一种多智能体强化学习方法、装置及介质

本发明涉及多个智能体行为自主控制,尤其涉及一种多智能体强化学习方法、装置及介质。

背景技术:

1、现实中,很多自动控制场景可以被视作多智能体场景。例如多机器人控制、自动驾驶、电子游戏博弈等。在多智能环境中,每个智能体根据其观测做出相应的动作,共同完成某项任务。而每个智能体的决策模型则通过多智能体强化学习技术完成训练。

2、在强化学习当中,环境对智能体的奖励分配直接影响智能体的训练结果。而在多智能体环境中,由于环境通常只能给所有智能体提供唯一个外部奖励,即存在奖励稀疏问题,导致每个智能体难以准确评估自身动作对整体环境的影响,从而难以学习到最优的决策模型。因此,为每个智能体设计其内部奖励,是解决奖励稀疏问题的一种有效途径。为设计一种合理的内部奖励分配模式,现有的一些方案通过设计可学习的内部奖励,鼓励智能体做出多样化的行为;还有的研究则利用内部奖励促进智能体之间做出相近的行为,让整个系统更加可预测。然而,现有的内部奖励分配方式在多智能体的整个行动中只鼓励各智能体做出的一致性或不一致性行为,而无法动态地促进智能体间何时应当做出一致性行为。而动态地鼓励一致性行为对于复杂多智能体环境下促进智能体间协作至关重要。

技术实现思路

1、为至少一定程度上解决现有技术中存在的技术问题之一,本发明的目的在于提供一种基于行为一致性内部奖励的多智能体强化学习方法、装置及介质。

2、本发明所采用的技术方案是:

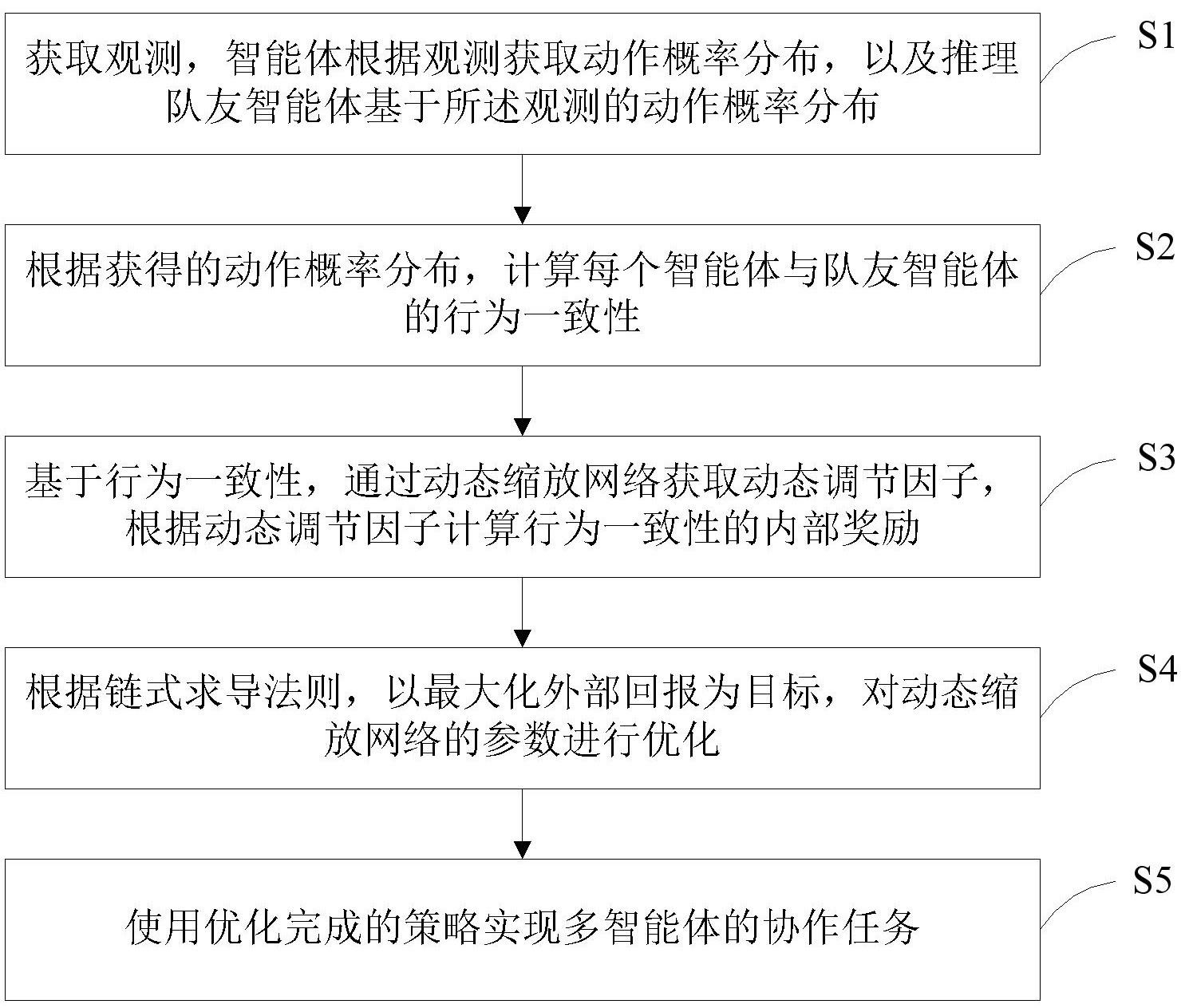

3、一种多智能体强化学习方法,包括以下步骤:

4、获取观测,智能体根据观测获取动作概率分布,以及推理队友智能体基于所述观测的动作概率分布;

5、根据获得的动作概率分布,计算每个智能体与队友智能体的行为一致性;

6、基于行为一致性,通过动态缩放(dsn)网络获取动态调节因子,根据动态调节因子计算行为一致性的内部奖励;

7、根据链式求导法则,以最大化外部回报为目标,对动态缩放网络的参数进行优化;

8、使用优化完成的策略实现多智能体的协作任务。

9、进一步地,所述获取观测,智能体根据观测获取动作概率分布,以及推理队友智能体基于所述观测的动作概率分布,包括:

10、对于每个智能体,输入该智能体当前时刻的观测,智能体利用自身的执行器推理出下一步的动作概率分布;

11、智能体将自身的观测输入其他智能体的执行器,推理出队友智能体执行器面对相同观测时的动作概率分布。

12、进一步地,所述计算每个智能体与队友智能体的行为一致性,包括:

13、计算每个智能体推理得到的自身下一步的动作概率分布,和队友智能体面对相同观测时输出的动作概率分布之间的相似度,作为行为一致性。

14、进一步地,所述相似度采用kl散度进行计算,计算公式如下:

15、

16、其中,表示智能体与智能体在时刻的行为一致性,表示智能体在时刻获取与智能体相同观测时,输出动作为第类动作的概率,表示智能体在时刻输出动作为第类动作的概率,表示智能体动作空间的长度。

17、进一步地,所述通过动态缩放网络获取动态调节因子,根据动态调节因子计算行为一致性的内部奖励,包括:

18、构建动态缩放网络;其中,该动态缩放网络的输入为全局观测,输出为与不同智能体之间行为一致性的动态调节因子;其中,所述全局观测为所有智能体的观测;

19、根据动态调节因子和行为一致性,计算获得基于行为一致性的内部奖励。

20、进一步地,对于智能体,在时刻获取的基于行为一致性的内部奖励如下:

21、

22、其中,为智能体自身动态缩放网络输出的动态调节因子,为一个缩放超参数,表示智能体与智能体在时刻的行为一致性,为智能体的队友智能体集合;当值为负时,鼓励智能体和智能体之间做出一致性行为;当值为正时,则惩罚智能体和智能体之间做出一致性行为。

23、进一步地,所述根据链式求导法则,以最大化外部回报为目标,对动态缩放网络的参数进行优化,包括:

24、构建外部价值目标函数,并将外部价值目标函数的导数通过链式法则,与动态缩放网络的参数相关联,从而使得动态调节因子的更新方向与外部价值增大的方向一致。

25、进一步地,所述根据链式求导法则,以最大化外部回报为目标,对动态缩放网络的参数进行优化,包括:

26、设第个智能体对应动态缩放网络的参数为,利用链式求导法则,外部回报对的梯度表示为:

27、(1)

28、其中表示第个智能体对应的执行器策略更新后的网络参数;

29、公式(1)中的,进一步表示为:

30、(2)

31、其中表示外部优势,由外部评判器给出;表示第个智能体更新后的执行器策略输出动作为的概率;为记录第个智能体历史观测的和动作的缓存器;

32、根据soft actor-critic算法,的计算表示为:

33、(3)

34、其中为学习率,为soft actor-critic算法中的熵温度系数,为第个智能体对应的更新后辅助评判器在输入其观测时的值;在soft actor-critic算法中,为每个智能体定义两个相同的辅助评判器和,每个辅助评判器的参数独立更新,并且所参与的奖励输入为内部奖励与外部奖励之和,即,为外部奖励,则;

35、进一步推导出,式(1)中的等于:

36、(4)

37、其中、分别为第个智能体对应辅助评判器更新前和更新后的参数;为第个智能体对应的更新前辅助评判器在输入其观测时的动作价值;为第个智能体更新前的执行器策略;将式(2)和式(4)代入式(1),计算出外部回报对的梯度;通过梯度上升法完成对动态缩放网络参数的优化。

38、本发明所采用的另一技术方案是:

39、一种多智能体强化学习装置,包括:

40、至少一个处理器;

41、至少一个存储器,用于存储至少一个程序;

42、当所述至少一个程序被所述至少一个处理器执行,使得所述至少一个处理器实现如上所述方法。

43、本发明所采用的另一技术方案是:

44、一种计算机可读存储介质,其中存储有处理器可执行的程序,所述处理器可执行的程序在由处理器执行时用于执行如上所述方法。

45、本发明的有益效果是:本发明提出一种基于行为一致性的内在奖励,解决多智能体协作算法忽略智能体之间行为意图的配合,从而导致出现次优化策略的问题,能够有效地提高多智能体之间的协作性能。

技术特征:

1.一种多智能体强化学习方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的一种多智能体强化学习方法,其特征在于,所述获取观测,智能体根据观测获取动作概率分布,以及推理队友智能体基于所述观测的动作概率分布,包括:

3.根据权利要求1所述的一种多智能体强化学习方法,其特征在于,所述计算每个智能体与队友智能体的行为一致性,包括:

4.根据权利要求3所述的一种多智能体强化学习方法,其特征在于,所述相似度采用kl散度进行计算,计算公式如下:

5.根据权利要求1所述的一种多智能体强化学习方法,其特征在于,所述通过动态缩放网络获取动态调节因子,根据动态调节因子计算行为一致性的内部奖励,包括:

6.根据权利要求5所述的一种多智能体强化学习方法,其特征在于,对于智能体,在时刻获取的基于行为一致性的内部奖励如下:

7.根据权利要求1所述的一种多智能体强化学习方法,其特征在于,所述根据链式求导法则,以最大化外部回报为目标,对动态缩放网络的参数进行优化,包括:

8.根据权利要求1所述的一种多智能体强化学习方法,其特征在于,所述根据链式求导法则,以最大化外部回报为目标,对动态缩放网络的参数进行优化,包括:

9.一种多智能体强化学习装置,其特征在于,包括:

10.一种计算机可读存储介质,其中存储有处理器可执行的程序,其特征在于,所述处理器可执行的程序在由处理器执行时用于执行如权利要求1-8任一项所述方法。

技术总结

本发明公开了一种多智能体强化学习方法、装置及介质,属于多个智能体行为自主控制技术领域。其中方法包括:获取观测,智能体根据观测获取动作概率分布,以及推理队友智能体基于观测的动作概率分布;根据获得的动作概率分布,计算每个智能体与队友智能体的行为一致性;通过动态缩放网络获取动态调节因子,根据动态调节因子计算行为一致性的内部奖励;根据链式求导法则,以最大化外部回报为目标,对动态缩放网络的参数进行优化;使用优化完成的策略实现多智能体的协作任务。本发明提出一种基于行为一致性的内在奖励,解决多智能体协作算法忽略智能体之间行为意图的配合,从而导致出现次优化策略的问题,能够有效地提高多智能体之间的协作性能。

技术研发人员:谭明奎,林坤阳,王宇丰,陈沛豪,杜卿,胡灏,李利

受保护的技术使用者:华南理工大学

技术研发日:

技术公布日:2024/1/14

- 还没有人留言评论。精彩留言会获得点赞!