基于仿真强化学习的基站制冷控制优化方法与系统

本发明属于移动通信系统节能优化,具体为一种基于仿真强化学习的基站制冷控制优化方法与系统。

背景技术:

1、5g通信网络是推动我国工业化、城市化进程的重要组成部分,近些年来迅速发展。5g通信网络整体架构是为了满足现阶段流量大以及多连接的社会应用需求,近年来,5g通信基站的数量呈增加趋势,5g通信基站数量增加的同时也带来了能耗的大幅增加。目前运营商的5g基站主设备空载功耗约为4g基站的3~4倍。为了实现节能环保的目标,对于提高5g通信基站的能效的研究可能是当下的有效途径。

2、5g通信基站在运行过程中设备大量放热会对基站热环境造成影响,进而影响通信设备的整体工作性能,因此需要额外的制冷单元来维持基站基本运行环境。通信基站内的制冷单元主要由hvac(heating ventilation and air conditioning,暖通空调)提供,制冷单元工作大约消耗了基站系统总能量的40%。虽然近年来基站主要通信设备节能降耗技术研究日渐成熟,但业界主要的节能手段聚焦于通信硬件器件的改进和控制以及类似于符号关断、通道关断、载波关断和深度休眠等的软件节能算法,但上述方法存在维护难度高、更新周期短等问题,并且虽然改进硬件器件能够提高基站的能源效率,但是仍然存在一些设备能耗较高的问题。因此,仍然需要寻找更加高效和可持续的节能方法。

3、近年来深度学习和强化学习技术受到广泛关注,深度强化学习作为二者结合的产物,集成了深度学习的理解能力以及强化学习的决策能力,有望在基站节能场景下发挥作用。基于ai和数据驱动的深度强化学习算法能够从标准基站的电力与环境管理系统中收集的数据中分析环境状态与温控策略之间的内在关联;同时在强化学习部分,智能体与基站环境的交互迭代过程中调整温控策略,通过不断累积环境奖励,从而在满足设备温度和室内环境要求的同时,学习到最佳温控策略,最大限度地降低运营成本。

4、现阶段对于建筑环境中的系统控制优化问题越来越复杂,影响系统环境变化的状态动作对也逐渐趋于连续,在这种情况下,传统的强化学习方法如q-learning可能无法学习获得较优的策略,因此基于深度强化学习的优化方法有望在解决该问题中发挥作用。由于强化学习在与环境交互学习的初始阶段对于动作的选取具有较强的随机性(探索性),因此暖通空调系统在与实际环境的交互学习过程中容易采取不合理的动作从而导基站运行环境的安全隐患。而且与真实环境的交互过程会造成时间、经济、人力资源的实验成本增加,也是现阶段基站节能优化过程中亟待解决的问题。

技术实现思路

1、为了解决上述问题,本发明提供了基于基站热环境仿真模型的深度强化学习暖通空调系统优化控制方法,(经过仿真学习控制策略),能够满足基站内设备安全性,提高基站能效并达到最小的运行成本。

2、为了实现上述目的,本发明采用如下技术方案:

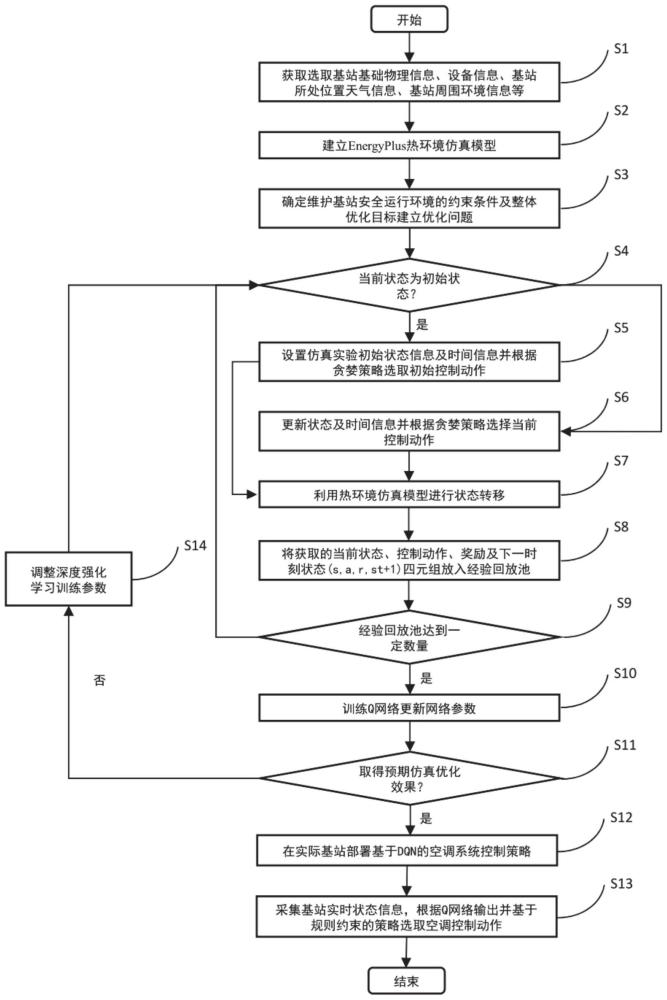

3、一种基于仿真强化学习的基站制冷控制优化方法,其特征在于,包括以下步骤:

4、s1、获取基站参数,所述基站参数包括基站基础信息、基站室外天气信息和分时电价信息;

5、s2、分析基站热环境的热平衡过程,根据s1获取的基站参数,建立基站energyplus热环境仿真模型;

6、s3、确定维护基站安全运行环境的约束条件及目标函数,基于约束条件及目标函数建立优化问题;

7、s4、判断当前状态是否为dqn训练过程中的初始状态:

8、若是初始状态则执行s5;否则,执行s6;

9、s5、设置dqn训练初始状态信息及时间信息,构建并初始化q网络,根据贪婪策略选取初始控制动作,所述时间信息用于判断dqn训练的训练轮次;

10、s6、将当前状态更新为上一时刻状态转移后的状态,并更新时间,根据dqn的输出选择空调当前控制动作;

11、s7、将当前状态及时间输入所述基站energyplus热环境仿真模型中,进行状态转移得到下一时刻的状态,并根据奖励函数获取当前时刻的环境奖励;所述奖励函数为所述目标函数的负数,所述约束条件为奖励函数惩罚项;

12、s8、将s6获取的当前状态st、当前空调控制动作at、当前环境奖励rt以及下一时刻的状态st+1组成四元组(st,at,rt,st+1)存入经验回放池;

13、s9、判断经验回放池是否达到预设数量;若是,则执行s10;否则执行s4;

14、s10、从满足数量要求的经验回放池中采样四元组对dqn的q网络进行参数更新;

15、s11、确定整个训练的回合,回合内的累积奖励值称为该回合的回合奖励值;根据dqn训练的回合奖励值是否收敛,以及该回合内的电费成本节省的百分比是否符合预期判断是否达到预期仿真优化效果;若回合奖励收敛且符合预期优化效果,得到训好的q网络,则执行s12;否则执行s13;

16、s12、将dqn训练得到的满足预期仿真优化效果的q网络部署到实际基站环境中;

17、s13、获取实时基站参数,根据当前状态以及实时基站参数对应的q网络输出选择空调控制动作。

18、进一步的,步骤s1中,获取基站参数后,对基站参数进行数据预处理,所述数据预处理包括缺失数据填充和异常值处理。

19、进一步的,步骤s2中,根据步骤s1中获取的基站基础信息,在energyplus仿真软件中对基站热环境进行建模,得到基站energyplus热环境仿真模型,energyplus对于环境建模的热力学原理及平衡方程如下所示:

20、

21、式中:表示对流内部负载之和,为对流内部负载;i为每个负载的标号,nsl为本房间内负载数量,表示本房间表面的对流传热,nsurfaces为本房间墙壁表面数量,hi为换热系数,ai为墙壁表面面积,tsi为墙壁温度,tz为本房间温度,表示本房间与相邻房间由空气混合导致的热传递,nzones为本房间的相邻房间数量,为换风流速,cp为空气比热容,tzi为相邻房间温度,tz为本房间温度,表示外部空气渗入造成的热传递,为与外部进行热传递的换风风速,t∞为室外环境温度,表示空调系统输出,表示储存在区域空气中的能量变化;cz为房间的热容;cz=ρaircpct,ρair表示区域空气密度,cp表示区域空气比热,ct表示显热能力乘数。

22、进一步的,步骤s3中,约束条件包括:

23、1)蓄电池的温度约束:

24、

25、式中:为设备入口处温度上限,表示蓄电池温度;

26、2)设备入口处温度的约束:

27、

28、式中:为设备入口处温度上限,表示设备当前温度。

29、进一步的,步骤s3中,目标函数为:

30、

31、式中:wbs为站点的空调系统电力运行成本,为时段k内的分时电价,为k时段空调系统用电量。

32、进一步的,步骤s5中,所述贪婪策略中用到的贪心系数ε满足下列关系式:

33、ε=ε1-epsilon_delta*episode,

34、其中,ε1为初始时贪婪系数的值为1,epsilon_delta为每回合贪婪系数的变化值,episode为此时训练的回合数。

35、进一步的,步骤s6包括以下步骤:

36、更新当前状态为st=st+1,然后根据当前q网络以贪婪策略选择当前空调控制动作at;采用当前q网络选择动作的方法为:将更新后的状态st输入到当前q网络中,再将q网络输出值的最大索引值映射到动作空间中得到当前状态下的空调控制动作。

37、进一步的,步骤s7中,以当前时刻t的状态st以及当前空调控制动作为输入,在基站热环境仿真模型中进行状态转移,通过energyplus环境模型计算得到基站下一时刻的状态,并通过约束条及奖励函数获取得到当前时刻的环境奖励。

38、进一步的,步骤s10包括:当经验回放池中的四元组数量到达预定值后,通过从经验回放池r中批量采样设定数量的四元组,对每个四元组,用目标网络计算q的实际观测值yi,然后根据损失函数(yi-q(si,ai;θ))2更新q网络的网络参数。

39、一种基于仿真强化学习的基站制冷控制优化系统,包括信息感知系统、中央处理器和实际部署部分;

40、所述信息感知系统,用于收集环境基础信息,环境基础信息包括基站基础信息、室外天气信息、分时电价信息以及由动环监控系统反馈的数据;

41、所述中央处理器,集成有energyplus热环境仿真模型,所述energyplus热环境仿真模型通过接收深度强化学习q网络输出的动作进行当前状态和下一时刻状态之间的转移并将下一时刻的状态输出,并将基站energyplus热环境仿真模型输出的状态信息和奖励信息作为输入生成实时温控策略并更新q网络;

42、所述实际部署部分,用于判断当前温控策略发否符合预设阈值:若符合预设阈值,根据实时温控策略进行控制,若当前温控策略不满足预设阈值,则继续优化温控策略。

43、与现有技术相比,本发明至少具有以下有益的技术效果:

44、现有的基站温控方案主要分为两种,一种为基于对基站环境及设备能耗等建立复杂的数学机理模型,通过研究hvac在数学模型中所受的约束及目标函数等来优化温控策略;另一种则是基于hvac与环境进行交互等方式来学习温控策略。但上述方案要求大量的输入参数和高质量的数据,这对于数据少、数据准备度较差的基站是难以满足的。因此本发明通过深度强化学习解决机理模型的对先验知识需求大、线性模型无法捕捉复杂的基站系统特性的局限性。

45、由于强化学习在与环境交互学习的初始阶段对于动作的选取具有较强的随机性(探索性),因此暖通空调系统在与实际环境的交互学习过程中容易采取不合理的动作从而导致基站运行环境的安全隐患。本发明通过基于仿真强化学习的基站制冷控制优化方法,通过引入energyplus仿真解决传统数据驱动模型高度依赖数据质量,无法实现迁移泛化、以及动作越位的问题,实现在无数据积累和输入少量基础参数的情况下能够安全有效地从仿真模型中学习得到较优的初始温控策略。将学习到的控制策略应用到(部署到)实际基站环境中进行本地模型推理,进行温控策略的进一步优化。

46、该方法首先对数据缺乏且数据准备度较差的基站的基础信息进行基础信息收集,然后根据收集到的信息建立energyplus热环境仿真模型。选取合适的状态信息、控制动作等将基站的热环境变化过程建立为马尔可夫决策过程;构建q网络,利用深度学习强大的感知能力来进行价值函数(状态动作对)的近似拟合;采用深度强化学习的方法通过与energyplus热环境仿真模型进行交互获得环境奖励以学习温控策略并更新q网络;当深度强化学习的仿真效果达到预期,将训练得到的q网络对应的温控策略部署到真实基站环境中并不断优化温控策略。该方法能够大幅减小纯强化学习部署带来的时间、经济、人力资源成本,并且具有较高的安全性。

47、进一步的,该方法以站内暖通空调为主要优化对象,具有巨大的节能潜力,可以降低基站的运行成本并保证设备在安全的温度范围内运行。

- 还没有人留言评论。精彩留言会获得点赞!