端到端的音视频抑郁症自动检测研究方法与流程

1.本申请涉及语音处理和图像处理领域,尤其涉及端到端的音视频抑郁症自动检测研究方法。

背景技术:

2.抑郁是一种使人情绪低落,无法正常参与社会生活的精神疾病。更严重的是,抑郁症会导致自残和自杀行为。根据世界卫生组织2017年的数据,全球约有3.5亿抑郁症患者,到2030年,抑郁症将成为第二大死因。早期诊断和治疗可以帮助患者尽快摆脱困境,然而,诊断过程通常很费力,主要依靠医生的临床经验,这会导致一些患者无法及时得到适当的治疗。因此,有必要研究一种自动诊断抑郁症的方法,以帮助医生提高工作效率。

3.自动抑郁检测的目的是探索健康个体和抑郁病人在语音和面部的变化规律,并设计相应的模型和方法来使机器具备捕获抑郁线索的能力,增强其诊断能力,提升诊断效率。现有技术中主要通过为个体录制音视频,提取音视频中能够体现个体抑郁水平的特征,将特征聚合分析后,进行抑郁水平预测。

4.现有技术中存在的问题是大多数使用多步骤、多模型来进行预测,不仅各个模板的目标函数跟最终的预测目标有偏差,而且容易累积误差,造成预测结果的不准确;另一个问题是现有的抑郁症检测特征提取方法并不是针对抑郁检测的,因此在抑郁检测任务上准确率不高。

5.专利申请公布号cn 109171769 a公开一种应用于抑郁症检测的语音、 面部特征提取方法及系统。根据能量信息法将音频数据进行特征提取,得到频谱参数和声学参数;将上述参数输入第一深度神经网络模型,得到语音深度特征数据;将视频图像进行静态特征提取,得到帧图像;将帧图像输入第二深度神经网络模型,得到面部特征数据;将视频图像进行动态特征提取,得到光流图像;将光流图像输入第三深度神经网络模型,得到面部运动特征数据;将面部特征数据和运动特征数据输入第三深度神经网络模型,得到面部深度特征数据;将语音深度特征数据和面部深度特征数据输入第四神经网络模型,得到融合数据。采用本发明的方法或系统能够提高抑郁症的筛查结果的精度和提高抑郁症的检测效率。

6.专利申请公布号cn 110556129 a提供了一种双模态情感识别模型训练方法及双模态情感识别方法,其中,该双模态情感识别模型训练方法包括:将语音训练数据输入第一神经网络模型进行训练,以得到语音情感识别模型;将图像训练数据输入第二神经网络模型,采用第一损失函数进行第一阶段的有监督训练,以得到第一阶段的初始图像情感识别模型;将图像训练数据输入第一阶段的初始图像情感识别模型,采用第二损失函数进行第二阶段的有监督训练,以得到目标图像情感识别模型,将所述语音情感识别模型及所述目标图像情感识别模型进行决策级融合,以得到双模态情感识别模型。

技术实现要素:

7.为了解决上述技术问题或者至少部分地解决上述技术问题,本申请提供了端到端

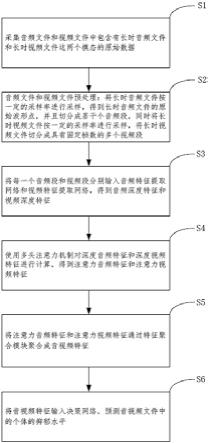

的音视频抑郁症自动检测研究方法,包括:s1:采集音频文件和视频文件中包含有长时音频文件和长时视频文件这两个模态的原始数据;s2:音频文件和视频文件预处理:将长时音频文件按一定的采样率进行采样,得到长时音频文件的原始波形点,并且切分成若干个音频段,同时将长时视频文件按一定的采样率进行采样,将长时视频文件切分成具有固定帧数的多个视频段;s3:将每一个音频段和视频段分别输入音频特征提取网络和视频特征提取网络,得到音频深度特征和视频深度特征;s4:使用多头注意力机制对深度音频特征和深度视频特征进行计算,得到注意力音频特征和注意力视频特征;s5:将注意力音频特征和注意力视频特征通过特征聚合模块聚合成音视频特征;s6:将音视频特征输入决策网络,预测音视频文件中的个体的抑郁水平。

8.优选地,所述将长时音频文件按一定的采样率进行采样,并且切分成若干个音频段,以mat文件格式进行保存,原始mp4文件对应的标签就是mat文件的标签;所述切分成若干个音频段为,切分成固定长度的音频。

9.优选地,所述将长时视频文件按一定的采样率进行采样,将长时视频文件切分成具有固定帧数的多个视频段,所提取的视频帧序列,按照jpg格式进行保存,原始mp4文件对应的标签就是jpg文件的标签。

10.优选地,所述音频特征提取网络包括,膨胀卷积层和时序池化层。

11.优选地,所述视频特征提取网络包括,3d卷积层,双向长短记忆网络模块。

12.优选地,所述使用多头注意力机制对深度音频特征和深度视频特征进行计算,得到注意力音频特征和注意力视频特征的具体方法包括,将音频深度特征和视频深度特征,分别输入多头注意力模块,得到不同权重分布的音频深度特征表示和不同权重分布的视频深度特征表示;使用softmax函数将不同权重分布的音频深度特征表示和不同权重分布的视频深度特征表示归一化,得到不同特征的重视程度,得到音频注意力特征和视频注意力特征。

13.优选地,所述多头注意力模块的注意力公式为,其中,q、k、v分别表示输入的查询、键和值的集合,d

k

为q、k的维数,公式如下:其中,x输入变量,w

q

,w

k

和w

v

分别是q、k和v对应的矩阵。

14.优选地,所述特征聚合模块采用前馈神经网络。

15.优选地,所述决策网络采用dense net网络。

16.优选地,所述dense net由dense block组成,dense block每一层的输入来自前面所有层的输出,每一层都可以直接从损失函数和原始输入信号中获取梯度,从而实现隐式的深度监督,dense block公式如下:

其中,表示一个非线性变换,表示将0到层的输出映射。

17.本申请实施例提供的上述技术方案与现有技术相比具有如下优点:本申请实施例提供的该方法,(1)使用了神经网络来自动学习有益于抑郁检测的深度特征表示,而省去了以往人工提取特征的过程,实现了端到端的检测。结果表明,神经网络学习出来的特征能够很好的体现抑郁个体的特征,提高了自动抑郁检测的准确率; (2)综合考虑了音频特征和视频特征在抑郁检测过程的时序性,所以使用了扩大卷积和时序池化、3d卷积和双向长短记忆网络来分别提取音频和视频的特征,很好的获取了音频和视频时序过程中的信息,提取了更深度的特征。

附图说明

18.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本发明的实施例,并与说明书一起用于解释本发明的原理。

19.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

20.图1为本申请实施例提供的端到端的音视频抑郁症自动检测研究方法流程图;图2是根据一示例性实施例示出的端到端的音视频抑郁症自动检测研究方法的结构图。

具体实施方式

21.为使本申请实施例的目的、技术方案和优点更加清楚,下面将结合本申请实施例中的附图,对本申请实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本申请的一部分实施例,而不是全部的实施例。基于本申请中的实施例,本领域普通技术人员在没有做出创造性劳动的前提下所获得的所有其他实施例,都属于本申请保护的范围。

22.如图1和图2所示,提供的端到端的音视频抑郁症自动检测研究方法,包括:s1:采集音频文件和视频文件中包含有长时音频文件和长时视频文件这两个模态的原始数据。

23.s2:音频文件和视频文件预处理:将长时音频文件按一定的采样率进行采样,得到长时音频文件的原始波形点,并且切分成若干个音频段;所述将长时音频文件按一定的采样率进行采样,并且切分成若干个音频段,以mat文件格式进行保存,原始mp4文件对应的标签就是mat文件的标签;所述切分成若干个音频段为,切分成固定长度的音频;时将长时视频文件按一定的采样率进行采样,将长时视频文件切分成具有固定帧数的多个视频段;所述将长时视频文件按一定的采样率进行采样,将长时视频文件切分成具有固定帧数的多个视频段,提取视频帧序列,按照jpg格式进行保存,原始mp4文件对应的标签就是jpg文件的标签。

24.s3:将每一个音频段和视频段分别输入音频特征提取网络和视频特征提取网络,得到音频深度特征和视频深度特征;所述音频特征提取网络包括,膨胀卷积层和时序池化

层;扩大卷积可以确保提取特征时不会违反数据的顺序,并且相比卷积具有更大的感受野,感受野随着扩大因子增加而指数型增大;而时序池化考虑了特征的时序关系,可以捕获时序中的重要特征,并且实现了下采样,减少了参数的大小;所述视频特征提取网络包括,3d卷积层,双向长短记忆网络模块。

25.s4:使用多头注意力机制对深度音频特征和深度视频特征进行计算,得到注意力音频特征和注意力视频特征;将音频深度特征和视频深度特征,分别输入多头注意力模块,得到不同权重分布的音频深度特征表示和不同权重分布的视频深度特征表示;使用softmax函数将不同权重分布的音频深度特征表示和不同权重分布的视频深度特征表示归一化,就得到了不同特征的重视程度,得到音频注意力特征和视频注意力特征;所述多头注意力模块的注意力公式为,其中,q、k、v分别表示输入的查询、键和值的集合,d

k

为q、k的维数,公式如下:其中,x输入变量,w

q

,w

k

和w

v

分别是q、k和v对应的矩阵。

26.s5:将注意力音频特征和注意力视频特征通过特征聚合模块聚合成音视频特征;所述特征聚合模块采用前馈神经网络。

27.s6:将音视频特征输入决策网络,预测音视频文件中的个体的抑郁水平;所述决策网络采用dense net网络;所述dense net由dense block组成,dense block每一层的输入来自前面所有层的输出,每一层都可以直接从损失函数和原始输入信号中获取梯度,从而实现隐式的深度监督,dense block公式如下:其中,表示一个非线性变换,表示将0到层的输出映射。

28.所以dense net在保证网络中层与层之间最大程度的信息传输的前提下,直接将所有层连接起来不仅在准确率上超过了res net,还大大降低了参数和计算量,也具有更好的泛化性。

29.实施例:输入音视频文件: 进入audio video motion challenge官网,下载2013年的抑郁症检测数据集(avec 2013),它是视听抑郁症语料库的一个子集,有网络摄像头和麦克风录制,共有来自82名被试者的150段视频,这些视频被分为三个部分:train、dev、test,每部分有50个样本。每个视频每秒30帧,分辨率为640

×

480,每个样本都用bdi

‑

ii评分作为标签。

30.音视频预处理:使用ffmpeg工具从下载的avec 2013数据集原始视频中提取音频,以wav格式保存。将长时音频切分成3s的音频文件,再以8k hz采样率进行采样,得到音频的原始波形点,以mat格式进行保存,标签就是原始视频的标签;将原始视频按照6次/s采样率进行采样,得到的视频帧以jpg格式进行保存,标签就是原始视频的标签。

31.音视频特征提取:将音频文件和视频文件分别送入音频特征提取网络和视频特征提取网络:音频特征提取网络由扩大卷积和时序池化构成,先将音频输入进行3次扩大卷积,卷积核数目设置为256,大小设置为2,膨胀率设置为2,卷积层数设置为4,输入通道为1,输出通道为256;再经过时序池化进行下采样,通道数和数据长度分别降到原来的一半,此时音频特征包含了音频样本的时序动态信息,提取出的特征更具有鲁棒性,是更高级的特征;视频特征提取网络由3d卷积和双向长短记忆网络构成,先将视频帧输入进行3d卷积,卷积核数目设置为8,大小设置为3

×3×

3,步长设置为(2,2,2);再将视频特征输入到双向长短记忆网络,其输出节点个数为64,捕获了视频的时序序列表示;经过特征提取网络,分别提取了音频和视频的深度特征表示;提取注意力特征:将音频深度特征和视频深度特征,分别输入多头注意力模块,得到不同权重分布的深度特征表示;这里注意力头数设置为8,意味着从8个角度计算特征隐层表示与特征的相似度,并使用softmax函数归一化,就得到了不同特征的重视程度,得到音频注意力特征和视频注意力特征。

32.音视频特征聚合:将注意力音频特征和注意力视频特征通过特征聚合模块聚合成音视频特征,这里直接将音频特征和视频特征直接拼接起来构成音视频深度特征,其包含了音频和视频这两个模态的特征和这两个模态交互的特征。

33.抑郁水平检测:将聚合后的音视频特征表示输入决策网络来预测输入音视频文件中的个体的抑郁水平,这里决策网络采用dense net,成长率growth rate设置为16,dense block个数为4,dense block里卷积操作分别进行(6,12,24,16)次,最后将结果输入全连接层,输出节点为1个,表示输入个体的抑郁水平得分。

34.需要说明的是,在本文中,诸如“第一”和“第二”等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

35.以上所述仅是本发明的具体实施方式,使本领域技术人员能够理解或实现本发明。对这些实施例的多种修改对本领域的技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所申请的原理和新颖特点相一致的最宽的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1