一种基于表观特征和空间约束的客体视域估计方法

1.本发明属于计算机视觉和模式识别领域,具体的涉及一种基于表观特征和空间约束的客体视域估计方法。

背景技术:

2.客体视域估计,即模式识别中识别对象具有客体性,以待识别客体为中心,根据客体的双目位置和注视方向,估计出图像区域内所有通视点的集合。在当前的视频监控领域中,客体视域估计的用途广泛和重要,如在教室的视频监控中,客体视域估计可以用来分析学生上课的注意力情况,能更加客观地评估学生的状态和教师的水平。在商场的视频监控中,客体视域估计还可以分析人群的注意力情况,能更加有效地设计广告的投放位置。在车站、机场和广场等人流密集场所的视频监控中,实时地进行客体视域估计,还能快速地发现异常行为情况等。因此对于当前的计算机视觉系统,能够在一般性场景下拥有准确的客体视域估计能力就显得尤为重要。

3.当前一般性场景下的客体视域估计一般采用两阶段方案,第一阶段首先是通过输入的客体人脸图像以及人脸中心位置进行注视方向的估计,第二阶段则是结合显著性模型在估计的注视方向上进行显著性热图回归以找到客体视域。尽管两阶段的方案已经较好的进行一般性场景下的客体视域估计,但是仍然存在一些问题尚待解决。两阶段模型将客体的头部图像和头部的中心位置作为模型的输入这是不符合人类进行客体视域估计的生理行为的,人类主体对客体的视域估计行为首先是进行客体的头部和人眼位置的检测,接着才是人眼视线的估计。其次上述模型直接学习从头部特征到注视方向的映射函数,他们没有将双目图像特征和头部图像特征之间的空间约束关系考虑其中,从而导致客体视线方向的估计存在一定的偏差性。最后客体的视域不一定是显著性物体,客体视域中的物体存在着尺度大小不一,显著层次不同等特性,因此第二阶段显著性热图回归生成的视域在精确性以及空间位置准确性上与真实值还存在较大差距。

技术实现要素:

4.为解决以上现有技术存在的问题,本发明提出了一种基于表观特征和空间约束的客体视域估计方法,该方法包括:获取含有待估计客体的原始场景图像,将该场景图像输入到训练好的客体视域估计模型中,得到客体视域估计结果;客体视域估计模型包括头部显著性检测网络、双目注视方向场预测网络、frnet网络;

5.对客体视域估计模型进行训练的过程包括:

6.s1:获取样本集合,根据样本集合建立场景数据集,对场景数据集中的数据进行预处理;对预处理后的场景数据集进行划分,得到训练数据集和测试数据集;获取的样本集合为包含头部图像的样本集合;

7.s2:将训练数据集输入到头部显著性检测网络中,根据输入图像的表观特征提取客体的显著性头部图像、客体的双目图像以及客体的双目位置坐标;

8.s3:采用双目注视方向场预测网络学习客体的显著性头部图像和双目图像之间的空间约束关系,根据该空间约束关系以及客体的双目位置坐标得到客体的双目注视方向场特征图;

9.s4:将双目注视方向场特征图通过基于通道维度相连接的方式与初始图像进行特征图拼接,将拼接后的特征图输入到frnet网络,得到客体的视域灰度图像表征;

10.s5:将客体的视域灰度图像表征与原始图像的像素融合,得到客体视域估计结果;

11.s6:根据客体视域估计结果计算模型的损失函数;

12.s7:将训练集中的数据输入到模型中,不断调整模型的参数,当损失函数取值最小时完成模型的训练;将测试数据集输入到训练好的模型中用于模型的验证。

13.优选的,对数据集中的图像进行预处理的过程包括:对数据集中的图像进行bm3d算法去噪、直方图均衡化、双线性插值缩放、随机水平翻转、像数值归一化以及像数值标准化操作;将场景数据集通过7:3的比例随机划分成训练数据集和测试数据集。

14.优选的,采用头部显著性检测网络对数据进行处理的过程包括:

15.s21:采用单级的人脸检测网络retinaface对训练集中的场景数据进行处理,生成场景中客体的头部图像以及客体的双目位置坐标;

16.s22:将头部图像输入到u

2-casnet模块中,生成显著性头部图像;

17.s23:基于双目位置坐标和三庭五眼几何空间关系裁剪出25

×

45分辨率大小的左、右眼图像,裁剪出的左、右眼图像为客体的双目图像。

18.进一步的,采用u

2-casnet模块对头部图像进行处理的过程包括:

19.s221:提取头部图像的特征图,将头部图像特征图输入到两级u型嵌套的u

2-casnet模块中,生成6个不同分辨率大小的显著性概率特征图;

20.s222:采用1

×

1卷积层和sigmoid函数跟随的级联操作将各个显著性概率特征图进行特征融合,得到最终的显著性概率特征图;

21.s223:将最终的显著性概率特征图与初始的头部图像基于像素相乘操作生成显著性头部图像。

22.进一步的,u

2-casnet模块包含主模块和次模块,主模块由残差子块rsu-l(c

in

,m,c

out

)通过u型嵌套堆叠形成,该结构从浅层和深层分别捕获局部表观特征信息和不同尺度的全局表观特征信息;次模块则由6个cam通道注意力模块并行构成,每个cam模块并行添加到嵌套结构中每一层生成的显著性概率特征图之前,该模块通过全局平均池化和最大池化操作对每一层生成的特征图的不同通道进行注意力权重赋值,实现对该层特征图显著性表观特征的增强,使得最终生成的显著性概率特征图具有更好的全局与细节的显著特征。

23.优选的,采用双目注视方向场预测网络学习客体的显著性头部图像和双目图像之间的空间约束关系,根据该空间约束关系以及客体的双目位置坐标得到客体的双目注视方向场特征图的过程包括:双目注视方向场预测网络采用两阶段处理方式:在第一阶段,使用三个深度残差网络分别提取出显著性头部图像和双目图像的特征图,将对应的特征图通过赋予不同的空间约束权重后输入到三层mlp网络中,将对应的特征图映射成二维空间中的方向向量;在第二阶段,将维度为2的方向向量与初始图像大小相同的灰度图进行特征融合筛选出粗粒度的注视方向场区域,并以双目位置作为视场出发点,进行注视方向场的细粒度调整,生成最后的双目注视方向场。该方向场表征了客体视域的概率分布,并根据每幅场

景图中客体双目位置的不同进行方向场的动态变换。

24.进一步的,方向向量在二维空间上的公式表示为:

[0025][0026]

其中,表示根据空间约束关系预测的注视方向,mlp表示三层的感知机网络,f

l

和fr分别表示左眼和右眼的细粒度方向特征,fh表示头部的粗粒度姿态特征,和w

head

分别表示双目特征和头部特征之间的空间约束权重,该空间约束权重是通过全连接层学习得到的。

[0027]

进一步的,动态双目注视方向场的公式表示为:

[0028][0029]

其中sim(p,γ)表示生成的双目视场概率图。点p表示视域中心值坐标,γ是控制视场的锥形大小,较大的γ对应孔径较小的场域。本发明的参数设置为γ=5,sim(p

l

)和sim(pr)分别表示左眼和右眼对应的视场概率图。β表示客体头部图像中是否存在单目的情况,当β=1时,p∈sim(p

l

),当β=0时,p∈sim(pr)。

[0030]

优选的,采用frnet网络对客体的双目注视方向场特征图与初始图像拼接后的图像进行处理的过程包括:

[0031]

s51:将224

×

224像素大小的左、右目注视方向场特征图与同尺寸大小的3通道输入原图以通道维度相拼接的方式生成5通道特征图。

[0032]

s52:将生成的5通道特征图输入到fcanet网络的stem主干中进行初次的表观特征提取,通过卷积、批量归一化以及relu激活操作将输入特征图的分辨率下采样到原始图像的1/4,并将通道数增加到64维,即64

×

56

×

56大小的特征图。

[0033]

s53:将生成的64

×

56

×

56的特征图送入到fcanet的主体网络中进行高分辨率表观特征的学习;通过主体网络的第一阶段进行特征的提取,该阶段包含了4个线性变换fcablock残差模块,生成了256

×

56

×

56的特征图;将该特征图通过2,3,4阶段中的分辨率并行卷积模块和多分辨率融合模块进行不同分辨率特征之间的信息交换与融合,生成最终的4个不同分辨率大小的特征图,并将尺寸为32

×

56

×

56的特征图作为客体视域的隐式表征。

[0034]

s54:将生成的32

×

56

×

56大小的特征图通过两层2d卷积进行通道的降维,变成1

×

56

×

56的特征图,最后通过sigmoid函数将特征图中的像素值映射到[0,1],生成客体视域灰度图像表征。

[0035]

优选的,将客体视域灰度图像表征映射到初始图像中的过程包括:将灰度图像表征中的像素值转换到[0,255]的区域内,采用三张灰度图像表征堆叠的方式增加相应的通道维度;通过双线性插值的方式将灰度图像表征调整到对应输入图像的尺寸;将灰度图像表征和初始图像的像素值通过8:2的比例融合得到预测结果。

[0036]

优选的,模型的损失函数为:

[0037][0038]

其中,λ表示平衡双目注视方向场预测阶段和客体视域估计阶段的损失权重,mi和分别表示含有真实视域的灰度图像表征和含有预测视域的灰度图像表征中的每个像素值,n表示灰度图像表征的像素大小56

×

56,d表示客体的真实注视方向,表示基于模型生成的预测注视方向。

[0039]

本发明的有益效果在于:

[0040]

本发明完美的借鉴了人类注视跟随的智慧,提出的客体视域估计模型改变了现有技术中需要提供头部图像和头部位置才能进行注视点估计的这一现状,并且通过对头部显著性检测网络、双目注视方向场预测网络、frnet等网络的设计,提高了当前注视点估计的精确值,全程实现端到端的学习以及自动化预测。

附图说明

[0041]

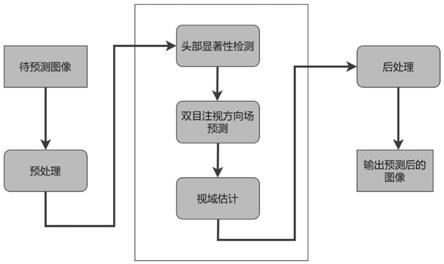

图1为本发明方法实施的总体流程框图;

[0042]

图2为本发明的整体模型架构图;

[0043]

图3为本发明构建的u

2-casnet模块结构示意图;

[0044]

图4为本发明构建的frnet模块结构示意图;

[0045]

图5为本发明的fcablock模块结构图;

[0046]

图6为本发明的fcaneck模块结构图;

[0047]

图7为本发明的部分实验结果图示例。

具体实施方式

[0048]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0049]

一种基于表观特征和空间约束的客体视域估计方法,该方法包括:将包括头部图像的数据作为训练数据集;根据客体的表观特征和空间约束,构建客体视域模型,输入预处理后的训练数据集进行模型的参数训练,得到训练后的客体视域估计模型;将测试数据输入客体视域估计模型,得到客体视域估计结果;所述客体视域估计模型包括头部显著性检测网络、双目注视方向场预测网络、frnet网络。

[0050]

如图1和图2所示,对客体视域估计模型进行训练的过程包括:

[0051]

s1:获取样本集合,根据样本集合建立场景数据集,对场景数据集中的数据进行预处理;对预处理后的场景数据集进行划分,得到训练数据集和测试数据集;获取的样本集合为包含头部图像的样本集合;

[0052]

s2:将训练数据集输入到头部显著性检测网络中,根据输入图像的表观特征提取客体的显著性头部图像、客体的双目图像以及客体的双目位置坐标;

[0053]

s3:采用双目注视方向场预测网络学习客体的显著性头部图像和双目图像之间的

空间约束关系,根据该空间约束关系以及客体的双目位置坐标得到客体的双目注视方向场特征图;

[0054]

s4:将双目注视方向场特征图通过基于通道维度相连接的方式与初始图像进行特征图拼接,将拼接后的特征图输入到frnet网络,得到客体的视域灰度图像表征;

[0055]

s5:将客体的视域灰度图像表征与原始图像的像素融合,得到客体视域估计结果;

[0056]

s6:根据客体视域估计结果计算模型的损失函数;

[0057]

s7:将训练集中的数据输入到模型中,不断调整模型的参数,当损失函数取值最小时完成模型的训练;将测试数据集输入到训练好的模型中用于模型的验证。

[0058]

对场景数据集中的样本集合进行预处理的过程包括:

[0059]

s11:运用bm3d算法去除离散噪声:该算法主要用到了非局部块匹配的思想,通过与相邻图像块进行匹配,将若干相似的块整合成一个三维矩阵,接着在三维空间中进行collaborative filtering处理,降低该三维矩阵自身含有的噪声,再将处理后的结果反变换融合到二维,形成去噪后的图像。

[0060]

s12:运用直方图均衡化进行光照调节:将原彩色图像进行空间转换,转换为hsv格式的图像,接着对该格式中的v分量即亮度通道进行直方图均衡化,最后将均衡化的图像转换成rgb彩色模型,得到光照调节后的图像

[0061]

s13:双线性插值缩放:其核心思想是在图像上的两个方向上分别进行一次线性插值,以保证满足224

×

224尺寸大小的模型输入要求。

[0062]

s14:随机水平翻转、归一化、标准化:随机的对输入图像进行水平翻转,并对标签进行翻转计算;运用归一化和标准化方法来去除图像之间存在的数据量纲和数据大小的差距,并通过中心化处理将输入图像的像素调整到[-1,1]之间,使得图像符合深度学习模型的输入。

[0063]

采用头部显著性检测网络对数据进行处理的过程包括:

[0064]

s21:采用单级的人脸检测网络retinaface对训练集中的场景数据进行处理,生成场景中客体的头部图像以及客体的双目位置坐标;

[0065]

s22:将头部图像输入到u

2-casnet模块中,生成显著性头部图像;

[0066]

s221:提取头部图像的特征图,将头部图像特征图输入到两级u型嵌套的u

2-casnet模块中,生成6个不同分辨率大小的显著性概率特征图;

[0067]

s222:采用1

×

1卷积层和sigmoid函数跟随的级联操作将各个显著性概率特征图进行特征融合,得到最终显著性概率图;

[0068]

s223:将最终显著性概率图与初始的头部图像基于像素相乘操作生成显著性头部图像。

[0069]

s23:基于双目位置坐标和三庭五眼几何空间关系裁剪出25

×

45分辨率大小的左、右眼图像,裁剪出的左、右眼图像为客体的双目图像;

[0070]

采用头部显著性检测网络对数据进行处理的具体过程包括:头部显著性检测网络主要作用为输入的图像中的客体生成显著性头部图像、双目图像以及客体的双目位置坐标。首先基于单级的人脸检测网络retinaface自动从图像中找到相应客体,并生成该客体的头部图像以及双目位置坐标,接着将头部图像通过双线性插值将尺寸调整到224

×

224大小,然后送入到本发明提出的u

2-casnet模块中,生成显著后的头部图像,并根据双目位置

坐标和三庭五眼几何空间关系裁剪出双目的特征图像,最后将显著后的头部图像、双目图像和双目位置坐标送入到双目注视场预测的阶段。u

2-casnet模块的作用:提升面部区域的特征表达,增强感兴趣的区域,同时弱化不相关的背景信息。

[0071]

如同3所示,u

2-casnet模块的流程:将预处理后的头部图像的特征图f

t

输入到两级嵌套的u

2-casnet模块中,该模块包括主模块和此模块两个部分,主模块由u

2-net中的残差子块rsu-l(c

in

,m,c

out

)通过嵌套堆叠形成。其中l代表编码器的层数,c

in

,c

out

表示输入和输出通道,m表示rsu内层的通道数。残差子u型块是编码器-解码器结构,该结构能够从具有任意空间分辨率的输入特征图中进行多尺度特征的抽取。从逐步下采样的特征图中提取多尺度特征,并通过逐级上采样、级联和卷积将多尺度特征编码生成高分辨率的特征图,并在u型结构的每一层输出不同分辨率大小的特征图。次模块则是将6个来自cbam网络中的cam模块并行添加到嵌套结构中每一层生成的特征图之后,如图3中虚线所示,该模块给生成的特征图的不同通道进行权重赋值来对通道间的重要性进行筛选,从而进行跨通道之间的信息交互。cam模块主要是将每层生成的特征图通过全局最大池化和全局平均池化,得到两个1

×1×

c的特征图,接着,将它们分别送入到两层mlp中,将得到的特征进行element-wise相加最后经过sigmoid激活操作生成最终的通道注意力特征,将该特征与原始输入特征图基于像素相乘操作得到最终的每一层的输出特征图整体结构可以概括为以下公式:

[0072][0073]

将u型结构的每一层输出的显著性概率特征图通过双线性插值的方式上采样到原始头部图像特征图的大小,接着把多个显著性概率特征图通过1

×

1卷积层和sigmoid函数跟随的级联操作来融合它们,以生成最终显著性概率图,将该概率图进行通道维度的叠加生成三通道的显著性概率图ps,将生成后的显著图ps与原始图像pg基于像素相乘操作生成最后的显著性头部图像y。生成显著性头部图像的公式为:

[0074][0075]

其中(r,c)是像素坐标,(h,w)是图像大小,表示图像的高度和宽度,p

g(r,c)

和p

s(r,c)

分别表示真实和预测显著性概率图的像素值,α表示常数值,这个值是通过实验形成的经验值为1

×

102。

[0076]

采用双目注视方向场预测网络学习客体的显著性头部图像和双目图像之间的空间约束关系,根据该空间约束关系以及客体的双目位置坐标得到客体的双目注视方向场特征图的过程包括:在第一阶段,使用三个深度残差网络分别提取出显著性头部图像和双目图像的特征图,将对应的特征图通过赋予不同的空间约束权重后输入到三层mlp网络中,将对应的特征图映射成二维空间中的方向向量;在第二阶段,将维度为2的方向向量与初始图像大小相同的灰度图进行特征融合筛选出粗粒度的注视方向场区域,并以双目位置作为视场出发点,进行注视方向场的细粒度调整,生成最后的双目注视方向场。该方向场表征了客体视域的概率分布,并根据每幅场景图中客体双目位置的不同进行方向场的动态变换。

[0077]

具体的,双目注视方向场预测网络以显著性检测后的头部图像、双目图像和双目位置作为双目注视方向场预测的输入。本发明将显著性头部图像送入resnet-50网络中进

行特征提取,接着通过一个全连接层生成512维的粗粒度头部姿态特征,然后将双目图像分别用resnet-18网络进行特征的提取,接着分别通过两个全连接层生成2个256维的细粒度眼睛方向特征。将提取后的粗粒度头部姿态特征与编码的细粒度眼睛方向特征进行维度拼接,接着通过mlp层生成2维注视方向表征,表示为注视方向表征的公式表示为:

[0078][0079]

其中,表示根据空间约束关系预测的注视方向,mlp表示三层的感知机网络,f

l

和fr分别表示左目和右目的细粒度方向特征,fh表示头部的粗粒度姿态特征,和w

head

分别表示双目特征和头部特征之间的空间约束权重,该空间约束权重是通过全连接层学习得到的。

[0080]

与前人的工作不同,前人提出的模型仅仅通过获取头部图像和头部中心位置来获得视线方向的估计,本发明中的模型则是通过学习粗粒度的头部姿态特征和细粒度的双目方向特征之间的隐式空间约束关系来进行视线方向的预测,这样的隐式关系增强了预测视线方向的精确性。本发明还提出了动态双目注视方向场的概念(binocular fov),该方视场是基于双目位置作为视场出发点,然后根据预测的注视方向以及视域的空间约束关系生成两个锥形场域,该场域是一个概率灰度图。双目形成的场域根据双目位置的不同进行变化,并且两个锥形场域叠加的部分会增强该场域的概率值,表明该场域更可能包含客体视域。场域的公式表示为:

[0081][0082]

其中sim(p,γ)表示生成的双目视场概率图。点p表示视域中心值坐标,γ是控制视场的锥形大小,较大的γ对应孔径较小的场域。本发明的参数设置为γ=5,sim(p

l

)和sim(pr)分别表示左眼和右眼对应的视场概率灰度图。β表示客体头部图像中是否存在单目的情况,当β=1时,p∈sim(p

l

),当β=0时,p∈sim(pr)。

[0083][0084]

上式表示了点p=(p

x

,py)表示成为视域中心值的概率,这里表示预测的注视方向,g表示点p到眼睛位置之间的直线,g表示为g=(p

x-h

x

,p

y-hy),这里使用的是余弦函数来描述角度到概率值的映射。

[0085]

在注视方向预测阶段需要通过对头部姿态粗粒度特征、双目注视方向细粒度特征进行空间约束的学习,因此这一阶段存在着训练的损失函数,注视方向的损失函数为:

[0086][0087]

其中,d表示真实注视方向,表示预测的注视方向。

[0088]

如图4所示,采用frnet网络对客体的视域灰度图像表征与输入到模型中的初始场景图像进行处理的过程包括:视域估计阶段将双目注视方向场预测阶段生成的视域灰度图像表征与初始预处理后的场景图像通过基于通道维度相连接的方式输入到frnet网络中,最后输出一个包含视域结果的56

×

56的灰度图像表征。本发明提出了一种融合频域通道注意力的多分辨率特征融合网络frnet。该模型对hrnet网络中各个阶段的子网的不同分辨率的特征图进行通道注意力权重分配,更明确地建立了通道之间的关系从而高效地进行通道之间的信息交互,在hrnet网络提取的高分辨率表征的基础之上,更好的提取出场景中多尺度信息,使得每个阶段生成含有更加丰富语义信息的高分辨率特征图,最终提升预测的热图在空间上的精确性。frnet网络是基于hrnet网络进行结构设计,结构图如图4所示,共有4个stage,分别为stage1、stage2、stage3和stage4。stage1由一个分辨率为56

×

56的高分辨率子网构成,该高分辨率子网包含了4个含有频域率通道注意力机制的fcaneck残差模块;stage2由2个并联的子网构成,分辨率分别为56

×

56和28

×

28;stage3由3个并联的分辨率分别为56

×

56、28

×

28和14

×

14的子网构成;stage4由4个并联的分辨率分别为56

×

56、28

×

28、14

×

14和7

×

7的子网构成。stage2、stage3和stage4均由包含了频域率通道注意力机制的fcablock模块和其他特征图模块融合组成,fcablock的模块数量分别为8,12,16。fcablock模块fcaneck模块和如图5和图6所示,fcablock模块包含2个3

×

3的卷积、1个msa layer模块以及一个残差连接,fcaneck模块包含两个1

×

1的卷积、1个3

×

3的卷积、1个msa layer模块以及一个残差连接。msa layer模块属于通道注意力机制,该机制是通过从频域分析的角度重新思考通道注意力,通过将更多的频率成分结合到注意力处理中,解决当前单个频率(即,gap)的通道注意中使用信息不足的问题。其表达式为:

[0089][0090]

其中,x表示输入的信息,这个式子表示输入信息有多个频域分量构成;表示的是在当前的注意力机制中所使用的频域分量。

[0091]

为了引入更多的信息,本发明中使用的msa模块使用2d dct的多个频率分量,包括gap。首先,输入x沿着通道维度被分成许多部分,即表示为[x0,x1,

…

,x

n-1

]各部分,其中i∈{0,1,

…

,n-1},c应能被n整除,对于每一部分,分配一个对应的2d dct频率分量,2d dct结果可作为通道注意的预处理结果。其表达式为:

[0092][0093]

s.t.i∈{0,1,

…

,n-1}

[0094]

其中,[u,v]是对应于xi的频率分量2d指数,是预处理后的c

′

维向量。将整个预处理向量进行连接,得到:

[0095]

freq=cat([freq0,freq1,

…

,freq

n-1

])

[0096]

其中是获得的多谱向量,整个多光谱通道注意力框架的表达式为:

[0097]

ms_att=sigmoid(fc(freq))

[0098]

视域估计阶段同样需要基于表观特征的学习,因此当前阶段存在着相应的损失函

数,本发明利用二进制交叉熵损失来作为视域估计的损失函数,该阶段的损失函数为:

[0099][0100]

其中,mi和分别表示含有真实视域的灰度图像表征和含有预测视域的灰度图像表征中的每个像素值。n表示灰度图像表征的像素大小56

×

56。

[0101]

本发明的模型总损失函数由双目注视方向场预测阶段和视域估计阶段的损失构成,其表达式为:

[0102][0103]

其中,λ表示平衡双目注视方向场预测阶段和客体视域估计阶段的损失权重,其值根据实验设置为λ=0.5。

[0104]

视域灰度图像表征映射到原始图像中的过程包括:将视域灰度图像表征中的像素值转换到[0,255]的区域内,采用三张灰度图堆叠的方式增加相应的通道维度;通过双线性插值的方式将灰度图表征调整到对应输入图像的尺寸;将灰度图像表征和原图的像素值通过8:2比例融合得到预测结果,部分结果图如图7所示。

[0105]

以上所举实施例,对本发明的目的、技术方案和优点进行了进一步的详细说明,所应理解的是,以上所举实施例仅为本发明的优选实施方式而已,并不用以限制本发明,凡在本发明的精神和原则之内对本发明所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1