一种数据训练方法及装置

1.本公开涉及深度学习和图网络数据挖掘技术领域,尤其涉及一种数据处理方法及装置。

背景技术:

2.随着人工智能的发展,深度学习作为一种强有力的技术已经开始改变我们生活的方方面面。自监督学习是深度无监督学习的一个代表分支,其利用图网络本身的信息构造伪标签训练模型,无需数据标注。

3.但是,目前现有的自监督学习技术在节点分类和图分类任务上的结果准确率较低。

技术实现要素:

4.本公开提供了一种数据训练方法、装置、电子设备和存储介质。

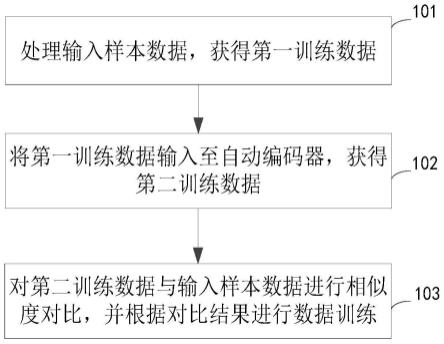

5.根据本公开的第一方面,提供了一种数据训练方法。该方法包括:处理输入样本数据,获得第一训练数据,将第一训练数据输入至自动编码器,获得第二训练数据,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。

6.在一些实施例中,处理输入样本数据,获得第一训练数据包括:获取输入样本数据,对输入样本数据中的节点进行采样,通过第一掩码标识遮盖输入样本数据中经采样的节点的原始特征,并将经第一掩码标识遮盖的输入样本数据确定为第一训练数据。

7.在一些实施例中,自动编码器包括编码器,编码器为第一图神经网络,将第一训练数据输入至自动编码器,获得第二训练数据包括:将第一训练数据输入编码器,获得输入样本数据中所有节点的隐式表示。

8.在一些实施例中,自动编码器还包括解码器,解码器为第二图神经网络,将第一训练数据输入至自动编码器,获得第二训练数据包括:将经采样的节点的隐式表示输入解码器,以输出第二训练数据。

9.在一些实施例中,将经采样的节点的隐式表示输入解码器,以输出第二训练数据包括:通过第二掩码标识遮盖输入样本数据中经采样的节点的隐式表示,并将经第二掩码标识遮盖的输入样本数据作为第二训练数据。

10.在一些实施例中,将第二训练数据与输入样本数据进行相似度对比包括:通过重建评估函数,计算第二训练数据与输入样本数据的相似度。

11.在一些实施例中,该方法还包括:基于放缩因子,构建重建评估函数,其中,重建评估函数是放缩余弦误差函数,放缩因子大于或等于1。

12.根据本公开的实施例,通过处理输入样本数据,获得第一训练数据,将第一训练数据输入至自动编码器,获得第二训练数据,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。实现在通过自监督算法进行数据学习,极大的提高了图网络数据分类的准确率。

13.根据本公开的第二方面,提供了一种数据训练装置,包括:处理单元,用于处理输入样本数据,获得第一训练数据;输入单元,用于将第一训练数据输入至自动编码器,获得第二训练数据;对比单元,用于对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。

14.根据本公开的实施例,该装置通过处理单元,输入单元以及对比单元,实现在通过自监督算法进行数据学习,极大的提高了图网络数据分类的准确率。

15.根据本公开的第三方面,提供了一种电子设备,包括:

16.至少一个处理器;以及

17.与至少一个处理器通信连接的存储器;其中,

18.存储器存储有可被至少一个处理器执行的指令,指令被至少一个处理器执行,以使至少一个处理器能够执行前述第一方面的方法。

19.根据本公开的第四方面,提供了一种存储有计算机指令的非瞬时计算机可读存储介质,其中,计算机指令用于使计算机执行前述第一方面的方法。

20.根据本公开的第五方面,提供了一种计算机程序产品,包括计算机程序,计算机程序在被处理器执行时实现如前述第一方面的方法。

21.根据本公开的实施例,通过处理输入样本数据,获得第一训练数据,将第一训练数据输入至自动编码器,获得第二训练数据,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。实现在通过自监督算法进行数据学习,极大的提高了图网络数据分类的准确率。

22.应当理解,本部分所描述的内容并非旨在标识本技术的实施例的关键或重要特征,也不用于限制本技术的范围。本技术的其它特征将通过以下的说明书而变得容易理解。

附图说明

23.附图用于更好地理解本方案,不构成对本公开的限定。其中:

24.图1为本公开实施例提供的一种数据训练方法的流程示意图;

25.图2为本公开实施例提供的一种数据训练方法的流程示意图;

26.图3为本公开实施例提供的一种数据训练方法的流程示意图;

27.图4为本公开实施例提供的一种基于图自编码器的生成式自监督学习的示意图;

28.图5为本公开实施例提供的一种数据训练装置的结构示意图;

29.图6为本公开实施例提供的示例电子设备600的示意性框图。

具体实施方式

30.以下结合附图对本公开的示范性实施例做出说明,其中包括本公开实施例的各种细节以助于理解,应当将它们认为仅仅是示范性的。因此,本领域普通技术人员应当认识到,可以对这里描述的实施例做出各种改变和修改,而不会背离本公开的范围和精神。同样,为了清楚和简明,以下的描述中省略了对公知功能和结构的描述。

31.下面参考附图描述本公开实施例的一种数据训练方法、装置、电子设备和存储介质。

32.随着人工智能的发展,深度学习作为一种强有力的技术已经开始改变我们生活的

方方面面。自监督学习是深度无监督学习的一个代表分支,其利用图本身的信息构造伪标签训练模型,无需数据标注。自监督学习在近年来获得了巨大的关注并得到了广泛的探索。自监督学习算法可以在无人工标注数据的场景下学习到数据的内在特征,并应用于多种下游任务。近年来,生成性学习在自然语言处理等领域取得了成功。

33.近几年来,预训练或自监督学习的方法可以应用在自然语言处理、计算机视觉、语音识别等领域。预训练是指通过在较大的数据集上训练模型,得到一套特征表示或模型参数。特征表示可以直接应用于下游任务,得到的模型参数可以根据下游任务进行微调来获得增益。它能够从海量未标注的数据上学习数据本身的特征,从而使下游任务能够更好地根据任务本身的特性来使用自监督学习阶段得到的知识。在图学习领域,如何进行预训练还是一个开放的问题,目前现有技术已经进行了一定的探索。

34.目前对比学习一直是图预训练的主流范式,其旨在学习不同数据增强中的标签不变因素。它依赖于负样本选择、模型架构设计、数据增强等组件的精心设计。负样本能够让学到的样本表示在空间中分布均匀,从而避免模型陷入平凡解。现有技术中基于互信息最大化的dgi和gcc探索了不同负样本的选择办法。高质量的数据增强在对比学习的成功中起着关键作用。对比学习旨在学习同一个数据不同形式下的标签不变特征,因此有效数据增强既需要保留数据的下游任务的标签不变信息,也需要使得不同的增强结果之间存在差异。所以现有技术探究了图中各种数据增强策略的有效性,包括特征遮盖、破坏结构、随机子图采样、删除节点等。由于有效的负样本选择、数据增强在图学习领域的实现非常困难,严重限制了对比学习在图学习领域的发展。

35.除了对比学习外,生成式自监督学习也广泛应用于各个领域。生成式学习的目的是恢复输入数据的缺失部分。现有技术提出了基于自回归方法的gpt-gnn模型,该模型采用自监督学习方法对gnn进行预训练,同时捕捉图节点特征和图结构信息。由于大多数图没有呈现出明显的节点顺序特性,自回归方法在图的预训练上并没有呈现出显著的意义。自动编码器被设计为在给定的上下文中重建某些输入,并不像自回归方法那样强制按照某种顺序进行解码。最早的工作可以追溯到图自动编码器和变分图自动编码器。尽管图自动编码器在链接预测和图聚类中的已经有成功的应用,然而它们在节点分类和图分类任务上的结果通常不能够令人满意。在自然语言处理和计算机视觉领域,生成式自监督学习呈现出比对比学习更大的潜力。

36.因此,相关技术中,自监督学习技术在节点分类和图分类任务上的结果准确率较低。在图的自监督学习领域,已有的对比学习方法严重依赖结构性数据增强和复杂的训练策略,而图上生成性学习的进展,特别是图自动编码器迄今尚未取得较好的表现。因此需要一种基于掩码的图自动编码器,以缓解生成性自监督图学习的问题的方法。

37.为解决现有技术中的相关技术问题,本公开提出一种数据训练方法,通过处理输入样本数据,获得第一训练数据,将第一训练数据输入至自动编码器,获得第二训练数据,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练,实现在通过自监督算法进行数据学习,极大的提高了图网络数据分类的准确率。

38.下面结合附图详细描述实现本公开提出的一种数据训练方法、装置、电子设备、存储介质以及程序产品。

39.图1为本公开实施例所提供的一种数据训练方法的流程示意图。本公开提出的方

法至少可以应用于自然语言处理、计算机视觉、语音识别等领域,具体可以应用于自然语言处理、计算机视觉、语音识别等领域的产品,例如智能终端等电子设备。如图1所示,该方法包括以下步骤:

40.步骤101,处理输入样本数据,获得第一训练数据。

41.在本公开的一种实现方式中,本公开实施例以采用掩码自动编码器作为预训练模型为主。

42.具体的,输入样本数据,即一个图g=(v,a,x)。从图g随机采样一定比例的节点将其节点特征用一个共同的掩码标识[mask]代替。从而得到第一训练数据,即其中为对x进行掩码后的结果。

[0043]

其中,令g=(v,a,x)表示一个图,v表示所有节点的集合,n=|v|表示节点的数目,a∈{0,1}n×n为邻接矩阵,x∈rn×d为输入的节点的特征矩阵,在本公开中,x也称为原始特征。g

′

表示重建的图,既可以是重建节点特征,也可以是重建结构,或者二者兼有。在本公开实施例具体以重建节点特征作为训练目标为例。

[0044]

本领域技术人员可以理解的是,掩码相当于在输入样本数据中替换了部分原有数据,相当于加入了噪音。掩码标识[mask]可以理解为一个可学习的向量。经过遮盖后的图上节点特征矩阵表示为给定部分观察到的节点特征和输入邻接矩阵a,图自动编码器的目标是重建节点集合v中被遮盖的节点的特征。

[0045]

步骤102,将第一训练数据输入至自动编码器,获得第二训练数据。

[0046]

在本公开的一种实施方式中,对第一训练数据通过自动编码器中编码,解码的过程进行数据处理。

[0047]

其中,自动编码器(autoencoder,ae)是一类在半监督学习和非监督学习中使用的人工神经网络(artificial neural networks,anns),其功能是通过将输入信息作为学习目标,对输入信息进行表征学习(representation learning)。

[0048]

自编码器包括编码器(encoder)、编码表示和解码器(decoder)。编码器是将输入数据映射为编码表示,即得到的样本表示。解码器是在重构准则的监督下,将编码表示映射到输入数据上,以重构输入数据。进一步地,在本公开实施例中,fe表示图的编码器,fd表示解码器,表示图g经过编码器之后的结果,即节点表示。因此,gae的重建目标表示为h=fe(a,x),g

′

=fd(a,h)。

[0049]

步骤103,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。

[0050]

在本公开的一种实施方式中,对于不同领域的掩码自动编码器,衡量重建质量的函数的是不同的。在本公开实施例中以直接重建每个被遮盖节点的原始特征,利用余弦误差作为重建原始节点特征的误差函数,从而减小维度和向量范数的影响。

[0051]

因此,根据本公开的实施例,通过处理输入样本数据,获得第一训练数据,将第一训练数据输入至自动编码器,获得第二训练数据,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练,实现在通过自监督算法进行数据学习,极大的提高了网络图数据分类的准确率。

[0052]

图2为本公开实施例提供的一种数据训练方法的流程示意图。图2基于图1所示的

实施例,对步骤102进行进一步定义。在图2所示的实施例中,步骤102包括步骤201和步骤202。

[0053]

如图2所示,该方法包括如下步骤。

[0054]

步骤201,将第一训练数据输入编码器,获得输入样本数据中所有节点的隐式表示。

[0055]

在本公开的一些实施方式中,将添加噪声后的图作为输入,使用多层图神经网络作为编码器

[0056]

其中,当通过编码器得到的节点表示的维度远大于输入的维度时,自动编码器有可能学习到“恒等映射函数”,即平凡解,这使得编码器的作用变得很小。降噪自动编码器通过在输入数据中添加噪声,可以避免平凡解。

[0057]

步骤202,将经采样的节点的隐式表示输入解码器,以输出第二训练数据。

[0058]

在本公开的一些实施方式中,该步骤具体包括:通过第二掩码标识遮盖输入样本数据中经采样的节点的隐式表示,并将经第二掩码标识遮盖的输入样本数据作为第二训练数据。

[0059]

具体的,使用“重掩码”策略,用另一个掩码标识[dmask],即解码器掩码标识向量,再次替换输入样本数据中选中的节点的隐式表示。将重掩码后的隐式表示作为输入,使用另一个单层的图神经网络作为解码器,重建节点的输入特征。标识[dmask]为所有被遮盖的节点共享,与编码阶段中使用的掩码标记不同。通过重掩码和使用图神经网络解码器,被遮盖的节点“被要求”从邻近的未被遮盖的节点表示中重建其输入特征。记重掩码之后的特征矩阵为

[0060]

其中,图解码器的作用fd将编码器得到的节点表示h映射回输入的节点特征x,其设计将依赖于重建目标x的语义水平。在图中,解码器重建的是信息量相对较小的高维节点特征。图神经网络解码器可以根据一个节点周围的节点分布恢复其自身的输入特征,而不局限于是节点本身,可以帮助编码器学习高层次的信息。

[0061]

综上所述,根据本公开的实施例,通过将第一训练数据输入编码器,获得输入样本数据中所有节点的隐式表示,将经采样的节点的隐式表示输入解码器,以输出第二训练数据,实现了当通过编码器得到的节点表示的维度远大于输入的维度时,在输入数据中添加噪声,避免“恒等映射函数”(即平凡解)以及缓解了严重依赖结构性数据增强和复杂的训练策略的问题。

[0062]

图3为本公开实施例提供的一种数据训练方法的流程示意图。图3基于图1所示的实施例,对步骤101、102、103进行进一步定义,其中,步骤101可以具体包括步骤301和步骤302以及步骤303,步骤102包括步骤303和步骤304。

[0063]

如图3所示,该方法包括如下步骤。

[0064]

步骤301,获取输入样本数据。

[0065]

在本公开的一种实施方式中,输入样本数据包括:所有节点的集合、节点的数目、邻接矩阵,以及输入的节点的特征矩阵。

[0066]

步骤302,对输入样本数据中的节点进行采样。

[0067]

在本公开的一种实施方式中,采用无替换的均匀随机抽样策略选取需要遮盖的节

点。在图神经网络中,每个节点可以依靠其邻居节点来增强或恢复其特征。

[0068]

步骤303,通过第一掩码标识遮盖输入样本数据中经采样的节点的原始特征,并将经第一掩码标识遮盖的输入样本数据确定为第一训练数据。

[0069]

在本公开的一种实施方式中,主要对输入样本数据中的x,即输入的节点特征矩阵进行处理。使用[mask]有可能造成训练和推理之间的不匹配,因为,[mask]标识在推理过程中不会出现。为了减少这种差异,本公开实施例以较小的概率,即15%或更小,保持节点特征不变或用另一个随机标识来替换它。其中,具体数值在本公开实施例中不做限制。记添加掩码后的图为

[0070]

步骤304,将第一训练数据输入编码器,获得输入样本数据中所有节点的隐式表示。

[0071]

步骤305,将经采样的节点的隐式表示输入解码器,以输出第二训练数据。

[0072]

步骤304和步骤305与上述步骤201和步骤202具有相同或相似的功能,其实施方式可参照上述实施例执行,在此不再赘述。

[0073]

步骤306,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。

[0074]

在本公开的一种实施方式中,该步骤包括:通过重建评估函数,计算第二训练数据与输入样本数据的相似度。基于放缩因子,构建重建评估函数,其中,重建评估函数是放缩余弦误差函数,放缩因子大于或等于1。

[0075]

具体的,余弦误差中的l2归一化将向量映射到一个“单位超球”上,能够提升表示学习的训练稳定性。同时,引入可放缩的余弦误差(scaled cosine error)来进一步改进余弦误差,可以通过将余弦误差以小于1的幂数进行调整来降低简单的样本在训练中的贡献。对于置信度高的预测,其相应的余弦误差通常小于1,并且当放缩因子大于1时,会更快地衰减为零。从形式上讲,给定原始特征x和重建输出放缩的余弦误差的定义可定义为:

[0076][0077]

其中,x表示原始特征,即输入的节点特征矩阵,xi为矩阵x的第i行表示的向量,z表示解码器的输出,zi为矩阵z的第i行表示的向量,γ表示放缩因子,为前述输入数据中进行掩码的节点集合,为集合的大小。

[0078]

最终的误差计算是对所有被遮盖的节点的误差取平均值。放缩因子是一个在不同数据集上可调整的超参数。

[0079]

综上所述,根据本公开的实施例,通过获取输入样本数据,对输入样本数据中的节点进行采样,通过第一掩码标识遮盖输入样本数据中经采样的节点的原始特征,并将经第一掩码标识遮盖的输入样本数据确定为第一训练数据,将第一训练数据输入编码器,获得输入样本数据中所有节点的隐式表示,将经采样的节点的隐式表示输入解码器,以输出第二训练数据,对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练,实现了当通过编码器得到的节点表示的维度远大于输入的维度时,在输入数据中添加噪声,避免“恒等映射函数”(即平凡解),缓解了严重依赖结构性数据增强和复杂的训练

策略的问题,以及在通过自监督算法进行数据学习,极大的提高了图网络数据分类的准确率。

[0080]

针对上述图3所示的实施例,本公开提供了具体的数据训练的示意图。如图4示出了一种基于图自编码器的生成式自监督学习的示意图。上述方法仅作为本公开的示例,不构成对本公开的限制。

[0081]

针对上述的数据训练方法,本公开以在节点分类和图分类任务上验证上述方法的有效性。表1示出了一种节点分类任务实验结果,表2示出了一种图分类任务实验结果。

[0082]

表1节点分类任务实验结果

[0083]

数据集coraogbn-arxivppireddit#节点数2,708169,34356,944232,965#边数5,4291,166,243818,73611,606,919gcn81.5%70.3%75.7%95.3%dgi82.3%70.3%63.8%94.0%bgrl82.7%71.6%73.6%94.2%本公开方法84.2%71.8%74.5%96.0%

[0084]

表2图分类任务实验结果

[0085][0086][0087]

其中,在不同种类、不同规模的网络上进行节点分类的实验。节点分类的目的是预测网络中节点的种类,例如学术网络中论文的主题,社交网络中用户的兴趣爱好等。实验使用学术网络cora和ogbn-arxiv,社交网络reddit和蛋白质网络ppi,网络的规模和实验结果如上表所示。实验结果表明了数据分类的准确率,在不同种类、不同规模的网络上,所提出的基于掩码预测的生成自监督学习方法均优于之前的对比学习和和生成式学习方法。在部分数据集上,无监督方法的表现甚至超过了有监督学习下的gcn模型。

[0088]

图分类的目的是获得整个图级别的向量表示,并分辨一个图的种类,例如分子图的手性、蛋白质的性质等,考验网络对整个图结构和特征的抽象和提取能力。该实验在社交网络imdb,生物化学网络preoteins和nci1上评估了该方法的能力。如上表所示,该方法的数据分类的准确率表现超过了传统的核方法wl以及基于对比学习的方法graphcl,这表明了该方法的有效性。

[0089]

与上述的数据训练方法相对应,本公开还提出一种数据训练装置。图5为本公开实施例提供的一种数据训练装置500的结构示意图。如图5所示,包括:处理单元510,用于处理

输入样本数据,获得第一训练数据;输入单元520,用于将第一训练数据输入至自动编码器,获得第二训练数据;对比单元530,用于对第二训练数据与输入样本数据进行相似度对比,并根据对比结果进行数据训练。

[0090]

在一些实施例中,处理单元510具体用于获取输入样本数据,对输入样本数据中的节点进行采样,通过第一掩码标识遮盖输入样本数据中经采样的节点的原始特征,并将经第一掩码标识遮盖的输入样本数据确定为第一训练数据。

[0091]

在一些实施例中,输入单元520还包括:编码单元,用于将第一训练数据输入编码器,获得输入样本数据中所有节点的隐式表示,其中,编码器为第一图神经网络。

[0092]

在一些实施例中,输入单元520还包括:解码单元,用于将经采样的节点的隐式表示输入解码器,以输出第二训练数据,其中,解码器为第二图神经网络;重掩码单元,用于通过第二掩码标识遮盖输入样本数据中经采样的节点的隐式表示,并将经第二掩码标识遮盖的输入样本数据作为第二训练数据。

[0093]

在一些实施例中,对比单元530还包括:计算单元,用于通过重建评估函数,计算第二训练数据与输入样本数据的相似度;构建单元,用于基于放缩因子,构建重建评估函数,其中,重建评估函数是放缩余弦误差函数,放缩因子大于或等于1。

[0094]

综上,根据本公开的实施例,该装置通过处理单元,输入单元以及对比单元的相应功能,实现在通过自监督算法进行数据学习,极大的提高了图数据分类的准确率。

[0095]

需要说明的是,由于本公开的装置实施例与上述的方法实施例相对应,前述对方法实施例的解释说明,也适用于本实施例的装置,原理相同,对于装置实施例中未披露的细节可参照上述的方法实施例,本公开中不再进行赘述。

[0096]

根据本公开的实施例,本公开还提供了一种电子设备、一种可读存储介质和一种计算机程序产品。

[0097]

图6示出了可以用来实施本公开的实施例的示例电子设备600的示意性框图。电子设备旨在表示各种形式的数字计算机,诸如,膝上型计算机、台式计算机、工作台、个人数字助理、服务器、刀片式服务器、大型计算机、和其它适合的计算机。电子设备还可以表示各种形式的移动装置,诸如,个人数字处理、蜂窝电话、智能电话、可穿戴设备和其它类似的计算装置。本文所示的部件、它们的连接和关系、以及它们的功能仅仅作为示例,并且不意在限制本文中描述的和/或者要求的本公开的实现。

[0098]

如图6所示,设备600包括计算单元601,其可以根据存储在rom(read-only memory,只读存储器)602中的计算机程序或者从存储单元608加载到ram(random access memory,随机访问/存取存储器)603中的计算机程序,来执行各种适当的动作和处理。在ram 603中,还可存储设备600操作所需的各种程序和数据。计算单元601、rom 602以及ram 803通过总线604彼此相连。i/o(input/output,输入/输出)接口605也连接至总线604。

[0099]

设备600中的多个部件连接至i/o接口605,包括:输入单元606,例如键盘、鼠标等;输出单元607,例如各种类型的显示器、扬声器等;存储单元608,例如磁盘、光盘等;以及通信单元609,例如网卡、调制解调器、无线通信收发机等。通信单元609允许设备600通过诸如因特网的计算机网络和/或各种电信网络与其他设备交换信息/数据。

[0100]

计算单元601可以是各种具有处理和计算能力的通用和/或专用处理组件。计算单元801的一些示例包括但不限于cpu(central processing unit,中央处理单元)、gpu

(graphic processing units,图形处理单元)、各种专用的ai(artificial intelligence,人工智能)计算芯片、各种运行机器学习模型算法的计算单元、dsp(digital signal processor,数字信号处理器)、以及任何适当的处理器、控制器、微控制器等。计算单元601执行上文所描述的各个方法和处理,例如数据训练方法。例如,在一些实施例中,数据训练方法可被实现为计算机软件程序,其被有形地包含于机器可读介质,例如存储单元608。在一些实施例中,计算机程序的部分或者全部可以经由rom 602和/或通信单元609而被载入和/或安装到设备600上。当计算机程序加载到ram 603并由计算单元601执行时,可以执行上文描述的方法的一个或多个步骤。备选地,在其他实施例中,计算单元601可以通过其他任何适当的方式(例如,借助于固件)而被配置为执行前述数据训练方法。

[0101]

本文中以上描述的系统和技术的各种实施方式可以在数字电子电路系统、集成电路系统、fpga(field programmable gate array,现场可编程门阵列)、asic(application-specific integrated circuit,专用集成电路)、assp(application specific standard product,专用标准产品)、soc(system on chip,芯片上系统的系统)、cpld(complex programmable logic device,复杂可编程逻辑设备)、计算机硬件、固件、软件、和/或它们的组合中实现。这些各种实施方式可以包括:实施在一个或者多个计算机程序中,该一个或者多个计算机程序可在包括至少一个可编程处理器的可编程系统上执行和/或解释,该可编程处理器可以是专用或者通用可编程处理器,可以从存储系统、至少一个输入装置、和至少一个输出装置接收数据和指令,并且将数据和指令传输至该存储系统、该至少一个输入装置、和该至少一个输出装置。

[0102]

用于实施本公开的方法的程序代码可以采用一个或多个编程语言的任何组合来编写。这些程序代码可以提供给通用计算机、专用计算机或其他可编程数据处理装置的处理器或控制器,使得程序代码当由处理器或控制器执行时使流程图和/或框图中所规定的功能/操作被实施。程序代码可以完全在机器上执行、部分地在机器上执行,作为独立软件包部分地在机器上执行且部分地在远程机器上执行或完全在远程机器或服务器上执行。

[0103]

在本公开的上下文中,机器可读介质可以是有形的介质,其可以包含或存储以供指令执行系统、装置或设备使用或与指令执行系统、装置或设备结合地使用的程序。机器可读介质可以是机器可读信号介质或机器可读储存介质。机器可读介质可以包括但不限于电子的、磁性的、光学的、电磁的、红外的、或半导体系统、装置或设备,或者上述内容的任何合适组合。机器可读存储介质的更具体示例会包括基于一个或多个线的电气连接、便携式计算机盘、硬盘、ram、rom、eprom(electrically programmable read-only-memory,可擦除可编程只读存储器)或快闪存储器、光纤、cd-rom(compact disc read-only memory,便捷式紧凑盘只读存储器)、光学储存设备、磁储存设备、或上述内容的任何合适组合。

[0104]

为了提供与用户的交互,可以在计算机上实施此处描述的系统和技术,该计算机具有:用于向用户显示信息的显示装置(例如,crt(cathode-ray tube,阴极射线管)或者lcd(liquid crystal display,液晶显示器)监视器);以及键盘和指向装置(例如,鼠标或者轨迹球),用户可以通过该键盘和该指向装置来将输入提供给计算机。其它种类的装置还可以用于提供与用户的交互;例如,提供给用户的反馈可以是任何形式的传感反馈(例如,视觉反馈、听觉反馈、或者触觉反馈);并且可以用任何形式(包括声输入、语音输入或者、触觉输入)来接收来自用户的输入。

[0105]

可以将此处描述的系统和技术实施在包括后台部件的计算系统(例如,作为数据服务器)、或者包括中间件部件的计算系统(例如,应用服务器)、或者包括前端部件的计算系统(例如,具有图形用户界面或者网络浏览器的用户计算机,用户可以通过该图形用户界面或者该网络浏览器来与此处描述的系统和技术的实施方式交互)、或者包括这种后台部件、中间件部件、或者前端部件的任何组合的计算系统中。可以通过任何形式或者介质的数字数据通信(例如,通信网络)来将系统的部件相互连接。通信网络的示例包括:lan(local area network,局域网)、wan(wide area network,广域网)、互联网和区块链网络。

[0106]

计算机系统可以包括客户端和服务器。客户端和服务器一般远离彼此并且通常通过通信网络进行交互。通过在相应的计算机上运行并且彼此具有客户端-服务器关系的计算机程序来产生客户端和服务器的关系。服务器可以是云服务器,又称为云计算服务器或云主机,是云计算服务体系中的一项主机产品,以解决了传统物理主机与vps服务("virtual private server",或简称"vps")中,存在的管理难度大,业务扩展性弱的缺陷。服务器也可以为分布式系统的服务器,或者是结合了区块链的服务器。

[0107]

其中,需要说明的是,人工智能是研究使计算机来模拟人的某些思维过程和智能行为(如学习、推理、思考、规划等)的学科,既有硬件层面的技术也有软件层面的技术。人工智能硬件技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理等技术;人工智能软件技术主要包括计算机视觉技术、语音识别技术、自然语言处理技术以及机器学习/深度学习、大数据处理技术、知识图谱技术等几大方向。

[0108]

应该理解,可以使用上面所示的各种形式的流程,重新排序、增加或删除步骤。例如,本发公开中记载的各步骤可以并行地执行也可以顺序地执行也可以不同的次序执行,只要能够实现本公开公开的技术方案所期望的结果,本文在此不进行限制。上述具体实施方式,并不构成对本公开保护范围的限制。本领域技术人员应该明白的是,根据设计要求和其他因素,可以进行各种修改、组合、子组合和替代。任何在本公开的精神和原则之内所作的修改、等同替换和改进等,均应包含在本公开保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1