仓储调度决策方法、装置、终端设备以及存储介质

1.本技术涉及仓储系统调度与优化领域,尤其涉及一种仓储调度决策方法、装置、终端设备以及存储介质。

背景技术:

2.目前,电商物流行业的订单任务场景呈现出规模大、时效性高和波动性大等特点,对现代物流仓储技术提出了密集化、自动化、集成化和智能化的发展需求。自动化密集型仓储系统是集高密度立体货架、输送带、多层穿梭车、提升机、条码自动识别系统和仓库管理系统为一体的新型物流存储系统,具有空间利用率高、存储容量大、作业效率高、吞吐量高和响应速度快等优点,成为打造智慧仓储中心的理想选择。

3.然而,电商物流行业的订单任务场景容易出现紧急订单、插单和订单任务剧增等突发请求,对仓储系统出入库作业的设备调度和货物分配提出一定的要求。目前对于仓储系统的设备调度和货位分配问题,多以排队论、混合整数规划建模并以优化算法求解的方法,模型复杂且实时性较差,导致系统响应慢,难以满足任务变动大、系统响应频繁的需求。传统的经典调度规则方法具有较好的实时性,但作业效率较低,设备利用率较低,致使系统总作业时间耗费较长,难以满足高吞吐量的要求。

4.因此,有必要提出一种节省仓储调度总作业时间的解决方案。

技术实现要素:

5.本技术的主要目的在于提供一种仓储调度决策方法、装置、终端设备以及存储介质,旨在解决仓储调度作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统调度决策及时、高效的目的。

6.为实现上述目的,本技术提供一种仓储调度决策方法,所述仓储调度决策方法包括:

7.当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;

8.将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。

9.可选地,所述将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案的步骤之前,还包括:

10.训练得到所述深度信念网络模型,具体包括:

11.对所述深度信念网络模型进行离线训练,得到离线训练后的深度信念网络模型;

12.对所述离线训练后的深度信念网络模型进行在线训练,得到训练好的深度信念网络模型。

13.可选地,所述对所述深度信念网络模型进行离线训练,得到离线训练后的深度信念网络模型的步骤包括:

14.建立集成优化数学模型,运用优化算法对所述集成优化数学模型进行求解,得到模拟的决策方案;

15.将所述模拟的决策方案导入至预先构建的仓储系统仿真模型进行划分,得到模拟的标签数据;

16.将预先建立的出库订单计划和所述模拟的决策方案导入至所述仓储系统仿真模型中进行模拟作业,得到模拟的运行属性状态数据;

17.根据所述运行属性状态数据生成模拟的属性特征数据;

18.获取所述密集型仓储系统的历史交互数据,生成历史的属性特征数据和历史的标签数据;

19.结合所述模拟的属性特征数据、所述历史的属性特征数据、所述模拟的标签数据和所述历史的标签数据,对所述深度信念网络模型进行离线训练,得到所述离线训练后的深度信念网络模型。

20.可选地,所述对所述离线训练后的深度信念网络模型进行在线训练,得到训练好的深度信念网络模型的步骤包括:

21.获取仓储管理系统和所述密集型仓储系统实际作业现场的在线交互数据;

22.根据所述在线交互数据对所述离线训练后的深度信念网络模型进行在线训练,得到所述训练好的深度信念网络模型。

23.可选地,所述深度信念网络模型由所述提升机选择学习模型、所述穿梭车选择学习模型和所述货位优先级学习模型组成,所述结合所述模拟的属性特征数据、所述历史的属性特征数据、所述模拟的标签数据和所述历史的标签数据,对所述深度信念网络模型进行离线训练,得到所述离线训练后的深度信念网络模型的步骤包括:

24.根据所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述提升机选择学习模型的第一训练用的属性特征数据;

25.根据所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述提升机选择学习模型的第一训练用的标签数据;

26.结合所述第一训练用的属性特征数据和所述第一训练用的标签数据对所述提升机选择学习模型进行离线训练,生成被选提升机决策方案,并得到离线训练后的提升机选择学习模型;

27.结合所述被选提升机决策方案,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述穿梭车选择学习模型的第二训练用的属性特征数据;

28.结合所述被选提升机决策方案,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述穿梭车选择学习模型的第二训练用的标签数据;

29.结合所述第二训练用的属性特征数据和所述第二训练用的标签数据对所述穿梭车选择学习模型进行离线训练,生成被选提升机-穿梭车决策方案,并得到离线训练后的穿梭车选择学习模型;

30.结合所述被选提升机-穿梭车决策方案,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述货位优先级学习模型的第三训练用的属性特征数据;

31.结合所述被选提升机-穿梭车决策方案,以及所述模拟的标签数据和所述历史的

标签数据,生成用于离线训练所述货位优先级学习模型的第三训练用的标签数据;

32.结合所述第三训练用的属性特征数据和所述第三训练用的标签数据对所述货位优先级学习模型进行离线训练,生成被选提升机-穿梭车-货位决策方案,得到离线训练后的穿梭车选择学习模型,并得到所述离线训练后的深度信念网络模型。

33.可选地,所述第三训练用的属性特征数据包括:被选巷道的属性特征、被选提升机的属性特征、被选穿梭车的属性特征、待出库货物的货位属性特征以及通过货位两两对比方式生成的货位优先级的属性特征。

34.可选地,所述将所述属性特征输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案的步骤之后,还包括:

35.根据所述调度决策方案执行仓储调度任务,具体包括:

36.当被选穿梭车执行跨层取货任务时,检测目标货物所在目标层的穿梭车工作状态信息;

37.当检测到所述目标层的穿梭车正在执行工作任务时,执行任务转移策略,具体包括:

38.取消所述被选穿梭车当前的跨层取货任务;

39.当检测到所述目标层的穿梭车结束执行任务时,执行所述跨层取货任务。

40.本技术实施例还提出一种仓储调度决策装置,所述仓储调度决策装置包括:

41.数据获取模块,用于当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;

42.调度决策模块,用于将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。

43.本技术实施例还提出一种终端设备,所述终端设备包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的仓储调度决策程序,所述仓储调度决策程序被所述处理器执行时实现如上所述的仓储调度决策方法的步骤。

44.本技术实施例还提出一种计算机可读存储介质,所述计算机可读存储介质上存储有仓储调度决策程序,所述仓储调度决策程序被处理器执行时实现如上所述的仓储调度决策方法的步骤。

45.本技术实施例提出的仓储调度决策方法、装置、终端设备以及存储介质,通过当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

附图说明

46.图1为本技术仓储调度决策装置所属终端设备的功能模块示意图;

47.图2为本技术仓储调度决策方法第一示例性实施例的流程示意图;

48.图3为本技术仓储调度决策方法实施例涉及的深度信念网络模型的结构示意图;

49.图4为本技术仓储调度决策方法第二示例性实施例的流程示意图;

50.图5为本技术仓储调度决策方法第三示例性实施例的流程示意图;

51.图6为本技术仓储调度决策方法第四示例性实施例的流程示意图;

52.图7为本技术仓储调度决策方法第五示例性实施例的流程示意图;

53.图8为本技术仓储调度决策方法第七示例性实施例的流程示意图;

54.图9为本技术仓储调度决策方法实施例涉及的自动化密集型仓储系统方案学习与实时决策的示意图;

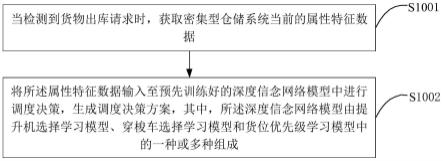

55.图10为本技术仓储调度决策方法实施例涉及的设备调度与货位分配的实时决策流程的流程示意图。

56.本技术目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

57.应当理解,此处所描述的具体实施例仅仅用以解释本技术,并不用于限定本技术。

58.本技术实施例的主要解决方案是:对深度信念网络模型进行离线训练,得到离线训练后的深度信念网络模型;对所述离线训练后的深度信念网络模型进行在线训练,得到训练好的深度信念网络模型;当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

59.具体地,参照图1,图1为本技术仓储调度决策装置所属终端设备的功能模块示意图。该仓储调度决策装置可以为独立于终端设备的、能够进行仓储调度决策、网络模型训练的装置,其可以通过硬件或软件的形式承载于终端设备上。该终端设备可以为手机、电脑等具有数据处理功能的智能移动终端,还可以为具有数据处理功能的固定终端设备或服务器等。

60.在本实施例中,该仓储调度决策装置所属终端设备至少包括输出模块110、处理器120、存储器130以及通信模块140。

61.存储器130中存储有操作系统以及仓储调度决策程序,仓储调度决策装置可以将获取的密集型仓储系统当前的属性特征数据,将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策后生成的调度决策方案,以及建立的集成优化数学模型,

运用优化算法对所述集成优化数学模型进行求解后得到的模拟的决策方案,将所述模拟的决策方案导入至预先构建的仓储系统仿真模型进行划分后得到的模拟的标签数据,建立的出库订单计划,将所述出库订单计划和所述模拟的决策方案导入至所述仓储系统仿真模型中进行模拟作业后得到的模拟的运行属性状态数据,根据所述运行属性状态数据生成的模拟的属性特征数据,获取的所述密集型仓储系统的历史交互数据,生成的历史的属性特征数据和历史的标签数据,获取的仓储管理系统和所述密集型仓储系统实际作业现场的在线交互数据等信息存储于该存储器130中;输出模块110可为显示屏等。通信模块140可以包括wifi模块、移动通信模块以及蓝牙模块等,通过通信模块140与外部设备或服务器进行通信。

62.其中,存储器130中的仓储调度决策程序被处理器执行时实现以下步骤:

63.当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;

64.将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。

65.进一步地,存储器130中的仓储调度决策程序被处理器执行时还实现以下步骤:

66.训练得到所述深度信念网络模型,具体包括:

67.对所述深度信念网络模型进行离线训练,得到离线训练后的深度信念网络模型;

68.对所述离线训练后的深度信念网络模型进行在线训练,得到训练好的深度信念网络模型。

69.进一步地,存储器130中的仓储调度决策程序被处理器执行时还实现以下步骤:

70.建立集成优化数学模型,运用优化算法对所述集成优化数学模型进行求解,得到模拟的决策方案;

71.将所述模拟的决策方案导入至预先构建的仓储系统仿真模型进行划分,得到模拟的标签数据;

72.将预先建立的出库订单计划和所述模拟的决策方案导入至所述仓储系统仿真模型中进行模拟作业,得到模拟的运行属性状态数据;

73.根据所述运行属性状态数据生成模拟的属性特征数据;

74.获取所述密集型仓储系统的历史交互数据,生成历史的属性特征数据和历史的标签数据;

75.结合所述模拟的属性特征数据、所述历史的属性特征数据、所述模拟的标签数据和所述历史的标签数据,对所述深度信念网络模型进行离线训练,得到所述离线训练后的深度信念网络模型。

76.进一步地,存储器130中的仓储调度决策程序被处理器执行时还实现以下步骤:

77.获取仓储管理系统和所述密集型仓储系统实际作业现场的在线交互数据;

78.根据所述在线交互数据对所述离线训练后的深度信念网络模型进行在线训练,得到所述训练好的深度信念网络模型。

79.进一步地,存储器130中的仓储调度决策程序被处理器执行时还实现以下步骤:

80.根据所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述提升机选择学习模型的第一训练用的属性特征数据;

81.根据所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述提升机选择学习模型的第一训练用的标签数据;

82.结合所述第一训练用的属性特征数据和所述第一训练用的标签数据对所述提升机选择学习模型进行离线训练,生成被选提升机决策方案,并得到离线训练后的提升机选择学习模型;

83.结合所述被选提升机决策方案,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述穿梭车选择学习模型的第二训练用的属性特征数据;

84.结合所述被选提升机决策方案,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述穿梭车选择学习模型的第二训练用的标签数据;

85.结合所述第二训练用的属性特征数据和所述第二训练用的标签数据对所述穿梭车选择学习模型进行离线训练,生成被选提升机-穿梭车决策方案,并得到离线训练后的穿梭车选择学习模型;

86.结合所述被选提升机-穿梭车决策方案,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述货位优先级学习模型的第三训练用的属性特征数据;

87.结合所述被选提升机-穿梭车决策方案,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述货位优先级学习模型的第三训练用的标签数据;

88.结合所述第三训练用的属性特征数据和所述第三训练用的标签数据对所述货位优先级学习模型进行离线训练,生成被选提升机-穿梭车-货位决策方案,得到离线训练后的穿梭车选择学习模型,并得到所述离线训练后的深度信念网络模型。

89.进一步地,存储器130中的仓储调度决策程序被处理器执行时还实现以下步骤:

90.根据所述调度决策方案执行仓储调度任务,具体包括:

91.当被选穿梭车执行跨层取货任务时,检测目标货物所在目标层的穿梭车工作状态信息;

92.当检测到所述目标层的穿梭车正在执行工作任务时,执行任务转移策略,具体包括:

93.取消所述被选穿梭车当前的跨层取货任务;

94.当检测到所述目标层的穿梭车结束执行任务时,执行所述跨层取货任务。

95.本实施例通过上述方案,具体通过当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

96.基于上述终端设备架构但不限于上述架构,提出本技术方法实施例。

97.参照图2,图2为本技术仓储调度决策方法第一示例性实施例的流程示意图。本实施例方法的执行主体可以是一种仓储调度决策装置,也可以是一种仓储调度决策终端设备或服务器,本实施例以仓储调度决策装置进行举例,该仓储调度决策装置可以集成在具有数据处理功能的智能手机、平板电脑等终端设备上。所述仓储调度决策方法包括:

98.步骤s1001,当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据。

99.具体地,当系统检测到货物出库请求时,获取所述密集型仓储系统当前的属性特征数据,其中,所述属性特征数据是与所述密集型仓储系统的运行状态信息相关的数据,可以由系统的运行状态信息中提取得到。在本实施例中,所述密集型仓储系统可以是一种集高密度立体货架、输送带、多层穿梭车、提升机、条码自动识别系统和仓库管理系统为一体的物流存储系统。一般地,密集型仓储系统的结构分布包括:每两排货架形成一个巷道,每个巷道入口处配有穿梭车提升机和货物提升机,每种货物在不同货架上存放在多个货位中。每个巷道配有数台穿梭车,穿梭车可以通过穿梭车提升机实现跨层取货,但只能在固定的巷道运动,货物可以通过货位提升机实现出库。货架每层的入口处配有货物缓存区。当某一巷道被选择后,对应的穿梭车提升机和货物提升机同时被选择。

100.步骤s1002,将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。

101.具体地,将获取到的所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案。如图3所示,图3为本技术仓储调度决策方法涉及的深度信念网络模型的结构示意图,所述深度信念网络模型的结构通过受限玻尔兹曼机rbm的顺序堆叠来构造,即,前一个rbm的输出是下一个rbm的输入。该网络结构的学习过程分为两个阶段,首先是对rbm进行逐层无监督预训练,然后再用反向传播算法bp对整个网络进行有监督的调优。

102.rbm是一种双层神经网络结构的生成模型,第1层为可见层v,用来接受输入,由n个可见单元v=(v1,v2,

…

,vn)构成,一般服从伯努利分布或者高斯分布。第2层为隐藏层h,由m个隐藏单元h=(h1,h2,

…

,hm)构成,一般服从伯努利分布。所有的可见单元与隐藏单元全部连接,而可见层与隐藏层自身内部的单元互不连接,即层间全连接,层内无连接。相连接的神经元之间的权重w={w

ij

}∈rn×m,i=1,2,

…

,n,j=1,2,

…

,m。a={ai}∈rn和b={bj}∈rm,分别表示第i个可见单元和第j个隐藏单元的偏置。如下公式1所示,对于v和h均服从伯努利分布的rbm,其能量函数为:

[0103][0104]

式中,vi和hj分别表示第i个可见单元和第j个隐藏单元的二元状态,w

ij

表示第i个可见单元和第j个隐藏单元之间的权值。较低的能量表示网络处于更理想的状态,即学习误差最低。对该能量函数正则化和指数化后,得到可见节点与隐藏节点一组状态的联合概率分布公式,如下公式2和3所示:

[0105][0106][0107]

可见神经元和隐藏神经元的条件概率分布如下公式4和5所示:

[0108][0109][0110]

在给定v和h时,可以得到隐藏层单元hj和可见层单元vi的激活状态概率。采用对比散度算法逐层求解以获得每层rbm权值的最优解。通过计算对数似然函数logp(v,h|θ)的梯度,可以得到rbm权值更新公式,如下公式6和7所示:

[0111][0112][0113]

式中,τ和η分别表示rbm的迭代次数和学习率,e

data

(v

ihj

)和e

model

(v

ihj

)分别表示训练集中观测数据的期望和模型所确定分布上的期望。

[0114]

前向堆叠rbm学习属于无监督学习,对每层rbm贪婪逐层训练后得到整个初始化的权重w={w1,w2,

…wl

},相当于为监督学习提供了输入数据的先验知识。后向微调学习是从dbn网络输出层出发,利用已知标签逐步向输入层微调模型参数,即通过bp算法对网络进行有监督的训练,精调从输出层到输入层的参数以减小梯度。深度信念网络模型最后一层的构建以soft-max作为分类器模型,模型的输出结果以概率的形式展现,选取最大概率所对应的类别即为模型的判定结果。

[0115]

基于上述网络结构,所述深度信念网络模型可以由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。

[0116]

本实施例通过上述方案,具体通过当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系

统调度决策的及时与高效。

[0117]

参照图4,图4为本技术仓储调度决策方法第二示例性实施例的流程示意图。基于上述图2所示的实施例,在本实施例中,在当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据的步骤之前,所述图片修复方法还包括:

[0118]

步骤s1000,训练得到所述深度信念网络模型。本实施例以步骤s1000在步骤s1001之前实施,在其他实施例中,步骤s1000也可以在步骤s1001与步骤s1002之间实施。

[0119]

相比上述图2所示的实施例,本实施例还包括训练得到所述深度信念网络模型的方案。

[0120]

具体地,训练得到所述深度信念网络模型的步骤可以包括:

[0121]

步骤s1100,对所述深度信念网络模型进行离线训练,得到离线训练后的深度信念网络模型;

[0122]

步骤s1200,对所述离线训练后的深度信念网络模型进行在线训练,得到训练好的深度信念网络模型。

[0123]

更为具体地,本实施例对构建的所述深度信念网络模型进行离线训练,完成离线训练后,得到离线训练后的深度信念网络模型,其中,所述离线训练是指通过预先获取到的训练样本数据在模拟或仿真的状态下对所述深度信念网络模型进行训练。然后,对得到的离线训练后的深度信念网络模型进行在线训练,完成在线训练后,得到在线训练后的深度信念网络模型,其中,所述在线训练是指通过获取实际现场操作生成的增量样本数据在真实环境中对所述深度信念网络模型进行训练。此时,完成训练后,得到训练好的深度信念网络模型。

[0124]

之后即可通过训练好的深度信念网络模型对所述密集型仓储系统进行调度决策。

[0125]

本实施例通过上述方案,具体通过训练得到所述深度信念网络模型;当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0126]

进一步地,参照图5,图5为本技术仓储调度决策方法第三示例性实施例的流程示意图。基于上述图4所示的实施例,在本实施例中,步骤s1100,对所述深度信念网络模型进行离线训练,得到离线训练后的深度信念网络模型可以包括:

[0127]

步骤s1110,建立集成优化数学模型,运用优化算法对所述集成优化数学模型进行求解,得到模拟的决策方案。

[0128]

具体地,依据系统运行过程的合理假设和约束,以最小化总作业时间为目标建立集成优化数学模型,然后,运用优化算法对所建立的集成优化数学模型进行求解,得到模拟的决策方案,其中,所述模拟的决策方案为近似最优的仓储调度决策方案,所述决策方案的

内容可以包括设备的调度及货位的分配。

[0129]

步骤s1120,将所述模拟的决策方案导入至预先构建的仓储系统仿真模型进行划分,得到模拟的标签数据。

[0130]

具体地,将得到的所述模拟的决策方案导入至预先构建的仓储系统仿真模型中进行调度方案指令的划分,其中,所述调度方案指令可以分为设备调度指令和货位分配指令,然后根据得到的所述调度方案指令生成用于训练的模拟的标签数据。

[0131]

步骤s1130,将预先建立的出库订单计划和所述模拟的决策方案导入至所述仓储系统仿真模型中进行模拟作业,得到模拟的运行属性状态数据。

[0132]

具体地,根据问题实例建立出库订单计划,将预先建立的所述出库订单计划和所述模拟的决策方案导入至预先构建的所述仓储系统仿真模型中,通过仓储系统仿真模型模拟作业过程,并提取得到模拟的运行属性状态数据。其中,所述运行属性状态数据是与仓储系统的运行,如设备调度、货位分配相关的数据。

[0133]

步骤s1140,根据所述运行属性状态数据生成模拟的属性特征数据。

[0134]

具体地,根据得到的所述运行属性状态数据生成用于训练的模拟的属性特征数据。

[0135]

步骤s1150,获取所述密集型仓储系统的历史交互数据,生成历史的属性特征数据和历史的标签数据。

[0136]

具体地,获取所述密集型仓储系统的历史交互数据,其中,所述历史交互数据是由仓储管理系统与密集型仓储系统在历史作业过程中产生,所述历史交互数据的内容可以包括但不限于历史的运行属性状态数据和历史的调度方案指令,然后,根据所述历史交互数据生成历史的属性特征数据和历史的标签数据。

[0137]

步骤s1160,结合所述模拟的属性特征数据、所述历史的属性特征数据、所述模拟的标签数据和所述历史的标签数据,对所述深度信念网络模型进行离线训练,得到所述离线训练后的深度信念网络模型。

[0138]

具体地,结合所述模拟的属性特征数据、所述历史的属性特征数据、所述模拟的标签数据和所述历史的标签数据,即,将模拟的数据与历史的数据进行合并,共同生成用于训练的属性特征数据和标签数据,对所述深度信念网络模型进行离线训练,完成训练后,得到所述离线训练后的深度信念网络模型。

[0139]

本实施例通过针对系统运行过程数据,构建密集型仓储系统的运行状态属性特征,并通过提取系统运行过程中影响设备调度和货位分配的关键属性,针对不同的模型学习目标建立对应范围的属性特征,降低了模型输入维度,减少训练时间。

[0140]

本实施例过上述方案,具体通过训练得到所述深度信念网络模型;当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现

场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0141]

进一步地,参照图6,图6为本技术仓储调度决策方法第四示例性实施例的流程示意图。基于上述图5所示的实施例,在本实施例中,步骤s1200,对所述离线训练后的深度信念网络模型进行在线训练,得到训练好的深度信念网络模型可以包括:

[0142]

步骤s1210,获取仓储管理系统和所述密集型仓储系统实际作业现场的在线交互数据。

[0143]

具体地,获取仓储管理系统和所述密集型仓储系统在实际作业现场产生的在线交互数据,其中,所述在线交互数据的内容可以包括但不限于在线的运行属性状态数据和在线的调度方案指令。根据所述在线交互数据可以生成在线的属性特征数据和在线的标签数据。

[0144]

步骤s1220,根据所述在线交互数据对所述离线训练后的深度信念网络模型进行在线训练,得到所述训练好的深度信念网络模型。

[0145]

具体地,根据所述在线交互数据对所述离线训练后的深度信念网络模型进行在线训练,即,通过将根据所述在线交互数据生成的所述在线的属性特征数据和在线的标签数据输入至离线训练后的深度信念网络模型中进行在线训练,完成训练后,得到在线训练后的深度信念网络模型。此时,得到训练好的深度信念网络模型。

[0146]

之后即可通过训练好的深度信念网络模型对所述密集型仓储系统进行调度决策。

[0147]

本实施例通过上述方案,具体通过训练得到所述深度信念网络模型;当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0148]

参照图7,图7为本技术仓储调度决策方法第五示例性实施例的流程示意图。基于上述图6所示的实施例,在本实施例中,所述深度信念网络模型由所述提升机选择学习模型、所述穿梭车选择学习模型和所述货位优先级学习模型组成,步骤s1160,结合所述模拟的属性特征数据、所述历史的属性特征数据、所述模拟的标签数据和所述历史的标签数据,对所述深度信念网络模型进行离线训练,得到所述离线训练后的深度信念网络模型可以包括:

[0149]

步骤s1161,根据所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述提升机选择学习模型的第一训练用的属性特征数据。

[0150]

具体地,根据得到的所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述提升机选择学习模型的训练用的属性特征数据,并作为第一训练用的属性特征数据。其中,所述提升机选择学习模型用于生成被选巷道和被选提升机的调度决策

方案。所述第一训练用的属性特征数据的属性类型包括连续类型和布尔类型,属性特征数据的内容包括仓储系统内所有巷道及配备的提升机的特征,如巷道内空闲穿梭车数目、巷道内到达目标层的穿梭车数目、巷道库位率、穿梭车提升机是否空闲、穿梭车提升机目标层等。假设仓储系统的立体货架设有m个巷道,则对应配有m台穿梭车提升机和m台货物提升机,对于每一个巷道和提升机的属性,需要建立m个对应的属性特征。

[0151]

其中,属性特征巷道库位率sr_lane的计算如下公式8所示:

[0152][0153]

其中,n

r1

和n

r2

分别指巷道两侧货架中被占用的货架单元数,n

r1

和n

r2

分别指巷道两侧货架的单元总数。

[0154]

步骤s1162,根据所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述提升机选择学习模型的训练用的标签数据。

[0155]

具体地,根据得到的所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述提升机选择学习模型的训练用的标签数据,并作为第一训练用的标签数据,其中,所述第一训练用的标签数据为提升机的编号。

[0156]

步骤s1163,结合所述第一训练用的属性特征数据和所述第一训练用的标签数据对所述提升机选择学习模型进行离线训练,生成被选提升机决策方案,并得到离线训练后的提升机选择学习模型。

[0157]

具体地,结合得到的所述第一训练用的属性特征数据和所述第一训练用的标签数据,对所述提升机选择学习模型进行离线训练,生成被选提升机决策方案,所述被选提升机决策方案的内容包括被选巷道和被选提升机及其属性特征数据与标签数据,此时,得到离线训练后的提升机选择学习模型。

[0158]

步骤s1164,结合所述被选提升机决策方案,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述穿梭车选择学习模型的第二训练用的属性特征数据。

[0159]

具体地,结合所述被选提升机决策方案,其中,包括被选巷道和被选提升机的属性特征数据,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述穿梭车选择学习模型的训练用的属性特征数据,并作为第二训练用的属性特征数据。其中,所述穿梭车选择学习模型用于生成被选巷道、被选提升机和被选穿梭车的调度决策方案。所述第二训练用的属性特征数据的属性类型包括连续类型和布尔类型,其内容包括被选巷道的属性特征、被选提升机的属性特征以及被选巷道配备的所有穿梭车的属性特征,如穿梭车是否空闲、穿梭车是否在目标层、穿梭车目标层、穿梭车待完成任务数、穿梭车任务完成度等。假设每个巷道配有k台穿梭车,对于每一个穿梭车的属性,需要建立k个对应的属性特征。

[0160]

其中,属性特征穿梭车任务完成度s_comp的计算如下公式9所示:

[0161]

[0162]

其中,t

comp

指穿梭车已完成的任务数,t

total

指穿梭车截止当前时刻的总任务数。

[0163]

步骤s1165,结合所述被选提升机决策方案,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述穿梭车选择学习模型的第二训练用的标签数据。

[0164]

具体地,结合所述被选提升机决策方案,其中,包括被选巷道和被选提升机的标签数据,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述穿梭车选择学习模型的训练用的标签数据,并作为第二训练用的标签数据,其中,所述第二训练用的标签数据为穿梭车的编号。

[0165]

步骤s1166,结合所述第二训练用的属性特征数据和所述第二训练用的标签数据对所述穿梭车选择学习模型进行离线训练,生成被选提升机-穿梭车决策方案,并得到离线训练后的穿梭车选择学习模型。

[0166]

具体地,结合得到的所述第二训练用的属性特征数据和所述第二训练用的标签数据,对所述穿梭车选择学习模型进行离线训练,生成被选提升机-穿梭车决策方案,所述被选提升机-穿梭车决策方案的内容包括被选巷道、被选提升机和被选穿梭车及其属性特征数据与标签数据,此时,得到离线训练后的穿梭车选择学习模型。

[0167]

步骤s1167,结合所述被选提升机-穿梭车决策方案,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述货位优先级学习模型的第三训练用的属性特征数据。

[0168]

具体地,结合所述被选提升机-穿梭车决策方案,其中,包括被选巷道、被选提升机和被选穿梭车的属性特征数据,以及所述模拟的属性特征数据和所述历史的属性特征数据,生成用于离线训练所述货位优先级学习模型的训练用的属性特征数据,并作为第三训练用的属性特征数据。其中,所述货位优先级学习模型用于生成被选巷道、被选提升机、被选穿梭车以及被选货位的调度决策方案。所述第三训练用的属性特征数据的属性类型包括连续类型和布尔类型,其内容包括被选巷道的属性特征、被选提升机的属性特征、被选穿梭车的属性特征以及被选巷道所有此刻需要出库的货物货位的属性特征以及构建的其他与货位相关的特征,如货位所在层是否存在未选择的穿梭车、货位所在货架、货位所在层、货位所在货架的库位率、穿梭车到达货位所需时间等。

[0169]

其中,属性特征货位所在货架的库位率sr_rack的计算如下公式10所示:

[0170][0171]

其中,nr指货架中被占用的货架单元数,nr指货架的单元总数。

[0172]

其中,属性特征穿梭车到达货位所需时间的计算如下公式11所示:

[0173][0174]

其中,t

load_1

指货箱从货架装载到穿梭车的时间,t

load_2

指穿梭车从轨道驶入提升机的时间,t

unload_1

指货箱从穿梭车卸载到缓存区的时间,t

unload_2

指穿梭车从提升机驶入轨

道的时间,z

shuttle

指穿梭车所在的层,z

cargo

指目标货位所在的层。表示水平向上穿梭车从待命点到达货位的行程时间,计算过程如下公式12所示:

[0175][0176]

其中,y1,y2分别表示待命点和货位所在的位置,w0表示货架单元的宽度,as表示穿梭车的加速度,vs表示穿梭车的最大行驶速度,c表示货架的总列数。

[0177]

表示垂直方向上穿梭车通过提升机跨层的行程时间,计算过程如下公式13所示:

[0178][0179]

其中,z1,z2分别表示穿梭车所在层和目标货位所在层,h0表示货架单元的高度,a

l

表示提升机的加速度,v

l

表示提升机的最大行驶速度,n-tier表示货架的总层数。

[0180]

步骤s1168,结合所述被选提升机-穿梭车决策方案,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述货位优先级学习模型的第三训练用的标签数据。

[0181]

具体地,结合所述被选提升机-穿梭车决策方案,其中,包括被选巷道、被选提升机和被选穿梭车的标签数据,以及所述模拟的标签数据和所述历史的标签数据,生成用于离线训练所述货位优先级学习模型的训练用的标签数据,并作为第三训练用的标签数据,其中,所述第三训练用的标签数据为货位优先级“高”和“低”。

[0182]

步骤s1169,结合所述第三训练用的属性特征数据和所述第三训练用的标签数据对所述货位优先级学习模型进行离线训练,生成被选提升机-穿梭车-货位决策方案,得到离线训练后的穿梭车选择学习模型,并得到所述离线训练后的深度信念网络模型。

[0183]

具体地,结合得到的所述第三训练用的属性特征数据和所述第三训练用的标签数据,对所述货位优先级学习模型进行离线训练,生成被选提升机-穿梭车-货位决策方案,所述被选提升机-穿梭车-货位决策方案的内容包括被选巷道、被选提升机、被选穿梭车和被选货位及其属性特征数据与标签数据,此时,得到离线训练后的穿梭车选择学习模型,并得到所述离线训练后的深度信念网络模型。

[0184]

在本实施例中,对于不同的学习目标,同一对象源的属性特征数据和构建范围不同,具体如下表一所示。其中,建立的用于提升机选择、穿梭车选择和货位优先级学习的属

性特征的详细描述如下表二所示:

[0185][0186][0187]

表一:同一对象源的属性特征数据和构建范围表

[0188][0189]

表二:用于提升机选择、穿梭车选择和货位优先级学习的属性特征

[0190]

本实施例通过建立提升机选择、穿梭车选择和货位优先级的三阶段深度信念网络

模型,以最小化系统做作业时间为目标,实现较优调度方案解的集成学习。

[0191]

本实施例通过上述方案,具体通过训练得到所述深度信念网络模型;当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0192]

进一步地,基于上述实施例,在本实施例中,所述第三训练用的属性特征数据包括:被选巷道的属性特征、被选提升机的属性特征、被选穿梭车的属性特征、待出库货物的货位属性特征以及通过货位两两对比方式生成的货位优先级的属性特征。

[0193]

具体地,用于训练货位优先级学习模型的第三训练用的属性特征数据包括:被选巷道的属性特征、被选提升机的属性特征、被选穿梭车的属性特征、待出库货物的货位属性特征以及通过货位两两对比方式生成的货位优先级的属性特征。其中,所述货位两两对比方式用于构建货位优先级的扩充的属性特征,具体为:将货位cl1设为a,货位cl2设为b,以a作为对象,将b与a进行对比,例如对于属性特征“货位的层数”,构建“货位层数(a)《货位层数(b)”的布尔类型特征,以此类推。如果选择结果是a优先于b,则优先级输出为“高”。其次,将货位cl2设为a,货位cl1设为b,方法同上,则优先级输出为“低”。假设某种货物在某巷道共有n处存放位置,则需要按照上述方法建立对属性特征。

[0194]

本实施例针对货位优先级学习模型提出的货位两两对比方式,扩建布尔类型的属性特征,提高了模型的学习准确率。

[0195]

如图8所示,图8是本技术仓储调度决策方法第七示例性实施例的流程示意图。基于上述实施例,在本实施中,在步骤s1002,将所述属性特征输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案之后,还包括:步骤s1003,根据所述调度决策方案执行仓储调度任务。

[0196]

具体地,根据所述调度决策方案执行仓储调度任务的步骤可以包括:

[0197]

当被选穿梭车执行跨层取货任务时,检测目标货物所在目标层的穿梭车工作状态信息;

[0198]

当检测到所述目标层的穿梭车正在执行工作任务时,执行任务转移策略。

[0199]

具体地,在被选穿梭车执行任务过程中,当需要通过被选提升机实现跨层取货任务时,首先检测目标货物所在目标层的穿梭车工作状态信息;当检测到所述目标层的穿梭车正在该目标层执行工作任务时,所述被选穿梭车执行任务转移策略,以避免在执行任务过程中出现穿梭车冲突现象。

[0200]

进一步地,所述当检测到所述目标层的穿梭车正在执行工作任务时,执行任务转移策略的步骤可以包括:

[0201]

取消所述被选穿梭车当前的跨层取货任务;

[0202]

当检测到所述目标层的穿梭车结束执行任务时,执行所述跨层取货任务。

[0203]

具体地,在被选穿梭车准备执行跨层取货的任务时,若检测到所述目标层的穿梭车正在该层执行工作任务,则取消所述被选穿梭车当前的跨层取货任务,并将该任务的执行时间转移到在所述目标层执行任务的当前的穿梭车的下一个时刻,换句话说,在所述目标层上,在执行当前任务的穿梭车完成任务执行后,所述被选穿梭车将会开始执行跨层取货任务。因此,当检测到所述目标层的穿梭车结束执行任务时,所述被选穿梭车开始执行跨层取货任务。

[0204]

本实施例通过上述方案,具体通过当被选穿梭车执行跨层取货任务时,检测目标货物所在目标层的穿梭车工作状态信息;当检测到所述目标层的穿梭车正在执行工作任务时,执行任务转移策略,可以有效的避免在执行任务过程中出现穿梭车冲突的现象。

[0205]

如图9所示,图9是本技术仓储调度决策方法实施例涉及的自动化密集型仓储系统方案学习与实时决策的示意图。在本实施例中,所述自动化密集型仓储系统方案学习与实时决策的流程可以包括:基于深度信念网络的实时决策和自动化高密度仓储系统作业现场,其中,自动化高密度仓储系统为深度信念网络提供实时系统运行信息,而深度信念网络则为自动化高密度仓储系统的现场作业提供实时决策指导。

[0206]

基于深度信念网络的实时决策的流程包括:

[0207]

首先,根据实时系统运行信息,获取巷道和提升机的属性状态信息,提取生成第一属性特征数据,将所述第一属性特征数据输入至提升机选择学习模型进行调度决策,生成被选提升机决策方案。

[0208]

然后,结合所述被选提升机决策方案,获取被选巷道和提升机的属性状态信息以及穿梭车的属性状态信息,提取生成第二属性特征数据,将所述第二属性特征数据输入至穿梭车选择学习模型进行调度决策,生成被选提升机-穿梭车决策方案。

[0209]

最后,结合所述被选提升机-穿梭车决策方案,获取被选巷道和提升机的属性状态信息、被选穿梭车的属性状态信息以及货位的属性状态信息,提取生成第三属性特征数据,将所述第三属性特征数据输入至货位优先级学习模型进行调度决策,生成被选提升机-穿梭车-货位决策方案。

[0210]

根据深度信念网络生成的被选提升机-穿梭车-货位决策方案的指导,自动化高密度仓储系统执行相关仓储调度任务,并将任务执行过程中生成的实时系统运行信息提供给深度信念网络。

[0211]

本实施例通过上述方案,将训练后的三阶段深度信念网络模型集成到仓储管理系统中,通过实时获取系统运行属性状态信息,实现对提升机、穿梭车调度和货位分配的即时、高效的决策。与传统的经典调度规则相比,在不同任务规模下,具有更少的系统总作业时间。

[0212]

如图10所示,图10是本技术仓储调度决策方法实施例涉及的设备调度与货位分配的实时决策流程的流程示意图。在本实施例中,所述仓储调度决策方法的设备调度与货位分配的实时决策流程可以包括:

[0213]

在某一时刻t收到系统的某个货物出库请求时,首先根据系统运行属性状态信息,构建当前系统作业现场的用于巷道和提升机选择学习的属性特征,通过训练后的提升机选择学习模型,为请求出库的货物选择巷道和提升机。

[0214]

然后,基于上述步骤,构建当前系统作业现场的用于穿梭车选择学习的属性特征,通过训练后的穿梭车选择学习模型,为请求出库的货物选择穿梭车。

[0215]

然后,基于上述步骤,获得当前系统作业现场的用于货位优先级学习的属性状态信息,检索获得请求出库的货物在被选巷道的所有货位,通过货位两两对比方式构建货位优先级学习的属性特征,然后通过训练后的货位优先级学习模型,为请求出库的货位选择优先级最高的货位。

[0216]

最后,基于上述步骤,生成被选提升机-穿梭车-货位的决策方案,根据所述方案执行仓储调度任务,完成本批订单出库计划。

[0217]

之后,判断该批订单出库计划是否完成,若完成则结束本次仓储调度任务;若未完成,则等待下一个货物出库请求。

[0218]

本实施例通过上述方案,具体通过训练得到所述深度信念网络模型;当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0219]

进一步地,在本实施例中提供了一种仓储调度决策方法的具体实施案例以及性能验证案例。

[0220]

以某自动化密集型仓储中心的立体仓库为例。仓储系统设有4排巷道,每排巷道两侧各设立1个单深度的密集型货架,每个货架20层,40列。货架每层都设有缓存区用于缓存货箱,缓存区的容量为1。每排巷道配备1台穿梭车提升机、1台货物提升机和3台多层穿梭车。以系统的出库作业为例,已知仓储系统的货物初始位置和历史出库订单列表。通过基于该真实仓储系统的仿真案例进行实验分析,采用专业的离散时间仿真软件平台西门子tecnomatix建立了该仓储系统的仿真场景。

[0221]

为了实现本发明提出的实时决策方法,开发了dbn程序,并与仿真平台集成。dbn程序通过python编码在tensorflow上开发,系统仿真程序通过内置的simtalk编程语言在tecnomatix上开发。仿真程序包括以下几个子程序:仓储系统控制器、系统运行状态控制器、任务控制器、调度指令生成器、通信器和调度器。仓储系统控制器模拟系统运行过程,任务控制器负责管理出库订单计划,通信器通过com接口与仿真程序和dbn程序建立实时信息交互。

[0222]

决策方案学习过程如下:根据问题实例建立设备调度和货位分配集成优化模型并运用优化算法求解得到较优的决策方案。将问题实例的出库订单计划和决策方案导入任务控制器,通过仓储系统控制器模拟作业过程。当任务控制器根据出库订单计划依次触发货物出库任务时,系统实时的运行属性状态信息发送给系统运行状态控制器,运行状态控制器对信息进行记录并处理,生成用于模型训练的特征数据。调度指令生成器根据导入的决

策方案划分设备调度与货位分配指令,建立用于模型训练的标签数据。生成的系统状态特征数据和标签数据对dbn模型进行训练,得到训练后的提升机、穿梭车选择学习和货位优先级学习模型。

[0223]

实时决策过程如下:任务控制器根据出库订单计划依次触发货物出库请求,系统运行状态控制器生成实时的系统属性特征数据,发送到通信器,通信器将数据发送给训练后的dbn程序,输出得到设备调度与货位分配方案发送给调度器,调度器将实时的调度指令通过通信器发送给仓储系统控制器执行。任务的完整执行过程信息被保存到仿真平台的数据库中。

[0224]

对历史订单数据通过上述方法进行处理,得到用于提升机选择学习的样本共11880条,穿梭车选择学习的样本共11880条,货位优先级学习的样本共29466条。其中,设定80%的样本作为训练集,20%的样本作为测试集。根据本发明提出的特征数据构建方法,用于巷道/提升机选择学习的属性特征数目为(4+7)*4+4*4=60,用于穿梭车选择学习的属性特征数目为(3+5)*3+4+7+4=39,用于货位优先级学习的属性特征数目为(2+6)*2+7+3+5+4+7+4=46。

[0225]

算法的参数对算法的性能影响至关重要。田口法可以通过较少的实验次数选择出最佳参数,大幅度减少计算的成本。深度信念网络包括以下的重要参数:(1)网络节点数目nn;(2)隐藏层数目nh;(3)rbm学习率r1;(4)bp学习率r2;(5)批量规模bs。对每个参数考虑4个因素水平,如下表三所示。采用正交矩阵l

16

(45)设计实验。所有实验的rbm迭代次数设为20,bp迭代次数设为300,激活函数采用relu函数。采用上述数据集进行参数选择实验。每个案例运行30次,提升机选择(ls)、穿梭车选择(ss)和货位优先级(lp)的模型学习准确率均值如下表四所示。

[0226][0227]

表三:深度信念网络的重要参数的因素水平

[0228][0229][0230]

表四:提升机选择(ls)、穿梭车选择(ss)和货位优先级(lp)的模型学习准确率均值

[0231]

ls、ss和lp三个模型的信噪比响应值和每个参数的重要性排行分别如下表五、表六和表七所示。

[0232]

levelnnnhr1r2bs1-1.2604-0.6535-0.5608-0.8024-0.54102-0.5895-0.6042-0.7203-0.5996-0.58013-0.8374-0.5829-0.6369-0.5760-0.72414-0.5693-1.4161-1.3387-1.2787-1.4115delta0.69110.83320.77790.70270.8706rank52341

[0233]

表五

[0234]

levelnnnhr1r2bs1-0.5357-0.3567-0.3769-0.4709-0.28162-0.4875-0.3419-0.3481-0.4393-0.40563-0.3300-0.5506-0.3819-0.3697-0.28554-0.3348-0.4387-0.5811-0.4080-0.7153delta0.20570.20870.23300.10120.4337

rank43251

[0235]

表六

[0236][0237][0238]

表七

[0239]

delta表示参数的重要性排行。可以看出,不同模型的参数影响程度次序不同。因此,三个模型的参数均需要仔细的选择,以防止模型欠拟合或过拟合。最大的信噪比响应值的参数组选择为最佳参数组,即ls:nn=256,nh=3,r1=0.02,r2=0.1,bs=128;ss:nn=128,nh=2,r1=0.05,r2=0.1,bs=128;lp:nn=256,nh=4,r1=0.05,r2=0.2,bs=256。

[0240]

为验证本文所提出的实时决策方法的性能,将本文的方法与传统的经典调度规则进行对比。根据案例,密集型仓储系统运行参数设置如下表八所示。经典调度规则根据用途可分为提升机调度、穿梭车调度和货位分配3类。经典规则的详细信息如下表九所示。将3类规则组合形成8种仓储系统的调度规则组,如下表十所示。例如,调度规则组s1表示提升机调度采用最短任务队列规则,穿梭车调度采用最长等时间规则以及货位分配采用最短搬运距离规则。在6种规模的任务(ts)上进行实验,以系统总作业时间作为指标,表格中p代表本文所提出的方法,实验结果如下表十一所示。本文的方法与经典调度规则组相比的总作业时间减少比率如下表十二所示。其中,mi代表同一任务规模下最小的总作业时间减少比率,av代表不同任务规模下相同调度规则组下总作业时间减少比率的均值。

[0241]

w0h0v

svlasal

t

load_1

t

load_2

t

unload_1

t

unload_2

0.750.754211.56767

[0242]

表八:密集型仓储系统运行参数设置

[0243]

[0244][0245]

表九:经典规则的详细信息

[0246]

no.调度规则组no.调度规则组s1stq-lwt-mhds5mnis-lwt-mhds2stq-lwt-stts6mnis-lwt-stts3stq-stq-mhds7mnis-stq-mhds4stq-stq-stts8mnis-stq-stt

[0247]

表十:仓储系统的调度规则组

[0248][0249]

表十一:实验结果

[0250][0251][0252]

表十二:本方法与经典调度规则组相比的总作业时间减少比率

[0253]

由表十一可得,不同任务规模下,本文所提出的方法的总作业时间均小于经典调度规则组。由表十二可以看出,本文的方法与经典调度规则组相比,平均系统总作业时间最小可减少6.54%,最大可减少17.22%;随着任务规模的增加,系统总作业时间减少比率最

小值呈逐渐增大的趋势,当批次任务规模达到100时,系统总作业时间最少可减少7.4%。因此验证了本文所提出的实时决策方法在密集型仓储系统作业的优越性。

[0254]

本实施例通过上述方案,具体通过当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0255]

此外,本技术实施例还提出一种仓储调度决策装置,所述仓储调度决策装置包括:

[0256]

数据获取模块,用于当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;

[0257]

调度决策模块,用于将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。

[0258]

本实施例实现仓储调度决策的原理及实施过程,请参照上述各实施例,在此一一不再赘述。

[0259]

此外,本技术实施例还提出一种终端设备,所述终端设备包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的仓储调度决策程序,所述仓储调度决策程序被所述处理器执行时实现如上所述的仓储调度决策方法的步骤。

[0260]

由于本仓储调度决策程序被处理器执行时,采用了前述所有实施例的全部技术方案,因此至少具有前述所有实施例的全部技术方案所带来的所有有益效果,在此不再一一赘述。

[0261]

此外,本技术实施例还提出一种计算机可读存储介质,所述计算机可读存储介质上存储有仓储调度决策程序,所述仓储调度决策程序被处理器执行时实现如上所述的仓储调度决策方法的步骤。

[0262]

由于本仓储调度决策程序被处理器执行时,采用了前述所有实施例的全部技术方案,因此至少具有前述所有实施例的全部技术方案所带来的所有有益效果,在此不再一一赘述。

[0263]

相比现有技术,本技术实施例提出的仓储调度决策方法、装置、终端设备以及存储介质,通过当检测到货物出库请求时,获取密集型仓储系统当前的属性特征数据;将所述属性特征数据输入至预先训练好的深度信念网络模型中进行调度决策,生成调度决策方案,其中,所述深度信念网络模型由提升机选择学习模型、穿梭车选择学习模型和货位优先级学习模型中的一种或多种组成。通过训练后的深度信念网络模型对密集型仓储系统的货物出库请求进行调度决策,可以解决作业效率较低,设备利用率较低,致使系统总作业时间耗费长的问题,达到仓储系统的调度决策及时、高效的目的。通过本技术方案,不需要建立复

杂的数学模型和假设约束,而是从系统运行过程积累的海量数据中学习密集型仓储系统调度的潜在规律,并为现场作业提供决策指导。基于本技术方案以最小化系统总作业时间为目标,通过实时获取系统运行过程信息,实现了仓储系统调度决策的及时与高效。

[0264]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者系统不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者系统所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者系统中还存在另外的相同要素。

[0265]

上述本技术实施例序号仅仅为了描述,不代表实施例的优劣。

[0266]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在如上的一个存储介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端设备(可以是手机,计算机,服务器,被控终端,或者网络设备等)执行本技术每个实施例的方法。

[0267]

以上仅为本技术的优选实施例,并非因此限制本技术的专利范围,凡是利用本技术说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本技术的专利保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1