视频监控中的小孩无人陪护的检测方法及设备与流程

1.本技术涉及图像处理领域,更具体地,涉及一种视频监控中的小孩无人陪护的检测方法及设备。

背景技术:

2.儿童走失、儿童被拐等安全事件频发,国家对儿童安全保护高度重视。小孩一人在小区、街道、公园、马路、游乐场等公共场所玩耍而身边无大人照看,往往存在安全隐患。近年来随着监控设施几乎遍布全国所有公共场所的各个角落,以及视频监控技术的日益发展。我们越来越有能力快速侦查出公共场所中无人陪护的儿童,提前预警,防止儿童走失或被拐。

3.现有的小孩无人陪护的检测方法主要包括基于定位装置和人体姿态进行检测的方案。若小孩在屋外为事先佩戴定位装置则无法对小孩的状态进行检测;基于人体姿态的方法是通过小孩的姿态进行风险评分来判断小孩是否有大人陪护,然而有些儿童在公共场所处于无陪护状态时,其姿态与有陪护儿童的姿态差异不大,因而所计算的姿态风险评分也不能有效反应儿童无人陪护的风险。

技术实现要素:

4.针对现有技术,本技术提供一种视频监控中的小孩无人陪护的检测方法及设备,其基于视频的目标检测跟踪以及大人目标和小孩目标之间的陪护关系的判定来对小孩有无陪护检测,基于陪护关系的检测方式更加直接有效且能够更加准确地判断公共场所的小孩处于无人陪护的状态。

5.为解决上述技术问题,本技术提供一种视频监控中的小孩无人陪护的检测方法,其包括:

6.获取指定时间窗口内的视频图像;

7.对视频图像中的每一帧图像进行行人检测,检测出每一帧图像中的大人目标和小孩目标,并对视频图像中的大人和小孩目标进行目标跟踪匹配以对同一目标分配同一id标签;

8.寻找每同一id小孩目标c的所有陪护候选者,组成陪护候选大人目标集ca;以及

9.对每同一id小孩目标c和其对应的陪护候选大人目标集ca中所有的陪护候选目标进行陪护关系判定,对于未有大人目标陪护的小孩进行报警。

10.在一种可能的实现方式中,寻找每同一id小孩目标c的所有陪护候选者,组成陪护候选大人目标集ca的步骤包括:

11.为每一id小孩目标c设计一个密接大人序列:在每一帧图像中寻找与该id小孩目标c的距离排序最小的n个大人目标,并将该n个大人目标列入该id的小孩目标c的密接大人序列中;

12.确定每一id小孩目标的陪护候选者集ca:在该id小孩目标c对应的密接大人序列

中重复出现m次的大人目标为该id小孩目标c的候选者。

13.在一种可能的实现方式中,m值为:时间窗口内的所有图像帧的帧数的70%。

14.在一种可能的实现方式中,若每一id小孩目标c与其对应的陪护候选大人目标集ca中的任一陪护候选大人目标c

ai

存在陪护关系则该id小孩目标c有人陪护,其中,判定每一id小孩目标c与其对应的陪护候选大人目标集ca中的任一陪护候选大人目标c

ai

存在陪护关系的步骤为:

15.在该id小孩目标c与该陪护候选大人目标c

ai

同时出现的所有帧图像中,抽选l张图像;

16.在该l张图像进行截图,截取该id小孩目标c与该陪护候选大人目标c

ai

,获得l张疑似陪护图;

17.判断是否在至少一张疑似陪护图中该id小孩目标c与该陪护候选大人目标c

ai

具有肢体接触的强陪护特征;

18.若是,则判定该id小孩目标c有陪护者;

19.否者,判断是否在至少一张疑似陪护图中该id小孩目标c与该陪护候选大人目标c

ai

具有非肢体接触的间隔距离照看的弱陪护特征;若是,则判断该id小孩目标c有陪护者;否者,则判定该id小孩目标c未有人陪护。

20.在一种可能的实现方式中,判定一张疑似陪护图中该id小孩目标c与陪护候选大人目标c

ai

具有非肢体接触的间隔距离照看的弱陪护特征的步骤包括:

21.基于神经网络模型训练判断人体朝向的身体朝向模型;

22.利用身体朝向模型判断该张疑似陪护图中该陪护候选大人目标c

ai

的身体朝向;

23.根据该陪护候选大人目标c

ai

的身体朝向判断该id小孩目标c是否在该陪护候选大人目标c

ai

的照看视野方向;

24.若是,判断该id小孩目标c是否位于大人目标c

ai

的照看范围内;

25.若是,则判定该id小孩目标c有人陪护;

26.否者,则该判定id小孩目标c无人陪护。

27.在一种可能的实现方式中,该id小孩目标c未在该陪护候选大人目标c

ai

的照看视野方向满足的条件是:在一张疑似陪护图,该id小孩目标c位于该陪护候选大人目标c

ai

的身体朝向的方位上。

28.在一种可能的实现方式中,设定行人检测时获得该陪护候选大人目标c

ai

的检测框的长宽比为b1,设定行人检测时获得该id小孩目标c的检测框的长宽比为b2,其中,该id小孩目标c不位于该陪护候选大人目标c

ai

的照看范围内满足的条件为:

29.b1≤第一设定阈值t1且b1/b2<第二设定阈值t2,或者b1>第一设定阈值t1时且b1/b2<第三设定阈值t3。

30.在一种可能的实现方式中,第一设定阈值t1取值0.4,第二设定阈值t2取值1.1,第三设定阈值t3取值0.7。

31.在一种可能的实现方式中,指定时间窗口的时间为10秒钟,且指定时间窗口内的视频图像中的图像帧数为300帧。

32.本技术还提供一种设备,其包括包括用于存储程序指令的存储器和用于执行所述程序指令的处理器;所述程序指令当被所述处理器执行时实现所述视频监控中的小孩无人

陪护的检测方法的步骤。

33.本技术提供的视频监控中的小孩无人陪护的检测方法及舍恩比的有益效果在于:基于视频图像的目标检测跟踪获取每一帧图像中的大人目标和小孩目标,并在视频图像中寻找每一小孩目标的陪护候选者,在陪护候选者和小孩目标之间判定是否存在陪护关系,进而判断小孩目标是否有无陪护。相对于佩戴设备和基于小孩姿态评分的方式,该方法基于视频的目标检测跟踪以及大人目标和小孩目标之间的陪护关系的判定来对小孩有无陪护,基于陪护关系的检测方式更加直接有效且能够更加准确地判断公共场所的小孩处于无人陪护的状态。

附图说明

34.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

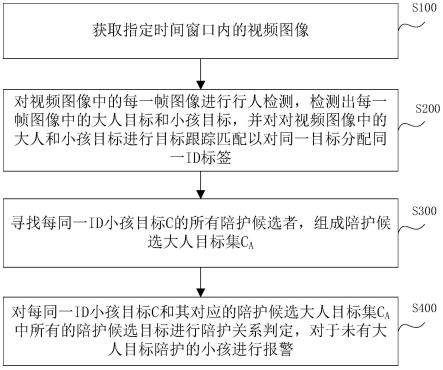

35.图1为本技术实施例的视频监控中的小孩无人陪护的检测方法的流程图;

36.图2为本技术实施例的判定每一id小孩目标c与其对应的陪护候选大人目标集ca中的任一陪护候选大人目标c

ai

存在陪护关系的步骤流程图;

37.图3为本技术实施例的判定一张疑似陪护图中该id小孩目标c与陪护候选大人目标c

ai

具有非肢体接触的间隔距离照看的弱陪护特征的步骤流程图;

38.图4为本技术实施例的大人小孩之间有无强陪护关系的结果示意图;

39.图5为本技术实施例的图4中的无强陪护关系的进行弱陪护关系判定结果示意图。

具体实施方式

40.为了使本技术所要解决的技术问题、技术方案及有益效果更加清楚明白,以下结合附图及实施例,对本技术进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本技术,并不用于限定本技术。

41.需要说明的是,当元件被称为“固定于”或“设置于”另一个元件,它可以直接在另一个元件上或者间接在该另一个元件上。当一个元件被称为是“连接于”另一个元件,它可以是直接连接到另一个元件或间接连接至该另一个元件上。

42.需要理解的是,术语“长度”、“宽度”、“上”、“下”、“前”、“后”、“左”、“右”、“竖直”、“水平”、“顶”、“底”、“内”、“外”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本技术和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本技术的限制。

43.此外,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性或者隐含指明所指示的技术特征的数量。由此,限定有“第一”、“第二”的特征可以明示或者隐含地包括一个或者更多个该特征。在本技术的描述中,“多个”的含义是两个或两个以上,除非另有明确具体的限定。

44.现结合附图对本技术的明视频监控中的小孩无人陪护的检测方法及设备进行具体说。

45.请参照图1,本技术实施例提供的视频监控中的小孩无人陪护的检测方法的步骤包括:

46.步骤s100:获取指定时间窗口内的视频图像;

47.步骤s200:对视频图像中的每一帧图像进行行人检测,检测出每一帧图像中的大人目标和小孩目标,并对视频图像中的大人和小孩目标进行目标跟踪匹配以对同一目标分配同一id标签;

48.步骤s300:寻找每同一id小孩目标c的所有陪护候选者,组成陪护候选大人目标集ca;以及

49.步骤s400:对每同一id小孩目标c和其对应的陪护候选大人目标集ca中所有的陪护候选目标进行陪护关系判定,对于未有大人目标陪护的小孩进行报警。

50.在所述监控视频中儿童无人陪护的检测方法中,基于视频图像的目标检测跟踪获取每一帧图像中的大人目标和小孩目标,并在视频图像中寻找每一小孩目标的陪护候选者,在陪护候选者和小孩目标之间判定是否存在陪护关系,进而判断小孩目标是否有无陪护。相对于佩戴设备和基于小孩姿态评分的方式,该方法基于视频的目标检测跟踪以及大人目标和小孩目标之间的陪护关系的判定来对小孩有无陪护,基于陪护关系的检测方式更加直接有效且能够更加准确地判断公共场所的小孩处于无人陪护的状态。

51.在一实施例中,指定时间窗口的时间为10秒钟,并且指定时间窗口内的视频图像中的图像帧数为300帧;在其他实施例中,指定时间窗口的时间可按照实际需求设定,指定时间窗口内的视频图像中的图像帧数也可按照实际需求设定。

52.值得说明的是,本技术实施例利用yolox检测模型检测每一图像帧中行人目标,且基于bytetrack多目标跟踪方法对视频图像进行目标匹配以对同一目标进行跟踪匹配,由于同一个目标(大人或小孩)会出现在不同帧图像中,步骤s200中的目标跟踪的目的在于:将视频图像中所有帧图像的同一个目标赋予同一id标签值。值得说明的是,小孩目标是指大人照看情况下无法保证安全的人,尤其是指婴儿、幼儿以及3岁以下的儿童。训练数据集可以涵盖公园,超市,商场,广场,马路,街道,车站,社区,博物馆,图书馆等公共场所。数量庞大,场景、人群及人体姿态丰富。模型从海量数据中学习了小孩和大人两类人群在身高,体型,姿态,衣着,行李等方面的差异。虽然我们收集的数据很丰富,但在某些维度数据依然是有偏的。比如只有小孩才坐婴儿车,不够精确模型会偷懒的认为所有坐在推车里的是小孩,而当遇到一个坐轮椅的老人,可能会引发误检。再比如有些很奇特的姿态基本发生小孩中,偶然遇到某个大人也有类似奇特的姿态时也可能引发误检。再比如当一个大人的着装接近小孩群体的,模型也容易将该大人识别成小孩等等。这类误检的特点是,模型能正确的框出目标的位置,但标签预测错了。而出现标签预测错误的原因在于在yolox检测头中,坐标框回归分支和类别预测分支是两个独立的分支。yolox依据类别预测分支计算所得的最高的置性度给目标分配标签。对于这类由于数据有偏带来的标签翻转问题,应用一种依据先验坐标信息来修正标签的方法,该方法基于一个先验知识:成人和小孩的坐标框是有差距的,成人更高更壮,小孩矮瘦,因此可以推想大人和小孩两个群体的坐标隐向量在某个空间是有区别的。为了找到两个群体的坐标差异引入亥姆霍兹自由能量函数。该函数可以将深度网络的隐层的高维特征向量映射成一维的值,该值又叫该实例的坐标能量值。由于同类中的坐标信息会服从一个分布,当把训练集中所有属于同一个类别的实例的坐标框回归

分支的隐向量映射成能量值后,这些能量值会服从一个韦伯分布。于是本文依据先验坐标信息来修正标签的方法具体实现如下:

53.(1)在训练的第一个epoch中,每次前向运算时,都将坐标框回归分支的隐向量带入亥姆霍兹自由能量函数,记录该实例所得的能量值以及该实例对应的标签(成人,儿童),以及距离记录(e(f),label),其中e(f)为亥姆霍兹自由能量函数,label为标签。

54.(2)第一个epoch结束时,将第一步记录下来的能量值和标签对,依据标签分为两个类别。将每个类别的能量值分别拟合出一条韦伯分布,记录下每个类别对应韦伯分布的参数。步骤(1)和步骤(2)只在第一个epoch进行,后面则不需要。

55.(3)当模型推理时,将坐标框回归分支的隐向量带入亥姆霍兹自由能量函数得到该实例的能量值,然后将该能量值分别带入两个类别的韦伯分布,得到该实例的坐标属于每个类别的概率。记为该实例的坐标先验概率。该坐标先验概率可以表明从坐标信息的维度,该实例属于各个类别的概率。

56.(4)对该实例分配最终的标签时,不单单依据类别预测分支所得的置性度大小做判定。要用类别预测分支的置性度大小乘上对应类别的坐标先验概率。得到修正的类别概率。比较修正的类别概率大小,得出最终的标签。这样由于数据有偏造成的坐标检测准确,但是类别预测错误的情况。会因为乘上了属于真实类别更大的先验概率,而以更大概率判定为真实类别,起到了扭转标签翻转的问题的作用,从而带来模型精度的提升。

57.在一实施例中,在步骤s300中,寻找每同一id小孩目标c的所有陪护候选者,组成陪护候选大人目标集ca的步骤包括:

58.步骤s310:为每一id小孩目标c设计一个密接大人序列:在每一帧图像中寻找与该id小孩目标c的距离排序最小的n个大人目标,并将该n个大人目标列入该id的小孩目标c的密接大人序列中;

59.步骤s320:确定每一id小孩目标的陪护候选者集ca:在该id小孩目标c对应的密接大人序列中重复出现m次的大人目标为该id小孩目标c的候选者。

60.在一实施例中,在同一帧图像中,每一大人目标与某一id小孩目标c的距离为:利用步骤s200中的行人目标检测获得的大人目标的检测框的中心位置和利用步骤s200中的行人目标检测获得的该id小孩目标c的检测框的中心位置之间的距离。

61.值得说明的是,在所述步骤s310中,依照视频图像的图像帧的顺序,对每一帧图像进行如下处理:将小孩目标c的检测框的中心位置和所有的大人目标的检测框的中心位置的之间的距离进行排序,选取距离值最小的n大人目标列入密接大人序列中。由于视频帧图像是连续采集的,故而同一小孩目标和同一大人目标会重复出现在不同帧图像中,由于在步骤s300中,是在每一帧图像中执行:找与该id小孩目标c的距离排序最小的n个大人目标,并将该n个大人目标列入该id的小孩目标c的密接大人序列中。故而列入密接大人序列中同一个大人目标会重复出现,进而,为了保证候选者目标的精确性和稳定性,设定重复出现m次的大人目标为该id小孩目标c的候选者。

62.在一实施例中,n取值为3。并且,m值为:时间窗口内的所有图像帧的帧数的70%;可以理解地,若10秒时间窗口内的图像帧的帧数为300,则m取值210。

63.在一实施例中,在步骤s400中,对每同一id小孩目标c和其对应的陪护候选大人目标集ca中所有的陪护候选目标进行陪护关系判定,若每一id小孩目标c与其对应的陪护候

选大人目标集ca中的任一陪护候选大人目标c

ai

存在陪护关系,则判定该id小孩目标c有人陪护。其中,参照图2,判定每一id小孩目标c与其对应的陪护候选大人目标集ca中的任一陪护候选大人目标c

ai

存在陪护关系的步骤包括:

64.步骤s410:在该id小孩目标c与该陪护候选大人目标c

ai

同时出现的所有帧图像中,抽选l张图像;

65.步骤s420:在该l张图像进行截图,截取该id小孩目标c与该陪护候选大人目标c

ai

,获得l张疑似陪护图;

66.步骤s430:判断是否在至少一张疑似陪护图中该id小孩目标c与该陪护候选大人目标c

ai

具有肢体接触的强陪护特征;若是,执行步骤s440:若否,执行步骤s450。

67.步骤s440:则判定该id小孩目标c有陪护者;

68.步骤s450:判断是否在至少一张疑似陪护图中该id小孩目标c与该陪护候选大人目标c

ai

具有非肢体接触的间隔距离照看的弱陪护特征;若是,执行步骤s440;否者,执行步骤s460。

69.步骤s460:判定该id小孩目标c未有人陪护。

70.在一实施例中,在所述步骤s430中,基于efficientnet网络训练强陪护检测模型,具有肢体接触的强陪护特征是指牵着、抱着、靠着、背着以及用婴儿车推着等具有肢体接触行为。在进行强陪护检测模型的训练集包括前述具有肢体接触行为的图像样本。将一疑似陪护图输入至强陪护检测模型中,以判断该疑似陪护图中的该id小孩目标与该陪护候选大人目标c

ai

之间是否具有肢体接触的强陪护特征。

71.在一实施例中,参照图3,在所述步骤s450中,判定一张疑似陪护图中该id小孩目标c与陪护候选大人目标c

ai

具有非肢体接触的间隔距离照看的弱陪护特征的步骤包括:

72.步骤s451:基于神经网络模型训练判断人体朝向的身体朝向模型;

73.步骤s452:利用身体朝向模型判断该张疑似陪护图中该陪护候选大人目标c

ai

的身体朝向;

74.步骤s453:根据该陪护候选大人目标c

ai

的身体朝向判断该id小孩目标c是否在该陪护候选大人目标c

ai

的照看视野方向;若是,则执行步骤s454;若否则执行步骤s455;

75.步骤s454:判断该id小孩目标c是否位于大人目标c

ai

的照看范围内;若是则执行步骤s456,若否则执行步骤s454;

76.步骤s455:则判定该id小孩目标c无人陪护。

77.步骤s456:则判定该id小孩目标c有人陪护。

78.在一实施例中,在步骤s451中:身体朝向模型基于mobilenet神经网络模型进行训练获得,以图像坐标系的x轴和y轴来定义人体朝向方位,x轴正向方向为左,x轴负方向为右,y轴正方向为前方,y轴负方向为后方。在身体朝向模型训练过程中,就是在将图片输入网络之前对图像上下或者左右填充灰色边框确保图片为正方形,然后再将图像的尺寸转变成到256*256,如此这样就不会改变里面人物的长宽比。由于我们的训练数据是人物的截图大部分都是长方形的,而且是不同远近,不同背景的,不同姿态的。直接将图像的尺寸转变成到256*256,会改变人物的长宽比,从而影响模型的识别准确性。

79.在一实施例中,在所述步骤s453中,该id小孩目标c在该陪护候选大人目标c

ai

的照看视野方向满足的条件是:在一张疑似陪护图,该id小孩目标c位于该陪护候选大人目标c

ai

的身体朝向的方位上;对于该id小孩目标c是否位于该陪护候选大人目标c

ai

的身体朝向的方位上可以依据小孩目标c的检测框的中心位置的坐标和该陪护候选大人目标c

ai

的检测框的中心位置坐标关系进行判定。

80.例如,在一张疑似陪护图中,当身体朝向模型检测出该陪护候选大人目标c

ai

的人体朝右且该id小孩目标c位于该陪护候选大人目标c

ai

的人体朝右的方位上时,意味着:该陪护候选大人目标c

ai

的人体朝右时该id小孩目标c位于陪护候选大人目标c

ai

的人眼朝右视野范围内,即意味着:该陪护候选大人目标c

ai

的人体朝右,且该id小孩目标c的检测框的中心位置的x轴的坐标大于该陪护候选大人目标c

ai

的检测框的中心位置的x轴的坐标值。

81.又如,在一张疑似陪护图中,当身体朝向模型检测出该陪护候选大人目标c

ai

的人体朝左且该id小孩目标c位于该陪护候选大人目标c

ai

的人体朝左的方位上时,意味着:该陪护候选大人目标c

ai

的人体朝右时该id小孩目标c位于陪护候选大人目标c

ai

的人眼朝左视野范围内,即意味着:该陪护候选大人目标c

ai

的人体朝左,且该id小孩目标c的检测框的中心位置的x轴的坐标小于该陪护候选大人目标c

ai

的检测框的中心位置的x轴的坐标值。对于该陪护候选大人目标c

ai

其他朝向时,该id小孩目标c的方位不再一一例举,只要保证该id小孩目标c能落入该陪护候选大人目标c

ai

视线范围内即可保证:该id小孩目标c位于该陪护候选大人目标c

ai

的照看视野方向。

82.其中,图4示意了步骤s430的判定结果示意图,即小孩目标和大人目标具有肢体接触的强陪护特征(强陪护关系)的示意图,其中打钩的意味着具有强陪护关系,打叉意味着不具有强陪护关系。将图4中不具有强陪护关系的结果挑选出来,对挑选出来的图片进行非肢体接触的间隔距离照看的弱陪护特征(弱陪护关系)判定,判定结果如图5所示,在图5中打钩的意味着具有弱陪护关系,打叉意味着不具有弱陪护关系。

83.在一实施例中,在所述步骤s453中,设定行人检测时获得该陪护候选大人目标c

ai

的检测框的长宽比为b1,设定行人检测时获得该id小孩目标c的检测框的长宽比为b2。其中,该id小孩目标c不位于该陪护候选大人目标c

ai

的照看范围内需满足下述条件(1)或者满足下述条件(2):(1)b1≤第一设定阈值t1且b1/b2<第二设定阈值t2;(2)b1>第一设定阈值t1时且b1/b2<第三设定阈值t3。在一具体实施例中,第一设定阈值t1取值0.4,第二设定阈值t2取值1.1,第三设定阈值t3取值0.7。

84.值得说明的是,本技术实施例的检测框的长度为图像坐标系的y轴方向的长度,检测框的宽度为图像坐标系的x轴方向的宽度。由于采集的图像帧的是符合人眼习惯的,通常情况下当目标时站立的,检测框的长度会大于宽度。

85.在上述步骤s400中,由于在公共场所中,大人不一定一直与其陪护外出的小孩直接肢体接触,弱陪护关系判定和强陪护关系判定相辅相成且弱陪护对于强陪护是必要且有效的补充,故而,进行肢体接触的强陪护和间隔照看的弱陪护结合判定更加能够提高准确性。并且本技术实施例提供的检测方法中,结合神经网络模型从大量样本中学习目标特征,结合图像中小孩目标和大人目标直接的肢体接触特征、两者之间的相对位置、大人的身体朝向以综合小孩和大人之间的强弱陪护关系,即直接从大人和小孩之间的陪护关系出发进行有无陪护的检测,更加直接有效且能适应公共场所的小孩监护检测。

86.本技术实施例还提供一种设备,其包括用于存储程序指令的存储器和用于执行所述程序指令的处理器;所述程序指令当被所述处理器执行时实现所述视频监控中的小孩无

人陪护的检测方法的步骤。

87.以上所述仅为本技术的较佳实施例而已,并不用以限制本技术,凡在本技术的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本技术的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1