一种结合知识蒸馏与对比学习的情感增强继续训练方法

本发明属于计算机视觉领域,具体涉及深度学习,情感分析等技术。

背景技术:

1、随着互联网发展,社交途径增多,人们越来越倾向于在朋友圈,微博,推特,脸书社交平台上发布文本图像等多种模态信息来分享自己的经历,表达自己的感受。通过这些蕴含着情感信息的数据,人们可以表达自己的快乐或宣泄自己的不满。从海量图片中提取情感趋向可以帮助了解人们的个人喜好、情感状态,对于现实生活中的许多应用场景,比如社会舆情监测,个性化推荐或者潜在心理疾病预防,都起着重要的作用。

2、情感表达的媒介以文本,图像,视频为主。随着生活节奏加快,社交平台变得旷阔,为了快速且大范围的分享自己的情感,人们更重视图片可以高效传递情感这一特点。如今,人们倾向于通过发布一张照片或者多张照片再配上一句简单的话,或者只发布图片的方式来表达自己的情感。所以对图像情感的研究是至关重要的。如何快速,准确自动化的对蕴含情感信息的图像进行识别和分析自然而然的成为研究的热点。

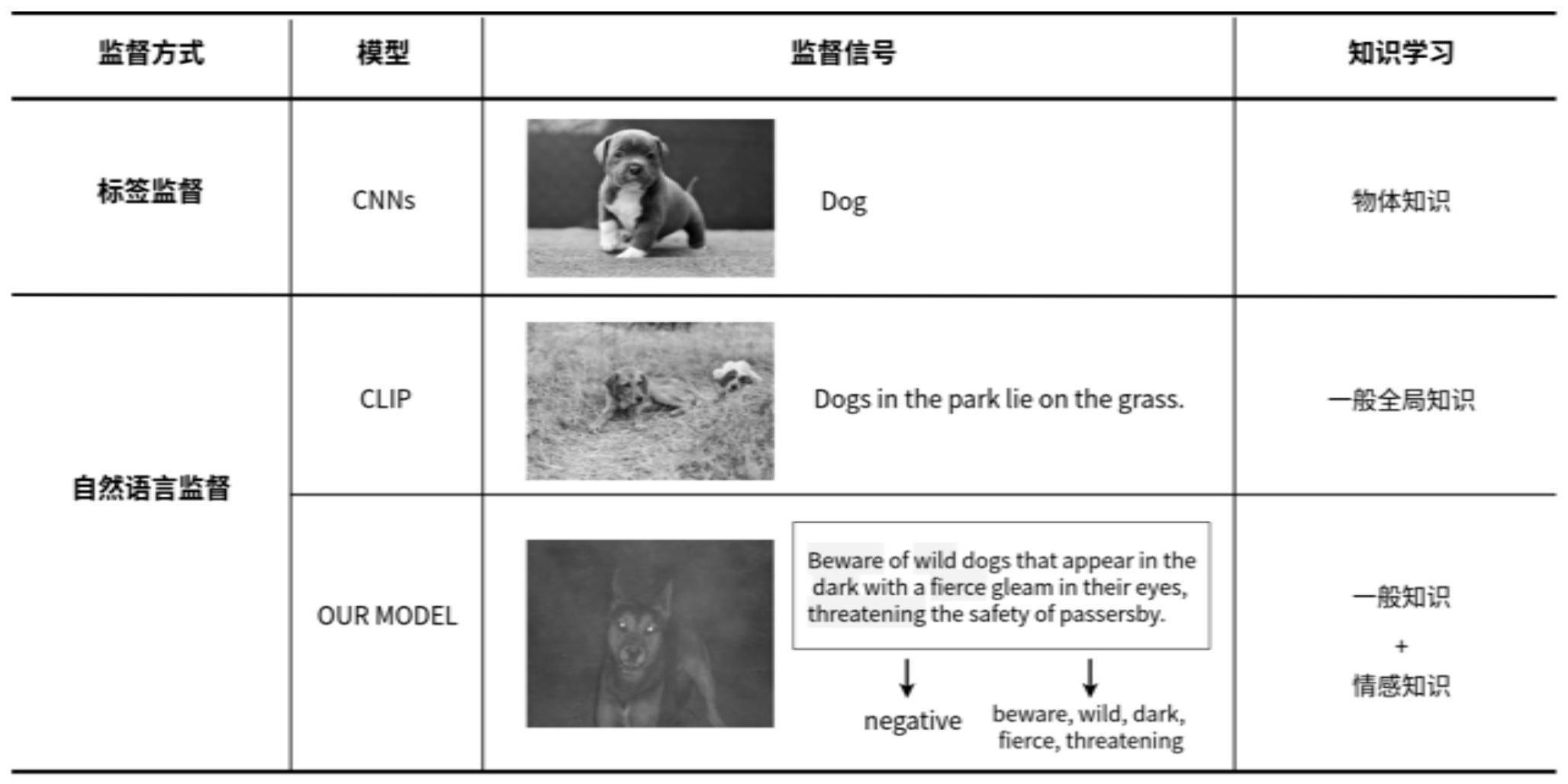

3、目前所有图像情感分析方法都最初选定的已有主干网络,然后注重设计微调网络训练得到具有情感分析能力的模型,方法可以总结为主干网络加微调网络的训练范式。其中主干网络在模型结构中有举足轻重的地位,传统方法使用的主干网络是通过物体识别任务训练得到,以图片中物体的标签作为监督信号,通过物体识别任务进行训练,然而这种方法只可以学习到有限的图片浅层语义,这一类知识有限的主干网络只具备处理目标识别类任务,降低了模型的泛化性,对于图像情感分析这类深层语义理解任务标签监督的预训练模型难以完成,同时这一类预训练模型需要昂贵的训练成本大部分训练数据都是通过人工标注。

4、最近,大规模语言预训练模型(lpm)被提出来从文本中挖掘知识,并取得了令人难以置信的结果。一些工作表明,这些模型可以作为处理下游任务的起点,最后的实验结果大大提高。在这些模型中,clip模型在视觉和语言领域取得了巨大的成功。clip将来自文本的信息作为视觉的监督信号,实现了文本信息与图片信息的融合,同时具有强大的泛化能力。但是我们发现应用这类自然语言监督的预训练模型直接解决情感分析任务由于域偏移的问题导致效果并不理想,分析认为是由于在训练过程中忽略针对任务的特殊知识,比如情感知识。主干网络对比如图1所示。

5、为了解决上述问题,本发明提出一种结合知识蒸馏与对比学习的情感增强继续训练方法。筛选收集大量具有明显情感极性的图文对,并基于知识蒸馏方法通过大量数据训练降低域之间的gap。具体模型训练在对比学习的基础上,于图文空间内通过挖掘视觉模态以及文本模态中的多粒度情感知识,深入理解图片中情感语义信息,帮助预训练模型输出准确的情感表征,实现下游任务中图像情感准确识别。

技术实现思路

1、本发明要解决的技术问题是克服现有技术的缺陷,提供一种结合知识蒸馏与对比学习的情感增强继续训练方法,充分利用领域内多模态情感知识。其主要目的在于解决进行情感分析模型预测精确度较低以及适用性差的问题。

2、本发明设计了一种结合知识蒸馏与对比学习的情感增强继续训练方法。方法分为4个阶段,教师训练数据获取,教师网络训练,学生训练数据获取,学生网络训练,下游任务测试。

3、本发明包括以下步骤:

4、s1、获取教师网络训练数据;通过已有文本情感分类模型筛选得到cc12m数据集中具有情感极性的图文对,将文本情感作为图片伪标签,并使用情感词典对文本中情感单词进行标记。最终数据集命名为sr-cc12m(sentiment rich-cc12m),如图2所示。其中第一行为图片,第二行为对应的文本,第三行为图文对情感标签,第四行为文本中的标记单词具有明显情感极性。

5、s2、教师网络训练数据预处理;对训练数据中图片以及文本进行格式统一化处理,并针对文本进行情感掩膜,得到文本原样本、文本掩膜样本以及图片样本。

6、s3、构建教师模型;基于输入数据,对教师模型进行对比学习以及情感知识学习。教师模型整体结构如图3所示。学生模型由教师模型视觉编码器初始化。

7、s4、获取学生网络训练数据;将教师网络作为图片情感分类工具,分析图片中每一小块的情感极性,记录具有明显情感极性的图片块位置以及情感类别,得到图片块原样本,并对图片块进行情感掩膜,得到图片块掩膜样本。

8、s5、构建学生模型;基于图片块样本,对学生模型进行图片情感知识学习。学生模型整体结构如图4所示。将学生模型作为图像情感分析预训练模型。

9、s6、下游任务测试:将待测数据集中的图像经过同s2一样的预处理步骤后。学生网络训练得到的图像编码器应用至下游3个常用图像情感分析数据集fi,twitter,emotionroi中进行情感二分类以及多分类的实验。在零样本,线性探针和有监督设置下得到对应实验结果。

10、可选地,s2中对教师网络训练数据处理的过程为:

11、步骤1:对输入图片进行缩放,剪裁操作得到三通道大小为224x224的像素值矩阵。将图片像素值等分为小矩阵后传入视觉embedding层得到对应图片块编码,作为图片样本。

12、步骤2:通过文本embedding层将输入文本编码为令牌,并设置掩膜概率,基于掩膜概率以及文本令牌得到掩膜数量,根据掩膜数量在输入文本令牌中进行随机采样,得到掩膜位置。对掩膜位置对应的令牌进行掩膜;输入文本令牌为文本原样本,掩膜后的文本即为掩膜样本。

13、可选地,对掩膜位置对应的令牌进行掩膜的过程为:

14、步骤1:根据掩膜位置确定输入文本令牌中需要掩膜的令牌;

15、步骤2:根据需要掩膜的令牌以及掩膜策略,将输入文本令牌中需要掩膜的令牌替换为对应的掩膜令牌。

16、可选地,步骤2的掩膜策略包括:

17、(1)有80%的概率将输入文本令牌中需要掩膜的令牌替换为[mask]令牌。

18、(2)有10%的概率将输入文本令牌中需要掩膜的令牌替换为clip预训练模型词表中随机的令牌。

19、(3)有10%的概率将输入文本令牌中需要掩膜的令牌保持原样不动。

20、可选地,教师模型视觉编码器以及文本编码器均由12层的transformer模型组成。

21、可选地,s3中基于输入数据,对教师模型进行对比学习以及情感知识学习的过程为:

22、步骤1:对比学习;将图样本对应的文本原样本作为训练正例,同一个batch中的其余文本作为负样本;通过transformer网络得到图片以及文本样本特征,计算同一训练batch中图片样本分别与正例、负例之间的相似度,计算公式为:

23、sim(fi,ft)=cos(fi,ft)

24、其中,sim表示相似度函数;表示图片样本特征;表示文本样本特征;cos表示余弦相似度函数。

25、步骤2:根据原样本分别与正例、负例之间的相似度,计算对比损失;计算公式为:

26、

27、其中lcl表示对比学习损失,n为一个batch中的训练样本图文数量,sim表示相似度函数。

28、步骤3:文本情感知识学习;将文本掩膜样本作为训练用例,通过transformer网络得到掩膜令牌特征;将transformer最后一层特征向量进行全连接,映射至clip字典空间,得到掩膜位置的预测令牌标签,计算预测令牌标签与真实令牌标签交叉熵损失;

29、步骤4:将transformer最后一层输出的令牌特征(除了第一维类别特征向量)进行全连接,映射至情感空间,得到掩膜位置的预测情感标签,计算预测情感标签与真实情感标签交叉熵损失;

30、可选地,s4中对学生网络训练数据处理的过程为:

31、步骤1:与s2步骤一操作一致,处理图片得到图片样本。

32、步骤2:掩膜图片生成。将图片样本输入至教师网络视觉编码器中,得到每个图片块的情感倾向得分,设定阈值为0.8,大于0.8为情感极性明显的图片块,,记录位置,并设置随机掩膜概率,得到掩膜位置。对掩膜位置对应的图片块进行掩膜;输入图片为图像原样本,掩膜后的图片即为图像掩膜样本;

33、可选地,对掩膜位置对应的令牌进行掩膜的过程为:

34、步骤1:根据掩膜位置确定输入图片块编码中需要被掩膜的图片块;

35、步骤2:根据需要掩膜的图片块以及掩膜策略(掩盖75%的情感图片块),将输入图片块编码中需要掩膜的编码位置替换为对应的掩膜编码。

36、可选地,学生模型包括视觉编码器以及解码器,其中视觉编码器由教师模型视觉编码器初始化,解码器为一个简单的卷积层。

37、可选地,s5中基于输入数据,对学生模型进行情感知识学习的过程为:

38、步骤1:图像情感知识学习;将图像掩膜样本作为训练用例,通过transformer网络得到掩膜预测特征;将transformer最后一层掩膜预测特征向量传入解码器得到预测像素,计算预测像素与真实像素的l1损失;

39、

40、其中lmin表示图像掩膜重构损失,ym表示预测像素,xm表示真实像素,||·||表示特征间距离,ω(xm)表示元素个数。

41、步骤2:将transformer最后一层图片块特征向量(除了第一维类别特征向量)进行全连接,映射至情感空间,得到掩膜位置的预测情感标签,计算预测情感标签与真实情感标签交叉熵损失。

- 还没有人留言评论。精彩留言会获得点赞!