一种用于文字修复的分支卷积通道注意力模块

本发明涉及一种用于文字修复的分支卷积通道注意力模块,是利用神经网络模型来修复笔画缺失或涂抹不清楚的文字,目的是数字化保护文化遗产和提高手写汉字识别的准确率,是一种端到端的修复网络,涉及到的技术包括u-net、扩张卷积(dilatedconvolution)、repvgg和高效通道注意力机制(efficient channel attention for deepconvolutional neural networks,eca-net)等,属于文字修复。

背景技术:

1、目前,研究文字修复的学者不多,提出的文字修复方法更是寥寥无几。文字修复是图像修复的一个具体应用,属于图像修复的一个分支,是一个小众研究。

2、图像修复的概念很早就被提出,在发展过程中也设计了很多优秀的算法。根据修复方法的不同,可以分为传统纯算法修复和神经网络修复。传统的图像修复主要有偏微分方程和补丁匹配这两类。

3、偏微分方程只能修复小的划痕,利用偏微分方程将周围的像素扩散到缺失区域。补丁匹配可以修复稍大一点的区域,但也只是从原图或其他图像中匹配最相似的像素块填充到缺失区域,无法生成出新的区域。

4、手写汉字变化多样,有复杂的结构信息,其次每个人都有自己的写字风格,不能用像素扩散和像素块填充的方法来修复。因此,传统的纯算法修复方法是很难完成文字修复任务的。

5、神经网络的图像修复模型分为生成对抗网络(generate adversarial networks,gans)、变分自编码器(auto-encoding variational bayes,vae)、双重编码器、并行编码器和vision transformer(vit)五大类。其中,目前的文字修复模型主要借鉴前两类图像修复网络。

6、生成对抗网络直接用随机生成的100维噪声生成文字,然后对100维噪声进行优化或筛选,使生成器能根据筛选出的100维噪声生成出和待修复文字相似的文字,以达到文字修复的目的。变分自编码器由编码器和解码器组成,编码器利用卷积神经网络学习文字的结构特征,解码器根据编码器学习到的文字特征解码重建文字。

7、双重编码器相当于两个变分自编码器,分为粗修和精修或者先修轮廓再修颜色两个阶段,模型复杂,参数量大。并行编码器是双重自编码器的改进版本,对双重编码器进行了优化,仅使用一个编码器提取图像特征,两个解码解码器进行图像重建。vit是借鉴自然语言处理(natural language processing,nlp)领域的transformer,为了输入和文本同规模大小的图像,mae只把图像中未被遮挡的像素块输入到transformer中。

8、陈善雄老师的团队设计出了一种双判别器gans的古彝文字符修复方法,该模型在深度生成网络(deep convolutional generative adversarial networks,dcgan)的基础添加一个字符筛选器,筛选出能生成出和待修复字符相似的随机噪声,生成器再利用这些筛选出的噪声生成字符。这类模型有一个很大的缺陷,就是没有学习待修复字符的结构信息,而是直接利用随机100维噪声进行文字生成,这可能会导致生成的字符和待修复的字符有差别。但也有一个很大的优势,那就是可以获得很多不同的修复结果,这是其他类模型做不到的,能提供人们更多的选择。

9、18年lv等人改进u-net,使用u-net作为模型的生成器对文字进行修复。u-net是vae的改进,u-net在vae的基础上添加了跳跃连接操作,编码器向解码器传递学习到的局部特征。song等人将vae和自注意力机制结合起来了,编码器学习文字特征,自注意力机制处理学习到的特征,解码器根据处理完的特征解码重建文字。基于vae和u-net的生成器先学习文字的特征,然后再根据文字的特征重建文字。这类模型有学习文字的特征,但文字比图像的结构更复杂,并且模型的输入一般是遮挡文字,普通下采样模块在文字特征提取上存在缺陷。

技术实现思路

1、为了解决现有技术的不足,本发明提供一种用于文字修复的分支卷积通道注意力模块。

2、编码器提取遮挡文字的特征是文字修复中关键步骤之一。编码器和解码器合作完成文字修复任务,编码器负责学习文字的结构特征,解码器负责根据学习到的特征解码重构文字。如果编码器不能给解码器提供完整准确的文字特征,解码器就不能根据文字特征解码重建出语义细节更合理的文字。也可以说解码器完全依赖编码器提供的文字特征。

3、文字相比普通的图像有更复杂的结构信息,因此,普通卷积在提取文字的结构特征时能力有限,这是文字重建任务的一个阻碍。其次,在修复文字时,模型的输入一般遮挡住要修复的区域。模型在学习文字特征时,遮挡区域和未遮挡区域有同样的权重,这样提取出的特征是不够准确的,提取出地遮挡区域的特征对文字的重建任务是没有任何价值的。

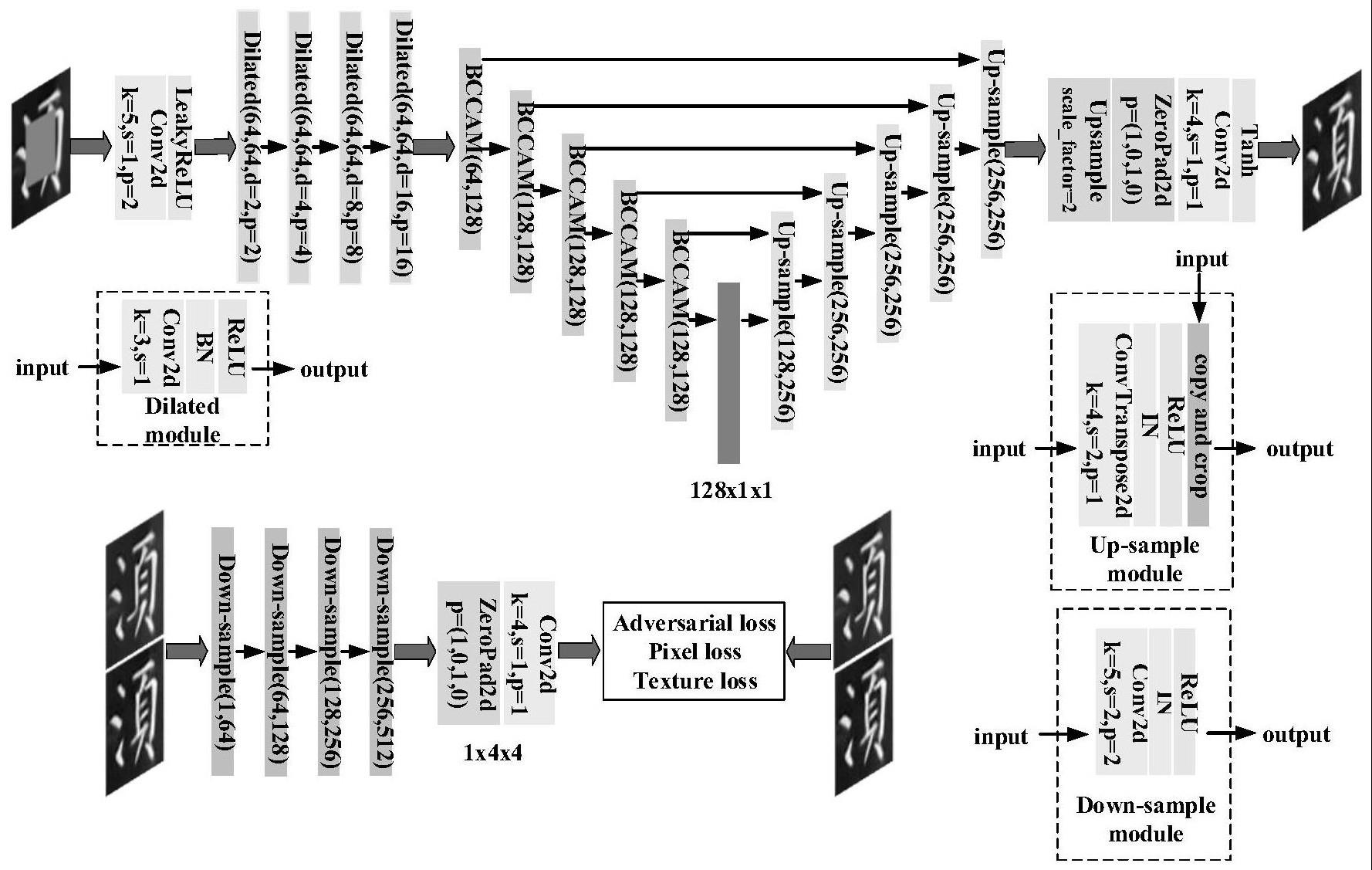

4、本发明把repvgg和eca-net结合起来组成一个新的模块,分支卷积通道注意力模块(branching convolutional channel attention module,bccam),下采样模块和bccam如图1所示;

5、本发明采用以下技术方案:

6、一种用于文字修复的分支卷积通道注意力模块,包括字符自编码器(characterauto-encoder,cae),字符自编码器cae的结构图如图2所示:

7、cae整体上是一个基于u-net的生成器和一个判别器,生成器负责文字修复任务,判别器负责监督生成器完成文字修复任务;cae的生成器由编码器和解码器组成;

8、编码器是一个下采样层,该层通过不断减小空间分辨率实现将图像信息压缩到低维表示,cae使用bccam替换下采样层,对文字特征进行逐层下采样,将文字特征学习到一个长度为128的向量。

9、cae的前面还设置有4层扩张卷积,4层扩张卷积是辅助编码学习遮挡文字的整体特征,扩张卷积有更大的感受野,非常适合学习遮挡图像的语义特征。

10、解码器是上采样层,该阶段层级结构与前面的下采样阶段完全相同,但它通过不断增加特征映射大小重新增加分辨率,则可以精确地重建原始图像;

11、判别器类似于编码器,也是由下采样模块组成,不过是使用的普通下采样模块。判别器将输入的文字学习到4x4的特征矩阵进行判别。

12、优选的,训练cae时用到了三个损失函数,分别是最小二乘对抗损失(leastsquares adversarial loss)、像素重建损失和纹理损失,损失函数是引导优化器对生成器进行优化的目标,是模型训练中关键的部分。

13、最小二乘对抗损失的作用是辅助并监督生成器生成出更像训练集的文字,即使生成器生成出地文字更加真实,更符合人类的视觉。当然该损失函数还有一个更重要的作用就是防止生成器生成出不存在的文字,这样是没有意义的。

14、最小二乘损失函数如下所示:

15、

16、

17、其中,d(·)和g(·)分别表示模型的判别器和生成器,x和z是训练集数据和随机噪声,m(·)是遮挡函数,该函数完成训练集文字的随机遮挡任务。

18、最小化像素重建损失可以使生成器学习到数据表示的正态分布或者均匀分布的同时,保留足够的图像信息,完成图像重构任务。像素重建损失可以表示为:

19、lpixel(x)=||x-g(m(x))||2

20、使用纹理损失可以让生成器生成具有与输入纹理相似的文字,使其在视觉上与原始纹理看起来非常相似。纹理损失函数如下所示:

21、ltexture=||xi,j-g(m(x))i,j||2

22、其中,xi,j是原文字的gram matrix,表示通道i和通道j之间的相关性大小,同理g(m(x))i,j是生成文字的gram matrix。

23、最后对三个损失进行加权训练cae,总的损失函数可以表示为:

24、

25、其中,λ1、λ2andλ3分别表示三个损失在生成损失中的权重,模型训练时,设置λ1=1,λ2=100和λ3=100。

26、本发明未详尽之处,均可参见现有技术。

27、本发明的有益效果为:

28、本发明的分支卷积通道注意力模块(bccam)的分支结构比普通卷积有更强的特征提取能力,可以弥补普通卷积的特征提取能力有限的问题。bccam使用了可微分的结构来代替传统卷积层中的非线性运算,从而使得整个网络结构变得更加规则并具有更好的可解释性。bccam的通道注意力可以处理文字特征的遮挡区域和未遮挡区域的权重问题。通道注意力可以对单通道特征进行全局加权平均来学习通道之间的相关性,并通过尺寸为1的逐点卷积来增强特征表达。

29、文字修复不管是在古籍修复方面还是在手写汉字修复方面都有非常重要的意义。本发明提出的bccam可以替换编码器的下采样模块应用到大部分文字修复网络中。除此之外,bccam也可以用于大部分图像修复模型,它是一个通用的模块,和下采样模块一样通用。

30、另外,本发明还使用bccam设计了cae,cae使用基于u-net的生成器,u-net本身的跳跃连接,把编码器学习到的局部特征跳跃连接到解码器的对应层,解码器结合解码的整体特征和跳跃连接的局部特征进行文字重建。cae兼顾了文字修复的特征提取和文字重建两个过程。

31、在训练生成器时,本发明使用了最小二乘对抗损失,最小二乘对抗损失比最大最小对抗损失对生成器生成的文字和原文字的区分度更高,能监督生成器生成出更真实的文字。相比最大最小对抗损失,最小二乘对抗损失的核心思想是在拟合的意义上从判断两个分布是否“靠近”,变为判断两个分布是否“相似”。

32、本发明还加入了拉格拉姆矩阵计算生成文字和原文字的纹理损失,加入纹理损失可以使生成的文字和原手写汉字在风格上更相似。

- 还没有人留言评论。精彩留言会获得点赞!