一种基于Transformer的高效去雾语义分割方法及其应用

本发明涉及图像分割,特别涉及一种基于transformer的高效去雾语义分割方法及其应用,基于计算机视觉、transformer模型开发,应用于自动驾驶中出现在恶劣天气视觉分割效果不当的场景。特别针对于在浓雾、大雨等恶劣天气中分割的效果,以及现有的检测恶劣环境模型结构复杂检测结果不佳等问题,最终将算法在jestonxavier中运行。

背景技术:

1、无人驾驶是指车辆可以像驾驶员一样理解“道路场景”,并根据该理解对外界环境作出应对,从而可以实现车辆的自动导航,路灯、行人的避障,将乘坐者安全送达目的地。场景理解的关键是语义分割技术,它将图像中每个像素分配到语义类别中,从而提供更准确、更精细的环境感知。这可以使自动驾驶系统更好地理解道路、交通标志、行人等环境要素,从而更安全、更高效地行驶。

2、然而,适应恶劣天气条件场景仍然是一个悬而未决的问题。由于浓雾,大雨等天气条件降低了能见度,不仅破坏了图像捕获的信息,并且使得场景能见度的巨大变化加剧了域与域之间的偏移,因此如何确保在去除雾间隙的同时减少域差距是需要解决的。

3、早期,基于卷积神经网络的解决方案被广泛使用于去雾,去雨滴,但它存在很大的局限性,包括低性能,实时性,不具有远距离特征捕获的能力。近年来,基于transformer的方法去探索去雾消除任务,它取得了比cnn更好的性能。

技术实现思路

1、发明目的:为了解决背景技术中指出的问题,本发明提供了一种基于transformer的高效去雾语义分割方法及其应用,在正常天气且具有像素级别标注的数据集的基础上,首先搭建一个transformer网络的分割网络,将雾天场景的图片进行去雾处理,然后,在源域和目标域之间加入中间域,缩小域间差距,并将网络进行端对端的训练,得到一个训练权重。最后将模型嵌入到嵌入式终端设备中,并在ros里面部署语义分割模型,使得很好的适应自动驾驶的应用。

2、技术方案:本发明公开了一种基于transformer的高效去雾语义分割方法,包括如下的步骤:

3、步骤1:获取雾天天气下城市道路场景图像数据,根据场景中不同建筑的类别进行人工标注,构建训练用的数据集;

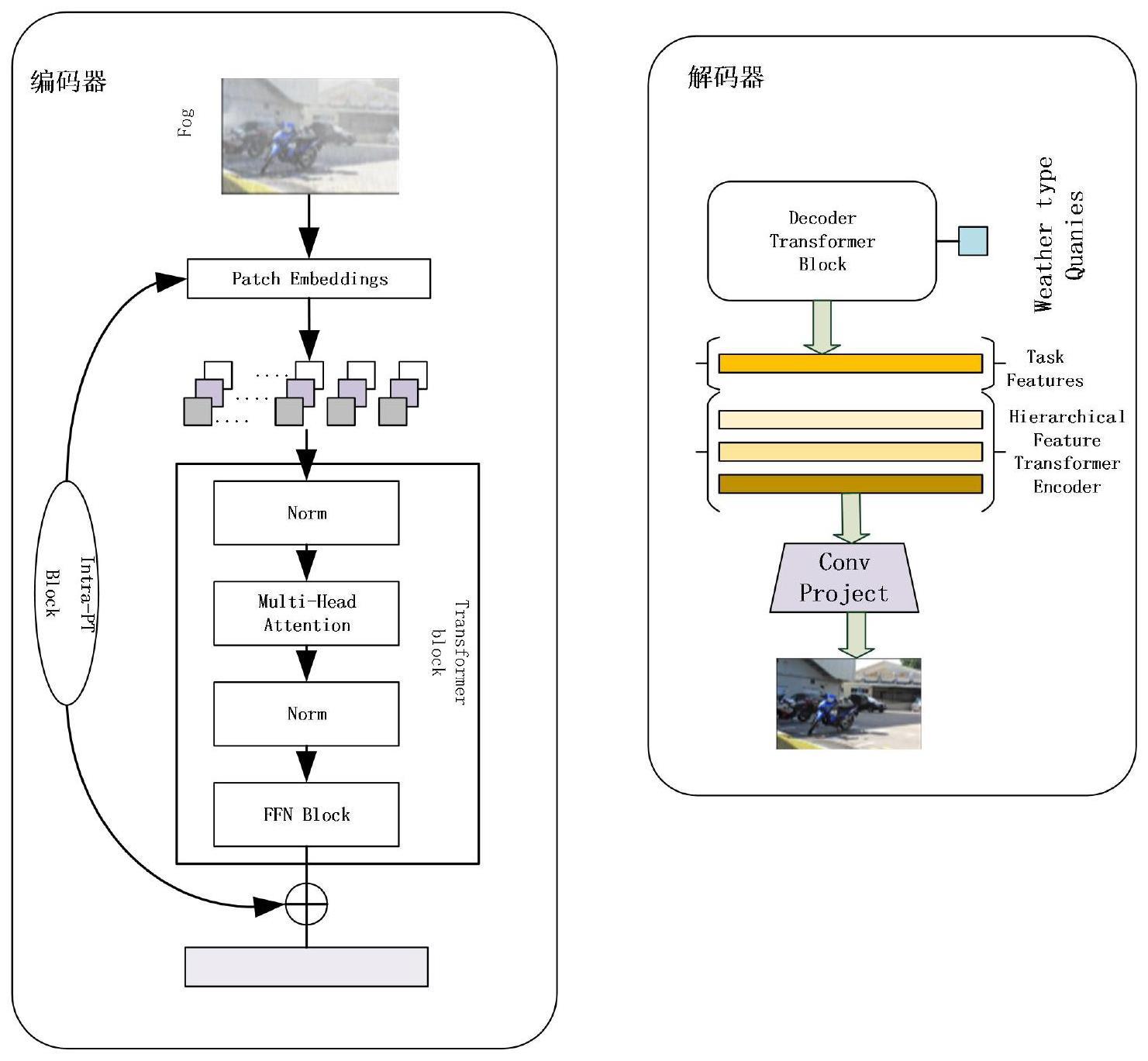

4、步骤2:搭建实现初步去雾的主干去雾网络;所述主干去雾网络基于transformer,在编码器的不同阶段,提取多级特征并生成输入图像的分层特征,在每个阶段将重叠特征的块结合起来;在解码器上使用雾天特征类型查询来完成解码任务,预测任务特征向量并使用其来恢复干净的图像;

5、步骤3:采用无监督域自适应的框架,用于改进网络结构的泛化能力和准确度;引入逐步连接这两个域的中间域,将一个域的内容图像特征和另一个域图像的私有特征进行重组,生成新的图像,形成模糊的目标域到清晰的目标域,逐层缓解域之间的差异;

6、步骤4:将经过改进的去雾网络模型进行训练,最终得到最好的预训练模型权重,利用优化好的模型对待处理图像进行高效去雾语义分割。

7、进一步地,所述步骤1中使用深度摄像头搜集城市街景图像雾天场景的实况图,使用labelm打标签工具进行标签标注,标注完成之后生成json文件进行转换并生成mask;将mask标签图像和原图进行缩放、旋转、裁剪的操作之后数据会得到增强;将增强完毕之后的数据集生成训练集、验证集和测试集。

8、进一步地,所述步骤2中编码器部分采用尺寸为h*w*3的雾场景的图像,并将其分为很多块,然后将块前馈到包括不同阶段的transformerblock的transformer编码器中;在解码器部分,与传统transformer的解码器中q、k和v取自相同输入的自注意力转换器模块不同,将q变为雾天气类型学习嵌入,而k和v取自变量。

9、进一步地,所述步骤2中雾天场景下雾建模为:

10、

11、其中,i为降级图像,m为掩模图像,b为背景,r为雨滴残差。

12、进一步地,所述编码器部分的transformerblock中,使用多头注意力层和前馈网络计算自注意力特征,其公式为:

13、ti(ii)=ffn(msa(ii)+ii)

14、其中,t()表示变压器块,ffn()表示前馈网络,msa表示多头注意力,i为输入,i为编码器中的级;

15、transformer编码器的前馈过程的公式如下:

16、yi=mti(xi)+intrapti(p(xi))

17、其中,i是跨级transformer的输入,y是跨级输出,mt()是主transformer块,intrapt是内补丁transformer块,p()对应从输入补丁创建子补丁的过程,i表示阶段。

18、进一步地,所述步骤3具体操作为:

19、步骤3.1:采用自训练方式,得到一组源域的图像和源域中的注释为以及仅带有注释的目标域样本和带有丰富的未标记目标域数据其中,为输入变量,为输出变量,ns为表示集合中二维组的数量,表示一个训练集,包含ns个样本,每个样本由一个输出变量和相应的输入变量组成;

20、步骤3.2:在源域上训练学生模型gθ,在自训练中使用双教师网络为目标域数据生成伪标签;

21、步骤3.3:构建新的无监督域自适应uda框架,首先在源域上训练分割模型,并且学生网络得到梯度回传;其次,让源域和中间域之间进行混合训练,此时学生网络同样得到回传梯度;源域和中间域做完混合之后,让源域与目标域之间进行混合,学生网络得到回传梯度;最后学生网络到教师网络学生网络到教师网络交替训练,并更新指数移动平均值ema。

22、进一步地,在源域上训练学生模型gθ,其交叉熵损失的目标函数公式如下所示:

23、

24、其中,xs、ys是第n个源图像和对应的标签,c表示向量的第c个标量;gcw(n,c)表示大小为n的二维高斯卷积核,用于对于每个像素位置计算一个权重,以便提高周围像素对于当前像素的影响;是训练样本的标签,表示第h行、第w列的像素属于第c个类别的概率,是模型对于输入的预测输出,表示第h行、第w列的像素属于第c个类别的得分。

25、进一步地,所述步骤3.2中生成伪标签选择在线生成,并按照与教师学生模型相同的构架设计双教师模型,其中权重θ'在不同训练步骤中为学生模型权重θ的指数移动平均ema,在训练阶段内,教师模型θ't的权重更新为:

26、θ't=αθ't-1+(1-α)θt

27、其中,t表示迭代次数,θt表示第t个时间步或迭代次数的模型参数,θ't-1表示上一个时间步或迭代次数的指数移动平均值,α是平滑因子,用于平衡当前参数值和历史平均值的权重。

28、进一步地,所述无监督域自适应的框架的损失如下公式所示:

29、l总=ls+l't+lt

30、其中,ls代表源域的损失,l't代表中间域的损失,lt代表目标域的损失,l't、lt的损失和ls类似,ls的损失计算为:

31、

32、其中,s表示训练集中的样本,i表示第i个样本,j表示样本中的像素位置,c表示类别数量,h和w分别表示输入图像的高度和宽度,是训练样本的标签,表示第i个样本中第j行、第w列的像素属于第c个类别的概率;是模型对于输入的预测输出,表示第i个样本中第j行、第w列的像素属于第c个类别的得分;是训练样本的标签,表示第i个样本中第j行、第w列的像素属于第c个类别的概率。

33、本发明还公开一种基于transformer的高效去雾语义分割方法在自动驾驶中的应用,采用ros通信机制将上述基于transformer的高效去雾语义分割模型应用到自动驾驶中,包括如下步骤:

34、(1)用oak-d的摄像头连接xavier开发板;

35、(2)创建一个oak摄像头管道对象;

36、(3)在创建的管道对象上创建一个神经网络对象,将上面放入oak-d中训练好的基于transformer的高效去雾语义分割模型赋值给神经网络对象;

37、(4)将彩色输出流对象与神经网络输出流对象相融;

38、(5)编写ros节点,每次接收到图像都进行网络分割并保存效果。

39、有益效果:

40、1、本发明采用transformer的去雾网络结构,采用的transformer编码器-解码器的结构相对于传统的神经网络模型具有更好的处理多变量输入、考虑位置信息、可并行化计算和更好的泛化能力等优势,因此在去除雾天气中具有更好的表现,并且会计算模型中每个输入元素的自注意力机制以便对序列中的每个元素进行加权聚合。这种加权聚合不仅可以捕捉元素之间的相关性,还可以考虑元素在序列中的位置信息,从而更好地处理时间序列数据。

41、2、在源域和目标域中加入中间域可以对源域和目标域之间相关的域间隙进行划分和封闭。提出一种新的管道来适应源域和目标域,尽可能的减少域差距,尝试利用中间域进行过滤,从清晰的源域过度到清晰的目标域,再从清晰的目标过度模糊的目标域,以此来达到缩小域差距的目的,整个过程实现的原理为由易到难,逐步递进。

42、3、本发明可以将语义分割集成到ros(机器人操作系统),通过ros软件系统,采用发布-订阅式的通信框架,便于对每个模块化的部分进行重新修改与定制,提高了系统的容错能力。

43、4、本发明可以将分割的模型嵌入到嵌入式设备中,可以有效的避免将图像数据传输到云端进行处理,从而减少了通信延迟,提高了响应速度。同时,可以实现实时处理,从而提高了决策速度和准确度。

- 还没有人留言评论。精彩留言会获得点赞!