一种基于宽时间范畴的多模态情境情感识别方法及系统

本发明涉及情感识别,具体涉及一种基于宽时间范畴的多模态情境情感识别方法及系统。

背景技术:

1、人类在沟通时往往会结合表情、语言、姿态等多种表达方式来传递自己的观点,因此单一模态的情感识别往往无法准确地判断目标人物的情感状态。多模态情感识别可以通过从不同的模态数据中挖掘情感信息并进行融合,使各个模态的信息实现互补,从而实现具有鲁棒性的、情感表征能力更强的情感识别系统。

2、自情感计算的概念出现以来,众多研究人员在情感计算的识别领域做出了相当多的贡献,然而多模态情感识别领域仍然存在很多难点和挑战。

3、(1)目前的多模态情感识别方法仅将当前时刻的多种情感表达进行多模态融合,但是人类的情感变化会受到某些事件导致的因果关系的影响,要将目标人物的显式情感表达与情绪变化的原因联系起来,才能更准确地分析情感状态。因此在情感分析模型中,需要结合发生过的事件(情境上下文信息)和当前时刻的信息综合考虑,因此对宽时间范畴的情感特征提取方法的研究是有必要性的。如何将宽时间范畴的研究带来的情境信息转化为模型能够处理的形式,如何捕捉情境信息对情感识别带来的影响,是目前需要解决的难题。

4、(2)情景信息作为情感分析的辅助信息,对于情感识别的辅助作用还在研究的初期阶段,目前的方法大多使用卷积神经网络提取图像中的情景信息,但并不是全部的情景信息都对目标主体的情感状态有影响,对整幅图像包含的信息进行学习可能会带来冗余信息,需要使模型能区分出对情感状态有影响的区域。

5、(3)跨模态不一致。情绪对于人类来说是一种非常主观的内在感受,个人的成长背景、文化背景、周围的环境等因素,都会影响其面对不同情况的情绪变化。不同的人在情绪相同的情况下,心理状态和外在表现可能会大相径庭。显式情感表达还可能会因为主观的抑制或伪装让人产生错误的判断,比如一个人在面对可怕的场景时会假装镇定,但是可以从面部表情和语音等多个角度进行情感信息的挖掘,捕捉到害怕的情绪。因此,需要情感识别模型对不同模态的情感表达进行综合判断,从而分析出目标人物的真实情感状态。

6、(4)跨模态不平衡。不同的人表达情感的方式存在差异,因此在多模态情感识别过程中,不同的模态对情感分析的贡献都不是一成不变的,某些情况下可能面部表情的变化更明显,或者语音语调表达了更强烈的情绪,亦可能在行动上表现出了情感的状态,不同情况下每个模态的情感表达强度都是不相同的。因此在多模态融合的过程中需要考虑如何有效的将贡献度不同的模态融合,实现准确的情感分析。

技术实现思路

1、为了克服现有技术的不足,本发提供一种基于宽时间范畴的多模态情境情感识别方法及系统,用于解决现有的多模态情感识别技术存在的仅针对当前时刻包含的信息进行情感挖掘、不能有效区分出对情感状态有影响的区域、跨模态不一致以及跨模态不平衡等的技术问题,从而实现具有鲁棒性的、情感表征能力更强的情感识别系统的目的。

2、为解决上述问题,本发明所采用的技术方案如下:

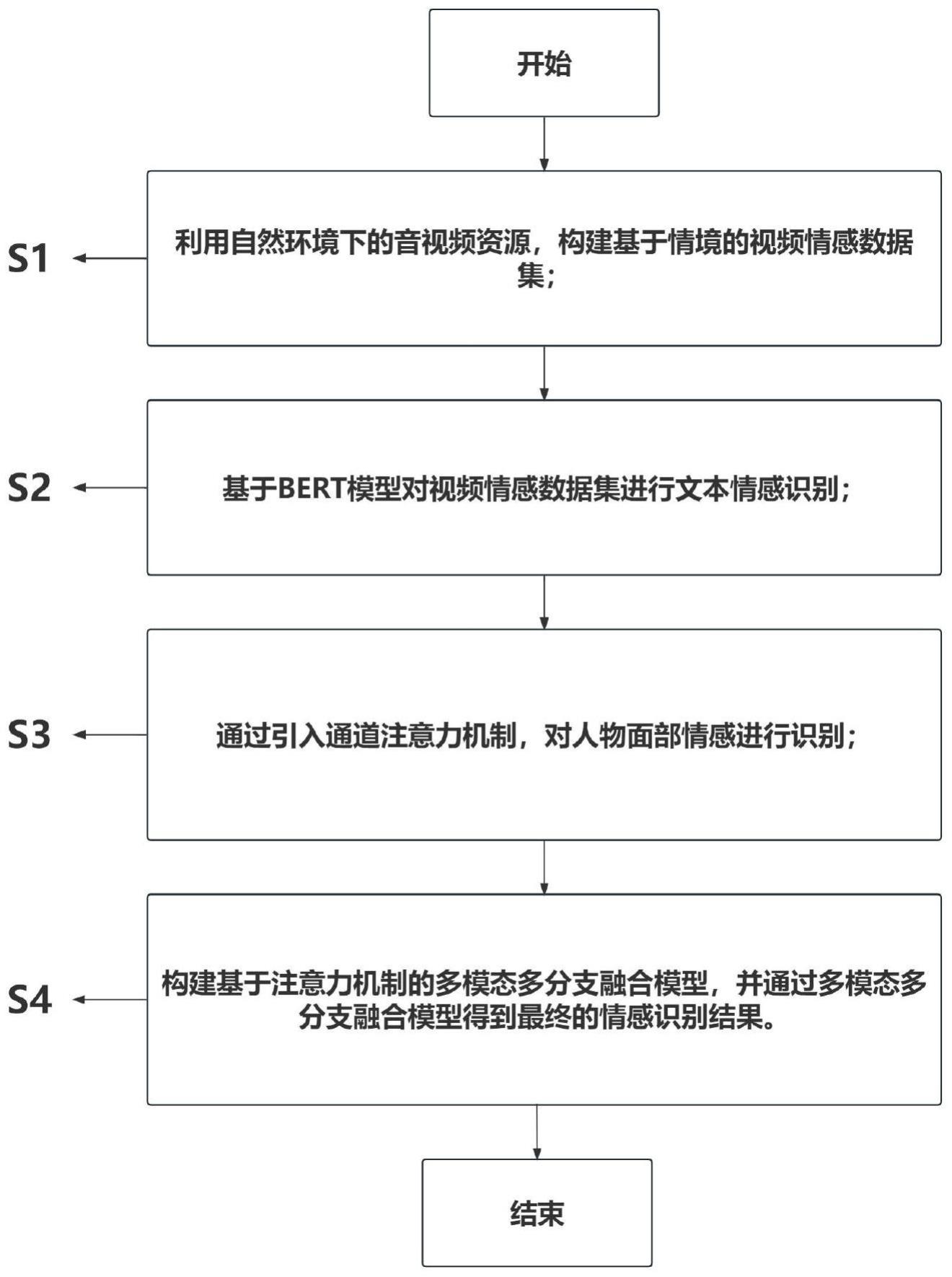

3、一种基于宽时间范畴的多模态情境情感识别方法,包括以下步骤:

4、利用自然环境下的音视频资源,构建基于情境的视频情感数据集;

5、基于bert模型对所述视频情感数据集进行文本情感识别;

6、通过引入通道注意力机制,对人物面部情感进行识别;

7、构建基于注意力机制的多模态多分支融合模型,并通过所述多模态多分支融合模型得到最终的情感识别结果。

8、作为本发明优选的实施方式,在构建基于情境的视频情感数据集时,包括:数据采集、情感类别定义、数据处理和以及数据标注;

9、其中,所述数据采集,包括:

10、筛选出与当前真实环境下的条件差别不大的影视剧,使用视频编辑工具在视频帧级别截取目标片段,将单个数据的时长控制在预设时间内,并且在尽可能减少镜头切换次数的基础上保留有用的场景信息;

11、所述情感类别定义,包括:

12、以emotic数据集定义的情感类别为基准,加入了iemocap中的沮丧情感和遗憾情感,得到多种情感类别;

13、所述数据处理,包括:

14、使用yolo v5和deepsort结合的多人目标追踪方法,识别并追踪视频当中所有出现的人,为每一个人的检测框赋予一个编号,并得到每一个检测框在图像中的坐标和宽高;基于检测到了目标人物在图像中的位置,利用mtcnn算法提取出人脸部分,并使用了libfacedetection算法进行查漏补缺;

15、所述数据标注,包括:

16、对每一个样本进行情感标注和文字标注;

17、其中,所述情感标注,包括:基于定义的多种情感类别,采用多标签的方式给所述每一个样本标注情感;

18、所述文字标注,包括:被标注者在当前视频片段中的台词、事实描述以及情境描述。

19、作为本发明优选的实施方式,在进行文本情感识别时,包括:

20、利用bertbase模型分别对事实描述、情境描述以及两者的拼接进行特征提取和情感分类,得到的分类结果;

21、其中,在进行特征提取时,包括:

22、所述bertbase模型利用transformer的自注意力机制对输入序列进行并行处理,同时获得每个词在序列内的相关性,捕捉到序列内部距离较长的特征依赖关系;

23、在进行情感分类时,包括:

24、对于每个输入序列,经过特征提取后的输出维度为128×768,将分类标记对应的输出特征经过全连接层映射到输出空间,得到每个文本的分类结果。

25、作为本发明优选的实施方式,在通过自注意力机制捕捉特征依赖关系时,包括:

26、通过使用输入向量对应的query与key计算点积,得到每个词向量与其他词向量的相关性,经过softmax归一化之后,得到每个位置的词向量对应的注意力分布,将对应位置的注意力值与value相乘后再求和,如公式1所示:

27、

28、式中,dk是为了使得到的注意力图的元素符合均值为0,方差为1的标准高斯分布,q为输入向量对应的query,k为输入向量对应的key,v为输入向量对应的value;

29、其中,每个词向量得到的向量表示都融合了输入序列中其他位置的语义信息。

30、作为本发明优选的实施方式,在对人物面部情感进行识别时,包括:

31、在模型训练阶段,从每个人脸图像序列中随机抽取n帧图像作为输入;

32、在测试阶段,将整段视频的图像序列作为输入;

33、面部情感识别部分选用resnet18作为图像特征提取的基础网络,并引入通道注意力模块和重要性权重生成的方法,最后使用滑动融合的方式,根据每一帧图像对应的重要性权重进行时序上的融合,将融合结果送入分类器得到最终的分类结果。

34、作为本发明优选的实施方式,在引入通道注意力模块时,包括:

35、将所述通道注意力模块引入resnet18中,得到引入通道注意力机制的resnet18,通过显示地构建通道之间的相关性,对每个通道赋予不同的重要性权重;

36、在所述通道注意力模块中,在对每个输入特征图使用全局平均池化后,通过使用一维卷积核捕获每个通道与其临近的通道之间的局部交互信息;

37、其中,一维卷积核尺寸决定了每次计算局部交互所覆盖的通道数,通过所述一维卷积核尺寸k和所述通道数c间的非线性映射关系,得到所述一维卷积核k的尺寸。

38、作为本发明优选的实施方式,在引入通道注意力模块时,还包括:

39、将所述通道注意力模块通过添加一个identity连接的方式,整合到resnet的每一个basic block中残差连接之前的位置;

40、其中,所述identity连接与经过所述通道注意力模块的输出通过对应位置元素相加的方式进行连接,并使用sigmoid函数对注意力权重进行处理,转化为0~1之间的值。

41、作为本发明优选的实施方式,在引入重要性权重生成的方法时,包括:

42、通过使用所述引入通道注意力机制的resnet18得到每个样本的面部特征表示后,将特征向量送入全连接层和sigmoid函数,为每个样本分配重要性权重,权重较低的样本表示其情感类别与标签不符,会被重新识别和打标签;

43、其中,在为每个样本分配重要性权重时,包括:

44、对经过骨干网络得到的特征向量重新分配重要性权重,面部表情完整且情感表达强烈的帧会被分配较高的权重,面部姿态处于侧脸或情感表达不明确的帧会被赋予较低的权重,将特征向量与对应的权重结合,完成针对表情不确定性的特征向量加权。

45、作为本发明优选的实施方式,在构建基于注意力机制的多模态多分支融合模型时,包括:

46、通过所述引入通道注意力机制的resnet18,分别对不同模态单独训练,得到每个模态的分类结果,并且引入注意力机制来自适应地为每个模态的分类结果分配权重;

47、其中,在训练的过程中只保留有效的数据进行学习;在多模态融合阶段,将缺失的模态数据使用零矩阵代替。

48、一种基于宽时间范畴的多模态情境情感识别系统,包括:

49、情感数据集构建单元:用于利用自然环境下的音视频资源,构建基于情境的视频情感数据集;

50、文本情感识别单元:用于基于bert模型对所述视频情感数据集进行文本情感识别;

51、面部情感识别单元:用于通过引入通道注意力机制,对人物面部情感进行识别;

52、最终情感识别单元:用于构建基于注意力机制的多模态多分支融合模型,并通过所述多模态多分支融合模型得到最终的情感识别结果。

53、相比现有技术,本发明的有益效果在于:

54、(1)本发明以宽时间范畴的视频情感数据集为研究基础,对人物面部、视频全局、音频以及文本分别提取情感特征,结合外部情感知识图,使用图神经网络构建先验信息的特征提取模型,验证事件前因对当前时刻情感识别的有效性。引入注意力机制,为每个模态的特征动态分配权重,以解决某一个模态丢失或表征不明显带来的问题,使模型更适应实际应用的复杂场景。

55、(2)本发明通过对主体面部表情、情景信息、音频、文本以及宽时间范畴内包含的先验信息(即情境信息)构建多模态情感识别模型,实现更加接近人类情感分析过程的情感识别系统。多个情感模态的结合可以有效避免由于某个模态的缺失带来的影响,可以应对现实生活中的复杂场景,在教育、心理治疗、智能陪伴机器人等领域都有较大的应用前景。

56、(3)通过本发明的基于宽时间范畴的多模态情感识别可以通过从不同的模态数据中挖掘情感信息并进行融合,使各个模态的信息实现互补,从而实现具有鲁棒性的、情感表征能力更强的情感识别系统。

57、下面结合附图和具体实施方式对本发明作进一步详细说明。

- 还没有人留言评论。精彩留言会获得点赞!