基于隐式通信的值分解多智能体强化学习方法

本发明属于协作式多智能体强化学习,特别是一种基于隐式通信的值分解多智能体强化学习方法。

背景技术:

1、多智能体强化学习已广泛用于解决单智能体难以解决的协同问题,如自动驾驶、无人机编队以及网络数据资源调度等。智能体之间,通过合适的训练框架学习策略并完成协作性任务。传统的训练框架包括完全集中式和完全分散式两种:前者利用所有智能体的经验信息,避免竞争,提高学习效率,但在系统规模较大时会面临计算和通信开销过大的问题,同时也具有一定的不可扩展性;而后者具备可扩展性的优点,但其理论上存在不收敛和局部决策不确定性问题。

2、因此,当前多数多智能体强化学习算法是基于上述两种方式的结合:集中训练、分散执行(centralized-training decentralized-execution,ctde)的训练框架。在训练阶段,基于全局信息优化自身的策略;在执行阶段,智能体之间相互独立,根据训练好的策略模型进行局部决策。一般来说,基于此框架的多智能体强化学习算法主要有两类:基于策略梯度的强化学习算法从直接优化策略入手,通过学习一种函数来表示策略,该函数将给定的状态映射到联合概率分布的动作上,同时利用梯度下降等优化方法来使得策略的预期累积奖励最大化。

3、基于值的强化学习算法的思路则是通过学习一种价值函数来表示状态或状态-动作对的长期回报的估计值,并根据该值来选择下一步动作。这种方法适用于对于状态-动作对的值函数能够被准确计算的离散的状态空间和动作空间问题上。

4、这些方法在一些场景中都表现出较好的性能,但是现有工作还存在如下问题:

5、(1)智能体之间隐式关系挖掘不足,可导致在部分可观测状态的下智能体之间奖励分配不公平,算法的收敛性不佳。

6、(2)对于智能体之间局部关系的建模,易导致智能体的策略空间增大,降低训练和执行效率。

技术实现思路

1、本发明的目的在于针对上述现有技术存在的问题,提出一种更有效的协调方式,通过利用隐式通信方式构建智能体之间的隐式关系,降低复杂环境中智能体局部决策的不确定性,以此达到一种隐式协调,从而使得智能体的奖励分配更公平,使得学习到的策略接近最优策略。

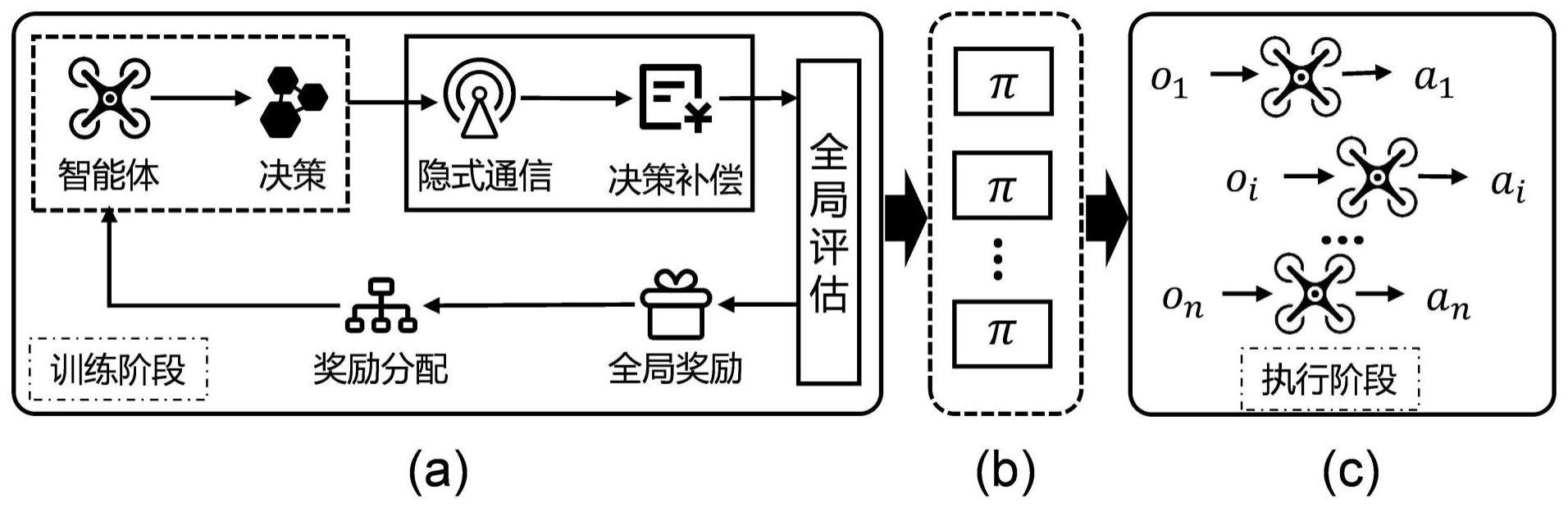

2、实现本发明目的的技术解决方案为:一种基于隐式通信的值分解多智能体强化学习方法,所述方法包括以下步骤:

3、步骤1,每个智能体根据当前的策略网络与环境进行交互,相互协作完成目标任务,收集相应的数据并将其保存至经验缓冲区;

4、步骤2,设计隐式通信框架用于获取全局智能体的局部观测信息,并且基于所述隐式通信框架构建基于隐式通信的值分解策略;

5、步骤3,基于所述值分解策略构建包含全局信息的局部动作值模型,并通过全局影响优化该模型;

6、步骤4,基于步骤3构建的模型构建基于隐式通信的值分解多智能体强化学习网络,对当前策略网络进行策略补偿;

7、步骤5,利用所述经验缓冲区的数据对所述基于隐式通信的值分解多智能体强化学习网络进行训练,更新智能体的策略网络;

8、步骤6,重复执行步骤1与步骤5,直至达到预设训练次数。

9、进一步地,步骤1所述每个智能体根据当前的策略网络与环境进行交互,相互协作完成目标任务,收集相应的数据并将其保存至经验缓冲区,具体包括:

10、步骤1-1,每个智能体根据局部观测值oi做出一个动作ai,环境根据任务的完成度给予系统一个奖励值r,并且全局环境状态由状态s切换到状态s';

11、步骤1-2,将步骤1-1的过程保存到一个马尔可夫元组g=<s,a,p,r,z,o,n,γ>中,并将该马尔可夫元组保存至经验缓冲区中;其中s∈s表示真实的全局环境状态集合,包括系统所有可能达到的全局环境状态;o表示智能体部分可观测信息集合,智能体i∈n≡{1,2,...,n}的部分观测信息表示为oi∈o,n表示智能体集合;观测值的概率分布由观测函数z(s,i):s×n→p(o)进行定义,p(o)∈[0,1]表示局部状态转移概率;环境动力学表示为状态转移函数p(s'|s,a):s×a×s→[0,1];奖励函数r(s,a):s×a→r由所有智能体共享,a∈a≡an表示智能体的联合动作;γ∈[0,1]表示折扣因子。

12、进一步地,步骤2所述设计隐式通信框架用于获取全局智能体的局部观测信息,并且基于所述隐式通信框架构建基于隐式通信的值分解策略,具体过程包括:

13、步骤2-1,设计隐式通信框架,该框架包括:(1)训练阶段智能体基于隐式通信,共享局部观测信息;(2)智能体利用全局信息进行训练,得到全局影响值;(3)将全局影响值与局部动作值融合,对策略网络进行弥补;

14、步骤2-2,构建基于隐式通信的值分解策略,具体包括:

15、(1)将全局信息引入局部动作值函数中,则全局动作值函数表示为:

16、

17、其中,qtot(s,a)为全局动作值函数,为一种混合网络,qi(s,ai)表示第i个智能体的局部动作值,s为全局环境状态,a表示智能体联合动作,ai∈a表示第i个智能体的动作;

18、(2)针对智能体的局部动作值函数,构建包含全局信息的局部动作值函数,表示为:

19、

20、其中,表示第i个智能体的包含全局信息的局部动作值,fij(oi,oj)表示第i个智能体对第j个智能体的影响值函数;

21、(3)基于上述(1)和(2),得到值分解策略为:

22、

23、则全局动作值函数进一步表示为:

24、

25、进一步地,步骤3所述基于所述值分解策略构建包含全局信息的局部动作值模型,并通过全局影响优化该模型,具体包括:

26、(2)对步骤2-2中所述包含全局信息的局部动作值函数进行多元泰勒展开,得到:

27、

28、其中为系数,且系数项也是关于第i个智能体的局部观测oi的函数,是关于智能体局部观测信息oi和动作ai的常函数;

29、(2)重构智能体全局影响评估模型

30、利用全局状态值s表示智能体影响的评估模型,即:

31、

32、其中,为重构后的第i个智能体对第j个智能体的影响评估模型,oi(s)表示第i个智能体的局部观测值与全局状态s之间的关系模型;

33、在全局初始状态s0处对进行泰勒展开,得到:

34、

35、其中,αi、βi表示泰勒展开式系数,表示高阶无穷小;

36、(3)针对一般项将上述(2)得到的展开模型代入,则:

37、

38、其中j1...jk为智能体的下标,用于表示不同的智能体,所有的α、β相关的变量均表示泰勒展开式系数;

39、令得到优化后的包含全局信息的局部动作值模型:

40、

41、进一步地,步骤4中基于步骤3构建的模型构建的基于隐式通信的值分解多智能体强化学习网络,具体为:

42、

43、其中,δ∈[0,1]为平衡系数,作为超参数用于平衡数量级的影响,qi(oi,ai)表示第i个智能体受局部观测信息的影响,表示当前策略函数;表示其他智能体对第i个智能体做出决策的影响值,为策略补偿值;

44、构建损失函数:

45、

46、其中,目标动作值θ为当前网络参数,θ-为目标网络的参数,s'为下一个状态,a'为状态s'采取的动作,为全局损失函数,表示经验缓冲区,表示期望。

47、进一步地,步骤5所述利用所述经验缓冲区的数据对所述基于隐式通信的值分解多智能体强化学习网络进行训练,更新智能体的策略网络,具体包括:

48、步骤5-1,从经验缓冲区中取出一个批次的数据;

49、步骤5-2,将步骤5-1的数据输入至所述基于隐式通信的值分解多智能体强化学习网络进行训练。

50、进一步地,步骤5-2中所述将步骤5-1的数据输入至所述基于隐式通信的值分解多智能体强化学习网络进行训练,具体包括:

51、(1)对于智能体受到局部观测信息的影响qi(oi,ai),基于传统的gru网络进行求解,输入的数据为第i个智能体的局部观测信息oi和局部动作ai;

52、(2)对于其他智能体的影响值利用一种多头注意力网络机制进行求解,将每个智能体的局部观测值作为多头注意力网络的输入计算对其他智能体的影响值;

53、(3)将上述(1)得到的局部动作值以及上述(2)的决策影响值进行融合,实现对当前决策的策略补偿,得到补偿后的局部动作值。

54、进一步地,所述利用一种多头注意力网络机制进行求解,将每个智能体的局部观测值作为多头注意力网络的输入计算对其他智能体的影响值,具体包括:注意力网络的输入键向量key和查询向量query分别为第i个智能体的局部观测值以及其他智能体的局部观测值,对角线为0其余元素为1的矩阵作为值向量value,三者的输入用于计算智能体之间的影响值;影响值前面的系数通过智能体策略网络的隐层输出经过一层全连接网络进行计算得出。

55、本发明与现有技术相比,其显著优点为:

56、1)基于隐式通信的多智能体强化学习,在智能体数量较多、智能体异构等复杂的环境中,能够减少智能体由于局部观测而导致的不确定性问题。(2)基于全局信息构建了一个影响评估模型,挖掘智能体之间的隐式关系,推导出策略补偿模型,进一步提高奖励分配的准确性。(3)基于一种类多头注意力机制设计一种多智能体强化学习框架,能够求解复杂环境中多智能体强化学习问题。

57、下面结合附图对本发明作进一步详细描述。

- 还没有人留言评论。精彩留言会获得点赞!