能源互联网中经济调度与电动汽车充电策略联合优化方法与流程

本发明例涉配电网运行优化,具体涉及一种能源互联网中经济调度与电动汽车充电策略联合智能优化方法。

背景技术:

1、近年来,随着工业的发展,能源短缺和环境污染问题日益严重。在交通领域,汽车尾气的排放已经成为日益严重的环境污染问题的主要因素之一。新能源电动汽车由于其零排放的特性变得越来越受人们的青睐。但随着电动汽车数量的增加,道路拥堵问题也随之而来,“充电难”成为众多电动汽车用户最大的困扰。此外,交通拥堵和充电策略不当会导致发电侧向充电桩输送的电能过剩,进而导致能量损失,对能源短缺造成严重影响。

2、在智能交通智能体中设计充电策略存在三个主要挑战。首先,由于道路交通网络的时变性和能源价格的波动性,很难设计出有效的策略来引导电动汽车选择合适的充电桩进行充电。这种策略不仅可以提升用户的充电体验,还可以尽可能消耗掉充电桩中剩余的电能。其次,设计高效的电力经济调度策略,尽可能消纳新能源发电,减少环境污染也很关键。最后,由于风光发电的不确定性,难以设计出高效且经济的调度策略来满足充电桩的能源负荷需求,同时尽可能降低充电桩的能源过剩。

3、目前关于电动汽车充电策略的研究有很多,例如,有人提出了一种“智能充电调度算法(icsa)”来减少电动汽车充电时间并降低能量消耗。然而,作者在模型中没有考虑到实时的道路交通状况,这可能会导致电动汽车因道路拥堵而无法及时充上电。还有人中提出了一种插电式电动汽车智能充电调度策略,用于辅助插电式电动汽车寻找充电时间、行程时间和充电成本最小的充电桩。然而,作者并没有考虑到充电桩的剩余能源消纳和用户里程焦虑[3]的变化可能导致策略指导的结果不是最优的。还有人提出了一种电动汽车充电导航框架,将电力智能体与交通智能体连接起来,通过分层博弈的方法有效地将电动汽车导航到充电桩。但该文献作者并未考虑到不同地区的充电桩能源价格的变化可能对策略指导产生不同的影响,部分电动汽车用户可能会忍受更长的路程距离来选择价格较低的充电桩进行充电任务。因此,有必要设计一个全面的电动汽车充电架构,以提高智能交通智能体中的用户充电满意度。

4、随着alphago的成功,深度强化学习(drl)在决策应用问题上显示出了巨大的潜力,最近也有很多研究使用drl来解决复杂场景下的电动汽车充电调度问题,有人提出了一种有效的充电规划模型,并采用基于drl的深度q网络(dqn)算法来获得最优调度策略,实现电动汽车的实时智能能量管理。但是,dqn只能处理离散的动作任务,显然dqn不适合连续动作的电动汽车充电场景。还有人提出了一种多目标电动汽车充电协调框架以获得较低的充电成本。此外,作者还使用了长短期记忆网络来预测电价以应对不确定的价格机制。然而,该文献中并未充分考虑到道路交通的实时变化对电动汽车充电策略的影响。有人为了解决用户通勤的不确定性和电动汽车到达充电桩的随机性,作者将电动汽车充电问题描述为一个受约束的马尔可夫决策过程,最终找到受约束的充电策略。然而,作者并没有考虑电动汽车的实时电量和充电桩的剩余电量情况,这很容易造成电动汽车因电量不足而未能及时充上电,也会造成充电桩能源出现过剩,

5、综上所述,现有技术当中能源互联网中经济调度与电动汽车充电策略的联合优化中,存在考虑不全面的问题。

技术实现思路

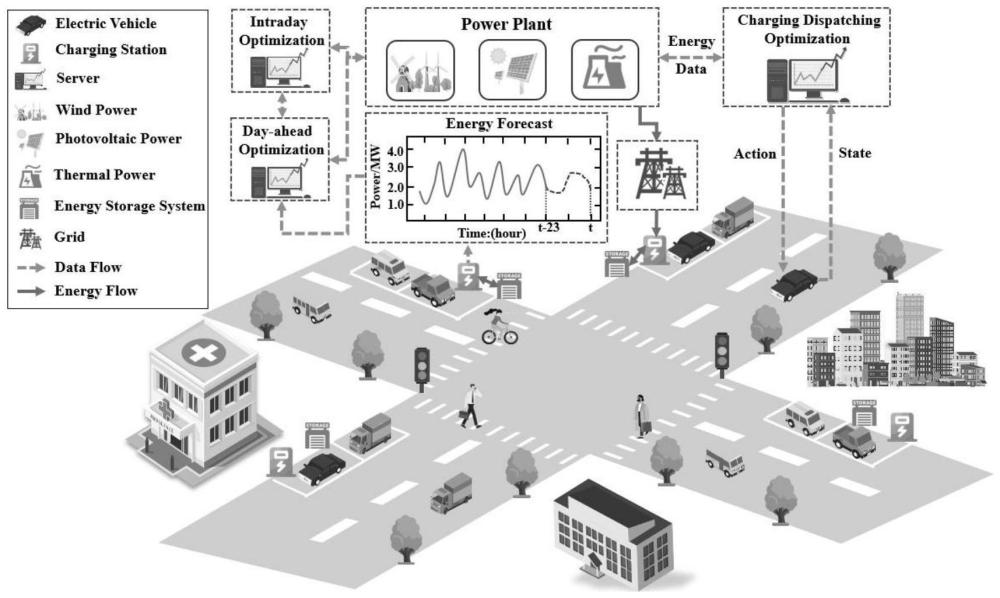

1、本发明的目的是现有技术当中能源互联网中经济调度与电动汽车充电策略的联合优化中,存在考虑不全面的问题,设计了一种最优充电策略来尽可能消纳可再生能源发电,减少环境污染,提高用户充电满意度,该方法通过距离成本、时间成本、用户里程焦虑等间接反映用户的充电满意度,采用一种基于近端策略优化的方法来寻找电动汽车的最优充电策略,实现更低的充电成本和尽可能消纳充电桩中的电能。同时,还考虑了充电桩的电力经济调度,通过建立两阶段多目标优化模型,使用基于近端策略优化的深度强化学习方法给出最优电力调度策略,以实现更低的发电成本和碳排放量。

2、本技术的技术方案是:

3、s1:构建数据集1

4、s1.1:获取充电桩的历史数据信息;

5、所述充电桩历史数据信息包括充电桩历史负荷数据和充电桩历史储能数据;

6、所述充电桩历史负荷数据包括风力发电机组对充电桩历史负荷数据、光伏发电机组对充电桩的历史负荷数据和火力发电机组对充电桩历史负荷数据;

7、充电桩历史储能数据包括充电桩日前调度阶段的历史储能数据和充电桩日内短期滚动调度阶段的历史储能数据;

8、s1.2:基于注意力(attention)机制的gru网络分别对风力发电机组对充电桩历史负荷数据、光伏发电机组对充电桩的历史负荷数据和火力发电机组对充电桩历史负荷数据进行处理,得到风力发电机组预测发电数据、光伏发电机组预测发电数据、日前调度阶段火力发电机组对充电桩的预测发电功率;

9、所述风力发电机组预测发电数据包括:日前调度阶段风力发电机组对充电桩的预测发电功率、日内短期滚动调度阶段风力发电机组对充电桩的预测发电功率;

10、所述光伏发电机组预测发电数据包括:日前调度阶段光伏发电机组对充电桩的预测发电功率、日内调度阶段光伏发电机组对充电桩的预测发电功率;

11、s1.3:将日前调度阶段风力发电机组对充电桩的预测发电功率、日前调度阶段光伏发电机组对充电桩的预测发电功率、充电桩日前调度阶段的历史储能数据和充电桩在日前调度阶段的负荷功率作为数据集1;

12、所述充电桩在日前调度阶段的负荷功率由日前调度阶段风力发电机组对充电桩的预测发电功率、日前调度阶段光伏发电机组对充电桩的预测发电功率以及日前调度阶段火力发电机组对充电桩的预测发电功率组成;

13、s2:构建基于近端策略优化的考虑两阶段经济调度的电动汽车充电调度优化模型;

14、所述基于近端策略优化的考虑两阶段经济调度的电动汽车充电调度优化模型包括:电力经济调度模型和电动汽车充电调度模型;

15、所述构建基于近端策略优化的考虑两阶段经济调度的电动汽车充电调度优化模型具体过程为:

16、s2.1:建立电力经济调度的目标函数和约束条件,并根据电力经济调度的目标函数和约束条件建立电力经济调度的优化形式;

17、s2.2:建立电动汽车充电调度的目标函数和约束条件,并根据电动汽车充电调度的目标函数和约束条件建立电动汽车充电调度的优化形式;

18、s3:将基于近端策略优化的考虑两阶段经济调度的电动汽车充电调度优化模型转换为对应的马尔可夫决策模型;所述马尔可夫决策模型主要构成通常是由一个三元组数据s、a、r来构成,包括:状态集合s、动作集合a和回报函数r;

19、所述将基于近端策略优化的考虑两阶段经济调度的电动汽车充电调度优化模型转换为对应的马尔可夫决策模型具体过程为:

20、s3.1:根据电力经济调度优化形式建立电力经济调度的马尔可夫决策模型;所述电力经济调度的马尔可夫决策模型包括:日前调度的马尔可夫决策模型和日内短期滚动调度的马尔可夫决策模型;

21、s3.2:根据将电动汽车充电调度的优化形式建立电动汽车充电调度的马尔可夫决策模型;

22、s4:求解电力经济调度的马尔可夫决策模型,得到最优的电力经济调度策略计划表;

23、所述最优的电力经济调度策略计划表包括:发电机组的日前调度动作集合组成的日前调度策略以及发电机组日内短期滚动调度动作集合组成的日内短期滚动调度策略;

24、所述发电机组包括火力发电机组、风力发电机组、光伏发电机组;

25、s4.1:构建actor-critic架构下融入重要性采样技术和动态步长机制的actor-critic网络,

26、actor网络根据当前状态st以及当前策略参数θ产生一种随机策略πθ,并根据当前策略πθ,输出智能体会采取相应动作at;t时刻智能体在做出动作at后,actor-critic网络会返回给智能体一个即时奖励rt,然后智能体生成下一时刻的状态向量st+1,得到训练样本序列<st,at,rt,st+1,πθ>;所述智能体是指采取行动并根据反馈做出决策的实体;所述当前状态st是智能体当前所在的位置或情况;

27、训练actor网络时采用策略梯度下降的方法,在智能体获得的最大化奖励期望值j(θ)方向上更新actor网络的策略参数θ;所述策略梯度下降的方法,是通过计算策略梯度,根据测量梯度下降的方向来更新策略参数;

28、所述策略梯度是通过引入优势函数进行计算,优势函数表示当前状态下选择动作的优异程度;所述优势函数通过状态-动作值函数和由critic网络产生的状态值函数的差值得到;

29、所述critic网络则负责评估动作at的好坏,从抽取的样本序列中提取当前状态st计算当前状态st下的状态值函数critic网络通过使用奖励函数和状态值函数之间的均方误差(mse)作为损失函数来更新网络参数μ;

30、所述重要性采样技术用来估计新策略的更新对于旧策略的奖励期望值,从而确定奖励期望值j(θ)最大化方向,进行策略参数的更新;

31、所述动态步长机制是指在训练过程中通过优势函数的剪切机制限制更新步长,从而实现动态调整步长,得到actor网络的损失函数;

32、s4.2:构建actor-critic架构下融入重要性采样技术和动态步长机制的actor1-critic1网络,并通过所述actor1-critic1网络求解日前调度的马尔可夫决策模型,得到一组最优日前调度动作集合组成的日前调度策略;

33、所述actor1网络产生的策略πθ1服从贝塔(beta)分布;

34、所述actor1-critic1网络求解日前调度的马尔可夫决策模型具体过程为:

35、数据集1构建actor1-critic1网络的状态集合st1,然后输入到actor1-critic1网络,输出发电机组会采取日前调度动作以及奖励得到训练样本序列将训练样本序列πθ1>存储在经验缓冲区

36、actor1-critic1网络从经验缓冲区中随机抽取一批样本序列,训练更新actor1网络参数θ1和critic1网络参数μ1,得到一组最优日前调度动作集合组成的日前调度策略;

37、所述日前调度动作集合包括:在日前调度阶段光伏发电机组调度给充电桩的上网功率,风力发电机组调度给充电桩的上网功率,火力发电机组调度给充电桩的实际发电功率,火力发电机组日前调度阶段的运行状态;

38、s4.3:构建数据集2;

39、将日内短期滚动调度阶段风力发电机组对充电桩的预测发电功率、日内短期滚动调度阶段光伏发电机组对充电桩的预测发电功率、充电桩日内短期滚动调度阶段的历史储能数据、充电桩在日内短期滚动调度阶段的负荷功率作和日内短期滚动调度阶段火力发电机组运行状态为数据集2;

40、所述充电桩在日内短期滚动调度阶段的负荷功率由日前调度阶段风力发电机组对充电桩的预测发电功率、日内短期滚动调度阶段光伏发电机组对充电桩的预测发电功率、日内短期滚动调度阶段火力发电机组对充电桩的实际发电功率组成;

41、所述日内短期滚动调度阶段火力发电机组运行状态与火力发电机组日前调度阶段的运行状态相同;

42、s4.4:构建actor-critic架构下融入重要性采样技术和动态步长机制的actor2-critic2网络,并通过所述actor2-critic2网络求解日内短期滚动调度的马尔可夫决策模型,得到一组日内短期滚动调度动作集合组成的日内短期滚动调度策略;

43、所述actor2网络产生的策略πθ2服从贝塔(beta)分布;

44、所述actor2-critic2网络求解日内短期滚动调度的马尔可夫决策模型具体过程为:

45、数据集2构建actor2-critic2网络的状态集合st2,然后输入到actor2-critic2网络,输出发电机组会采取日内短期滚动调度动作at2以及奖励rt2,得到训练样本序列<st2,at2,rt2,st2+1,πθ2>,将训练样本序列<st2,at2,rt2,st2+1,πθ2>存储在经验缓冲区

46、actor2-critic2网络从经验缓冲区中随机抽取一批样本序列,来训练更新actor2和critic2网络参数θ2和μ2,得到一组日内短期滚动调度动作集合组成的日内短期滚动调度策略,

47、基于s4.2和s4.4最终得到最优的电力经济调度策略计划表,实现高精度的充电桩电力分配;

48、所述日内短期滚动调度集合包括:在日内短期滚动调度阶段光伏发电机组调度给充电桩的上网功率,风力发电机组调度给充电桩的上网功率,火力发电机组调度给充电桩的实际发电功率;

49、s5:构建数据集3,并求解电动汽车充电调度的马尔可夫决策模型,得到最优的电动汽车的充电调度策略;具体过程为:

50、s5.1:获取电动汽车,充电桩,能源存储系统和道路交通状况的数据信息作为数据集3

51、所述电动汽车数据包括:电动汽车的剩余电量;

52、所述充电桩数据包括:充电桩的电价,充电桩的排队车辆数目,充电桩所接收到的发电功率和电动汽车行驶至充电桩所需要的最小电量;

53、所述能源存储系统数据包括:能源存储系统中的剩余电量;

54、所述道路交通状况数据包括:两路由节点之间的距离,道路拥挤指数,道路平均通行速度;

55、s5.2:所述求解电动汽车充电调度的马尔可夫决策模型,得到最优的电动汽车的充电调度策略具体过程包括:

56、构建actor-critic架构下融入重要性采样技术和动态步长机制的actor3-critic3网络,并通过所述actor3-critic3网络求解电动汽车充电调度的马尔可夫决策模型,

57、所述actor3网络产生的策略πθ3服从类别(categorical)分布;

58、所述actor3-critic3网络求解电动汽车充电调度的马尔可夫决策模型具体过程为:

59、数据集3构建actor3-critic3网络的状态集合st3,然后输入到actor3-critic3网络,输出电动汽车会采取充电调度动作at3以及奖励rt3,得到训练样本序列<st3,at3,rt3,st3+1,πθ3>,将训练样本序列<st3,at3,rt3,st3+1,πθ3>存储在经验缓冲区

60、actor3-critic3网络从经验缓冲区中随机抽取一批样本序列,来训练更新actor3和critic3网络参数θ3和μ3,最终得到一组电动汽车充电调度动作集合组成的最优的电动汽车的充电调度策略;

61、所述电动汽车充电调度动作由电动汽车选择哪一个充电桩进行充电以及在该选中的充电桩所获得的充电功率组成。

62、本技术与现有技术相比具有以下效果:

63、提出了基于近端策略优化的考虑两阶段经济调度的电动汽车充电调度模型。该模型旨在最大化用户的充电满意度和充电桩的能源消耗。同时,也最大限度地降低了发电侧的发电成本和碳排放量。最后给出了电动汽车充电调度的最优策略。为了有效地解决所提出的模型,首先提出了一个三步优化框架。第一步是通过日前调度给出机组的发电计划。第二步是通过日内短期滚动调度提高电力调度的精确性,第三步是电动汽车选择合适的充电桩实现充电调度。在三步优化过程中,我们分别使用基于近端策略优化的深度强化学习算法来获得最优调度结果。数值结果表明,我们提出的算法在模型收敛速度和奖励函数的大小方面要优于sac等最先进的算法。

- 还没有人留言评论。精彩留言会获得点赞!