一种基于图像隐写的联邦学习后门攻击方法

本发明属于人工智能、信息安全领域,具体涉及人工智能图像分类领域中联邦学习计算范式下的对图像分类任务的后门攻击领域,更具体的是一种图像分类领域中基于图像隐写的联邦学习后门攻击方法。

背景技术:

1、人工神经网络快速发展,并在现实生活中广泛应用,例如使用人工智能技术进行图像分类。但神经网络想要达到最优的效果,需要大量的训练数据。由于训练的数据涉及到敏感的隐私问题而导致持有大量数据的公司、机构无法合法的共享这些数据来推动模型的训练,使大量的数据孤岛产生。因此为了解决数据孤岛的问题,联邦学习应运而生。联邦学习提供了一种安全的人工智能算法,通过使不同客户的数据所产生的结果在互联网中流通,从而保证客户的图像资源可以不暴露本身的情况下安全的进行协作,共同训练一个效果良好的模型。联邦学习在训练过测试使用了神经网络,因此也具有神经网络存在的后门安全漏洞。参与者通过使用精心制作的包含触发器的数据进行后门的注入,使模型在后门激活的情况下输出特定的类而非正确的结果。在广泛的联邦学习后门攻击中,通常使用明显的图案作为触发器,且后门的效果会随着联邦学习的训练进程而被消除。因此,如何提供一种隐蔽的联邦学习后门攻击方法并使其难以随着模型的训练进程而被消除是本领域技术人员急需解决的问题。

2、联邦学习受到深度学习中一些攻击的影响,比如a.n.bhagoji等人在《analyzingfederated learning through an adversarial lens》提出的对抗攻击、v.tolpegin等人在《data poisoning attacks against federated learning systems》提出的数据投毒攻击,也因为其特性衍生出了一些新的攻击方式,例如c.xie等人在《dba:distributedbackdoor attacks against federated learning》提出的分布式的后门攻击。

3、现有的大部分联邦学习中的后门攻击都是基于一个明显的、固定的、与被注入数据无关的触发器,导致在模型不断地训练中容易被良性的梯度所覆盖。例如t.gu等人在《badnets:identifying vulnerabilities in the machine learning model supplychain》中,使用了美国停车标志数据库,并在其中选取了一张图片注入后门,依次使用的触发器为,黄色方块贴纸,炸弹贴纸,花朵贴纸。同时,联邦学习的后门攻击中,后门所产生的影响会随着训练时间的增加而减弱,导致后门攻击会随着时间的增加而失效。

4、现有的后门防御方法有如在样本中加入噪声模糊输入的差分隐私方法、y.gao等人在《strip:a defence against trojan attacks on deep neural networks》提出的strip方法、r.r.selvaraju等人在《grad-cam:visual explanations from deep networksvia gradient-based localization》提出的grad-cam方法、和感知哈希方法。

5、申请号2023107052684的中国专利申请公开了一种《基于重参数化隐写触发器的标签一致型后门攻击方法》,该方法包括生成毒化图像,构建具有毒化图像的训练集,再用训练集指导模型进行训练,完成后门触发器与目标标签的映射,得到被损害的模型,被损害的模型对干净图像分类正确,而将毒化图像的目标标签转化为预设标签输出,实现后门攻击的同时还能够保证后门触发器的较强隐蔽性。

6、申请号202310238338x的中国专利申请公开了《一种基于目标特征增强生成网络的神经网络后门攻击方法》,该方法针对现有基于生成网络的后门攻击对于要攻击的神经网络模型信息利用不足的问题,提出将目标类样本在要攻击的神经网络模型中的特征均值引入生成网络的解码器,引导训练,减小后门触发器的噪声并提升触发器对输入样本的自适应性。还提出使用一种三阶段的后门模型生成策略,通过依次执行神经网络模型预训练、后门触发器生成网络优化、后门模型中毒训练三个阶段,实现完整的后门攻击过程,进一步完善触发器生成网络的训练与后门信息的注入。相较于现有后门攻击方法具有出色的综合性能。

7、申请号2022115392819的中国专利申请公开了《一种基于空间变换的后门攻击方法、装置和介质》,该方法包括:从原始数据集中随机选择部分图像样本进行设定参数的空间变换,且将该部分图像样本的标签更改为目标标签,并对该原始数据集中剩余良性图像样本在保持标签不变的情况下进行随机参数的空间变换,从而将所述原始数据集处理为中毒数据集;使用所述中毒数据集进行深度学习分类模型的标准训练,构建被植入隐藏后门的受害模型;其中,所述受害模型在进行分类预测时,其隐藏后门能被待分类数据集中经过所述设定参数的空间变换的样本激活,使得待分类数据集中经过所述设定参数的空间变换的样本被错误地预测为目标标签,而其余样本能被正确地预测为真实标签。

8、以上三个专利都属于人工智能系统的后门攻击方法,其中,《基于重参数化隐写触发器的标签一致型后门攻击方法》在普通的dnn网络中将样本重参数化后与信息拼接制作触发器。《一种基于目标特征增强生成网络的神经网络后门攻击方法》是将特征均值引入生成网络的解码器,引导训练,减小后门触发器的噪声并提升触发器对输入样本的自适应性。《一种基于空间变换的后门攻击方法、装置和介质》是随机选择部分图像样本进行设定参数的空间变换,从而将所述原始数据集处理为中毒数据集。使用所述中毒数据集进行深度学习分类模型的标准训练,构建被植入隐藏后门的受害模型。使得待分类数据集中经过所述设定参数的空间变换的样本被错误地预测为目标标签,而其余样本能被正确地预测为真实标签。

9、而本发明人设计的是不同于上述三个专利的攻击方法,经检索,未有相同的专利文献。

技术实现思路

1、本发明的目的在于在图像分类领域中提供一种基于图像隐写的联邦学习后门攻击方法,该方法针对图像分类领域中的联邦学习架构,使用图像隐写方法制作的全尺寸图像触发器,多重损失联合计算获得较好的隐蔽性;同时在联邦学习模型更新的过程中,使用特征筛选和稀疏更新相结合的方法。本发明可以有效减少后门被清洗的概率、延长后门存在的时间,并增强后门的泛化性,从而提高攻击的成功率。

2、本发明的技术方案是:

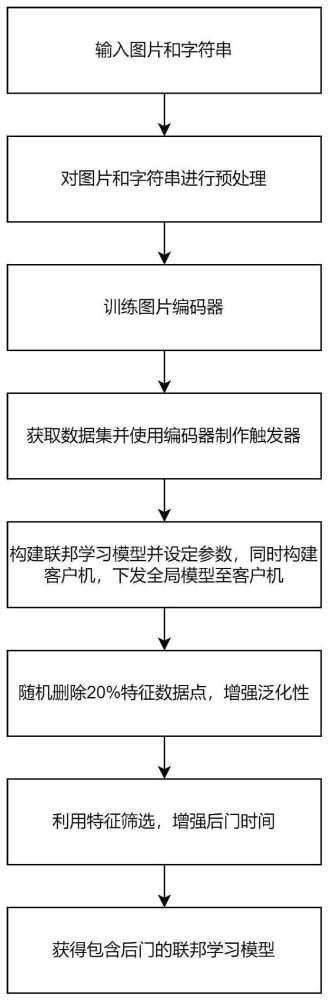

3、一种图像分类领域中基于图像隐写的联邦学习后门攻击方法,首先,通过图像隐写的方法来制作隐式触发器,该触发器的尺寸与输入的图片相同;其次,在模型更新时使用特征筛选方法,将包含攻击的梯度更新在数值最小的更新的梯度上,使触发器仅采取影响较小的部分,将较大的影响剪枝;最后使用稀疏更新再将所剩的较小的梯度值随机剪枝20%,从而将触发器的影响进行缩减,并随机进行更新;即包括如下步骤:

4、步骤1、制作攻击图像分类模型所需的触发器;

5、步骤2、构建图像分类联邦学习网络模型,通过中心服务器将3000个使用resnet模型的客户机联合构成总体模型;

6、步骤3、利用特征筛选方法对模型后门触发器对模型的影响进行筛选;

7、步骤4、利用稀疏更新方法将触发器的影响随机剪枝20%;

8、步骤5、更新联邦学习模型,将后门植入模型,最终获得包含后门的模型。

9、进一步地,步骤6、将上述方法与badnets和dba方法进行比较,并使用strip、感知哈希、grad-cam和差分隐私四种后门防御方法进行鲁棒性测试。

10、更具体的步骤为:

11、步骤1、建立u-net编码器和空间变换网络解码器,这对编解码器通过两个主要的损失值和两个辅助的损失值来组成的损失函数进行训练;在制作触发器时,首先将提供一段密文s,和一张需要写入密文的图片porg,然后使用编码器将图片编码并输出一个三通道的rgb残差图像作为触发器,然后将使用解码器将触发器进行解码,从而获得一张写入了密文的图片pen和一串通过解密获得的密文串sdecode;根据这些内容,使用两个损失,一是加密前的原图和加密后图片之间的损失ⅰ;二是解密前的原字符串和从图片中解密出的字符串之间的交叉熵损失ⅱ;为了更好制作一个肉眼难以察觉的隐式触发器,在最后的损失中还加入了学习感知图像块相似度损失,用于感知两张图像的差距,并且加入判别器对后门图像的判断所产生的结果向量的均值作为最后一个损失;将以上的四个损失组成最后的损失ⅲ:

12、lossimage=pen-porg#ⅰ

13、losssecret=crossentropyloss(s,sdecode)#ⅱ

14、

15、通过这些损失函数的共同计算,得到一个性能较好的u-net编码器;通过这个编码器,将每个图片根据一个固定的密文产生一张残差图像,以此作为最终的触发器。

16、步骤2、选择一个中心服务器,在中心服务器上初始化resnet参数;选用3000个客户机,在每个客户机中创建resnet模型;随后中心服务器下发模型的参数给所有客户机;训练时,每一轮由中心服务器选取客户机中的10个,且包含一个敌手,敌手会从后门数据集中抽取攻击数据进行训练,设定batchsize为64,在抽取样本时,使用了狄利克雷分布,通过调整狄利克雷分布的参数将样本划分为符合狄利克雷分布的样本;在训练中,设置良性学习率为0.001并以每轮以0.0005的大小进行衰减,在攻击的轮次中设置后门样本学习率为0.02并且每轮以0.005的大小进行衰减。

17、步骤3、在模型训练的过程中,敌手所存在的客户机将会上传包含触发器的后门数据所产生的梯度;在每个梯度中,筛选出值最大的前5%的梯度值ⅳ、ⅴ,并将他们置零,然后上传,从而阻止这些梯度的被中心服务器所学习。

18、

19、

20、步骤4、在中心服务器获取到所有客户端的梯度更新时,随机将20%的梯度剪枝ⅵ,仅使用剩余的80%进行模型的更新。

21、

22、步骤5、联邦学习中心服务器收到良性客户机的梯度更新和敌手所在的客户机的梯度更新,将所有的梯度根据平均梯度聚合算法进行聚合,获得最终的梯度更新;使用最终的梯度更新模型后,向所有客户机下发最新的模型;经过多轮训练最终获得包含后门的模型。

23、步骤6、将上述方法与badnets和dba方法进行比较,每个方法都使用图像分类数据集cifar-10、cifar-100和fashion-mnist进行对比,比较后门植入的成功率,观察后门下降的趋势,比较后门存活的时间;同时,使用strip、感知哈希、grad-cam和差分隐私四种后门防御方法对本发明的方法进行鲁棒性测试,与badnets和dba方法比较,比较模型的鲁棒性。

24、本发明具有以下特点:

25、1、本发明提出了一种在图像分类领域应用的联邦学习后门攻击方法的改进。引入了四个损失值的联合计算,以得出最终损失,从而训练出一个高性能的编码器。该编码器能够生成与输入图像尺寸一致的隐蔽触发器,以增强后门攻击的隐蔽性。

26、2、本发明涉及一种针对联邦学习框架的策略,该策略通过对包含后门触发器的样本产生的梯度进行筛选,并只用较小的梯度值进行模型更新。此方法使得后门攻击在联邦学习环境中的清除过程变得更加缓慢,从而延长了后门攻击在图像分类模型中的存活时间。

27、3、本发明还提出了一种图像分类领域的联邦学习模型优化方法。在模型聚合过程中,随机对20%的梯度进行剪枝,仅使用剩余的80%进行模型更新。这种方法提升了后门攻击的准确率和泛化性。

- 还没有人留言评论。精彩留言会获得点赞!