一种图像神经风格迁移方法

本发明涉及图像处理,具体涉及一种图像神经风格迁移方法。

背景技术:

1、图像风格迁移是将不同的图像进行结合,广泛用于艺术创作工作。gatys等人开创性地借助深度神经网络对图像进行特征提取,并使用gram矩阵进行损失衡量,有效进行了风格迁移,将风格迁移引入神经风格迁移时代,现其正向视频风格化,字体转化,肖像变化,艺术创作,图像增强等领域进行发展。

2、基于神经网络的风格迁移方法不仅包括获取高质量的风格迁移图像,也包括提升图像生成速度。现有技术中,从图像生成过程的损失衡量出发,主要包括了gatys等人使用gram矩阵的全局损失优化方式,以及li等人为代表的局部匹配优化方式。两种典型的风格迁移方式都可以有效地进行风格迁移。全局优化方式对于任意图像都可以有效转移风格图像全局的纹理,色彩等特征,而采用图像块匹配的局部风格迁移方法常常用于对结构,纹理相近的图像进行风格迁移,比较适用于人脸等位置敏感的风格迁移。但全局优化的方式也存在无法捕获细小结构,容易风格溢出从而产生伪影等不足,而局部优化的方式虽然利于细节迁移,但是却有不利于反映全局特征,应用受限等劣势。

技术实现思路

1、本发明的目的在于克服上述缺点而提出了一种能结合全局和局部优化方式,有效避免全局或局部单一优化方式的局限性的图像神经风格迁移方法。

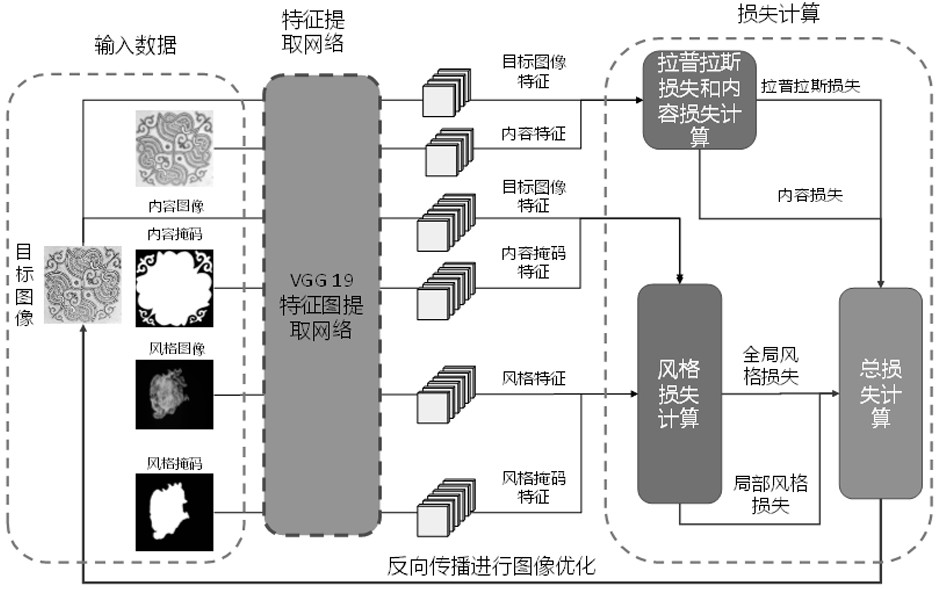

2、本发明的一种图像神经风格迁移方法,该方法包括以下步骤:

3、步骤1、图像数据输入:输入要优化的目标图像、内容图像、风格图像、内容掩码图像、风格掩码图像,并将所有图像进行张量形状的统一;

4、步骤2、模型构建:通过卷积神经网络vgg19网络进行特征提取模型构建,然后使用所述的特征提取模型进行特征图的提取,并根据获取的特征图进行内容损失,风格损失,拉普拉斯损失等的计算;

5、所述特征提取模型:基于vgg19网络,包含卷积层、池化层、全连接层;采用卷积层、池化层进行特征的提取,获取特征图,并根据获取的特征图进行损失函数计算;

6、所述损失函数定义为公式(1):

7、

8、表示计算总的内容损失,表示在特征提取网络第i层计算内容损失,α为内容损失权重参数;

9、表示使用块匹配的方式计算其中的局部风格损失,表示在特征提取网络第j层计算风格损失,β为局部损失权重参数;

10、表示根据局部损失得到图像块进一步进行gram矩阵计算,表示依据第j次局部匹配的图像块再次计算gram矩阵损失,β1为gram矩阵权重参数;

11、表示计算gram矩阵损失用作全局损失,表示在特征提取网络第k层计算全局损失,γ为全局损失权重参数;

12、表示计算总的拉普拉斯矩阵损失,表示在特征提取网络第看层计算拉普拉斯损失,δ为拉普拉斯矩阵权重参数;

13、所述内容损失定义为:

14、

15、其中,表示要计算的第i层的内容损失,fx表示要优化的风格迁移图像经过特征提取网络获取的特征图,即风格迁移特征图,fx_c表示内容图像经特征提取网络得到的特征图,两者形状一致,对应的形状尺寸是[1,c,h,w],c表示通道数,h,w表示特征图的高和宽;

16、所述局部风格损失:获取风格迁移特征图fx,风格图像特征图fx_s,内容掩码特征图fx_cm,风格掩码特征图fx_sm,在计算局部风格损失的过程中,为了更好地进行图像块的匹配,进行通道连接,将内容掩码特征图fx_cm与风格迁移特征图fx进行通道连接,将风格掩码特征图fx_sm与风格图像特征图fx_s进行通道连接的公式如下:

17、

18、

19、其中在公式(3)中,表示内容掩码特征图fx_cm与风格迁移特征图fx进行通道连接之后的新特征图,λ表示控制掩码的权重参数;

20、在公式(4)中表示风格掩码特征图fx_sm与风格图像特征图fx_s进行通道连接之后的新特征图,根据新的特征图,获取对应的局部补丁,其中表示获取的第i个局部补丁相连得到的特征图,尺寸为[bn,2c,hp,wp],bn分别表示局部补丁的数量、2c连接形成的新通道数,hp表示局部补丁的高,wp表示局部补丁的宽;

21、其局部风格损失函数定义为:

22、

23、其中,寻找最佳图像块的匹配的过程如公式(6)示:

24、

25、其中,ps表示其中的局部补丁的基数,表示获取特征图的补丁;此处,使用局部补丁进行图像块匹配之后,同时获得了其中的对应图像块补丁,然后使用图像块补丁的特征图再次计算gram矩阵,用于进行图像块补丁的增强计算,计算如公式(7)所示:

26、

27、

28、

29、其中,表示要计算的局部风格损失,表示对应局部特征图的gram矩阵;公式(8)表示计算gram矩阵,表示将特征图形状尺寸尺寸[1,c,h,w]变换为[c,h*w];公式(9)中,表示将特征图形状尺寸[1,c,h,w]变换为[c,h*w];

30、所述全局损失的计算如公式(10)所示,表示对gram矩阵求差值,然后计算其平方和:

31、

32、

33、

34、

35、

36、其中,表示要计算的某模型层的全局风格损失,λt为控制参数,gxc、gss表示对应全局特征图的gram矩阵;公式(11)使用内容掩码特征图fx_cm,风格迁移特征图fx相加得到新的特征图公式(12)表示风格迁移特征图fx与风格掩码特征图fx_sm相加获取新的特征图公式(13)表示计算gram矩阵,表示将特征图形状尺寸[1,c,h,w]变换为[c,h*w],表示获取转置矩阵;公式(14)表示计算gram矩阵,表示将特征图形状尺寸[1,c,h,w]变换为[c,h*w];

37、所述拉普拉斯损失:拉普拉斯算子由公式(15)给出,在使用过程中,将图像与拉普拉斯算子进行卷积得到图像的拉普拉斯矩阵,为了对风格迁移图像的细节进行有效控制,引入拉普拉斯算子用于损失计算,以更好保留获取风格迁移图像的结构完整性;计算拉普拉斯损失过程中,先获取风格迁移图像的特征图,内容图像的特征图,然后对特征图使用拉普拉斯算子进行卷积计算,同时进行边缘填充以保持获取的拉普拉斯矩阵的高宽形状不变,得到的拉普拉斯损失如公式(16)所示:

38、lap_f=[[0,-1,0],[-1,4,-1],[0,-1,0]] (15)

39、

40、其中,表示计算图像拉普拉斯损失,lap(fx,lap_f)表示对风格迁移特征图fx使用算子lap_f进行卷积处理获取特征图的拉普拉斯矩阵;lap(fx_c,lap_f)表示对内容特征图fx_c使用算子lap_f进行卷积处理获取内容特征图的拉普拉斯矩阵;

41、步骤3,图像数据更新:将所有的损失进行合并计算,获得一个总的损失,然后通过优化器对损失进行求导与更新,从而对风格迁移图像进行像素更新;在优化的过程中,使用优化器l_bfgs并以分辨率逐次增加的方式进行优化处理,并得到最终的风格迁移图像。

42、上述一种图像神经风格迁移方法,其中:在步骤1中,所述内容掩码图像和风格掩码图像,采用工具进行标注,将所述图像中相同类别标记为相同的掩码颜色。

43、上述一种图像神经风格迁移方法,其中:在步骤1中,所述张量形状统一为尺寸[1,3,hi,wi],3表示图像的通道,hi,wi分别表示第i个输入图像的缩放高和宽。

44、上述一种图像神经风格迁移方法,其中:在步骤2中,所述特征提取模型构建,采用顺序模型的方式进行模型构建,进行损失函数计算后,获取特征图;所述特征图的尺寸为[1,c,h,w],c表示对应的模型的通道,h,w表示获取的特征图高和宽。

45、上述一种图像神经风格迁移方法,其中:在步骤2中,所述内容损失是获取特征图的欧几里得距离。

46、上述一种图像神经风格迁移方法,其中:在步骤2中,所述控制参数λt,用于对数据进行相加处理,λt=0表示掩码数据不对数据有任何的影响。

47、本发明与现有技术的相比,具有明显的有益效果,由以上方案可知,首先输入要优化的风格迁移图像(目标图像),内容图形,风格图像,内容图像掩码,风格图像掩码;然后使用vgg19网络进行特征图的提取,并根据获取的特征图进行内容损失,风格损失,拉普拉斯损失等的计算;之后通过优化器对损失进行求导与更新从而对风格迁移图像进行像素更新,并得到最终的风格迁移图像。该发明是结合全局和局部优化的图像神经风格迁移方法。在局部损失的计算中,将内容图像的掩码,风格图像的掩码加入图像块的匹配过程,保留风格细节并减少图像误匹配;全局损失函数使用gram矩阵进行计算,将内容特征图的掩码与风格迁移图像的特征图进行相加,采用超参数控制掩码数据对图像影响,同时将拉普拉斯算子引入用于结构细化,以更好保留风格迁移图像的结构完整性。总之,本发明主要优点:

48、1.在同时存在全局和局部优化损失函数的情况下,将输入数据大小纳入风格迁移图像效果的考虑。探究了输入数据对风格迁移图像生成效果的影响,为风格迁移过程平衡全局和局部优化效果提供了新的参数,也为使用全局和局部损失优化提供了新思路。

49、2.对局部优化过程匹配的图像块再次使用gram进行损失计算。使用gram矩阵以及图像块匹配在实际优化过程对于图像生成效果不一致,对图像块再次进行gram矩阵计算用于图像优化可以为风格迁移过程提供进一步的超参数控制,便于进行细节部分更加细致优化。

50、3.将掩码数据同时用于局部优化和全局优化过程,提升图像质量。将掩码数据进行通道连接用于局部优化过程的图像块匹配,减少风格溢出;将掩码数据用于特征图相加,为全局损失计算提供进一步的超参数控制,提升图像质量。

51、以下通过具体实施方式,进一步说明本发明的有益效果。

- 还没有人留言评论。精彩留言会获得点赞!