基于序列注意力机制的交通数据补全方法及电子设备

本发明属于神经网络和数据恢复领域,特别是涉及一种基于序列注意力机制的交通数据补全方法及电子设备。

背景技术:

1、交通数据通常用于支持交通规划、交通管理和决策制定。交通数据可能会因系统故障、人为错误或自然灾害而丢失。如果数据不完整或损坏,这可能导致不准确的分析和决策。数据补全技术可以帮助确保数据的完整性,从而提高决策的准确性。数据补全技术在交通领域具有重要的背景意义,可以提高数据的质量和可用性,有助于更好地管理、规划和改进城市的交通系统。这对于提高交通安全、减少拥堵、提高交通效率和提供更好的交通服务都非常重要。随着深度学习技术的兴起,基于深度学习的数据补全研究逐渐变得普及了起来。

2、现有的数据补全算法可以分为三类:传统统计方法、机器学习方法和深度学习方法。流行的统计方法包括均值/中值补全、回归补全、期望最大值补全和链式方程多变量补全法(mice)。统计方法主要是通过假设数据满足某种假设,基于这个假设进行统计学模型建立和因果推断从而达到缺失数据补全。许多机器学习方法根据问题的性质和数据的特点选择机器学习模型,主要采用线性模型、树模型、支持向量机等可解释性较强的结构,通过这些模型进行预测缺失数据。最近大部分基于深度学习的方法都是基于递归神经网络(rnn),比如brits和m-rnn都是通过使用双向rnn的隐藏状态来计算缺失值方面,m-rnn将缺失值视为常量,不考虑特征相关性,而brits则将缺失值视为可学习变量,并在训练过程中迭代更新。通过深度学习进行数据补全主要是通过模型捕捉数据的基本模式和特征进行数据补全。

3、上述现有的交通数据补全算法依然存在一些不可忽略的缺陷,针对传统统计的方法而言,是单一补全方法,没有考虑缺失数据预测的不确定性。机器学习的方法大多依赖于对缺失值的有力假设,这些假设可能会带来很大的偏差,但当假设不成立时,它们的线性性质可能会限制其捕捉数据表现中更复杂模式的能力。对于深度学习方法,都是基于自回归模型,使用自回归模型时可能会面临误差传播问题,生成序列的每一步都依赖于前面已生成的序列部分,因此如果在生成过程中存在一些错误或噪声,这些错误或噪声会被传递到后续的生成步骤中,导致生成的序列中积累了误差。对于交通数据集来说,这种现实数据本身可能存在噪声、不完整性或不确定性,自回归模型在生成过程中可能会受到这些问题的影响,进而产生复合误差。此外上述方法只基于一个数据集考虑时间维度特征,也就是说,如果换了不同颗粒的数据集模型就会不适用。同时上述一些方法在提取时间特性的时候只是笼统的提取时间隐藏特征,并没有充分考虑到时间序列数据中的周期性。现有的很多方法没有充分利用空间依赖性,补全的精确度往往不高。

技术实现思路

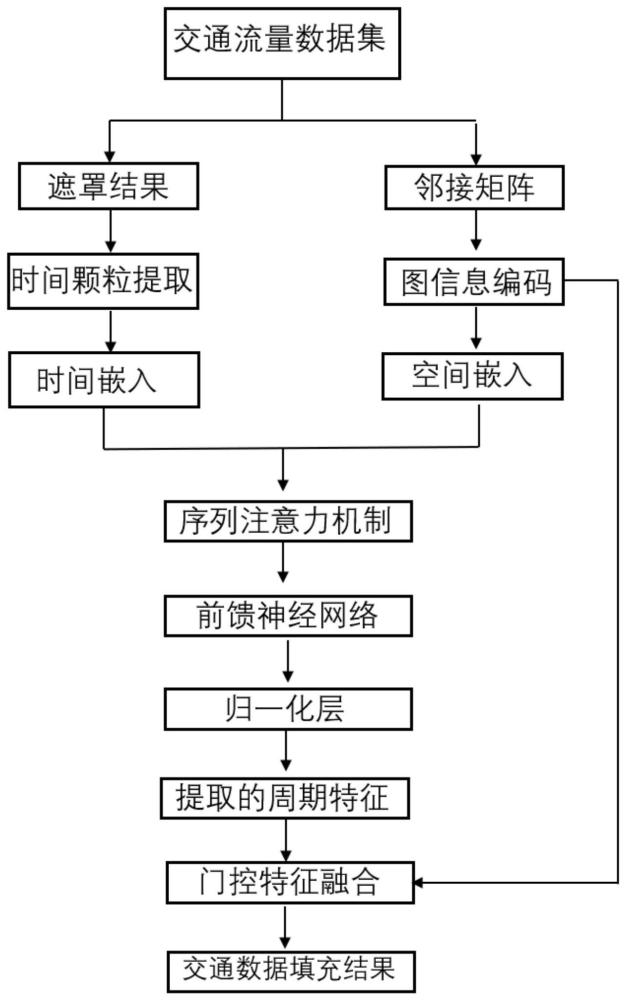

1、本发明的目的是针对现有技术不足,本发明提供了一种基于序列注意力机制的交通数据补全方法及电子设备,该方法将图信息编码结合时间序列周期性特征,使用基于图编码的序列注意力机制进行补全训练。

2、为了实现上述目的,本发明所采用的技术方案是:

3、一种基于序列注意力机制的交通数据补全方法,包括以下步骤:

4、s1:对交通流量数据集进行遮罩处理,获得遮罩后的缺失数据集x、掩码矩阵m及邻接矩阵;

5、s2:将缺失数据集x作为基于序列注意力机制的交通数据补全模型的输入参数,训练基于序列注意力机制的交通数据补全模型,所述基于序列注意力机制的交通数据补全模型包括时间颗粒提取层、空间特征提取层、序列注意力层、前馈神经网络层、归一化层、门控特征融合层;所述时间颗粒提取层和所述空间特征提取层分别连接所述序列注意力层,所述序列注意力层连接所述前馈神经网络层,所述前馈神经网络层连接所述归一化层,所述归一化层连接所述门控特征融合层;

6、基于序列注意力机制的交通数据补全模型的训练过程包括:

7、对缺失数据集x进行时间颗粒特征提取,得到时间颗粒特征矩阵,将时间颗粒特征矩阵线性映射到指定维度,得到时间嵌入x时间嵌入;用消息传递神经网络结合邻接矩阵进行图信息聚合,得到空间特征矩阵,将空间特征矩阵编码成空间嵌入x空间嵌入;

8、融合空间嵌入x空间嵌入和时间嵌入x时间嵌入,得到x嵌入=x时间嵌入+x空间嵌入;

9、使用序列注意力机制对x嵌入提取时间周期特征,得到自相关子序列xattention;

10、对xattention进行非线性映射,得到x周期特征=relu(w1xattention+b1)w2+b2,relu是激活函数,w1,w2是权重矩阵,b1,b2是偏差;

11、对x周期特征进行归一化,使用门控机制整合x空间嵌入和归一化后的x周期特征,得到补全数据o(x),o(x)=w(σ(ex空间嵌入)*fx周期特征),w、e、f为权重矩阵,σ为激活函数;

12、基于序列注意力机制的交通数据补全模型输出为是掩码矩阵m按位取反后得到的矩阵,掩码矩阵m数据为0时输出o(x),掩码矩阵m数据为1时输出缺失数据集x;

13、重复上述训练过程,迭代训练优化基于序列注意力机制的交通数据补全模型,得到最终模型。

14、本发明利用消息传递神经网络mpnn提取图信息聚合的空间特征,将图信息聚合的空间特征编码为更具表达力的空间嵌入向量,解决了现有基于神经网络的交通数据补全算法只考虑时间特征不提取空间特征的技术问题。

15、本发明采用序列注意力机制,使用改进之后的注意力机制提取到序列和序列之间的相关性,进而提取时间序列数据中周期性。解决了使用自回归模型时可能会面临误差传播的技术问题,同时解决了自注意力机制只提取点和点相关性不能更全面捕捉序列相关性的问题。

16、本发明根据数据集的时间颗粒度,创建时间特征类,考虑不同数据集的时间戳精确度,形成适当的时间颗粒特征矩阵。根据输入的时间频率字符串,自动确定时间特征列表,能够解决模型方法不适用于多种数据集和时间精度的情况,进而使模型能够捕捉时间序列数据中的周期性模式。

17、进一步地,所述遮罩处理,包括以下步骤:

18、s1:读取交通流量数据集,从交通流量数据集找到时间索引作为数据集列索引,行索引为每个交通传感器的id,得到一个t×n的原始数据矩阵t为时间长度,n是传感器个数;

19、s2:创建一个n×n的矩阵dist,将交通传感器之间的距离存储到矩阵dist中,通过遍历矩阵dist中的距离信息得到距离矩阵,对距离矩阵进行归一化,通过高斯核函数计算距离矩阵的相似矩阵,将相似矩阵中小于设定阈值的值设为零,得到邻接矩阵;

20、s3:创建一个与原始数据矩阵维度相同的随机矩阵,给定缺失概率p,将随机矩阵中与原始数据矩阵中数据小于p的对应位置设为0,其余位置设为1,得到掩码矩阵m;

21、s4:将原始数据矩阵中数据小于p的位置设为0,其余位置为原值,得到缺失数据集x。

22、进一步地,所述时间颗粒提取,包括以下步骤:

23、s1:创建时间颗粒特征矩阵x_mark,用来存储提取的时间颗粒特征,维度为t×dt,t是时间长度,dt是时间颗粒特征数量;

24、s2:定义一系列时间颗粒提取类,用来提取不同颗粒度的时间特征;

25、s3:输入缺失数据集x的时间戳和给定的频率,提取时间颗粒特征,给定的频率表示数据集精确的颗粒度;

26、s4:对提取的时间颗粒特征进行垂直堆叠,放在特征矩阵x_mark中,得到时间颗粒特征矩阵。

27、进一步地,所述编码成空间嵌入x空间嵌入,包括以下步骤:

28、s1:初始化交通传感器节点的隐藏状态,从标准正态分布中采样生成隐藏状态的初始值;

29、s2:利用消息传递神经网络结合邻接矩阵进行图信息聚合,通过消息传递、消息聚合、更新节点,得到空间特征矩阵;

30、s3:将空间特征矩阵编码成空间嵌入x空间嵌入。

31、进一步地,所述使用序列注意力机制对x嵌入提取序列周期特征,包括以下步骤:

32、s1:对输入x嵌入进行线性投影得到k、q、v,q表示基于序列注意力机制的交通数据补全模型当前位置需要关注的元素序列,形状为(b,l,dmodel),其中b是批大小,l是序列长度,dmodel是嵌入向量维度;k表示用于计算注意力权重的参考序列,形状为(b,s,dmodel),其中s是参考序列的时间步长;v表示反应元素序列本身的值,形状为(b,s,dmodel),wq,wk,wv为权重矩阵,

33、s2:通过快速傅里叶变换计算序列的相似性矩阵a,f()是傅立叶变换,f-1()是傅立叶逆变换,f*()是共轭计算;

34、s3:使用回滚操作查找得到自相关子序列xattention,xattention=roll(v,τ)softmax(a)v,roll(…,…)是序列回滚操作,τ是滚回的长度参数。

35、基于同一构思,本发明提供了一种实现基于序列注意力机制的交通数据补全方法的电子设备,包括:

36、一个或多个处理器;

37、存储器,其上存储有一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器实现所述基于序列注意力机制的交通数据补全方法的步骤。

38、相比于现有技术,本发明的有益效果:

39、(1)本发明利用消息传递神经网络提取图信息聚合的空间特征,将图信息聚合的空间特征编码为空间嵌入向量,解决现有交通数据补全方法只是通过时间之间相似性进行补全,而没有充分利用空间特征,导致交通数据补全准确度的技术问题;

40、(2)本发明采用序列注意力机制,使用改进之后的注意力机制提取到序列和序列之间的相关性,进而提取时间序列数据中周期性,解决了由于现有深度学习技术都使用rnn自回归模型结构,自回归模型存在误差传播问题,导致生成的序列中积累了误差,错误逐渐扩大的技术问题;

41、(3)本发明采用序列注意力机制,解决了transformer只能捕获点和点之间相关性,无法获取序列和序列之间相关性的技术问题。

- 还没有人留言评论。精彩留言会获得点赞!