一种基于授权机制的本地化大模型保护方法及其系统

本发明涉及深度学习模型知识产权保护领域,尤其涉及一种基于授权机制的本地化大模型保护方法及其系统。

背景技术:

1、大语言模型(以下简称大模型)如chatgpt在各类任务上表现卓越,特别受到中小企业青睐,它们通过预训练学习广泛知识,允许企业在不大量投资的情况下,通过定制化改进来满足特定业务需求。然而,微调这些模型以适应特定领域时,存在隐私挑战:现有方案要求上传私有数据至供应商,无法完全保护数据隐私。此外,基于参数通信的方案虽可部分解决隐私问题,但因大模型的巨大参数量,无法支持全参微调,限制了其在垂直领域的应用,并且训练完成的模型留在供应商处,仍然存在使用过程中的隐私风险。

2、对企业而言,数据隐私至关重要,是企业的核心数字资产。为了充分保证在模型微调和后续使用过程中数据的隐私,企业需要在私域数据不出域的情况下进行模型微调和后续使用。这带来了大模型的本地化部署的需求。然而,从模型提供商的视角来看,大模型的训练成本高昂(gpt-3的训练成本约1200万美元),其价值不言而喻。确保基座模型的安全对他们至关重要,但是下游企业进行的必要微调和部署可能会带来安全风险。

3、模型水印作为一种最被广泛讨论的模型知识产权保护技术,能够帮助证明机器学习模型的所有权,但水印作为一种后验性措施,无法对模型进行主动保护。在模型本地化部署的场景下,模型可能被窃取并在未被发现的情况下被非法复制或滥用,由于缺乏实时监控和即时发现机制,损失可能会迅速扩大,给原始模型所有者带来重大的经济和知识产权风险。

4、有一些基于密钥的方案可以实现对模型的主动保护,防御者将模型设计为只有依赖于正确的密钥才可以正常运行。然而,这些工作不能将使用权与模型的所有权分开,也就是说,如果用户想要使用模型,他们必须获得代表模型所有权的密钥,提供者无法再有效地保护模型,这决定了这类方案不能够很好的应用于本地化大模型的场景。

5、可信执行环境(trusted execution environment,tee)是一种安全计算环境。它是一个隔离的、受保护的计算空间,确保在这个环境中运行的代码和数据不会被未经授权的实体访问、篡改或泄露。有些方案可以利用tee在模型推理之前对模型做授权,只有通过了授权的用户才可以正常的访问模型,从而保护了模型的知识产权。这类方案可以在本地化部署的过程中保护模型的知识产权。但是这类方法只能够保护训练好的模型,无法解决训练过程中模型的安全。

6、综上所述,对本地化部署的大模型的全生命周期保护的关键在于三个方面:1)实现对模型的主动保护,而不仅仅是验证其所有权。2)不仅保护经过训练的模型,还支持这些模型的微调,确保在整个微调过程中提供有效的保护。3)确保模型的使用权和所有权之间有明确的区别,允许用户访问和训练模型,而不允许他们窃取或滥用模型。

技术实现思路

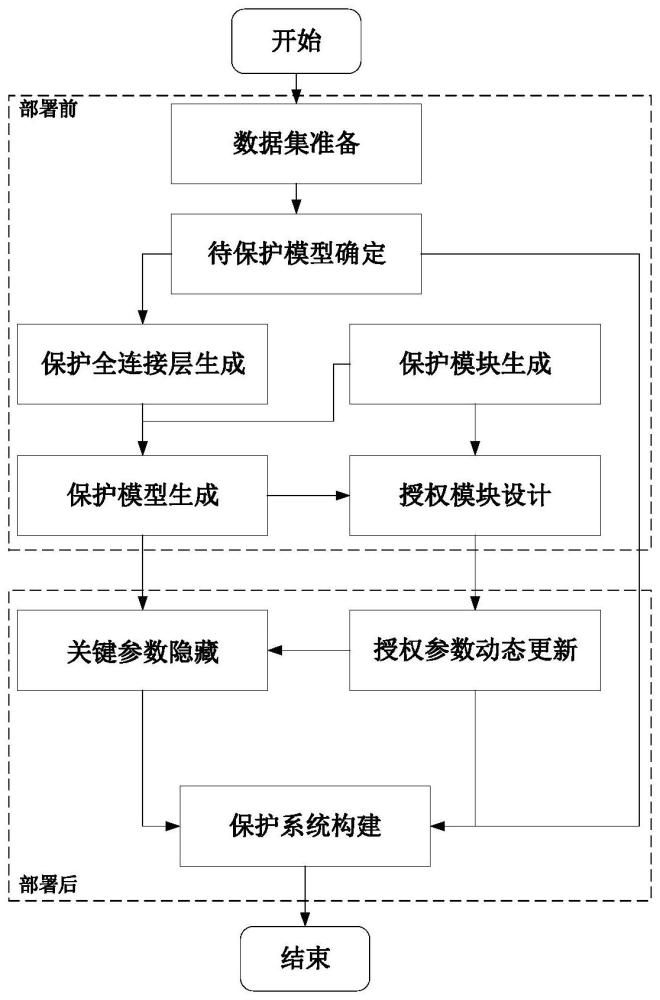

1、本发明针对现有技术的不足,提出了一种基于授权机制的本地化大模型保护方法及其系统。本发明采用授权机制做到了对模型使用权的隔离,起到了保护模型知识产权的作用。在授权使用的情况下,经过保护的模型可以和保护前的模型具有几乎相同的准确率,在未经过授权的情况下经过保护的模型准确率将会发生大幅度退化。本发明提出的保护方法在额外运算开销极小的情况下,实现了本地化大模型全生命周期保护。

2、为了实现上述目的,本发明采用的技术方案如下:

3、第一方面,本发明提出了一种基于授权机制的本地化大模型保护方法,包括以下步骤:

4、(1)确定待保护的大模型及其用于训练所述大模型的训练集;

5、(2)对待保护的大模型引入混淆因子以混淆真正的模型参数,并嵌入保护模块,生成本地化保护模型;

6、(3)根据所述本地化保护模型设计基于授权参数的授权模块,所述本地化保护模型在所述授权模块的授权情况下得到正确输出,在未授权情况下得到错误输出;

7、(4)利用所述训练集对本地化保护模型进行训练,梯度反向传播的过程中,可信执行环境接收后向的梯度后,先隐藏梯度中的混淆因子再向前传播,以更新本地化保护模型参数,所述授权模块同步更新授权参数。

8、进一步地,所述步骤(2)具体为:

9、(2.1)将待保护模型中的原始全连接层的乘法矩阵[w]和混淆因子α相乘,并为偏置项添加系数得到保护全连接层,将所述保护全连接层替换待保护模型中的原始全连接层,所述保护全连接层的运算表达式为:

10、

11、其中,[x1]表示输入向量,[b]表示原始全连接层的偏置,[y1]表示原始全连接层的输出;

12、(2.2)在所述保护全连接层之后嵌入保护模块,所述保护模块用于对所述保护全连接层的输出向量引入乘积元素β和矩阵元素[d],待保护模型中除全连接层之外的参数不变,生成保护模型;所述保护模型中全连接层的运算表达式为:

13、

14、进一步地,所述授权模块表示为:

15、

16、本地化保护模型在所述授权模块的授权情况下,输入向量[x1]首先经过授权模块处理后得到f([x1]),再将f([x1])输入保护模型中相对应的全连接层,得到正确输出:

17、

18、其中,表示授权模块中的乘积补偿项,[d][w]-1表示授权模块中的偏移补偿项,混淆因子α、乘积元素β和乘法矩阵[w]作为授权模块的授权参数。

19、进一步地,对本地化保护模型进行训练的过程中,在可信执行环境中同步更新所述授权模块中的授权参数[w],更新方法为:

20、从训练模型中接收当前的混淆后的模型参数α[w'],并根据可信执行环境中预先存储的混淆因子α计算获得真实的参数[w'],将[w']替换原来的授权参数[w]。

21、进一步地,所述授权模块、混淆因子部署在可信执行环境中。

22、进一步地,所述步骤(4)中可信执行环境接收后向的梯度后,将混淆因子视为单位值,实现隐藏梯度中的混淆因子的目的。

23、进一步地,待保护的大模型中不同的原始全连接层均引入混淆因子,训练过程中,混淆因子的数量级越高,学习率越高。

24、第二方面,本发明提出了一种用于实现上述方法的基于授权机制的本地化大模型保护系统,包括:

25、数据获取模块,其用于确定待保护的大模型及其用于训练所述大模型的训练集;

26、保护模型生成模块,其用于对待保护的大模型引入混淆因子以混淆真正的模型参数,并嵌入保护模块,生成本地化保护模型;

27、授权模块,其根据所述本地化保护模型并基于授权参数设计得到,所述本地化保护模型在所述授权模块的授权情况下得到正确输出,在未授权情况下得到错误输出;

28、关键参数隐藏模块,其用于在利用所述训练集对本地化保护模型进行训练的梯度反向传播过程中,接收后向的梯度并隐藏梯度中的混淆因子,再向前传播以更新本地化保护模型参数;

29、密钥更新模块,其用于在更新本地化保护模型参数的过程中,同步更新授权参数。

30、进一步地,所述授权模块、关键参数隐藏模块、密钥更新模块、混淆因子部署在可信执行环境中。

31、进一步地,所述保护模型生成模块包括:

32、模型参数混淆单元,其用于将待保护模型中的原始全连接层的乘法矩阵[w]和混淆因子α相乘,并为偏置项添加系数得到保护全连接层,将所述保护全连接层替换待保护模型中的原始全连接层;

33、保护模块,其嵌入在所述保护全连接层之后,所述保护模块用于对所述保护全连接层的输出向量引入乘积元素β和矩阵元素[d],待保护模型中除全连接层之外的参数不变,生成保护模型。

34、与现有技术相比,本发明的有益效果如下:

35、(1)本发明提出的一套授权机制,可实现对本地化部署的大模型进行微调和后续使用全生命周期的主动保护。

36、(2)本发明的授权模块所需的参数将随着模型参数的更新而调整,利用可信执行环境实现反向传播过程中授权参数梯度的隐藏,确保了微调过程的有效保护;由于在微调过程中对模型的保护不涉及参数通信或加密,产生的额外开销与模型参数更新规模以及微调方式无关,这确保了本发明能够支持全参微调,为模型的定制化来说更加具有实用性。

37、(3)本发明利用可信执行环境很好的保障了系统的鲁棒性,对模型的额外开销非常的小,具有很广阔的应用前景。

- 还没有人留言评论。精彩留言会获得点赞!