一种基于自适应位置编码和知识推理的文本标题生成方法

本发明涉及文本修改,具体是一种基于自适应位置编码和知识推理的文本标题生成方法。

背景技术:

1、文本摘要任务旨在从大量的文本中自动生成简洁准确的摘要,为人们快速获取信息提供便利。文本摘要方法根据产生方式不同可分为抽取式摘要方法和生成式摘要方法,标题生成是文本摘要任务下的一种。抽取式摘要方法基于特定规则抽取原文中重要的前几个句子组合形成摘要,其优点在于较强的可读性和信息准确性,但因其摘要句均来自于原文本,导致离散的摘要句之间连贯性较差,在一定程度上限制了内容的覆盖性,从而导致指代缺失等问题。生成式摘要方法将摘要任务视为序列到序列的生成任务,生成的摘要不局限于原文的原句,其优点在于灵活性更高,更符合人类的写作习惯,且对文本生成的长度、详略程度等方面可控性高[i],因此该方法适用于标题生成任务,但连贯性欠佳,可读性较差,实施难度相较抽取式摘要方法更大。

2、近年来,预训练技术在自然语言处理的研究中取得了了重要突破,也使得文本摘要任务性能有了大幅提升ii]。预训练技术使模型学习了丰富的语言知识和语义表示。运用了预训练技术的大语言模型,现有的文本摘要生成任务大多基于传统的循环神经网络(recurrent neural network,rnn),但在处理长序列时存在信息衰减和梯度消失问题,限制了其对长文本的建模能力。

3、然而,传统的transformer模型缺乏对位置的感知能力,尽管一些方法尝试通过显式编码的绝对位置信息或相对位置信息来解决这个问题,但由于其位置编码的长度和值是固定不变的,无法动态适应不同长度的序列,导致现有模型泛化能力较弱、无法较好捕捉不同位置的语义信息。

技术实现思路

1、本发明的目的在于提供一种基于自适应位置编码和知识推理的文本标题生成方法,以解决背景技术中的问题。

2、为实现上述目的,本发明提供如下技术方案:

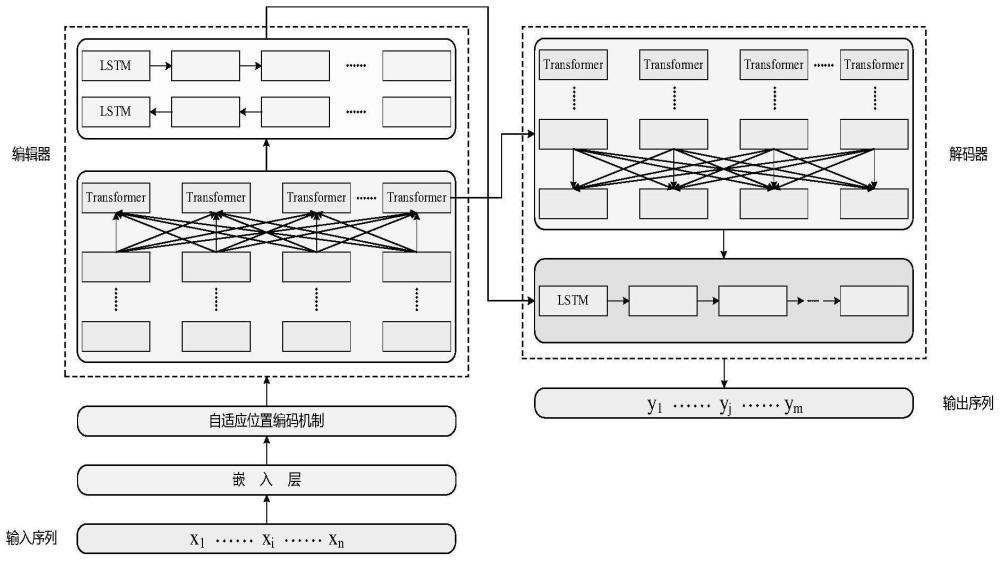

3、一种基于自适应位置编码和知识推理的文本标题生成方法,包括以下步骤:

4、步骤一:任务建模:

5、面向中文单文本的标题生成任务可形式化表示如下:给定中文单文本x={x1,...,xi,...,xn},要求模型自动生成面向该文本核心内容的准确连贯的标题y={y1,...,yj,...,ym};其中,xi和yi分别表示原文x、标题y中出现的词语,n和m分别表示原文长度和生成的标题长度(n>m);

6、步骤二:通过自适应位置编码机制获取自适应的位置表示;

7、步骤三:通过全局编码器负责提取原文语义信息;

8、步骤四:通过局部编码器对上述获取的语义信息进一步筛选获得高质量的上下文语义向量并将其传入解码器;

9、步骤五:本文采用改进transformer和单向lstm解码器作为生成式标题的混合解码模块;

10、步骤六:通过知识推理模块利用获得的语义向量引入义原知识约束标题的生成。

11、在上述技术方案的基础上,本发明还提供以下可选技术方案:

12、在一种可选方案中:全局编码器旨在挖掘全文所包含的语义信息,对于输入的单词序列w=(w1,...,wi,...,wn),嵌入层将其转化为对应的词嵌入表达式其中,d为嵌入层的维度;在获得e后,使用自适应位置编码机制添加位置嵌入。

13、在一种可选方案中:双向长短时记忆网络(bi-lstm)通过同时处理正向和反向的输入序列,捕捉当前时间步的前后上下文关系,提供了更全面和丰富的局部特征表示;为了丰富序列的语义表示能力,强化基于知识推理的生成器,tran-a-sdlm通过将transformer的输出结果送入到bi-lstm模型中来得到经过增强的语义向量获取更好的局部特征提取能力;

14、在获取全局语义向量hl后,局部编码器对该语义向量进一步编码,使模型关注局部上下文信息,更好地捕捉到序列中的语义特征;利用bi-lstm对hl进行编码,前向循环网络正向读取hl并计算前向隐藏层状态而后向循环网络逆向读取hl并计算后向隐藏层状态计算过程如式(3)、式(4)所示;

15、

16、

17、其中,和分别表示前向lstm和后向lstm网络,表示i时刻的输入;则i时刻的隐藏层状态是前向和后向编码向量的拼接;

18、

19、在一种可选方案中:改进后transformer解码器的特点在于采用多头自注意力机制和自适应位置编码机制帮助模型更好地捕捉输入序列的位置信息,增强模型的语义能力和泛化能力;单向lstm解码器能够捕捉长期依赖关系,通过使用门控机制来控制信息的流动,从而保留和更新关键信息,这使得lstm解码器能够更好地处理长序列的输入和输出,生成可变长度的输出序列,进一步提纯信息,约束知识推理模块生成的标题更加精确且冗余较少。

20、在一种可选方案中:transformer模型在解码状态下通过掩码多头自注意力对目标摘要进行编码,得到向量再计算编码器与解码器之间的多头注意力,最后经过全连接前馈网络和层归一化得到最终的隐藏状态计算过程如式(6)、式(7)、式(8)所示;

21、

22、

23、

24、其中,multihead*(·)表示掩码多头自注意力操作;第一层解码层的输入为其中,eg为已生成词的词嵌入和位置编码的向量和;其余层的输入为表示第1-1层解码层的输出;

25、

26、将transformer的输出送入单向lstm网络,生成t时刻的输出向量pt,如式(9)所示;

27、pt=tanh(wc[st;ct]+bc) (9)

28、其中,wc、bc为可训练参数,tanh(·)为激活函数,pt由隐状态向量st和上下文向量ct计算获得,[.;.]表示将两个向量按照某一维度拼接,st和ct的具体计算过程如式(10)~式(13)所示;

29、

30、

31、

32、st=lstm(wt-1,st-1,ct) (13)

33、其中,式(10)中wa、ba为可训练参数;式(11)利用softmax(·)函数计算归一化的注意力权重αt,i;式(12)利用注意力权重矩阵对输入序列的隐藏层状态进行加权求和操作获得;式(13)由t-1时刻目标词的词嵌入向量wt-1、隐状态向量st-1和上下文向量ct生成。

34、在一种可选方案中:知识推理模块中采用基于义原驱动的语言模型(sememe-driven language model,sdlm)推理,将句子中的每个词利用最小的语义单位——义原来表示,同时利用义原信息来预测下一个词出现的概率;该模块首先估计给定文本的上下文语义分布;然后,它将每个义原视为一个语义专家,这些专家共同打分得出最可能的义项和对应的单词。

35、相较于现有技术,本发明的有益效果如下:

36、1、本发明提出了一种基于transformer自适应位置编码和知识推理的生成式标题方法,该方法引入了视觉识别任务的自位置编码技术来帮助模型更好地捕捉不同位置的语义信息。同时利用上下文的义原知识以知识推理的方式优化标题生成模型的生成模块,使模型在标题生成的过程中可利用句子中的每个词的义原信息,提高了模型性能和可解释性。

37、2.基于所提出的方法实现了原型工具,并在lcsts数据集上进行了实验,实验结果表明tran-a-sdlm在rouge-1、rougr2和rouge-l多个指标上均有所提升,证明了本文所提方法的有效性,同时体现了自适应位置编码机制结合知识推理策略对生成式标题效果的提升作用。

- 还没有人留言评论。精彩留言会获得点赞!