一种面向智能制造故障诊断的域适应性信息瓶颈联邦学习方法

本发明涉及一种信息瓶颈联邦学习方法,专门设计用于智能制造领域中的高精度故障诊断。该方法针对存在域漂移数据的智能制造环境,利用信息瓶颈原理对各生产线的客户端的数据表征进行压缩和提取,从而有效地识别和分析故障。通过学习不同客户端间的不变特征,本发明能够显著提高全局模型在故障诊断任务中的预测精度。特别是在处理不同客户端数据分布差异较大时,本方法能有效克服由于域漂移引起的学习难题,实现对关键故障信息的准确提取。这不仅提升了故障诊断的准确性,也为智能制造领域中的分布式协同故障诊断提供了强大的技术支持。

背景技术:

1、在智能制造领域,特别是在故障诊断应用中,不同生产线(客户端)生成的数据通常具有不同的分布特征,这种现象被称为数据域漂移。这一问题在分布式制造系统中尤为突出,对基于机器学习的预测模型,如故障类型识别和生产质量控制,产生显著的负面影响。数据域漂移作为一种普遍存在的问题会极大地影响分布式建模的模型预测精度。在工业分布式建模中,联邦学习是一种常用的分布式机器学习框架,允许在数据源位置进行模型训练,能够有效地利用多个客户端的数据进行联合建模。然而,现有的联邦学习方法往往未能充分考虑域漂移的问题,导致模型的预测精度较低。为了解决这个问题,本发明提出了一种面向智能制造故障诊断的域适应信息瓶颈联邦学习算法。这种方法利用信息瓶颈原理来提取跨域数据的不变特征,从而使模型能够适应并克服数据的域漂移,提高模型的预测精度。因此,本发明的研究成果具有广阔的应用前景,能够从各客户端收集的数据中提取域不变特征,从而显著提高模型在故障诊断中的预测精度。

2、由于域漂移数据的问题,传统联邦学习方法对于故障诊断的精度较低,难以达到高效安全监测的要求。随着我国数字化的发展,来自不同工厂的大规模、不同域的数据需要通过联邦学习的方法为生产过程中的故障诊断进行协同建模。数据的域漂移问题,作为影响联邦学习模型性能的关键因素,严重制约着工厂之间联合故障诊断建模的效果。为了解决不同域漂移数据的联合建模,一些鲁棒的学习策略被提出。在分布式学习中,不同客户端被聚合的参数或者梯度常常是异质的。这种鲁棒的学习策略能够缓解客户端数据分布差异带来的影响,但是所学习的全局模型的表征能力难以得到保证。近些年来,针对域泛化的方法能够有效地学习域外泛化能力较强的模型,从而满足分布式学习中所学习模型泛化能力的要求。但是,此类方法常常要求在集中式的数据中进行学习。在多个域的数据分布在不同客户端的情况下域泛化方法难以很好地实现模型训练。因此,如何较好地利用不同域的故障数据在分布式的范式下提高模型的故障诊断预测精度在工业协同建模中仍然是一个悬而未决的问题,具有很强的现实意义。

3、本发明设计了一种面向智能制造故障诊断的域适应信息瓶颈联邦学习算法,旨在解决不同生产线间由于不同域数据分布差异所带来的建模挑战。该算法首先建立一个全局目标函数,该函数基于不同域特征信息瓶颈,考虑数据规模的多样性,对域的压缩表征进行重加权。通过联邦学习框架,实现了跨域不变特征的有效提取,从而提升全局模型的对于故障预测精度。在实际工业环境中,尤其是在面临不同生产线数据差异性时,该方法能有效克服全局模型表达能力受限故障预测精度较低的问题。

技术实现思路

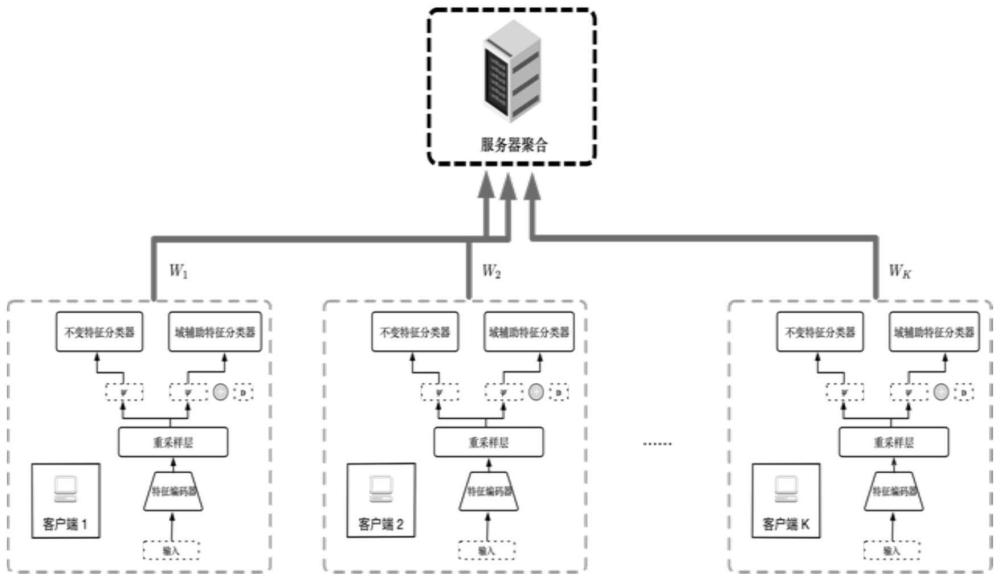

1、本发明获得一种面向智能制造故障诊断的域适应信息瓶颈联邦学习算法,该方法通过利用信息瓶颈提取不同客户端所属域的不变特征,实现模型对不同客户端特征的合理表征,提高模型的故障预测精度。该方法在智能制造故障诊断领域的联合建模中,能在不同生产线客户端数据分布差异较大的情况下,获得较高精度的全局模型。

2、本发明采用了如下的技术方案及实现步骤:

3、1.一种面向智能制造故障诊断的域适应性信息瓶颈联邦学习方法,其特征在于,包括以下步骤:

4、(1)初始化和分发全局模型

5、a)服务器使用取值范围为[0,1]的随机数初始化全局模型参数w;

6、b)服务器与不同生产线的客户端进行全局通信,将全局模型参数向量分发到各个生产线的客户端;

7、c)不同生产线的客户端接收全局模型参数向量,使用这些参数更新各自的本地模型参数,以满足各自的故障检测任务需求;

8、(2)客户端本地训练

9、a)生产线的客户端接收到全局模型参数向量,并且用全局模型参数向量w更新各自的本地模型;

10、b)客户端获取和预处理本地数据集;

11、①获取客户端所属生产线的分类图像数据集,数据集中包含p类故障图像;

12、②将所有样本分为两组,分别作为训练集和测试集;每个客户端所拥有的训练集表示为其中表示为第k个客户端的第i个故障图像特征和故障类型组成的样本对,为第k个的第i个样本的故障图像特征,为第k个客户端的第i个样本的标签,nk为第k个客户端的训练集样本数,第k个客户端的测试集样本数表示为uk;全部k个客户端的数据集总和为n,即n=∑nk;训练集的样本与测试集的样本数的比例为4:1,训练集和测试集中包含的故障类别相同;

13、③将训练集和测试集中的故障图片特征xk的维度大小调整224×224;将调整之后故障图像特征进行归一化至[0,1],归一化的公式为

14、

15、其中为归一化后的图像特征,min(·)和max(·)分别表示取特征矩阵中的最小值和最大值;

16、c)构建并更新分类网络模型;

17、①构建以信息瓶颈深度学习网络为基础的分类网络:信息瓶颈深度学习网络一共包括4个部分:首先,第一部份为特征编码器部分,它由一个resnet-18网络和1个编码器构成,处理的是尺寸为224×224像素、具有3个彩色通道的预处理故障图像特征;resnet-18网络由17个卷积层和1个全连接层依次连接而成,第1个卷积层的核大小为7×7,通道数为64,步幅为2,第1个卷积层通过全局最大池化运算与后续的卷积层链接,然后为第2个卷积层和第17个卷积层依次相连,每个卷积层的核大小均为3×3,步幅为1,这16个卷积层中,第2个到第5个卷积层的通道数为64,第6个到第9个卷积层的通道数为128,第10个到第13个卷积层的通道数为256,而第14个到第17个卷积层的通道数为512,最后第17个卷积层通过全局平均池化运算与一个输入维度为512、输出维度为1000的全连接层相连接,编码器由一个两层的多层感知机构成,输入维度为1000,输出维度为512;接下来,第二部分是重采样层,包含1个均值线性全连接和1个方差线性全连接层,输入和输出维度均为512;第三部分是不变特征分类器,由1个线性全连接层构成,输入维度为512,输出维度为p,即为p类故障的概率;最后,第四部分是域辅助特征分类器,也是由1个线性全连接层构成,但输入维度为513,输出维度为p;

18、②将接收到的模型参数向量更新本地模型:利用模型参数向量中对应部分的参数对本地模型中的参数进行更新;

19、d)训练信息瓶颈分类网络模型;

20、训练信息瓶颈分类网络模型分为两个阶段,分别为前向传播阶段和后向传播阶段;

21、前向传播阶段将第k个客户端的本地故障数据集的nk个故障样本按批次样本数s随机划分为多个特征批次,第k个客户端的第t个特征批次表示为将特征批次依次送入分类网络模型中,经过特征编码器,重采样层,不变特征分类器和域辅助特征分类器,每个批次数据的训练过程如下其过程如下:

22、i.将第k个客户端的第t批次的特征批次输入特征编码器,得到提取的表征z,维度为s×512;

23、ii.将提取的表征z输入重采样层,得到第k个客户端的均值向量vk和方差向量mk,vk和mk的维度为s×512;

24、iii.通过vk和mk进行重参数化,得到压缩表征ψk,ψk的维度为s×512,其中重参数化的公式为:

25、

26、其中rand(·)为随机抽样的函数选取[0,1]范围内的随机数,e(·)为指数函数;

27、iv.将压缩表征ψk输入不变特征分类器,得到向量向量为第k个客户端第t个特征批次的故障预测结果,维度为s×p;

28、v.将压缩表征ψk与域标签k在第一个维度上进行拼接,输入域辅助分类器,得到向量向量为第k个客户端第t个批次的辅助向量,维度为s×p;

29、后向传播阶段为计算信息瓶颈目标损失函数对于参数的梯度,对分类网络模型参数进行更新,其中信息瓶颈目标损失函数表示为:

30、

31、其中为第k个客户端第t个批次的模型参数,λ为调节因子,取值为0.01,为第k个客户端的第t批次的特征批次;

32、在式(3)中,为域专用损失函数,其计算公式为:

33、

34、其中和分别为第k个客户端的第s个样本经过特征编码层和重采样层之后输出的均值向量和方差向量,n为所有客户端的训练样本总数,s为一个批次中的所包含的样本数,nk为第k个客户端中的训练样本数;

35、在式(3)中,linv为不变特征分类器损失函数,其计算公式为:

36、

37、其中为第k个客户端的第s个样本的输出,lg(·)为底数为10的对数函数,s为一个批次中的所包含的样本数;

38、在式(3)中,ld为域辅助分类器损失函数,其计算公式为:

39、

40、其中为第k个客户端的第s个样本的辅助向量,lg(·)为底数为10的对数函数,s为一个批次中的所包含的样本数;

41、使用梯度下降算法通过信息瓶颈目标损失函数计算模型参数的梯度,并且更新分类网络模型参数,参数更新的表达式如下所示:

42、

43、其中ηt为第t个批次的梯度下降的学习率,取值范围为0.01~0.001,为第k个客户端第t+1个批次时的模型参数,为第k个客户端第t个批次时的模型参数,fk(·)为第k个客户端的信息瓶颈损失函数,为信息瓶颈损失函数对于参数所求的梯度;

44、e)得到基于信息瓶颈的分类网络模型;

45、将测试集中的样本输入分类网络模型;第i个样本首先输入特征编码器得到提取的表征z;表征z输入重采样层得到提取的均值向量vk和方差向量mk;均值向量和方差向量通过公式(2)重参数化得到压缩表征ψk;将ψk输入不变特征分类器得到预测的第i个样本的故障类别概率

46、f)上传更新的分类网络模型;

47、将训练后的故障分类网络模型以模型参数向量的形式上传到服务器;

48、(3)服务器聚合客户端模型

49、a)等待所有生产线的客户端训练完成,并且收集所有客户端发送的模型参数向量;

50、b)聚合所有客户端上传的本地模型参数向量,得到更新的全局模型参数,其中聚合模型参数的公式为:

51、

52、其中k表示客户端的数量,nk表示第k个客户端的训练集样本,wk表示第k个客户端的模型参数向量,w表示全局模型参数向量,n表示所有的k个客户端的训练集样本总数;

53、c)将更新的全局模型参数向量发送到所有客户端;

54、(4)全局协同迭代训练

55、服务器和不同生产线的客户端进行协同训练,重复步骤(2)-(3)直到全局迭代次数h达到预定的迭代次数h,h的取值为100;

56、(5)获取和使用最优全局模型

57、a)服务器将最优全局模型参数向量广播至所有生产线的客户端;

58、b)客户端使用收到的模型参数向量更新本地模型得到最终故障分类网络模型;

59、c)客户端使用最终故障分类网络模型对所属生产线的故障图像数据进行分类。

- 还没有人留言评论。精彩留言会获得点赞!