多媒体信息的播放控制方法及相关设备与流程

1.本公开涉及计算机和通信技术领域,具体而言,涉及一种多媒体信息的播放控制方法及装置、计算机可读存储介质、电子设备。

背景技术:

2.相关技术中,在多媒体信息例如视频的编辑过程中至少存在以下问题:

3.第一,当需要对该多媒体信息添加描述信息例如解说与弹幕时,一般采用人工解说与输入弹幕,人工解说与输入弹幕需要耗费较多的人力资源,效率低,添加速度慢,且容易出现人为差错。

4.第二,当需要剪辑出该多媒体信息中的精彩片段时,难以准确定位出所有精彩片段,导致剪辑出来的精彩时刻中混入背景时刻,或者漏剪精彩部分。

5.因此,需要一种新的多媒体信息的播放控制方法及装置、计算机可读存储介质、电子设备。

6.需要说明的是,在上述背景技术部分公开的信息仅用于加强对本公开的背景的理解。

技术实现要素:

7.本公开实施例提供一种多媒体信息的播放控制方法及装置、计算机可读存储介质、电子设备,能够解决上述相关技术中存在的难以自动准确定位出精彩片段且无法自动对精彩片段匹配描述信息的技术问题。

8.本公开的其他特性和优点将通过下面的详细描述变得显然,或部分地通过本公开的实践而习得。

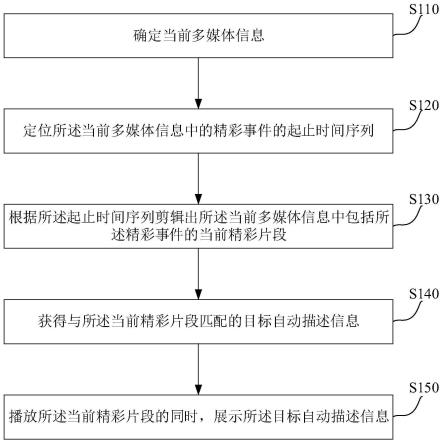

9.本公开实施例提供一种多媒体信息的播放控制方法,所述方法包括:确定当前多媒体信息;定位所述当前多媒体信息中的精彩事件的起止时间序列;根据所述起止时间序列剪辑出所述当前多媒体信息中包括所述精彩事件的当前精彩片段;获得与所述当前精彩片段匹配的目标自动描述信息,所述目标自动描述信息包括所述当前精彩片段的多维度标签识别结果;播放所述当前精彩片段的同时,展示所述目标自动描述信息。

10.本公开实施例提供一种多媒体信息的播放控制装置,所述装置包括:多媒体信息确定单元,用于确定当前多媒体信息;起止时间序列定位单元,用于定位所述当前多媒体信息中的精彩事件的起止时间序列;当前精彩片段剪辑单元,用于根据所述起止时间序列剪辑出所述当前多媒体信息中包括所述精彩事件的当前精彩片段;自动描述信息获得单元,用于获得与所述当前精彩片段匹配的目标自动描述信息,所述目标自动描述信息包括所述当前精彩片段的多维度标签识别结果;片段描述同时播放单元,用于播放所述当前精彩片段的同时,展示所述目标自动描述信息。

11.本公开实施例提供了一种计算机可读存储介质,其上存储有计算机程序,所述程序被处理器执行时实现如上述实施例中所述的多媒体信息的播放控制方法。

12.本公开实施例提供了一种电子设备,包括:至少一个处理器;存储装置,配置为存储至少一个程序,当所述至少一个程序被所述至少一个处理器执行时,使得所述至少一个处理器实现如上述实施例中所述的多媒体信息的播放控制方法。

13.在本公开的一些实施例所提供的技术方案中,一方面,通过定位当前多媒体信息中的精彩事件的起止时间序列,能够准确剪辑出当前多媒体信息中的全部当前精彩片段;另一方面,还能够自动生成与每个当前精彩片段匹配的目标自动描述信息,并在该目标自动描述信息中包括了各个当前精彩片段的多维度标签识别结果。在实际业务场景中可以替代人工剪辑当前多媒体信息例如视频与编辑解说和弹幕,节约大量的人工成本并减少人为误差。

14.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

附图说明

15.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。显而易见地,下面描述中的附图仅仅是本公开的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。在附图中:

16.图1示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程图。

17.图2示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程图。

18.图3示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。

19.图4示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。

20.图5示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。

21.图6示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。

22.图7示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的示意图。

23.图8示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的界面示意图。

24.图9示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的界面示意图。

25.图10示意性示出了根据本公开的一实施例的多媒体信息的播放控制装置的框图。

26.图11示出了适于用来实现本公开实施例的电子设备的结构示意图。

具体实施方式

27.现在将参考附图更全面地描述示例实施例。然而,示例实施例能够以多种形式实施,且不应被理解为限于在此阐述的实施例;相反,提供这些实施例使得本公开将全面和完整,并将示例实施例的构思全面地传达给本领域的技术人员。在图中相同的附图标记表示相同或类似的部分,因而将省略对它们的重复描述。

28.本公开所描述的特征、结构或特性可以以任何合适的方式结合在一个或更多实施方式中。在下面的描述中,提供许多具体细节从而给出对本公开的实施方式的充分理解。然而,本领域技术人员将意识到,可以实践本公开的技术方案而省略特定细节中的一个或更多,或者可以采用其它的方法、组元、装置、步骤等。在其它情况下,不详细示出或描述公知方法、装置、实现或者操作以避免模糊本公开的各方面。

29.附图仅为本公开的示意性图解,图中相同的附图标记表示相同或类似的部分,因而将省略对它们的重复描述。附图中所示的一些方框图不一定必须与物理或逻辑上独立的实体相对应。可以采用软件形式来实现这些功能实体,或在至少一个硬件模块或集成电路中实现这些功能实体,或在不同网络和/或处理器装置和/或微控制器装置中实现这些功能实体。

30.附图中所示的流程图仅是示例性说明,不是必须包括所有的内容和步骤,也不是必须按所描述的顺序执行。例如,有的步骤还可以分解,而有的步骤可以合并或部分合并,因此实际执行的顺序有可能根据实际情况改变。

31.本说明书中,用语“一个”、“一”、“该”、“所述”和“至少一个”用以表示存在至少一个要素/组成部分/等;用语“包含”、“包括”和“具有”用以表示开放式的包括在内的意思并且是指除了列出的要素/组成部分/等之外还可存在另外的要素/组成部分/等;用语“第一”、“第二”和“第三”等仅作为标记使用,不是对其对象的数量限制。

32.下面结合附图对本公开示例实施方式进行详细说明。

33.基于上述相关技术中存在的技术问题,本公开实施例提出了一种多媒体信息的播放控制方法,以用于至少部分解决上述问题。本公开各实施例提供的方法可以由任意的电子设备来执行,例如服务器,或者终端,或者服务器与终端之间进行交互,本公开对此不做限定。

34.本公开实施例中的服务器可以是独立的服务器,也可以是多个服务器构成的服务器集群或者分布式系统,还可以是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、cdn(content delivery network,内容分发网络)、以及大数据和人工智能平台等基础云计算服务的云服务器。

35.本公开实施例中的终端为可以进行多媒体播放的终端,例如可以是个人电脑(personal computer,pc)、平板电脑、个人数字助理(personaldigitalassistant,pda)、笔记本和手机等终端设备,还可以包括各种便携式、袖珍式、手持式、计算机内置的或者车载的移动装置。

36.图1示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程图。如图1所示,本公开实施例提供的方法可以包括以下步骤。

37.在步骤s110中,确定当前多媒体信息。

38.本公开实施例中,媒体是指承载和传输某种信息或物质的载体。在计算机领域中,

媒体主要是传输和存储信息的载体,其中传输的信息包括语音、文字、数据、视频、音频等。存储信息的载体包括硬盘、软盘、磁带、磁盘、光盘等。当前多媒体信息是把各种媒体的功能进行整合,在交互式界面上以文字材料、影像、音频及视频等形式展示,提供多种形式的多样化信息的展现。

39.在下面的举例说明中,以当前多媒体信息为虚拟游戏为例进行举例说明,但本公开并不限定于此。本公开实施例提供的方法可以通过多种形式应用于虚拟游戏的视频剪辑方案中。以web(网络)接口为例,用户可以通过终端上传一段虚拟游戏的视频或者虚拟游戏的视频url(uniformresource locator,统一资源定位符),web接口将该虚拟游戏的视频传输给服务器。

40.在步骤s120中,定位所述当前多媒体信息中的精彩事件的起止时间序列。

41.本公开实施例中,精彩事件是指当前多媒体信息中出现的一些相比该当前多媒体信息中的大部分事件具有超常表现的事件,让用户能够产生出乎意料感觉的事件。在不同的应用场景中,精彩事件可以有不同的设置。例如若当前多媒体信息为音乐,则精彩事件可以是该音乐中的歌唱高潮部分,让听众能够产生被打动感觉的歌词部分。再例如若当前多媒体信息为电影,则精彩事件可以是该电影中让人悲伤、兴奋、高兴等的视频片段。再例如若当前多媒体信息为虚拟游戏的视频,则精彩事件可以是该虚拟游戏的视频中让人感觉兴奋的视频片段,例如团战、击败人、逃生等精彩画面。当前多媒体信息中包括精彩事件的画面称之为精彩画面,其对应的时刻称之为精彩时刻;不包括精彩事件的画面称之为非精彩画面或者背景画面,其对应的时刻称之为背景时刻或者非精彩时刻。

42.起止时间是指精彩事件发生的起始时间和结束时间,起止时间序列是指多个精彩事件的起止时间按照时间顺序排列形成的序列。定位所述当前多媒体信息中的精彩事件的起止时间序列的实现方式可以参照下图2实施例的描述。

43.在步骤s130中,根据所述起止时间序列剪辑出所述当前多媒体信息中包括所述精彩事件的当前精彩片段。

44.当确定了当前多媒体信息中的每个精彩事件的起始时间和结束时间后,从可以据此从当前多媒体信息中剪辑出包括每个精彩事件的每个当前精彩片段。

45.在步骤s140中,获得与所述当前精彩片段匹配的目标自动描述信息,所述目标自动描述信息包括所述当前精彩片段的多维度标签识别结果。

46.本公开实施例中,描述信息是指用于描述当前精彩片段的语音、文字、图片等任意形式的信息。自动描述信息是指该描述信息是服务器或者终端自动生成的,而非用户手动输入或者添加的。目标自动描述信息是指与当前精彩片段中的精彩事件相匹配、内容上具有关联性的自动描述信息。

47.在步骤s150中,播放所述当前精彩片段的同时,展示所述目标自动描述信息。

48.本公开实施例中,终端上可以按照有多媒体客户端,多媒体客户端是主要用于多媒体播放处理的客户端,例如视频客户端和音乐播放器等,客户端可以是第三方应用程序。在一些实施例中,终端可以通过多媒体客户端播放当前多媒体信息,并在播放到当前精彩片段的同时,展示相应的目标自动描述信息。可以理解的是,终端也可以通过网页播放当前多媒体信息,并在播放到当前精彩片段的同时,展示相应的目标自动描述信息。

49.以当前多媒体信息为虚拟游戏的视频为例,该虚拟游戏的视频可以包括直播平台

的游戏直播视频,此时多媒体客户端可以为播放游戏直播视频的客户端,比如游戏客户端。

50.本公开实施方式提供的多媒体信息的播放控制方法,一方面,通过定位当前多媒体信息中的精彩事件的起止时间序列,能够准确剪辑出当前多媒体信息中的全部当前精彩片段;另一方面,还能够自动生成与每个当前精彩片段匹配的目标自动描述信息。在实际业务场景中可以替代人工剪辑当前多媒体信息例如视频与编辑解说和弹幕,节约大量的人工成本并减少人为误差。

51.图2示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程图。如图2所示,本公开实施例提供的方法可以包括以下步骤。

52.图2实施例中的步骤s110可以参照上述图1实施例。

53.在步骤s120中,定位所述当前多媒体信息中的精彩事件的起止时间序列。图2实施例中,步骤s120可以进一步包括步骤s121-步骤s124。

54.在步骤s121中,获得所述当前多媒体信息的当前视频特征矩阵。

55.获得所述当前多媒体信息的当前视频特征矩阵的方式可以参照下图4 实施例。

56.在步骤s122中,获得所述当前多媒体信息的当前音频特征矩阵。

57.其中,获得所述当前多媒体信息的当前音频特征矩阵,可以包括:从所述当前多媒体信息中抽取当前音频文件;按预定长度滑窗提取所述当前音频文件中的当前音频序列;将所述当前音频序列中的当前音频依次输入至音频特征编码模型中,提取各当前音频的音频特征向量;按照时间序列拼接各当前音频的音频特征向量,获得所述当前多媒体信息的当前音频特征矩阵。

58.本公开实施例中,可以从当前多媒体信息例如虚拟游戏的视频中抽取当前音频文件(假设时长为t秒,t为大于或等于1的正整数,若实际的当前音频文件的时长不足整数秒,可以对其进行补齐),以预定长度滑窗 (例如1秒,但本公开并不限定于此)提取当前音频序列(包括t个当前音频),将这t个当前音频依次输入到音频特征编码模型,用于提取各当前音频的音频特征向量,将各当前音频的音频特征向量(维度假设为m, m为大于或等于1的正整数)组成的序列在时间维度上拼接成时序特征矩阵,代表该虚拟游戏的视频的当前音频特征矩阵(维度为t*m)。

59.本公开实施例中,音频特征编码模型是指用于将输入的音频文件编码成音频特征向量的神经网络。在下面的举例说明中,采用在audioset公开数据集上训练好的vggish网络作为音频特征编码模型,但本公开并不限定于此。

60.其中,audioset是一个标记的视频音轨组成的数据集,其标签来自多个音频事件类的本体。vggish网络是在audioset公开数据集上预训练得到的vgg(visual geometry group,计算机视觉组)模型。vggish支持从音频波形中提取具有语义的128维embedding(嵌入式)特征向量。即 m=128,将每个预定长度滑窗的当前音频输入至vggish网络,将vggish 网络的全连接层输出的t个128维的音频特征向量进行拼接,作为当前音频特征矩阵。

61.在步骤s123中,拼接所述当前视频特征矩阵和所述当前音频特征矩阵,获得所述当前多媒体信息的当前融合特征矩阵。

62.在步骤s124中,将所述当前融合特征矩阵输入至精彩片段时序定位模型中,确定所述当前多媒体信息中的精彩事件的起止时间序列。

63.本公开实施例中,精彩片段时序定位模型是指用于定位精彩事件发生的开始与结

束时刻的网络。精彩片段时序定位模型的生成方式可以参照下图3实施例的描述。

64.图2实施例中的步骤s130-步骤s150可以参照上述图1实施例。

65.本公开实施方式提供的多媒体信息的播放控制方法,一方面,可以融合当前多媒体信息的当前视频特征矩阵和当前音频特征矩阵获得当前融合特征矩阵,并利用精彩片段时序定位模型处理该当前融合特征矩阵来自动定位当前多媒体信息中的精彩事件的起止时间序列,能够实现当前精彩片段定位的自动化、智能化,并能够提高定位的准确性和定位效率。

66.图3示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。如图3所示,与上述图2实施例的不同之处在于,在步骤s110之前,还可以进一步包括以下步骤s310-步骤s360,以用于训练获得精彩片段时序定位模型。

67.在步骤s310中,获得训练视频及所述训练视频中的精彩事件的标注起止时间对。

68.在数据标注阶段,可以将获得的全部视频样本划分为训练集和测试集,例如假设有100个视频样本,将其中80个划分至训练集,其中20个划分至测试集。将训练集中的视频样本称之为训练视频,将测试集中的视频样本称之为测试视频。对训练集中每个训练视频中出现的全部精彩事件(highlight),标注每个highlight发生的起始时间和结束时间,作为标注起止时间对。类似的,对测试集中每个测试视频中出现的全部精彩事件 (highlight),标注每个highlight发生的起始时间和结束时间,作为标注起止时间对。测试集可以用于验证训练集的训练效果。

69.在步骤s320中,获得所述训练视频的训练视频特征矩阵。

70.在数据整理阶段,将全部训练视频与测试视频以固定频率(例如1fps (frame per second,每秒帧数))进行抽帧,获得训练视频帧序列,将训练视频帧序列中的训练视频帧依次输入到视频特征编码模型,得到每个训练视频的训练视频特征矩阵。本公开实施例中的当前视频特征矩阵和训练视频特征矩阵均可以采用rgb特征矩阵,但本公开并不限定于此。

71.获得训练视频的训练视频特征矩阵的具体方式可以参照下图4实施例。

72.在步骤s330中,获得所述训练视频的训练音频特征矩阵。

73.其中,获得所述训练视频的训练音频特征矩阵,可以包括:从所述训练视频中抽取训练音频文件;按所述预定长度滑窗提取所述训练音频文件中的训练音频序列;将所述训练音频序列中的训练音频依次输入至音频特征编码模型中,提取各训练音频的音频特征向量;按照时间序列拼接各训练音频的音频特征向量,获得所述训练视频的训练音频特征矩阵。

74.例如,将全部训练视频与测试视频按照预定长度(例如1秒)滑窗抽取训练音频文件和测试音频文件。将每个预定长度滑窗的训练音频输入至 vggish网络,将vggish网络的全连接层输出的t个128维的音频特征向量进行拼接,作为训练音频特征矩阵。

75.在步骤s340中,拼接所述训练视频特征矩阵和所述训练音频特征矩阵,获得所述训练视频的训练融合特征矩阵。

76.将上述步骤s320获得的每个训练视频的训练视频特征矩阵和步骤 s330获得的训练音频特征矩阵进行拼接,获得每个训练视频的训练融合特征矩阵。

77.在步骤s350中,将所述训练融合特征矩阵输入至时序定位网络模型,获得所述训练视频中的精彩事件的预测起止时间对。

separable convolution(深度可分卷积),然后采用averagepooling(平均池化)将feature(特征)变成1x1,根据预测类别大小(这里为二分类)加上全连接层,最后是一个softmax层(称之为分类层)。将训练好的mobilenet除最后的softmax以外的其他结构作为视频特征编码模型。

94.在步骤s325中,按照时间顺序拼接所述视频特征编码模型输出的各训练视频帧的视频特征向量,获得所述训练视频的训练视频特征矩阵。

95.将上述训练过程中每个训练视频帧输入至该视频特征编码模型,该视频特征编码模型最后的全连接层输出的1280维的视频特征向量拼接作为对应训练视频的训练视频特征矩阵。例如,假设某个训练视频为100秒时长,按照1fps抽帧,将全部抽出的100帧训练视频帧的1280维视频特征向量拼接成100*1280的训练视频特征矩阵。

96.圆圈中的1代表省略了上述实施例中的步骤s330-s360和步骤s110。

97.在步骤s120中,定位所述当前多媒体信息中的精彩事件的起止时间序列。

98.在步骤s121中,获得所述当前多媒体信息的当前视频特征矩阵。在图 4实施例中,上述步骤s121可以进一步包括步骤s1211-步骤s1213。

99.在步骤s1211中,按视频抽帧率对所述当前多媒体信息进行抽帧,获得当前视频帧序列。

100.在步骤s1212中,将所述当前视频帧序列中的当前视频帧依次输入至视频特征编码模型中,提取各当前视频帧的视频特征向量。

101.本公开实施例中,视频特征编码模型是指用于将输入的视频帧序列 (包括当前视频帧序列和训练视频帧序列)例如rgb图像序列编码成视频特征向量的神经网络。

102.在步骤s1213中,按照时间顺序拼接各当前视频帧的视频特征向量,获得所述当前多媒体信息的当前视频特征矩阵。

103.按固定时间间隔(视频抽帧率例如为1秒)对当前多媒体信息例如虚拟游戏的视频(时长假设为t秒)进行抽帧,获得包括t帧当前视频帧的当前视频帧序列,将当前视频帧序列依次输入到视频特征编码模型,用于提取rgb特征,将rgb特征向量(维度n)作为视频特征向量形成序列,在时间维度上拼接成时序特征矩阵,代表该虚拟游戏的视频的rgb特征矩阵(即当前视频特征矩阵,维度为t*n)。

104.圆圈中的2代表省略了上述实施例中的步骤s122-步骤s124。

105.将上述获得的t*n维的当前视频特征矩阵和t*m维的当前音频特征矩阵进行融合拼接,拼接后获得的当前融合特征矩阵维度为t*(n+m)。将得到的当前融合特征矩阵输入到精彩片段时序定位模型,得到全部精彩事件发生的起止时间序列,并剪辑出当前精彩片段。

106.圆圈中的3代表省略了上述实施例中的步骤s130-步骤s150。

107.本公开实施方式提供的多媒体信息的播放控制方法,可以预先训练获得精彩背景图像二分类网络模型,然后剔除该精彩背景图像二分类网络模型中最后的softmax层作为视频特征编码模型,从而使得后续可以利用该视频特征编码模型输出当前多媒体信息的当前视频特征矩阵,可以实现视频特征的自动提取,提高视频特征提取的效率和智能化。

108.图5示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。如图5所示,本公开实施例提供的方法可以包括以下步骤。

109.图5实施例的步骤s110-步骤s130可以参照上述图1至图4实施例。

110.在步骤s140中,获得与所述当前精彩片段匹配的目标自动描述信息。在图5实施例中,上述步骤s140可以进一步包括以下步骤s141-步骤 s143。

111.在步骤s141中,利用多维度标签识别模型处理所述当前精彩片段,获得所述当前精彩片段的多维度标签识别结果。

112.相关技术中,缺少从多维度给出当前多媒体信息例如虚拟游戏的视频中的当前精彩片段的标签的能力。本公开实施例中的多维度标签识别模型可以使用多种图像分类网络来给出当前精彩片段中的精彩画面的多种维度标签,结合识别出的多种维度标签,可以自动生成准确的目标自动描述信息。

113.在步骤s142中,综合所述当前精彩片段的多维度标签识别结果,获得所述当前精彩片段的目标标签分类结果。

114.在步骤s143中,根据所述当前精彩片段的目标标签分类结果,获得与所述当前精彩片段匹配的目标自动描述信息。

115.在示例性实施例中,所述目标描述信息可以包括目标自动解说。其中,根据所述当前精彩片段的目标标签分类结果,获得与所述当前精彩片段匹配的目标自动描述信息,可以包括:获得解说模板;根据所述解说模板和所述目标标签分类结果,确定所述目标自动解说。

116.当用户利用终端查看新闻、观看视频、听音乐、玩网络游戏,或者观看电竞玩家在电竞比赛中的虚拟游戏的视频、体育比赛的直播视频、转播视频等,但是对于一些非专业用户在观看虚拟游戏的视频、体育比赛视频时,需要借助一定的解说才能更好地了解比赛形式,增强用户对比赛的理解等。本公开实施例中,可以使用算法自动定位出当前多媒体信息例如虚拟游戏的视频中的全部当前精彩片段,并对其发生的精彩事件进行文字、语音等至少一种形式的描述,称之为目标自动解说。

117.在示例性实施例中,所述目标描述信息可以包括目标自动弹幕。其中,根据所述当前精彩片段的目标标签分类结果,获得与所述当前精彩片段匹配的目标自动描述信息,可以包括:获得弹幕语料库,所述弹幕语料库包括每个标签分类结果及其对应的弹幕语料,所述标签分类结果包括所述目标标签分类结果;根据所述目标标签分类结果从所述弹幕语料库中匹配获得目标弹幕语料作为所述目标自动弹幕。

118.本公开实施例中,弹幕是指在网络上观看当前多媒体信息时弹出的评论性字幕,以实现在观看多媒体过程中的互动。例如,很多视频客户端 (也可以是音乐播放器、新闻客户端等)都提供评论功能,用户在线观看某个视频内容时,用户可以手动输入发表评论,该评论内容会在同时观看该相同视频的其他用户的视频窗口上显示,这样的评论可以称之为弹幕。而目标自动弹幕是指使用算法自动定位出当前多媒体信息中的当前精彩片段,对每个精彩片段自动生成的至少一句弹幕描述。

119.需要说明的是,目标自动描述信息不限于上述例举的目标自动解说和目标自动弹幕两种方式,且目标自动描述信息可以包括目标自动解说或者目标自动弹幕,或者同时包括目标自动解说和目标自动弹幕,在下面的举例说明中,以同时包括目标自动解说和目标自动弹幕为例进行举例说明。

120.图5实施例的步骤s150可以参照上述图1至图4实施例。

121.本公开实施方式提供的多媒体信息的播放控制方法,可以通过多维度标签识别模

型自动识别出当前精彩片段的多维度标签识别结果,根据该多维度标签识别结果可以获得当前精彩片段的目标标签分类结果,据此可以获得与该当前精彩片段匹配的目标自动描述信息,例如目标自动解说和/或目标自动弹幕,一方面,实现了解说和弹幕的自动生成;另一方面,基于多维度标签可以提高生成的解说和弹幕与当前精彩片段的关联度,使得解说和弹幕契合当前精彩片段中的精彩事件。

122.图6示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的流程示意图。本公开实施例中,以当前多媒体信息为虚拟游戏的视频为例,所述多维度标签识别模型可以包括英雄识别模型、团战规模识别模型、我方敌方人数识别模型、能量识别模型、越塔识别模型、闪现识别模型、播报文字识别模型和播报框颜色识别模型,所述多维度标签识别结果可以包括目标英雄、目标团战规模、目标我方敌方人数、目标能量、目标越塔识别结果、目标闪现识别结果、目标播报文字识别结果和目标播报框颜色识别结果。如图6所示,本公开实施例提供的方法可以包括以下步骤。

123.图6实施例中的圆圈中的4代表省略了上述图5实施例中的步骤s110

‑ꢀ

步骤s130。

124.在步骤s140中,获得与所述当前精彩片段匹配的目标自动描述信息。在图6实施例中,上述步骤s140可以进一步包括以下步骤s141-步骤 s143。

125.在步骤s141中,利用多维度标签识别模型处理所述当前精彩片段,获得所述当前精彩片段的多维度标签识别结果。在图6实施例中,上述步骤 s141可以进一步包括以下步骤s1411-步骤s1413。

126.在步骤s1411中,分别确定所述英雄识别模型、所述团战规模识别模型、所述我方敌方人数识别模型、所述能量识别模型、所述越塔识别模型、所述闪现识别模型、所述播报文字识别模型和所述播报框颜色识别模型的第一至第八抽帧率和第一至第八空间抠图区域。

127.在步骤s1412中,对所述当前精彩片段分别按照第一至第八抽帧率和第一至第八空间抠图区域抽帧,获得第一至第八当前图像帧序列。

128.本公开实施例中,将获得的当前精彩片段依次输入到多维度标签识别模型,这里假设多维度标签识别模型包括英雄识别模型、团战规模识别模型、我方敌方人数识别模型、能量识别模型、越塔识别模型、闪现识别模型、播报文字识别模型和播报框颜色识别模型这8个图像分类网络,对每个当前精彩片段按照不同的特定时间间隔(不同的抽帧率,将对应这8个图像分类网络的抽帧率分别定义为第一抽帧率、第二抽帧率、第三抽帧率、第四抽帧率、第五抽帧率、第六抽帧率、第七抽帧率和第八抽帧率),以及不同的特定空间位置(不同的空间抠图区域,将对应这8个图像分类网络的空间抠图区域分别定义为第一空间抠图区域、第二空间抠图区域、第三空间抠图区域、第四空间抠图区域、第五空间抠图区域、第六空间抠图区域、第七空间抠图区域和第八空间抠图区域)抽帧,获得第一当前图像帧序列、第二当前图像帧序列、第三当前图像帧序列、第四当前图像帧序列、第五当前图像帧序列、第六当前图像帧序列、第七当前图像帧序列和第八当前图像帧序列。

129.在步骤s1413中,将第一至第八当前图像帧序列中的当前图像帧分别输入至所述英雄识别模型、所述团战规模识别模型、所述我方敌方人数识别模型、所述能量识别模型、所述越塔识别模型、所述闪现识别模型、所述播报文字识别模型和所述播报框颜色识别模型,确定所述当前精彩片段中的所述目标英雄、所述目标团战规模、所述目标我方敌方人

数、所述目标能量、所述目标越塔识别结果、所述目标闪现识别结果、所述目标播报文字识别结果和所述目标播报框颜色识别结果。

130.将第一当前图像帧序列中的当前图像帧输入至英雄识别模型,得到目标英雄;将第二当前图像帧序列中的当前图像帧输入至团战规模识别模型,得到目标团战规模;将第三当前图像帧序列中的当前图像帧输入至我方敌方人数识别模型,得到目标我方敌方人数;将第四当前图像帧序列中的当前图像帧输入至能量识别模型,得到目标能量;将第五当前图像帧序列中的当前图像帧输入至越塔识别模型,得到目标越塔识别结果;将第六当前图像帧序列中的当前图像帧输入至闪现识别模型,得到目标闪现识别结果;将第七当前图像帧序列中的当前图像帧输入至播报文字识别模型,得到目标播报文字识别结果;将第八当前图像帧序列中的当前图像帧输入至播报框颜色识别模型,得到目标播报框颜色识别结果,即可以得到8种维度的标签。

131.在示例性实施例中,所述方法还可以包括:获得训练视频及所述训练视频中的精彩事件的标注起止时间对;根据所述标注起止时间对从所述训练视频中剪辑出训练精彩片段;对所述训练精彩片段分别按照第一至第八抽帧率和第一至第八空间抠图区域抽帧,获得第一至第八训练图像帧序列;分别获得第一至第八训练图像帧序列中的训练图像帧的英雄标签、团战规模标签、我方敌方人数标签、能量标签、越塔标签、闪现标签、播报文字标签和播报框颜色标签;将第一至第八训练图像帧序列中的训练图像帧分别输入至第一至第八图像分类模型,输出其预测英雄、预测团战规模、预测我方敌方人数、预测能量、预测越塔、预测闪现、预测播报文字和预测播报框颜色;根据所述英雄标签及其预测英雄训练所述第一图像分类模型,获得所述英雄识别模型;根据所述团战规模标签及其预测团战规模训练所述第二图像分类模型,获得所述团战规模识别模型;根据所述我方敌方人数标签及其预测我方敌方人数训练所述第三图像分类模型,获得所述我方敌方人数识别模型;根据所述能量标签及其预测能量训练所述第四图像分类模型,获得所述能量识别模型;根据所述越塔标签及其预测越塔训练所述第五图像分类模型,获得所述越塔识别模型;根据所述闪现标签及其预测闪现训练所述第六图像分类模型,获得所述闪现识别模型;根据所述播报文字标签及其预测播报文字训练所述第七图像分类模型,获得所述播报文字识别模型;根据所述播报框颜色标签及其预测播报框颜色训练所述第八图像分类模型,获得所述播报框颜色识别模型。

132.下面还是以虚拟游戏的视频来举例说明如何训练获得多维度标签识别模型。

133.在上述数据标注基础上,根据标注起止时间对从训练视频中剪辑出训练精彩片段,对训练精彩片段分别进行抽帧,获得第一训练图像帧序列、第二训练图像帧序列、第三训练图像帧序列、第四训练图像帧序列、第五训练图像帧序列、第六训练图像帧序列、第七训练图像帧序列和第八训练图像帧序列,并分别对第一训练图像帧序列、第二训练图像帧序列、第三训练图像帧序列、第四训练图像帧序列、第五训练图像帧序列、第六训练图像帧序列、第七训练图像帧序列和第八训练图像帧序列中的训练图像帧添加多维度标签标注,例如英雄标签、团战规模标签、我方敌方人数标签、能量标签、越塔标签、闪现标签、播报文字标签和播报框颜色标签,标签内容、第一至第八抽帧率以及第一至第八抠图空间区域可以参见下表 1。其中,抠图是图像处理中的操作之一,是把图片或影像的某一部分从原始图片或影像中分离出来成为单独的图层。

134.表1多维度标签训练数据标注

[0135][0136][0137]

上述表1中,之所以给不同图像分类网络设置不同的空间抠图区域和抽帧率,是考虑到不同图像分类网络要识别的区域及该区域的大小不同。例如,能量识别只需要抠出能量那个位置的图片做分类,对于整张大图,网络是较难关注到能量那部分的。再例如,一场

比赛的英雄开局前已确定,不会变,抽帧可以稀疏些。

[0138]

上表1中,scale表示图片resize(调整大小)后的尺寸,例如

“‑

1: 240”代表“高resize到240像素,宽按比例”。crop表示抠图位置,w表示抠出的小图的宽,h表示抠出的小图的高,x表示抠图的左上角x坐标,y表示抠图的左上角y坐标,iw表示原图的宽的长度,ih表示原图的高的长度。

[0139]

模型训练:使用得到的8组训练图像帧的数据分别训练cnn网络例如 mobilenet,获得英雄识别模型、团战规模识别模型、我方敌方人数识别模型、能量识别模型、越塔识别模型、闪现识别模型、播报文字识别模型和播报框颜色识别模型8个特定的图像分类网络,用于预测输出当前图像帧的8组标签。

[0140]

在步骤s142中,综合所述当前精彩片段的多维度标签识别结果,获得所述当前精彩片段的目标标签分类结果。

[0141]

在示例性实施例中,所述目标标签分类结果可以包括所述目标英雄、所述目标团战规模、目标击败类型、目标逃生类型和目标击败数。

[0142]

其中,图6实施例中上述步骤s142还可以进一步包括步骤s1421。

[0143]

在步骤s1421中,根据所述当前精彩片段中的所述目标我方敌方人数、所述目标能量、所述目标越塔识别结果、所述目标闪现识别结果、所述目标播报文字识别结果和所述目标播报框颜色识别结果,确定所述当前精彩片段的所述目标击败类型、所述目标逃生类型和所述目标击败数。

[0144]

综合上述获得的目标我方敌方人数、目标能量、目标越塔识别结果、目标闪现识别结果、目标播报文字识别结果和目标播报框颜色识别结果,可以获得目标击败类型、目标逃生类型和目标击败数。

[0145]

例如若目标我方敌方人数为1vs 1,则目标击败类型为单击败;若目标我方敌方人数为n vs 1、n vs n(n为大于1的整数),则目标击败类型为多人击败;若目标越塔识别结果为越塔、目标播报文字识别结果不是背景、目标播报框颜色识别结果为左蓝右红且目标能量没出现无能量,则目标击败类型为越塔强击败;若目标播报文字识别结果不是背景、目标播报框颜色识别结果为左蓝右红且目标能量为能量少,且没出现无能量,则目标击败类型为xxxx;若目标能量为能量少,且没出现无能量,则目标逃生类型为丝能量逃生;若目标闪现识别结果为前期出现闪现可用,后来出现闪现已用,且目标能量没出现无能量,则目标逃生类型为闪现逃生。

[0146]

其中,“左蓝右红”表示我方击败了敌方;“左红右蓝”表示敌方击败了我方。假设获得的目标标签分类结果如下表2所示。

[0147]

表2标签分类

[0148][0149][0150]

本公开实施例中,多人击败是指多个人击败一个人或多个人。xxxx 是指能量里剩的能量很少时,击败了人。闪现逃生是使用了闪现技能且没死,丝能量逃生是能量里剩的能量很少且没死。四连超凡和五连绝世是播报框里显示的字(非自己定义),四连超凡指连续4次击败人,五连绝世指连续5次击败人。第一滴能量是播报框里显示的字(非自己定义),指开局首击败。团战在游戏中的定义即为以小组(如帮派、战队)为单位的数名玩家进行集体对抗,大规模团战大概是7-10人,我方敌方两边至少有 2人;小规模团战大概是4-6人,我方敌方两边至少有2人。在敌人没有离开敌方防御塔攻击范围内,己方英雄进塔攻击敌人,这个行为叫越塔。

[0151]

在步骤s143中,根据所述当前精彩片段的目标标签分类结果,获得与所述当前精彩片段匹配的目标自动描述信息。

[0152]

对每个当前精彩片段的多维度的目标标签分类结果(见表2)进行组合,形成一句话描述,作为目标自动解说,例如假设解说(一句话描述) 模板如下:

[0153]“(英雄名字)在(大/小规模团战)中,参与(多击败/单击败/越塔强击败/xxxx)敌人,(闪现/丝能量)逃生,实现(击败敌人/二连击破/ 三连决胜/四连超凡/五连绝世/第一滴能量),(给力/干得漂亮/赞/奥力给/ 奈斯)!”[0154]“(英雄名字)参与(大/小规模团战)。”[0155]

本公开实施例中,还可以构建弹幕语料库(见表3),每个目标标签分类结果结合相应弹幕语料,形成至少一句目标自动弹幕;

[0156]

表2弹幕语料库示例

[0157]

[0158][0159]

上述表3中,n连击败是指目标击败数的标签为二连击破、三连决胜、四连超凡、五连绝世中的任意一个均可。当同一个目标标签分类结果对应多个弹幕语料时,可以随机决定本次采用哪一句作为目标弹幕语料。将目标标签分类结果+目标弹幕语料组合生成目标自动弹幕。例如:“xxxx,势不可挡”,“三连决胜,学会谦卑”。

[0160]

图6实施例的步骤s150可以参照上述图1至图4实施例。

[0161]

本公开实施方式提供的多媒体信息的播放控制方法,可以通过训练多个图像分类网络以生成多维度标签识别模型,从而可以基于该多维度标签识别模型识别自动、准确地获得每个当前精彩片段的多维度标签识别结果。

[0162]

图7示意性示出了根据本公开的一实施例的多媒体信息的播放控制方法的示意图。图7实施例以将上述实施例提供的方法应用于虚拟游戏的视频自动生成解说与弹幕为例进行举例说明。如图7所示,当前视频作为当前多媒体信息,且假设为虚拟游戏的视频,分别利用视频特征编码模型和音频特征编码模型对该当前视频进行视频特征编码和音频特征编码,获得当前视频特征矩阵和当前音频特征矩阵,然后进行特征融合,获得当前融合特征矩阵,再将当前融合特征矩阵输入至精彩片段时序定位模型进行精彩片段时序定位,获得当前视频中的精彩事件的起止时间序列作为精彩片段序列,利用多维度标签识别模型对精彩片段序列进行多维度标签识别,这里以多维度标签识别包括英雄识别、团战规模识别、我方敌方人数识别、能量识别、越塔识别、闪现识别、播报文字识别和播报框颜色识别为例,获得多维度标签识别结果,然后根据多维度标签识别结果自动生成目标自动解说和目标自动弹幕。

[0163]

一些当前精彩片段的目标自动解说和目标自动弹幕的实例如图8和图 9所示。如图8所示,在显示当前精彩片段的同时,显示“xxxx,我来就是看这个的”、“丝能量逃生,化险为夷”、“越塔强击败,三十功名尘与土,八千里路云和月”、“二连击破,无敌”和“芈月参与越塔强击败敌人,xxxx敌方,丝能量逃生,实现二连击破,给力!”等目标自动解说和目标自动弹幕。如图9所示,在显示当前精彩片段的同时,显示“击败敌人,学会谦卑”、“多击败,藏冰埋火销神剑,匹马西风听大潮”、“赵云在小规模团战中,参与多人击败敌方,实现击败敌人,赞!”和“小规模团战”等目标自动解说和目标自动弹幕。

[0164]

本公开实施方式提供的多媒体信息的播放控制方法,提供一套多模态自动解说与自动弹幕工具,使用多模态技术(图像分类、音频分类、时序定位)对接收到的当前视频中包含的全部当前精彩片段实现自动剪辑,准确剪辑出当前视频中的全部当前精彩片段,可以将这些当前精彩片段拼接成视频集锦,并完成当前精彩片段的多维度标签识别,利用构建的弹幕语料库和解说模板自动生成目标自动解说与目标自动弹幕。web接口可以以以url的形式返回包含目标自动解说和目标自动弹幕的视频集锦。在实际业务场景中可以替代人工剪辑视频与编辑解说,节约大量的人工成本并减少人为误差。

[0165]

本公开实施例提供的方法可以采用人工智能和云技术来实现。

[0166]

其中,人工智能(artificial intelligence,ai)是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。换句话说,人工智能是计算机科学的一个综合技术,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器。人工智能也就是研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。

[0167]

人工智能技术是一门综合学科,涉及领域广泛,既有硬件层面的技术也有软件层面的技术。人工智能基础技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理技术、操作/交互系统、机电一体化等技术。人工智能软件技术主要包括计算机视觉技术、语音处理技术、自然语言处理技术以及机器学习/深度学习等几大方向。

[0168]

其中,云技术(cloud technology)是指在广域网或局域网内将硬件、软件、网络等系列资源统一起来,实现数据的计算、储存、处理和共享的一种托管技术。

[0169]

云技术是基于云计算商业模式应用的网络技术、信息技术、整合技术、管理平台技术、应用技术等的总称,可以组成资源池,按需所用,灵活便利。云计算技术将变成重要支

撑。技术网络系统的后台服务需要大量的计算、存储资源,如视频网站、图片类网站和更多的门户网站。伴随着互联网行业的高度发展和应用,将来每个物品都有可能存在自己的识别标志,都需要传输到后台系统进行逻辑处理,不同程度级别的数据将会分开处理,各类行业数据皆需要强大的系统后盾支撑,只能通过云计算来实现。

[0170]

上述实施例提及的虚拟游戏可以采用云游戏。其中,云游戏(cloudgaming)又可称为游戏点播(gaming on demand),是一种以云计算技术为基础的在线游戏技术。云游戏技术使图形处理与数据运算能力相对有限的轻端设备(thin client)能运行高品质游戏。在云游戏场景下,游戏并不在玩家游戏终端,而是在云端服务器中运行,并由云端服务器将游戏场景渲染为视频音频流,通过网络传输给玩家游戏终端。玩家游戏终端无需拥有强大的图形运算与数据处理能力,仅需拥有基本的流媒体播放能力与获取玩家输入指令并发送给云端服务器的能力即可。

[0171]

图10示意性示出了根据本公开的一实施例的多媒体信息的播放控制装置的框图。如图10所示,本公开实施例提供的多媒体信息的播放控制装置 1000可以包括多媒体信息确定单元1010、起止时间序列定位单元1020、当前精彩片段剪辑单元1030、自动描述信息获得单元1040以及片段描述同时播放单元1050。

[0172]

本公开实施例中,多媒体信息确定单元1010可以用于确定当前多媒体信息。起止时间序列定位单元1020可以用于定位所述当前多媒体信息中的精彩事件的起止时间序列。当前精彩片段剪辑单元1030可以用于根据所述起止时间序列剪辑出所述当前多媒体信息中包括所述精彩事件的当前精彩片段。自动描述信息获得单元1040可以用于获得与所述当前精彩片段匹配的目标自动描述信息,所述目标自动描述信息包括所述当前精彩片段的多维度标签识别结果。片段描述同时播放单元1050可以用于播放所述当前精彩片段的同时,展示所述目标自动描述信息。

[0173]

在示例性实施例中,起止时间序列定位单元1020可以包括:当前视频特征矩阵获得单元,可以用于获得所述当前多媒体信息的当前视频特征矩阵;当前音频特征矩阵获得单元,可以用于获得所述当前多媒体信息的当前音频特征矩阵;当前融合特征矩阵获得单元,可以用于拼接所述当前视频特征矩阵和所述当前音频特征矩阵,获得所述当前多媒体信息的当前融合特征矩阵;精彩片段时序定位单元,可以用于将所述当前融合特征矩阵输入至精彩片段时序定位模型中,确定所述当前多媒体信息中的精彩事件的起止时间序列。

[0174]

在示例性实施例中,当前视频特征矩阵获得单元可以包括:当前视频帧序列获得单元,可以用于按视频抽帧率对所述当前多媒体信息进行抽帧,获得当前视频帧序列;当前视频特征向量提取单元,可以用于将所述当前视频帧序列中的当前视频帧依次输入至视频特征编码模型中,提取各当前视频帧的视频特征向量;当前视频特征矩阵拼接单元,可以用于按照时间顺序拼接各当前视频帧的视频特征向量,获得所述当前多媒体信息的当前视频特征矩阵。

[0175]

在示例性实施例中,当前音频特征矩阵获得单元可以包括:当前音频文件抽取单元,可以用于从所述当前多媒体信息中抽取当前音频文件;当前音频序列提取单元,可以用于按预定长度滑窗提取所述当前音频文件中的当前音频序列;当前音频特征向量提取单元,可以用于将所述当前音频序列中的当前音频依次输入至音频特征编码模型中,提取各当前音频的音频特征向量;当前音频特征矩阵拼接单元,可以用于按照时间序列拼接各当

前音频的音频特征向量,获得所述当前多媒体信息的当前音频特征矩阵。

[0176]

在示例性实施例中,多媒体信息的播放控制装置1000还可以包括:标注起止时间对获得单元,可以用于获得训练视频及所述训练视频中的精彩事件的标注起止时间对;训练视频特征矩阵获得单元,可以用于获得所述训练视频的训练视频特征矩阵;训练音频特征矩阵获得单元,可以用于获得所述训练视频的训练音频特征矩阵;训练融合特征矩阵获得单元,可以用于拼接所述训练视频特征矩阵和所述训练音频特征矩阵,获得所述训练视频的训练融合特征矩阵;预测起止时间对获得单元,可以用于将所述训练融合特征矩阵输入至时序定位网络模型,获得所述训练视频中的精彩事件的预测起止时间对;精彩片段时序定位模型训练单元,可以用于根据所述预测起止时间对及其标注起止时间对训练所述时序定位网络模型,获得所述精彩片段时序定位模型。

[0177]

在示例性实施例中,训练视频特征矩阵获得单元可以包括:训练视频帧序列获得单元,可以用于以所述视频抽帧率对所述训练视频进行抽帧,获得训练视频帧序列;训练视频帧画面标签确定单元,可以用于根据所述训练视频帧序列中的训练视频帧是否处于所述标注起止时间对的标注时间区间内,确定各训练视频帧的标签为精彩画面或者背景画面;精彩背景图像二分类网络模型训练单元,可以用于利用标签为所述精彩画面或所述背景画面的各训练视频帧训练卷积神经网络模型,获得精彩背景图像二分类网络模型,其中所述精彩背景图像二分类网络模型包括分类层;视频特征编码模型生成单元,可以用于将训练获得的所述精彩背景图像二分类网络模型剔除所述分类层,作为所述视频特征编码模型;训练视频特征矩阵拼接单元,可以用于按照时间顺序拼接所述视频特征编码模型输出的各训练视频帧的视频特征向量,获得所述训练视频的训练视频特征矩阵。

[0178]

在示例性实施例中,自动描述信息获得单元1040可以包括:多维度标签识别结果获得单元,可以用于利用多维度标签识别模型处理所述当前精彩片段,获得所述当前精彩片段的多维度标签识别结果;目标标签分类结果获得单元,可以用于综合所述当前精彩片段的多维度标签识别结果,获得所述当前精彩片段的目标标签分类结果;目标自动描述信息匹配单元,可以用于根据所述当前精彩片段的目标标签分类结果,获得与所述当前精彩片段匹配的目标自动描述信息。

[0179]

在示例性实施例中,所述当前多媒体信息为虚拟游戏,所述多维度标签识别模型可以包括英雄识别模型、团战规模识别模型、我方敌方人数识别模型、能量识别模型、越塔识别模型、闪现识别模型、播报文字识别模型和播报框颜色识别模型,所述多维度标签识别结果包括目标英雄、目标团战规模、目标我方敌方人数、目标能量、目标越塔识别结果、目标闪现识别结果、目标播报文字识别结果和目标播报框颜色识别结果。

[0180]

其中,多维度标签识别结果获得单元可以包括:抽帧率抠图区域确定单元,可以用于分别确定所述英雄识别模型、所述团战规模识别模型、所述我方敌方人数识别模型、所述能量识别模型、所述越塔识别模型、所述闪现识别模型、所述播报文字识别模型和所述播报框颜色识别模型的第一至第八抽帧率和第一至第八空间抠图区域;当前图像帧序列获得单元,可以用于对所述当前精彩片段分别按照第一至第八抽帧率和第一至第八空间抠图区域抽帧,获得第一至第八当前图像帧序列;多维度标签识别结果识别单元,可以用于将第一至第八当前图像帧序列中的当前图像帧分别输入至所述英雄识别模型、所述团战规模识别模型、所述我方敌方人数识别模型、所述能量识别模型、所述越塔识别模型、所述闪现识别模

型、所述播报文字识别模型和所述播报框颜色识别模型,确定所述当前精彩片段中的所述目标英雄、所述目标团战规模、所述目标我方敌方人数、所述目标能量、所述目标越塔识别结果、所述目标闪现识别结果、所述目标播报文字识别结果和所述目标播报框颜色识别结果。

[0181]

在示例性实施例中,多媒体信息的播放控制装置1000还可以包括:标注起止时间对获得单元,可以用于获得训练视频及所述训练视频中的精彩事件的标注起止时间对;训练精彩片段剪辑单元,可以用于根据所述标注起止时间对从所述训练视频中剪辑出训练精彩片段;训练图像帧序列获得单元,可以用于对所述训练精彩片段分别按照第一至第八抽帧率和第一至第八空间抠图区域抽帧,获得第一至第八训练图像帧序列;多维度标注标签获得单元,可以用于分别获得第一至第八训练图像帧序列中的训练图像帧的英雄标签、团战规模标签、我方敌方人数标签、能量标签、越塔标签、闪现标签、播报文字标签和播报框颜色标签;多维度标签预测单元,可以用于将第一至第八训练图像帧序列中的训练图像帧分别输入至第一至第八图像分类模型,输出其预测英雄、预测团战规模、预测我方敌方人数、预测能量、预测越塔、预测闪现、预测播报文字和预测播报框颜色;多维度标签识别模型训练单元,可以用于根据所述英雄标签及其预测英雄训练所述第一图像分类模型,获得所述英雄识别模型;根据所述团战规模标签及其预测团战规模训练所述第二图像分类模型,获得所述团战规模识别模型;根据所述我方敌方人数标签及其预测我方敌方人数训练所述第三图像分类模型,获得所述我方敌方人数识别模型;根据所述能量标签及其预测能量训练所述第四图像分类模型,获得所述能量识别模型;根据所述越塔标签及其预测越塔训练所述第五图像分类模型,获得所述越塔识别模型;根据所述闪现标签及其预测闪现训练所述第六图像分类模型,获得所述闪现识别模型;根据所述播报文字标签及其预测播报文字训练所述第七图像分类模型,获得所述播报文字识别模型;根据所述播报框颜色标签及其预测播报框颜色训练所述第八图像分类模型,获得所述播报框颜色识别模型。

[0182]

在示例性实施例中,所述目标标签分类结果可以包括所述目标英雄、所述目标团战规模、目标击败类型、目标逃生类型和目标击败数。

[0183]

其中,目标标签分类结果获得单元可以包括:多维度标签识别结果综合单元,可以用于根据所述当前精彩片段中的所述目标我方敌方人数、所述目标能量、所述目标越塔识别结果、所述目标闪现识别结果、所述目标播报文字识别结果和所述目标播报框颜色识别结果,确定所述当前精彩片段的所述目标击败类型、所述目标逃生类型和所述目标击败数。

[0184]

在示例性实施例中,所述目标描述信息可以包括目标自动解说。其中,目标自动描述信息匹配单元可以包括:解说模板获得单元,可以用于获得解说模板;目标自动解说确定单元,可以用于根据所述解说模板和所述目标标签分类结果,确定所述目标自动解说。

[0185]

在示例性实施例中,所述目标描述信息可以包括目标自动弹幕。其中,目标自动描述信息匹配单元可以包括:弹幕语料库获得单元,可以用于获得弹幕语料库,所述弹幕语料库包括每个标签分类结果及其对应的弹幕语料,所述标签分类结果包括所述目标标签分类结果;目标自动弹幕匹配单元,可以用于根据所述目标标签分类结果从所述弹幕语料库中匹配获得目标弹幕语料作为所述目标自动弹幕。

[0186]

本公开实施例的多媒体信息的播放控制装置的其它内容可以参照上述实施例。

[0187]

应当注意,尽管在上文详细描述中提及了用于动作执行的设备的若干单元,但是

这种划分并非强制性的。实际上,根据本公开的实施方式,上文描述的两个或更多单元的特征和功能可以在一个单元中具体化。反之,上文描述的一个单元的特征和功能可以进一步划分为由多个单元来具体化。

[0188]

下面参考图11,其示出了适于用来实现本技术实施例的电子设备的结构示意图。图11示出的电子设备仅仅是一个示例,不应对本技术实施例的功能和使用范围带来任何限制。

[0189]

参照图11,本公开实施例提供的电子设备可以包括:处理器1101、通信接口1102、存储器1103和通信总线1104。

[0190]

其中处理器1101、通信接口1102和存储器1103通过通信总线1104完成相互间的通信。

[0191]

可选的,通信接口1102可以为通信模块的接口,如gsm(globalsystem for mobile communications,全球移动通信系统)模块的接口。处理器 1101用于执行程序。存储器1103用于存放程序。程序可以包括计算机程序,该计算机程序包括计算机操作指令。其中,程序中可以包括:游戏客户端的程序。

[0192]

处理器1101可以是一个中央处理器cpu,或者是特定集成电路asic (application specific integrated circuit),或者是被配置成实施本公开实施例的一个或多个集成电路。

[0193]

存储器1103可以包含高速ram(random access memory,随机存取存储器)存储器,也可以还包括非易失性存储器(non-volatile memory),例如至少一个磁盘存储器。

[0194]

其中,程序可具体用于:确定当前多媒体信息;定位所述当前多媒体信息中的精彩事件的起止时间序列;根据所述起止时间序列剪辑出所述当前多媒体信息中包括所述精彩事件的当前精彩片段;获得与所述当前精彩片段匹配的目标自动描述信息;播放所述当前精彩片段的同时,展示所述目标自动描述信息。

[0195]

根据本技术的一个方面,提供了一种计算机程序产品或计算机程序,该计算机程序产品或计算机程序包括计算机指令,该计算机指令存储在计算机可读存储介质中。计算机设备的处理器从计算机可读存储介质读取该计算机指令,处理器执行该计算机指令,使得该计算机设备执行上述实施例的各种可选实现方式中提供的方法。

[0196]

需要理解的是,在本公开附图中的任何元素数量均用于示例而非限制,以及任何命名都仅用于区分,而不具有任何限制含义。

[0197]

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本公开的其它实施方案。本技术旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由下面的权利要求指出。

[0198]

应当理解的是,本公开并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本公开的范围仅由所附的权利要求来限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1