基于信道特性的联合学习接入方法

本发明涉及一种基于信道特性的联合学习接入方法,属于无线通信。

背景技术:

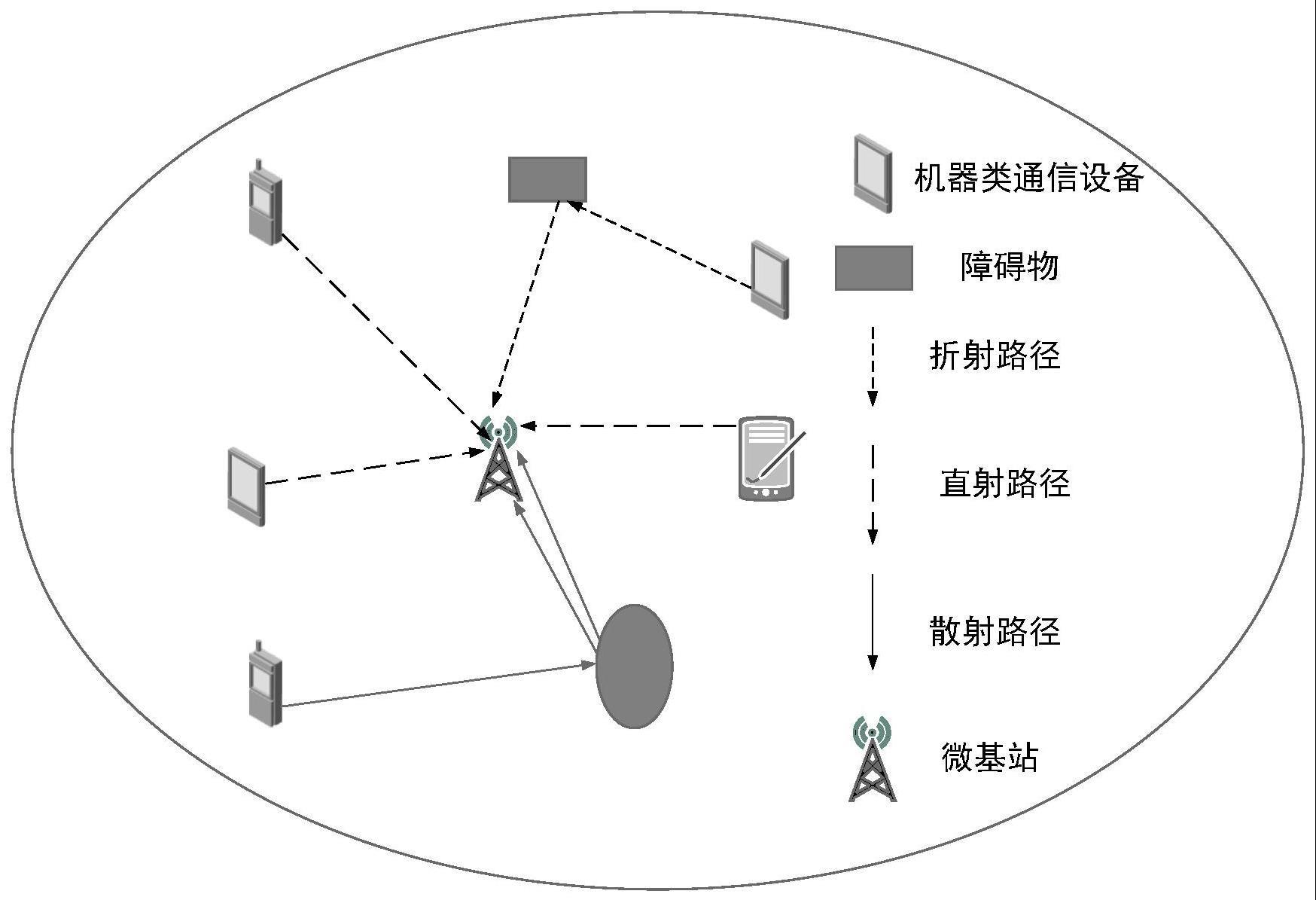

1、通信技术的不断更新迭代,通信业务发展极其迅速,其通信场景也变得原来越多。大规模机器类型通信(mmtc,massivemachine typecommunication)使用场景,也称为大规模物联网(miot,massive internet ofthings),它的特点是大量低复杂度和能量受限的机器类通信设备(mtcd,machine type communication device)周期性地发送非常短的数据包,具有宽松的延迟要求,预计在未来6g中无线网络中发挥重要作用。为了满足mtcd的海量接入需求,需要在当前拥塞控制机制的基础上进一步进行控制优化。同时对于多种业务类型mtcd同时进行随机接入(ra,randomaccess)的场景,在提高系统吞吐量的同时必须考虑各种业务类型mtcd的接入时延、碰撞数和接入公平性。在增强型mmtc场景中,由于放宽了延迟要求,可以采用基于竞争的随机接入过程,如果采用传统的lte随机接入过程,则大量mtcd可能同时启动其接入网络的过程,大量ra尝试会增加前导冲突概率,从而减少成功访问的次数。这个问题可以通过增加分配给物理随机接入信道(prach,physical randomaccess channel)资源来解决,然而由于上行链路资源有限,可用于prach资源的资源量越高,则可用于物理上行共享信道(pusch,physical uplink shared channel)的资源量就越低,许多成功完成ra尝试的mtcd无法在pusch中找到足够的传输资源。然而接入资源受限和接入冲突导致的时延问题仍然存在。

2、目前大多数方案只考虑到随机信道的资源分配,很少考虑可以借用物理上行链路共享信道(pusch,physical uplink shared channel)资源进行联合分配。此外,大多数方案缺乏对信道特性的考虑,忽视了大量的不同传输条件的设备导致的前导码分布不均匀的问题。

3、有鉴于此,确有必要提出一种基于信道特性的联合学习接入方法,以解决上述问题。

技术实现思路

1、本发明的目的在于提供一种基于信道特性的联合学习接入方法,能够解决有限资源分配不均衡和接入效率问题。

2、为实现上述目的,本发明提供了一种基于信道特性的联合学习接入方法,主要包括以下步骤:

3、步骤1、初始化每个智能体的深度q网络,包括训练网络q(s,a;θ)和目标网络q(s,a;θ-)以及参数θ和θ-;

4、步骤2、计算按贝塔分布到达设备的信道参数w,根据信道参数w的大小对设备分组;

5、步骤3、计算重传的设备与分组的设备总数,对物理随机接入信道prach与物理上行链路共享信道pusch进行联合分配;

6、步骤4、每个智能体根据当前状态信息并使用贪婪策略选择动作,并从可用前导池中选择前导;

7、步骤5、更新环境的状态st+1以及奖励rt+1,存放经验(st,at,st+1,rt+1)到经验库中;

8、步骤6、从累计的经验中随机抽取一定数量的样本,根据样本计算出损失函数li(θ),并更新权重θ,重复步骤3,直至损失函数e到达收敛条件或者达到最大迭代次数t。

9、作为本发明的进一步改进,步骤1中,每一个智能体中的损失函数可以表示为:

10、li(θ)=e[(ydqn-qk(st,at;θ))2],

11、其中,表示目标值,θ-表示目标网络的权重,e()表示均值,r表示奖励,t表示时隙,γ表示折扣因子。

12、作为本发明的进一步改进,步骤2中,均方根时延扩展与电平交叉率用于评估信道质量的统计特性,其中,所述均方根时延扩展可表示为:

13、

14、其中,表示平均过量时延。

15、作为本发明的进一步改进,所述电平交叉率是指包络线在正(或负)方向上交叉指定水平r的频率,在莱斯衰落过程中可表示为:

16、

17、其中,符号α和是独立的,2b0为分散功率,s2为镜面反射功率,b2=2b0(πfm)2,适用于各向同性散射环境,fm为最大多普勒频移。

18、作为本发明的进一步改进,所述均方根时延扩展与所述电平交叉率可以归一化:

19、

20、

21、并计算信道参数:

22、w=w1·lcrnor+w2·σnor,

23、其中,w1和w2是比例因子,且w1+w2=1,用于平衡均方根时延扩展和电平交叉率在信道参数中的重要性。

24、作为本发明的进一步改进,所述设备的到达模型服从贝塔分布:

25、

26、其中,符号α=3、β=4。

27、作为本发明的进一步改进,将所有设备分为m组,所以每个时隙的设备数量为:

28、

29、其中,nt(w)=nt·λ·e-wt表示当前时隙到达的设备数量,λ=α(α+β),是贝塔分布的期望。

30、作为本发明的进一步改进,步骤3中,根据基于竞争的前导码数量l和设备数可求得物理随机接入信道prach中成功接入前导码的平均设备数量:

31、

32、假设基站分配传输θmax比特所需的物理上行链路共享信道pusch资源,对应的可以求出物理上行链路共享信道pusch中可成功传输的设备数spu:

33、

34、其中,符号log2(i)是针对星座的每个符号发送的信息比特的数量,由上述公式可知,随着物理随机接入信道prach的增加,相应的物理上行链路共享信道pusch中可成功传输的spu就越少,通过给定的值找到tpr和tpu的最佳值:

35、

36、其中,tpr∈{1,2,tra-1},令可以求得最佳分配方案。

37、作为本发明的进一步改进,步骤4中,采用参数共享的深度q网络算法,设计一个基于联合信道接入的深度神经网络的框架,结合q学习以生成策略π,其中输入是观察到的状态空间s,输出是动作空间a中的所有可执行动作;每个状态动作对都有对应的q值q(st,at);每个步骤都会选择在每个状态下获得最大q值的动作,q函数根据以下规则更新,如下表示:

38、

39、其中,符号γ是折扣因子,st+1和rt+1表示下一个状态和在状态st下采取动作后获得的奖励,a'表示状态st+1下的动作,a为可执行动作集,表示状态st+1下动作集合a中的最大q值,智能体采用ε-贪婪策略寻找最大值。

40、作为本发明的进一步改进,步骤5中,将前导码决策问题转化为rl问题,定义了状态集,动作空间和奖励函数,

41、状态集s:分为三部分,第一部分是设备在上一个实时隙的访问状态,这个状态有三个值分别为1,0,-1,其中值为1时表示发送的前导码未被基站检测出冲突,0表示选择的前导码被基站检测到冲突,-1表示上一个时隙设备选择主动退避,未参与前导码竞争,第二部分是设备在最后一个ra过程中选择的前导码,记为pi,其中第三部分是其他设备与设备在之前的ra过程中选择的相同的前导码的个数;

42、动作空间:根据当前状态,每个智能体根据自身的决策策略π采取动作at,动作空间a可以定义为两部分:尝试访问和选择性退避;

43、奖励函数:当设备选择连接并成功连接时,将获得正向奖励,如果发生碰撞,它将获得负奖励,如果设备选择回退,奖励将根据当前时刻尝试连接的设备数量和剩余重传次数计算,

44、

45、其中,符号αk为学习率,βk是可调整参数。

46、本发明的有益效果是:本发明可以更好的适应环境变化,能够提高接入成功率。

- 还没有人留言评论。精彩留言会获得点赞!