基于注意力机制的时空神经网络雷达回波外推预报方法与流程

[0001]

本发明涉及大气探测中地面气象观测技术领域,特别涉及一种基于注意力机制的时空神经网络的雷达回波外推预报方法。

背景技术:

[0002]

雷达回波外推预报技术是天气临近预报技术中最为基础、最有效的方法之一,高精度雷达回声外推有助于减少极端天气造成的社会损失。雷达回波外推技术是根据已有的历史雷达回波数据,预测未来回波的形状、位置和强度等信息,以实现对天气系统的跟踪预报。传统的雷达回波外推方法主要包括质心追踪法、交叉相关法和光流法。质心追踪法通过计算连续的回波单体质心来确定移动矢量,进而预测未来回波位置。但质心追踪法使用范围局限于回波较强、范围较小的对流天气系统。交叉相关法将回波划分不同的追踪区域,计算相邻时刻区域之间的最优相关系数,进而确定区域间拟合关系以及实现预测。光流法通过计算连续回波的光流场得到运动矢量场,再基于运动矢量实现雷达回波外推。近十年来,光流法逐渐成为我国气象机构业务中最常用的一种雷达回波外推方法。但是光流法的效果受噪声的影响比较大,在存在噪声的情况下,光流法的精度往往比较低。对流天气系统是动态复杂的系统,它具有作非线性运动(如旋转)、运动中有形变(如扩张和缩小)以及生消发展变化快等特征。传统雷达回波外推方法只假设回波简单线性演变,且对历史雷达回波资料利用率不足,无法有效预测回波的旋转变化和生消发展,具有精确度不够高、预报时效短等缺陷。

[0003]

随着深度学习的不断发展,深度学习模型(尤其是卷积神经网络和递归神经网络)的应用在历史雷达回波图像临近预报的降水方面取得了良好的效果。而目前大多数方法是基于递归单元(例如rnn,lstm和gru)来对时间序列进行建模,使用卷积结构来提取局部空间依赖性。还有的方法是使用卷积递归单元串联或级联结构来融合时空特征。然而,雷达回波的累积和消散不仅限于局部空间范围和邻近时间上的关系,它需要考虑到大范围的空间气象变化和较长时间的影响,而上述这些深度学习方法仅侧重于小范围局部区域的空间关联,没有充分研究更大范围区域的空间关联性,不利于长时间的外推演算,导致这些方法的时空表示能力仍然有待提高,以预测精度更高的未来时刻的雷达回波。

技术实现要素:

[0004]

本发明的目的在于克服现有技术对空间信息提取不足、预报时效短的缺点,提供一种基于注意力机制的时空神经网络雷达回波外推预报方法,实现了准确度更高的雷达回波外推预测。

[0005]

本发明基于注意力机制的时空神经网络雷达回波外推预报方法,包括以下步骤:

[0006]

步骤1、数据预处理,对雷达回波图像数据,去除部分噪声,并选择出有效数据段,然后将数据段转换为归一化的灰度数据;基于归一化的数据集,对数据段进行拆分,然后将拆分的数据集划分为训练序列样本集和测试序列样本集;

[0007]

步骤2、构建及训练att-convlstm网络,对雷达回波序列样本的图像根据预设的切片因子进行切片,调整图像的维度,然后输入到基于注意力机制的时空预测神经网络,通过多层网络的前向传播,利用反向传播更新网络权重;

[0008]

步骤3、利用训练好的att-convlstm网络以及测试序列样本集进行预测,得到最终的外推图像序列。

[0009]

本发明相对于现有技术具有如下的优点及效果:

[0010]

1、设计了一种注意力机制来计算雷达图内数值大小的空间相关性,有效地学习图像的全局空间上下文信息,克服了现有方法仅采用卷积提取局部空间信息而对全局空间信息学习能力不足的缺点。

[0011]

2、提出了一种融合注意方法和卷积长短记忆力神经网络(convlstm)的st-convlstm网络模块,利用convlstm结构提取粗糙的时空特征信息,然后利用注意力方法对粗糙的时空特征图进行精细化,有效地利用了局部和全局的时空特征,增强了网络对雷达回波数据的时空表达能力。

[0012]

3、设计了基于注意力机制的卷积长短记忆力神经网络(att-convlstm),通过使用卷积层对数据通道间的强相关性进行编码,然后堆叠多层st-convlstm模块,提取数据的精细化的抽象时空信息表示并沿着垂直锯齿型的方向传输,优化了网络的短期记忆力,同时粗糙的时空信息和隐藏状态信息随着时间推移水平传输,保持了良好的长期记忆力,提高雷达回波外推的准确度和时效。

附图说明

[0013]

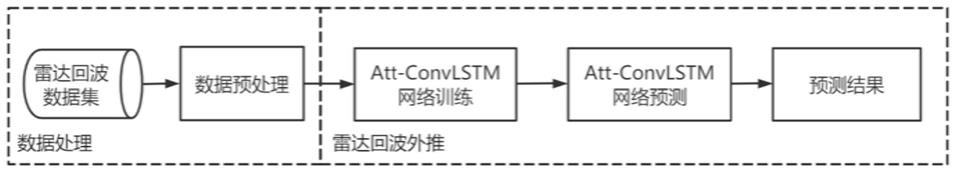

图1是本发明的方法流程图;

[0014]

图2是st-convlstm网络模块的结构示意图;

[0015]

图3示意了l=3的att-convlstm的网络结构图;

[0016]

图4为本发明对广州天气数据集外推实验结果图。

具体实施方式

[0017]

下面结合实施例及附图对本发明作进一步详细的描述,但本发明的实施方式不限于此。

[0018]

实施例

[0019]

如图1所示,本发明基于注意力机制的时空神经网络雷达回波外推预报方法,包括以下步骤:

[0020]

步骤1:数据预处理。对给定的已转换到空间直角坐标系的雷达回波数据,通过阈值法去除部分噪声,并选择出有效数据段,然后将数据段转换为归一化的灰度数据。基于归一化的数据集,通过滑动窗口法对数据段进行拆分,然后采用随机采样方法将拆分的数据集划分为训练序列样本集和测试序列样本集。本实施例中,雷达回波数据分辨率为140

×

140。

[0021]

本实施例中,步骤1包括以下步骤:

[0022]

步骤1-1,去噪。设置雷达回波强度阈值为value_threshold=10dbz,对每一张雷达回波图进行去噪处理,将图像中小于value_threshold的强度值置为0,大于等于value_

threshold的强度值保留。

[0023]

步骤1-2,选取有效数据。设置数据段样本数量阈值为time_threshold=10,序列有效图像占比阈值为valid_threshold=0.8,对所有经步骤1-1处理的数据进行遍历,若当前累积连续数据样本的数量大于等于time_threshold,且图像区域内雷达回波强度值非全零的图像数量在当前连续序列样本数量的占比大于等于valid_threshold,则划分为一个数据段,即每一个数据段至少包含s个连续样本,并且雷达回波强度值为非全零的样本数量与数据段样本数量比值不少于占用阈值occupy_threshold。每一个数据段均以当前可选取的最大连续样本序列样本数量为准进行划分。本实施例中,s=10,即每一个数据段至少包含10个连续样本;雷达回波强度值为非全零的样本数量至少占数据段的80%,即occupy_threshold=0.8。

[0024]

步骤1-3,数据转换和归一化。将步骤1-2选取得到的数据data映射到值域为[0,255]的灰度数据gray_data,数据映射公式如下:

[0025][0026]

其中,符号表示数值向下取整,min{data}表示data的最小值,max{data}表示data的最大值。

[0027]

并且对映射得到的灰度数据gray_data通过归一化处理得到归一化灰度数据normlized_data,数据归一化公式为:

[0028][0029]

得到的归一化灰度数据normalized_data的值域为[0,1]。

[0030]

步骤1-4,数据段拆分。设置滑动窗口大小w,然后对normalized_data的每一个数据段内的连续图像拆分成多个子序列,每一个序列sequence长度等于滑动窗口大小w值,其中,前w/2个数据作为输入序列inputs,后w/2个数据作为外推参照序列ground_truths。记其中一个数据段的样本数量为data_segment,则该数据段可以拆分成data_segment-w+1个序列。其中,序列可以表示为:sequence={inputs,ground_truths},由w张时间连续的雷达回波图组成;其中,input={i1,i2,...,i

w/2

}为输入序列,由w/2张时间连续的雷达回波图组成,ground_truths={i

w/2+1

,i

w/2+2

,...,i

w

}为外推参照序列,是由输入序列的后w/2张时间连续的雷达回波图组成。本实施例中,滑动窗口大小w取值为20。

[0031]

步骤1-5,划分训练集和测试集。将步骤1-4得到的所有数据序列样本汇总为序列样本总集total_set,将序列样本总集total_set中各个月份的序列按照比例r随机划分出测试序列样本子集和训练序列样本子集,合并各个月份的测试序列样本子集和训练序列样本子集,得到测试序列样本集test_set和训练序列样本集train_set。本实施例中,比例

[0032]

步骤2:构建及训练att-convlstm网络。对雷达回波序列样本的图像根据预设的切片因子参数patch_size进行切片,调整图像的维度,然后输入到基于注意力机制的时空预测神经网络,通过多层网络的前向传播,利用反向传播更新网络权重。

[0033]

att-convlstm网络的构建如图3所示。

[0034]

本实施例中,步骤2包括以下步骤:

[0035]

步骤2-1,训练参数初始化。即设置输入图像的高度height、宽度width和通道数channel、切片因子patch_size、st-convlstm模块堆叠层数l(l≥2)、卷积核大小filter_size、卷积核数量hidden_num、步长stride、隐藏层数量、学习率λ、输入序列长度w/2、外推序列长度w/2、训练阶段每次输入的样本数量batch_size、训练最大轮次max_epoch,并初始化网络中的各个卷积核参数和偏差。

[0036]

本实施例中,输入图像的高度height=140,宽度width=140,通道数channel=1,切片因子patch_size=4,st-convlstm模块(如图2所示)堆叠层数l=3,卷积核大小filter_size=5,步长stride=1,隐藏层数量hidden_num=64,学习率λ=0.001,输入序列长度input_length=10,外推序列长度output_length=10,训练阶段每次输入的样本数量batch_size=8,训练最大轮次max_epoch=60。

[0037]

步骤2-2,构建神经网络。首先,构建第1层的卷积层网络init_conv_layer,设置卷积核w

init

的尺寸大小为1

×

1,数量为channel'

×

hidden_num,步长为1。然后,根据步骤2-1设置的st-convlstm模块堆叠层数l、卷积核大小filter_size、步长stride、隐藏层数量hidden_num,构建l层st-convlstm并按顺序依次堆叠在第一层卷积层网络之后。最后,在第l层st-convlstm后堆叠一层卷积层网络,设置卷积核w

predict

的尺寸大小为1

×

1,数量为hidden_num

×

channel',步长为1。

[0038]

本实施例中,设置卷积核w

init

的数量为16

×

64;构建l=3层st-convlstm并按顺序依次堆叠在第一层卷积层网络之后,每一层st-convlstm中除了attention模块之外的卷积核大小设置为5

×

5,数量为64

×

64,步长为1;并将一开始的隐藏态细胞态时空记忆初始化为全零张量,大小为(8,64,35,35),其中k=1,2,3。

[0039]

步骤2-3,训练样本读取。采用批训练的方式,每次训练时从训练序列样本集train_set中读取batch_size=8个序列样本一同作为网络的输入。

[0040]

步骤2-4,训练样本切片。对读取到的batch_size个序列样本根据切片因子patch_size,对序列中每一张图像进行切片。将图像的高度和宽度分别除以patch_size得到新的高度和宽度,然后通道数乘以patch_size的平方得到新的通道数,然后根据新的高度、宽度和通道数对图像的维度进行调整,最后将切片后的数据一同作为网络的输入i

t

,其中t=1,2,3,...,w/2。而记原图像的高度、宽度和通道数为三元组(height,width,channel),切片后得到图像的高度、宽度和通道数三元组为(height',width',channel'),该转换过程可由以下式子表示:

[0041][0042][0043]

channel'=channel

×

patch_size

×

patch_size

[0044]

本实施例中,原图像的高度、宽度和通道数为三元组(140,140,1),切片后得到图像的高度、宽度和通道数三元组为(35,35,16)。

[0045]

步骤2-5,将i

t

(t=1,2,3,...,w/2)输入初始化网络的第1层卷积网络init_conv_layer,经卷积运算后得到第1层网络的输出x

t

,运算公式为:

[0046]

x

t

=w

init

*i

t

[0047]

其中,*表示卷积运算,卷积核w

init

的尺寸为1

×

1,数量为channel'

×

hidden_num。

[0048]

步骤2-6,将当前时刻上一层网络输出的隐藏态和时空记忆上一个时刻同层网络输出的隐藏态和细胞态输入到网络的第k(k=1,2,...,l)层时空卷积长短记忆力网络stconvlstm_layer,经前向传播后得到当前时刻第k层时空卷积长短记忆力网络输出的隐藏态细胞态时空记忆其中,t=1,2,3,...,w/2,k=1,2,...,l,和参数值通过初始化设定。

[0049]

时空卷积长短记忆力网络stconvlstm_layer模块结构图如图2所示,包括以下步骤:

[0050]

步骤2-6-1,上一个时刻第k层网络输出的隐藏态和细胞态当前时刻t第k-1层输出的隐藏态通过输入门和遗忘门进行更新,得到当前时刻t第k层的细胞态公式如下:

[0051][0052][0053][0054][0055]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,tanh表示双曲正切激活函数σ表示sigmoid函数卷积核卷积核的尺寸均为filter_size

×

filter_size,数量为hidden_num

×

hidden_num;表示偏差;f

tk

表示辅助变量。

[0056]

步骤2-6-2,第k-1层输出的隐藏态时空记忆和步骤2-6-1更新得到的细胞态进行加法融合得到然后输入到注意力模块。在注意力模块中,首先,对沿着通道轴分别应用平均池化操作和最大池化操作,并将平均池化和最大池化的结果按列拼接,再利用卷积核对拼接结果进行卷积运算,把卷积结果输入到sigmoid函数中得到注意力权重矩阵然后,将注意力权重矩阵与注意力模块的输入进行点乘运算,再使用1

×

1的卷积核对进行卷积运算得到时空注意力图,最后与时空记忆进行点乘运算,更新当前的时空记忆,得到运算公式如下:

[0057][0058]

[0059][0060]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;σ表示sigmoid函数avgpool(

·

)表示沿着通道轴的平均池化运算,maxpool(

·

)表示沿着通道轴的最大池化运算;卷积核的尺寸为7

×

7,数量为2

×

1,卷积核的尺寸为1

×

1,数量为hidden_num

×

hidden_num。

[0061]

步骤2-6-3,将第t-1时刻同层输出的隐藏态当前t时刻第k-1层输出的隐藏态步骤2-6-1和步骤2-6-2更新后得到的细胞态和时空记忆作为输出门的输入,对隐藏态进行更新,得到公式如下:

[0062][0063][0064]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;tanh表示双曲正切激活函数卷积核w1×1的尺寸为1

×

1,数量为hidden_num

×

hidden_num,卷积核的尺寸为5

×

5,数量为hidden_num

×

hidden_num;表示偏差。

[0065]

步骤2-7,把步骤2-6输出的隐藏态输入最后的卷积预测层predict_layer,输出网络的预测结果图像公式如下:

[0066][0067]

其中,*表示卷积运算,卷积核w

predict

的尺寸为1

×

1,数量为hidden_num

×

channel'。

[0068]

步骤2-8,将步骤2-7输出的预测结果图像还原至原图像尺寸大小,将图像的高度和宽度分别乘以patch_size,通道数除以patch_size的平方,进行维度的调整,得到调整后图像的高度、宽度和通道数为三元组(height,width,channel),完成从输入i

t

到的雷达回波外推。

[0069]

步骤2-9,当t≥w/2时,将步骤2-8输出的作为输入,重复执行步骤2-6至步骤2-8,直至t=w-1,依次得到预测未来时刻的图像序列完成雷达回波序列外推。

[0070]

步骤2-10,计算损失函数值。对步骤2-6至步骤2-9前向传播得到的预测序列9前向传播得到的预测序列和外推参照序列ground_truths={i

w/2+1

,i

w/2+2

,...,i

w

}计算均方误差作为损失函数。根据损失函数所得数值计算网络参数梯度,并更新网络参数,完成反向传播。

[0071]

在一个具体的实施例中,上述步骤2-5到步骤2-10可以具体为如下步骤(1)-(13):

[0072]

步骤(1),i1(t=1)输入初始化网络的第1层卷积网络init_conv_layer,经卷积运算后得到第1层网络的输出x1,运算公式为:

[0073]

x1=w

init

*i1[0074]

其中,*表示卷积运算,卷积核w

init

的尺寸为1

×

1,数量为16

×

64。

[0075]

步骤(2),x1和一开始初始化的隐藏态细胞态时空记忆输入到网络的第2层时空卷积长短记忆力网络stconvlstm_layer1,经前向传播后输出隐藏态细胞态时空记忆时空卷积长短记忆力网络stconvlstm_layer模块包括以下步骤:

[0076]

步骤(2-1),x1、隐藏态和细胞态通过输入门和遗忘门进行更新,公式如下:

[0077][0078][0079][0080][0081]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,tanh表示双曲正切激活函数σ表示sigmoid函数卷积核卷积核的尺寸均为5

×

5,数量为64

×

64;表示该层网络的偏差;f

11

表示辅助变量。

[0082]

步骤(2-2),x1、时空记忆和步骤(2-1)更新得到的细胞态进行加法融合得到然后输入到注意力模块。在注意力模块中,首先,对沿着通道轴分别应用平均池化操作和最大池化操作,并将平均池化和最大池化的结果按列拼接,再利用卷积核对拼接结果进行卷积运算,把卷积结果输入到sigmoid函数中得到注意力权重矩阵然后,将注意力权重矩阵与注意力模块的输入进行点乘运算,再使用1

×

1的卷积核对进行卷积运算得到时空注意力图,最后与时空记忆进行点乘运算,更新当前的时空记忆。运算公式如下:

[0083][0084][0085][0086]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;σ表示sigmoid函数avgpool(

·

)表示沿着通道轴的平均池化运算,maxpool(

·

)表示沿着通道轴的最大池化运算;卷积核的尺寸为7

×

7,数量为

2

×

1,卷积核的尺寸为1

×

1,数量为64

×

64。

[0087]

步骤(2-3),输入x1、隐藏态更新后的细胞态和更新后的时空记忆通过输出门后对隐藏态进行更新,公式如下:

[0088][0089][0090]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;tanh表示双曲正切激活函数卷积核w1×1的尺寸为1

×

1,数量为64

×

64,卷积核的尺寸为5

×

5,数量为64

×

64;表示偏差。

[0091]

步骤(3),步骤(2)输出的隐藏态和时空记忆输入到网络的第2层时空卷积长短记忆力网络stconvlstm_layer2,经前向传播后得到第2层时空卷积长短记忆力网络输出的隐藏态细胞态时空记忆其包括以下步骤:

[0092]

步骤(3-1),第1层输出的隐藏态第2层网络初始化的隐藏态和细胞态通过输入门和遗忘门进行更新,公式如下:

[0093][0094][0095][0096][0097]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,tanh表示双曲正切激活函数σ表示sigmoid函数卷积核卷积核的尺寸均为5

×

5,数量为64

×

64;表示偏差;f

12

表示辅助变量。

[0098]

步骤(3-2),第1层输出的隐藏态时空记忆和步骤(3-1)更新得到的细胞态进行加法融合得到然后输入到注意力模块。在注意力模块中,首先,对沿着通道轴分别应用平均池化操作和最大池化操作,并将平均池化和最大池化的结果按列拼接,再利用卷积核对拼接结果进行卷积运算,把卷积结果输入到sigmoid函数中得到注意力权重矩阵然后,将注意力权重矩阵与注意力模块的输入进行点乘运算,再使用1

×

1的卷积核对进行卷积运算得到时空注意力图,最后与时空记忆进行点乘运算,更新当前的时空记忆。运算公式如下:

[0099][0100][0101][0102]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;σ表示sigmoid函数avgpool(

·

)表示沿着通道轴的平均池化运算,maxpool(

·

)表示沿着通道轴的最大池化运算;卷积核的尺寸为7

×

7,数量为2

×

1,卷积核的尺寸为1

×

1,数量为64

×

64。

[0103]

步骤(3-3),将第1层输出的隐藏态第2层初始化的隐藏态更新后的细胞态和更新后的时空记忆作为输出门的输入,对隐藏态进行更新,公式如下:

[0104][0105][0106]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;tanh表示双曲正切激活函数卷积核w1×1的尺寸为1

×

1,数量为64

×

64,卷积核的尺寸为5

×

5,数量为64

×

64;表示偏差。

[0107]

步骤(4),步骤(3)输出的隐藏态和时空记忆输入到网络的第3层时空卷积长短记忆力网络stconvlstm_layer3,经前向传播后得到第3层时空卷积长短记忆力网络输出的隐藏态细胞态时空记忆其包括以下步骤:

[0108]

步骤(4-1),第2层输出的隐藏态第3层网络初始化的隐藏态和细胞态通过输入门和遗忘门进行更新,公式如下:

[0109][0110][0111][0112][0113]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,tanh表示双曲正切激活函数σ表示sigmoid函数卷积核卷积核的尺寸均为5

×

5,数量为64

×

64;表示偏差;f

13

表示辅助变量。

[0114]

步骤(4-2),第2层输出的隐藏态时空记忆和步骤2-7-1更新得到的细胞态进行加法融合得到然后输入到注意力模块。在注意力模块中,首先,对沿着通道轴分别应用平均池化操作和最大池化操作,并将平均池化和最大池化的结果按列拼接,再利用卷积核对拼接结果进行卷积运算,把卷积结果输入到sigmoid函数中得到注意力权重矩阵然后,将注意力权重矩阵与注意力模块的输入进行点乘运算,再使用1

×

1的卷积核对进行卷积运算得到时空注意力图,最后与时空记忆进行点乘运算,更新当前的时空记忆。运算公式如下:

[0115][0116][0117][0118]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;σ表示sigmoid函数avgpool(

·

)表示沿着通道轴的平均池化运算,maxpool(

·

)表示沿着通道轴的最大池化运算;卷积核的尺寸为7

×

7,数量为2

×

1,卷积核的尺寸为1

×

1,数量为64

×

64。

[0119]

步骤(4-3),将第2层输出的隐藏态第3层初始化的隐藏态更新后的细胞态和更新后的时空记忆作为输出门的输入,对隐藏态进行更新,公式如下:

[0120][0121][0122]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;tanh表示双曲正切激活函数卷积核w1×1的尺寸为1

×

1,数量为hidden_num

×

hidden_num,卷积核的尺寸为5

×

5,数量为hidden_num

×

hidden_num;表示偏差。

[0123]

步骤(5),把步骤(4)输出的隐藏态输入最后的卷积预测层predict_layer,输出网络的预测结果公式如下:

[0124][0125]

其中,*表示卷积运算,卷积核w

predict

的尺寸为1

×

1,数量为64

×

16。

[0126]

步骤(6),将步骤(5)预测输出的图像还原至原图像尺寸大小,将图像的高度和宽度分别乘以patch_size=4,通道数除以patch_size=4的平方,进行维度的调整,得到调整后图像的高度和宽度的高度、宽度和通道数为三元组(140,140,1),完成从输入i1到的雷达回波外推。

[0127]

步骤(7),i

t

(t=2,3,...,10)输入初始化网络的第1层卷积网络init_conv_layer,经卷积运算后得到第1层网络的输出x

t

,运算公式为:

[0128]

x

t

=w

init

*i

t

[0129]

其中,*表示卷积运算,卷积核w

init

的尺寸为1

×

1,数量为16

×

64。

[0130]

步骤(8),x

t

(t=2,3,...,10)、隐藏态细胞态和时空记忆输入到网络的第2层时空卷积长短记忆力网络stconvlstm_layer1,经前向传播后输出隐藏态细胞态时空记忆其包括以下步骤:

[0131]

步骤(8-1),x

t

、隐藏态和细胞态通过输入门和遗忘门进行更新,公式如下:

[0132][0133][0134][0135][0136]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,tanh表示双曲正切激活函数σ表示sigmoid函数卷积核卷积核的尺寸均为5

×

5,数量为64

×

64;表示偏差;f

11

表示辅助变量。

[0137]

步骤(8-2),x

t

、时空记忆和步骤2-12-1更新得到的细胞态进行加法融合得到然后输入到注意力模块。在注意力模块中,首先,对沿着通道轴分别应用平均池化操作和最大池化操作,并将平均池化和最大池化的结果按列拼接,再利用卷积核对拼接结果进行卷积运算,把卷积结果输入到sigmoid函数中得到注意力权重矩阵然后,将注意力权重矩阵与注意力模块的输入进行点乘运算,再使用1

×

1的卷积核对进行卷积运算得到时空注意力图,最后与时空记忆进行点乘运算,更新当前的时空记忆。运算公式如下:

[0138][0139][0140][0141]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;σ表示sigmoid函数avgpool(

·

)表示沿着通道轴的平均池化运算,maxpool(

·

)表示沿着通道轴的最大池化运算;卷积核的尺寸为7

×

7,数量为

2

×

1,卷积核的尺寸为1

×

1,数量为64

×

64。

[0142]

步骤(8-3),输入x

t

、隐藏态更新后的细胞态和更新后的时空记忆通过输出门后对隐藏态进行更新,得到更新后的隐藏态公式如下:

[0143][0144][0145]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;tanh表示双曲正切激活函数卷积核w1×1的尺寸为1

×

1,数量为64

×

64,卷积核的尺寸为5

×

5,数量为64

×

64;表示偏差。

[0146]

步骤(9),步骤(8)输出的隐藏态和时空记忆输入到网络的第k(k=2,3)层时空卷积长短记忆力网络stconvlstm_layerk,经前向传播后得到第k层时空卷积长短记忆力网络输出的隐藏态细胞态时空记忆其包括以下步骤:

[0147]

步骤(9-1),在t-1时刻第k层网络输出的隐藏态和细胞态当前t时刻第k-1层网络输出的隐藏态通过输入门和遗忘门进行更新,得到更新后的细胞态公式如下:

[0148][0149][0150][0151][0152]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,tanh表示双曲正切激活函数σ表示sigmoid函数卷积核卷积核的尺寸均为5

×

5,数量为64

×

64;表示偏差;f

tk

表示辅助变量。

[0153]

步骤(9-2),当前t时刻第k-1层输出的隐藏态时空记忆和步骤(9-1)更新得到的细胞态进行加法融合得到然后输入到注意力模块。在注意力模块中,首先,对沿着通道轴分别应用平均池化操作和最大池化操作,并将平均池化和最大池化的结果按列拼接,再利用卷积核对拼接结果进行卷积运算,把卷积结果输入到sigmoid函数中得到注意力权重矩阵然后,将注意力权重矩阵与注意力模块的输入进行点乘运算,再使用1

×

1的卷积核对进行卷积运算得到时空注意力图,最后与时空记忆进行点乘运

算,更新当前的时空记忆。运算公式如下:

[0154][0155][0156][0157]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;σ表示sigmoid函数avgpool(

·

)表示沿着通道轴的平均池化运算,maxpool(

·

)表示沿着通道轴的最大池化运算;卷积核的尺寸为7

×

7,数量为2

×

1,卷积核的尺寸为1

×

1,数量为64

×

64。

[0158]

步骤(9-3),将t-1时刻第k层输出的隐藏态当前t时刻第k-1层输出的隐藏态更新后的细胞态和时空记忆作为输出门的输入,对隐藏态进行更新得到公式如下:

[0159][0160][0161]

其中,*表示卷积运算,

⊙

表示矩阵的点乘运算,[

·

,

·

]表示两个矩阵按列拼接并保持行不变;tanh表示双曲正切激活函数卷积核w1×1的尺寸为1

×

1,数量为64

×

64,卷积核的尺寸为5

×

5,数量为64

×

64;表示偏差。

[0162]

步骤(10),把步骤(9)输出的隐藏态输入最后的卷积预测层predict_layer,输出网络的预测结果公式如下:

[0163][0164]

其中,*表示卷积运算,卷积核w

predict

的尺寸为1

×

1,数量为64

×

16。

[0165]

步骤(11),将步骤(10)预测输出的图像还原至原图像尺寸大小,将图像的高度和宽度分别乘以patch_size=4,通道数除以patch_size=4的平方,进行维度的调整,得到调整后图像的高度和宽度的高度、宽度和通道数为三元组(140,140,1),完成从输入i

t

到的雷达回波外推。

[0166]

步骤(12),当t=11,12,...,19时,将前一时刻经过predict_layer预测层输出并已转换为原来尺寸的作为输入att-convlstm网络的输入,重复执行步骤(7)至步骤(11),直至t=19,依次得到预测未来时刻的图像序列完成雷达回波序列外推。

[0167]

步骤(13),计算损失函数值。对步骤(12)得到的预测序列和

外推参照序列ground_truths={i

11

,i

12

,...,i

20

}计算均方误差作为损失函数。根据损失函数所得数值计算网络参数的梯度,并更新网络参数,进行反向传播。其包括以下步骤:

[0168]

步骤(13-1),计算损失函数值:

[0169][0170]

其中,i

t,h,w

表示第t个对照样本i

t

第i行、第j列的数值,表示第t个预测数据第i行、第j列的数值。

[0171]

步骤(13-2),计算网络参数梯度,通过对步骤2-17-2的损失函数求每个网络参数的偏导,得到梯度和

[0172][0173][0174]

其中,w

·

表示网络中所有卷积核参数,包括w

init

、、和w

predict

;b

·

表示网络中所有偏置参数,包括和k=0,1,2,3。

[0175]

步骤(13-3),更新网络参数,用当前网络学习率λ=0.001乘以步骤2-17-2计算得到的网络参数梯度,得到网络参数的修正项,然后用原网络参数减去对应的修正项,实现网络参数的更新,公式如下:

[0176][0177]

其中,w'

·

和b'

·

表示更新后的网络参数。

[0178]

步骤2-11,训练集中所有数据都完成一次计算为一轮,重复执行步骤2-3至步骤2-10,直至完成训练最大轮次max_epoch或者达到收敛条件,完成att-convlstm网络训练。

[0179]

步骤3:att-convlstm网络预测。利用步骤2中训练好的att-convlstm网络,以及步骤1中划分得到的测试序列样本集进行预测。预测时,每次从测试序列样本集test_set中读取1个序列样本数据,按照步骤2-4的变换规则,对样本数据进行切片,然后输入到训练好的att-convlstm网络中,得到最终的外推图像序列。

[0180]

本实施例中,步骤3包括以下步骤:

[0181]

步骤3-1,读取测试集样本并切片。每次从测试序列样本集test_set中读取1个序列样本,按照步骤2-4的切片规则,对测试序列样本中每一张图像进行切片。将图像的高度和宽度分别除以切片因子4得到新的高度和宽度,然后通道数乘以切片因子4的平方得到新的通道数,调整图像的高度、宽度和通道数三元组为(35,35,16)。

[0182]

步骤3-2,雷达回波图像外推。将步骤3-1切片后的测试序列样本输入到已经训练好的att-convlstm网络中,经过前向传播,最后得到长度为output_length=10的雷达回波外推图像序列。将该训练好att-convlstm网络在广州天气数据集上进行验证,得到的外推实验结果如图4所示,验证了发明方法的有效性。

[0183]

上述实施例为本发明较佳的实施方式,但本发明的实施方式并不受上述实施例的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1