窑炉表面缺陷检测方法、系统和介质与流程

[0001]

本申请涉及化工和人工智能技术领域,特别地涉及一种窑炉表面缺陷检测方法、窑炉表面缺陷检测系统和一种计算机可读存储介质。

背景技术:

[0002]

窑炉是用耐火材料砌成的用以烧成制品的设备,在陶瓷、水泥、玻璃、冶金化工等诸多领域中都得到了广泛的应用。

[0003]

窑炉的表面状态检测是窑炉使用过程中十分重要的一项日常任务。如果窑炉的表面发生缺陷,高热的内容物一旦发出溢出或喷出,不但会破坏生产环境,而且可能引起操作事故,威胁工作人员的人身安全。

[0004]

现有技术中,对窑炉的表面缺陷,往往是通过人工质检来发现的。由于窑炉表面温度很高,通过人眼难以近距离观察。而且通过人眼观察的方式效率极低,误检率高。

技术实现要素:

[0005]

为了解决或至少部分地解决上述技术问题,本申请提供了一种窑炉表面缺陷检测方法,包括:构建窑炉外表面的第一热成像图;将所得到的第一热成像图通过缺陷检测模型,得出缺陷检测结果;其中,所述缺陷检测模型通过如下步骤获得:记录第一热成像图上的缺陷信息,根据所述缺陷信息构建窑炉缺陷检测数据集,所述窑炉缺陷检测数据集包括训练集和验证集;基于所述窑炉缺陷检测数据集计算先验框参数;以及,利用所述窑炉缺陷检测数据集训练和验证深度学习模型,得到所述缺陷检测模型;其中,利用所述窑炉缺陷检测数据集训练和验证深度学习模型的步骤包括:(1)构建算法网络模型,包括:构建主干特征提取网络,并将该主干网络预先在公开的imagenet图像数据集上进行分类任务预训练,保存预训练网络模型和模型权重文件;(2)构建增加感受野网络;(3)构建特征聚合网络,在特征聚合网络的每一个卷积层后,添加交叉小批量归一化,激活函数mish,组成卷积模块;以及(4)使用所述窑炉缺陷检测数据集的训练集对所构建的算法网络模型进行训练;其中,在使用所述窑炉缺陷检测数据集的训练集对所构建的算法网络模型进行训练的步骤中,加入损失函数,所述损失函数包括回归损失、目标类别分类损失、置信度损失;其中,对缺陷位置回归损失使用ciou损失,对缺陷类别损失和置信度损失使用交叉熵损失函数;计算出总的损失值后进行误差反向传播,使用交叉小批量归一化和mish激活函数,并保存所有训练中验证集中平均精度均值最高的模型,得到训练好的改进的yolov4网络模型。

[0006]

本申请的另一实施方式提供了一种计算机可读存储介质,存储有计算器程序,所述计算机程序在被处理器执行时,能够实现上述的方法。

[0007]

本申请的又一实施方式提供了一种窑炉表面缺陷检测系统,所述系统包括:红外

热像仪,其正对所述窑炉设置;上位机,其与所述红外热像仪通信连接;所述红外热像仪拍摄所述窑炉的第一热成像图并发送给所述上位机;所述上位机用于将所得到的第一热成像图通过缺陷检测模型,得出缺陷检测结果。

[0008]

本申请中,通过缺陷检测模型,能够自动化地对窑炉的表面缺陷进行检测,具有效率高,误检率低的优势。具体来说,本申请对yolov4网络模型的骨干特征网络和特征聚合网络进行了改进。对骨干特征网络的改进之处在于:首先backbone71中采用的残差单元是“denseblock”,该残差单元是借鉴densenet中特征复用的思想并结合mish激活函数而设计的,这样设计能够提升网络参数效率和非线性表达能力;其次,与原yolov4骨干网络利用卷积层进行下采样不同,backbone71下采样层由“过渡层”完成,更加快速。对特征聚合网络的改进之处在于:首先,本文所述的特征聚合网络与原yolov4中panet输入不同,原特征聚合网络输入为骨干网络8倍、16倍和32倍下采样特征图不同。本专利特征聚合网络输入为骨干网络4倍、8倍和16倍下采样特征图,这样的特征图分辨率更高,可提升小缺陷检出率。当然缺点在于该输入特征图含有弱语义特征,这一点可由两次自下而上的特征聚合路径,使得输入到聚合网络的高分辨率特征图整合高维语义信息。此外,本文所述的特征聚合网络与原yolov4中panet特征聚合路径不同,原特征聚合网络采用一次自上而下和自下而上的特征聚合路径,本专利特征聚合网络不仅采用一次自上而下和自下而上的特征聚合,同时为了加强高分辨率弱语义特征图,额外采用了一次自上而下的特征聚合路径,对提升小缺陷的检测率和定位精度提升明显。

附图说明

[0009]

为了更清楚地说明本申请的实施方式,下面将对相关的附图做出简单介绍。可以理解,下面描述中的附图仅用于示意本申请的一些实施方式,本领域普通技术人员还可以根据这些附图获得本文中未提及的许多其他的技术特征和连接关系等。

[0010]

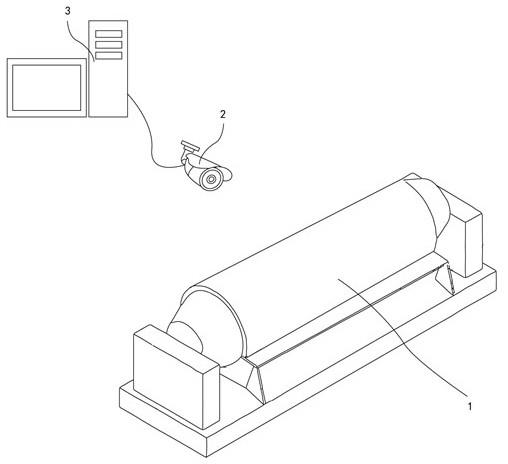

图1是窑炉表面缺陷检测系统的示意图。

[0011]

图2是窑炉表面缺陷检测方法的一种算法网络模型的示意图。

[0012]

图3是图2中一些参数的解释。

[0013]

附图标记:1、窑炉;2、红外热像仪;3、上位机;21、骨干网络71(backbone71);22、改进的panet(modified panet);23、输入(416,416,3);24、cbm

×

3(416,416,32);25、稠密块(denseblock)(208,208,64)

×

4;26、稠密块(104,104,128)

×

8;27、稠密块(52,52,256)

×

8;28、稠密块(26,26,512)

×

8;

29、稠密块(13,13,1024)

×

4;30、过渡层(transition layer);31、卷积(conv);32、卷积

×

2(conv

×

2);33、串联+卷积

×

3(concat+ conv

×

3);34、串联+卷积

×

5(concat+ conv

×

5);35、卷积+上采样(conv+upsampling);36、下采样(downsampling)37、第1个分类和边框预测结果(yolo head1);38、第2个分类和边框预测结果(yolo head2);39、第3个分类和边框预测结果(yolo head3);300、平均池化2

×

2,步长=2;301、卷积k

×

k;302、cmbn;303、mish函数;304、稠密单元;305、稠密块

×

x;306、最大池化5(maxpooling5);307、最大池化9(maxpooling9);308、最大池化13(maxpooling13);以及309、串联(concat)。

具体实施方式

[0014]

下面结合附图,对本申请进行详细说明。

[0015]

下面将描述根据本申请的第一实施方式。在现有技术中,对窑炉的表面缺陷,往往是通过人工质检来发现的。由于窑炉表面温度很高,通过人眼难以近距离观察。

[0016]

本申请的发明人还发现,即便是通过热像仪对窑炉的表面进行观察,依赖于人工判断其表面的缺陷程度,也依然需要占用大量的工时,效率极低,并容易发生误检。

[0017]

有鉴于此,本申请的第一实施方式示意出了一种窑炉表面缺陷检测方法和窑炉表面缺陷检测系统。参见图1,窑炉表面缺陷检测系统包括红外热像仪2和上位机3。在该实施方式中,红外热像仪2正对窑炉1。红外热像仪2是一种利用红外热成像技术,通过对标的物的红外辐射探测,并加以信号处理、光电转换等手段,将标的物的温度分布的图像转换成可视图像的设备。红外热像仪2能够将实际探测到的热量进行精确的量化,以面的形式实时成像标的物的整体,因此能够准确识别正在发热的疑似故障区域。操作人员通过屏幕上显示的图像色彩和热点追踪显示功能来初步判断发热情况和故障部位,同时严格分析,从而在确认问题上体现了高效率、高准确率。

[0018]

在该实施方式中,上位机3与红外热像仪2通信连接。上位机3是指可以直接发出操控命令的计算机,一般可以是计算机、平板电脑等各种终端。在上位机3的屏幕上可以数值化或图形化地显示下位设备所传输过来的诸多信号,并向这些下位设置发送控制命令。

[0019]

红外热像仪2拍摄窑炉1侧壁的热成像图并发送给上位机3,上位机3所获得的热成像图通过缺陷检测模型,得出缺陷检测结果。

[0020]

对本申请的实施方式而言,考虑到大部分的窑炉1是三维立体形状的,因此根据窑炉1的形态,可以沿着窑炉1的外周方向布置多个红外热像仪2,同时进行拍摄并发送给上位机3。

[0021]

另外,可选地,如图1所示的,窑炉1可以为回转窑,又称转床窑、旋转煅烧窑、旋窑,外形类似于转床。回转窑按处理物料不同可分为水泥窑、冶金化工窑和石灰窑。水泥窑主要用于煅烧水泥熟料,分干法生产水泥窑和湿法生产水泥窑两大类。冶金化工窑则主要用于冶金行业钢铁厂贫铁矿磁化焙烧;铬、镍铁矿氧化焙烧;耐火材料厂焙烧高铝钒土矿和铝厂焙烧熟料、氢氧化铝;化工厂焙烧铬矿砂和铬矿粉等类矿物。石灰窑(即活性石灰窑)用于焙烧钢铁厂、铁合金厂用的活性石灰和轻烧白云石。

[0022]

由于回转窑的转床一直在回转,因此可以仅设置一个红外热像仪2即可实现对整个窑炉1的热成像图的获取。此时,窑炉1外表面的第一热成像图,可以通过如下步骤构建:将窑炉1的外表面按照窑炉转角均匀分割为n块,n为大于或等于3的正整数;利用固定设置于窑炉1侧面的红外热像仪2,对窑炉1的侧壁拍摄,获得所述窑炉各个角度的侧壁的热成像图;将所述热成像图先后顺序依次拼接,获得所述窑炉1外表面的第一热成像图。

[0023]

具体说来,可以沿窑炉1的径向均匀分布设置的3至9个传感器。传感器与红外热像仪2通信连接。

[0024]

窑炉1在回转时依次触发传感器,发出开关信号,红外热像仪2在接收到开关信号时拍摄回转窑的侧壁的热成像图并发送给上位机3;上位机3将所获得的热成像图拼合形成第一热成像图,并用于将所得到的第一热成像图通过缺陷检测模型,得出缺陷检测结果。

[0025]

其中,传感器的数量可以根据红外热像仪2的拍摄范围来决定,通常,当红外热像仪2的拍摄角度在60

°

时,传感器的数量可以是6个。所选用的传感器可以是接触传感器,也可以是光电开关传感器,采用传感器控制红外热像仪2能够提高准确性。

[0026]

当然,在已知窑炉1的回转速度的前提下,也可以不设置传感器,改为每经过预定时长进行一次拍摄,可以更大程度地节约成本。

[0027]

值得一提的是,第一热成像图可以为待检测的带电设备的热像图转化而成的灰度图。然后将所述灰度图输入到如上所述训练好的改进的yolov4模型中进行计算,得到缺陷检测结果而缺陷检测结果可以包括故障判断结果(确认是否故障),以及基于所述故障判断结果,也就是说如果故障的话,显示故障的详细信息。

[0028]

据此,本申请的第一实施方式所提供的窑炉表面缺陷检测方法,包括如下步骤:s1、构建窑炉1外表面的第一热成像图;s2、将所得到的第一热成像图通过缺陷检测模型,得出缺陷检测结果。

[0029]

为了针对窑炉1的表面缺陷进行完善的检测,第一热成像图是窑炉1的全景图。显然,无论是设置多个热像仪同时拍摄多张热成像图,还是设置单个热像仪拍摄多次热成像图,都需要对这些热成像图进行拼合,以形成第一个热成像图。其中,拼合图片的技术可以采用现有技术中已经十分成熟的图像拼合方式,因此无需赘述。

[0030]

另外可选地,上位机3还可以设置有告警模块,在缺陷检测结果为负面时,可以及

时地发出警报,以便工作人员处理。

[0031]

相比于现有技术的人工检测而言,本申请的实施方式实现了针对窑炉表面缺陷的自动化、电子化的检测。由于无需人工持续关注即可全天二十四小时获得窑炉表面的工作状态,因此显著地提高了缺陷的检出效率。本申请能够做到将缺陷风险扼杀于摇篮之中,提高了生产环境的安全性。

[0032]

下面将描述根据本申请的第二实施方式。对于本申请第一实施方式而言,可以采用现有技术的各种图像识别算法来对缺陷检测模型进行训练。典型地,可以采用yolov3、yolov4或者改进的yolov4等方式对模型进行训练。然而,窑炉表面缺陷通常都是从很微小的缺陷发展壮大的,因此需要对微小的缺陷做到及时的检测,而现有技术的缺陷检测方式针对微小缺陷的检测精度不足,检测速度也较慢。

[0033]

有鉴于此,本申请的第二实施方式提供了一种窑炉表面缺陷检测方法,第二实施方式的窑炉表面缺陷检测方法是第一实施方式的窑炉表面缺陷检测方法的进一步改进,其主要改进之处在于,本申请的第二实施方式揭示了一种缺陷检测模型的获得步骤,包括:s3、记录第一热成像图上的缺陷信息,根据缺陷信息构建窑炉缺陷检测数据集;s4、基于窑炉缺陷检测数据集,计算先验框参数;s5、利用所述窑炉缺陷检测数据集训练和验证深度学习模型,得到缺陷检测模型。

[0034]

也就是说,在本申请的缺陷检测模型得到实际应用之前,可以通过机器学习的方式训练和提高缺陷检测模型的检测精度和速度。

[0035]

具体说来,本申请的实施方式利用多份具有各种表面缺陷的热成像图,构成用于训练缺陷检测模型的训练集。这些热成像图可以经过如下处理步骤来构成训练集:基于形态学处理和背景差分,截取窑炉外表面区域;通过这一步骤可以避免背景中的其他图像对算法产生不必要的影响。

[0036]

针对第一热成像图是否含有缺陷进行标记;将所标记的含有缺陷目标的图片分类,记录所有缺陷目标的真实边框位置、目标类别信息;针对不同类型的缺陷,构建不同的窑炉缺陷检测数据集,最后按照一定比例将所述窑炉缺陷检测数据集划分为训练集和验证集。

[0037]

训练集用于训练缺陷检测模型,验证集用于验证模型检测精度和速度。通过基于形态学的处理和背景差分,提取出窑炉的外表面区域,然后标记出含有缺陷的图片并分类,同时记录所有缺陷目标的位置、类别信息,就能够构建出不同类型缺陷的窑炉检测数据集。

[0038]

可选地,训练集和验证集的比例可以在6:4至8:2之间,特别可以是7:3的区间范围之内。对数据集,还可以采用平移(translations)、翻转(flips)、旋转(rotations)、缩放和改变背景色温等方式来扩充数据集,以使缺陷检测模型识别能力具有更强的鲁棒性。

[0039]

对于先验框参数,本申请实施方式提供了一种可选的计算方式,在这一方式中,计算先验框参数的步骤包括:确定每个聚类中心所属的特征图层,根据特征图层对应的预设点计算样本权重,根据样本权重,对训练集中所有缺陷目标真实边框的宽、高进行聚类,得到先验框的宽、高,并记录到先验框参数中。

[0040]

在深度学习算法的目标检测中,常常有先验框的一个概念,不管是ssd还是

yolov2、yolov3还是yolov4中,都用到了先验框。简单说来,先验框就是帮助人们定好了常见目标(在本申请中,相当于缺陷特征)的宽和高所框选的范围,从而在进行目标预测的时候,利用先验框进行处理。

[0041]

更具体地,本申请的实施方式中的先验框参数的计算,可以包括如下步骤:s41、收集所有真实框的坐标;其中,是真实框的中心点,是真实框的宽和高,n是所有真实框的个数;s42、给定k个聚类中心点;其中w

j

和h

j

分别是先验框的宽和高;s43、假设每个真实框的中心点都与聚类中心重合,计算每个真实框和每个聚类中心点的距离d:;其中,,iou(intersection over union)为重叠度,是一种测量在特定数据集中检测相应物体准确度的一个标准。c代表的是能够同时包含预测框和真实框的最小闭包区域的对角线距离。

[0042]

s44、将真实框分配给聚类中心,对每个簇重新计算聚类中心点w

’

:;其中,n

i

是第i个簇的标注框个数;s45、重复计算距离d和聚类中心点w

’

的步骤,直到聚类中心的改变量小于预设比例,得到先验框参数。

[0043]

其中,预设比例的越大,则先验框参数的计算效率越快,但反过来精确度也越差。综合效率和精度的考量,预设比例可以在5%至10%的范围之内。

[0044]

值得一提的是,尽管本实施方式仅给出了一种缺陷检测模型的训练方法,本领域普通技术人员通过其他的方法训练并得到缺陷检测模型也是可行的。

[0045]

对于缺陷检测模型的获得,本申请实施方式同样提供了一种可选的方式,在这一方式中,利用窑炉缺陷检测数据集训练和验证深度学习模型的步骤包括:s51、构建算法网络模型,包括:构建主干特征提取网络,并将该主干网络预先在公开的imagenet图像数据集上进行分类任务预训练,保存预训练网络模型和模型权重文件。

[0046]

在计算机视觉领域,卷积神经网络(cnn)已经成为最主流的方法。cnn史上的一个里程碑事件是resnet模型的出现,resnet可以训练出更深的cnn模型,从而实现更高的准确度。resnet模型的核心是通过建立前面层与后面层之间的“短路连接”(shortcuts,skip connection),这有助于训练过程中梯度的反向传播,从而能训练出更深的cnn网络。densenet模型的基本思路与resnet一致,但是它建立的是前面所有层与后面层的密集连接(dense connection),它的名称也是由此而来。densenet的另一大特色是通过特征在

channel上的连接来实现特征重用(feature reuse)。这些特点让densenet在参数和计算成本更少的情形下实现比resnet更优的性能。因此,本申请的实施方式中可以采用改进的密集连接的跨层网络(modified densenet)作为主干特征提取网络,相比于yolov4网络的原始主干特征提取网络cspdarknet53而言,仅仅只需要更少的参数,不需要重复学习多余的特征,具有更好的参数有效性,而且“稠密”的设计还改善了整个网络的信息流和梯度。

[0047]

s52、构建增加感受野网络(spp)。

[0048]

在机器视觉领域的深度神经网络中有一个概念叫做感受野,用来表示网络内部的不同位置的神经元对原图像的感受范围的大小。神经元之所以无法对原始图像的所有信息进行感知,是因为在这些网络结构中普遍使用卷积层和pooling层,在层与层之间均为局部相连(通过sliding filter)。神经元感受野的值越大表示其能接触到的原始图像范围就越大,也意味着他可能蕴含更为全局、语义层次更高的特征;而值越小则表示其所包含的特征越趋向于局部和细节。因此感受野的值可以大致用来判断每一层的抽象层次。

[0049]

本申请的实施方式中,通过增加感受野网络,增强了模型对小目标的检测效果。

[0050]

s53、构建特征聚合网络(modified panet),在特征聚合网络的每一个卷积层后,添加交叉小批量归一化,激活函数层mish,组成卷积模块。

[0051]

s54、使用所述窑炉缺陷检测数据集的训练集对所构建的算法网络模型进行训练。

[0052]

基于以上步骤,可选地,本申请的实施方式给出了更为具体的算法网络模型的结构。具体说来,在利用所述窑炉缺陷检测数据集缺陷数据集训练和验证深度学习模型的步骤中,算法网络模型的结构如下:主干特征提取网络,基于改进的密集连接的跨层网络(modified densenet),包括:若干层卷积层;以及,若干个稠密块层和分散设置于这些稠密块层之间的若干个过渡层;增加感受野网络;以及,特征聚合网络。

[0053]

其中,更为具体地,卷积层包括:若干个cbm卷积块,每个cbm卷积块包括:卷积、交叉小批量归一化(cross mini-batch normalization,cmbn)和mish激活函数。

[0054]

依据以上结构,本申请给出了一种主干特征提取网络 (改进的密集连接的跨层网络)的结构,示例如下:第1-3层由3个cbm卷积块组成,每个cbm由卷积(convolution,conv)、交叉小批量归一化(cross mini-batch normalization, cmbn )和mish激活函数组成,第1-3层中3个cbm模块的卷积核大小均为3x3,卷积核大小为3x3,步长分别为1,1,2;第4~11层为4个稠密块,每个稠密块由两个卷积块组成,第1个卷积块中卷积核大小为1

×

1,步长为1,主要用来调整通道数,第2个卷积块中卷积核大小为3

×

3,步长为1,主要用来提取特征;第12层为1个过渡层,由一个卷积块和一个池化层组成,卷积块中卷积核大小为1

×

1,步长为1,池化层为平均池化,池化核大小为2

×

2,步长为2;第13~28层为8个稠密块,每个稠密块由两个卷积块组成,第1个卷积块中卷积核大小为1

×

1,步长为1,第2个卷积块中卷积核大小为3

×

3,步长为1;第29层为1个过渡层,由卷积层和池化层组成,卷积块中卷积核大小为1

×

1,步长为1,

池化层为平均池化,池化核大小为2

×

2,步长为2;第30~45层为8个稠密块,每个稠密块由两个卷积块组成,第1个卷积块中卷积核大小为1

×

1,步长为1,第2个卷积块中卷积核大小为3

×

3,步长为1;第46层为1个过渡层,由卷积块和池化层组成,卷积块中卷积核大小为1

×

1,步长为1,池化层为平均池化,池化核大小为2

×

2,步长为2;第47~62层为8个稠密块,每个稠密块由两个卷积块组成,第1个卷积块中卷积核大小为1

×

1,步长为1,第2个卷积块中卷积核大小为3

×

3,步长为1;第63层为1个过渡层,由卷积块和池化层组成,卷积块中卷积核大小为1

×

1,步长为1,池化层为平均池化,池化核大小为2

×

2,步长为2;第64~71层为4个稠密块,每个稠密块由两个卷积块组成,第1个卷积块中卷积核大小为1

×

1,步长为1,第2个卷积块中卷积核大小为3

×

3,步长为1。

[0055]

针对这一主干特征提取网络的训练,首先可以将该主干特征提取网络预先在公开数据集(imagenet数据集)上进行分类任务预训练,在训练中设置批次大小(batch size)为32,训练迭代次数(epoch)为50次,使用交叉小批量归一化(cross mini-batch normalization, cmbn )和mish激活函数,最后保存预训练网络模型和模型权重文件。

[0056]

更为具体地,增加感受野网络,则可以包括将主干特征提取网络得到的特征图层经过若干个卷积层后送入spp模块,将所得到的特征图层进行串联操作,再经过若干个卷积层。

[0057]

依据以上结构,本申请给出了一种增加感受野网络的结构,示例如下:第72~76层,可以采用类似于现有技术的yolov4中的空间金字塔池化层(spp)来增加感受野。首先将第71层网络得到的特征图层经过2个卷积层,送入空间金字塔池化层,这2个卷积层中卷积核大小均为3

×

3,步长均为1。

[0058]

空间金字塔池化层由四个并行的最大池化层组成,池化核大小分别为5

×

5、9

×

9、13

×

13和1

×

1,步长均为1。随后将所得特征图层进行串联操作(concatenation),经过3个卷积层,送入特征聚合网络(panet),其中三个卷积层的卷积核大小均为3

×

3,步长均为1。

[0059]

更为具体地,改进的特征聚合网络(modified panet)可以包括:l1、上采样+卷积层;l2、将主干特征提取网络中的稠密块层得到的第一特征图层经卷积操作后,与上采样+卷积层得到的第二特征图层串联,再经过n个卷积层;重复m次l1和l2的层,m和n均为大于或等于1的正整数;l3、将上一层得到的第三特征图层进行下采样,与第一特征图层进行串联后,再经过n个卷积层;重复m次l3的层,在l2的层中,每次从主干特征提取网络中的不同的稠密块层得到的第一特征图层,且在l3的层中所串联的第一特征图层与l2的层中所提取的层逆序对应;l4、重复m次将上一层的特征图层与l3中的各个层的特征图层分别进行串联,再经过若干个卷积层的步骤,并在每次重复步骤中输出边框预测结果。

[0060]

依据以上结构,本申请给出了一种特征聚合网络的结构,示例如下:第77层为一个卷积层和上采样层,卷积核大小为1

×

1,步长为1;第78~82层是将62层得到的特征图层经过卷积核大小为1

×

1,步长为1的卷积操作后,

与第77层得到的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第83层为一个卷积层和上采样层,卷积核大小为1

×

1,步长为1;第84~88层是将45层得到的特征图层经过卷积核大小为1

×

1,步长为1的卷积操作后,与第83层得到的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第89层为一个卷积层和上采样层,卷积核大小为1

×

1,步长为1;第90~94层是将28层得到的特征图层经过卷积核大小为1

×

1,步长为1的卷积操作后,与89层得到的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第95~99层是上一层得到的特征图层进行下采样,与第88层得到的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第100-104层是将上一层得到的特征图层进行下采样,与第82层得到的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第105~109层是将上一层得到的特征图层进行下采样,与第76层得到的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第110层为一个卷积层和上采样层,卷积核大小为1

×

1,步长为1;第111~115层是将上一层的特征图层与第104层的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第116层为一个卷积层和上采样层,卷积核大小为1

×

1,步长为1;第117~121层是将上一层的特征图层与第99层的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第122层为一个卷积层和上采样层,卷积核大小为1

×

1,步长为1;第123~127层是将上一层的特征图层与第94层的特征图层进行串联后,再经过5个卷积层,卷积核大小依次为1*1、3*3、1*1、3*3和1*1,步长均为1;第1个分类和边框预测结果(yolo head1)是第115层输出;第2个分类和边框预测结果(yolo head2)是第121层输出;第3个分类和边框预测结果(yolo head3)是第127层输出。

[0061]

在上述实施方式中,第1个分类和边框预测结果包括尺寸为3*3、步长为1的2维卷积,以及尺寸为1*1、步长为1的2维卷积,输出特征图尺寸为52*52*18,其中52*52是特征图平面尺寸,18是特征图通道数。第2个分类和边框预测结果包括尺寸为3*3、步长为1的2维卷积,以及尺寸为1*1、步长为1的2维卷积,输出特征图尺寸为26*26*18,其中26*26是特征图平面尺寸,18是特征图通道数。第3个分类和边框预测结果包括尺寸为3*3、步长为1的2维卷积,以及尺寸为1*1、步长为1的2维卷积,输出特征图尺寸为13*13*18,其中13*13是特征图平面尺寸,18是特征图通道数。其中三个分类和边框预测结果都具有18个通道,以第3个分类和边框预测结果(yolo head3)中1*1*18为例,第1~6为第一个预测框的参数,7~12为第二个预测框的参数,13~18为第三个预测框的参数。第一个预测框的参数中,第1个参数是预测框的置信度;第2个参数是框内是窑炉缺陷的概率;第3~6个参数是预测框的4个位置调整参数,第二和第三个预测框的参数与第一个预测框的参数顺序一致。

[0062]

上述算法网络的示例参见图2和图3所示。可以理解地,在本申请实施方式的示例

中,为了表述清楚,对各个网络的层、块、核大小、步长等等都作出了具体的示例。但这些数值均为示例性的说明,在实际使用中,本领域普通技术人员可以根据实际需要修改层数、块数、核大小、步长等等。

[0063]

在图2中,在每一个卷积层(conv)后,都添加了交叉小批量归一化(cmbn)以及激活函数层mish组成卷积模块cbm。

[0064]

现有技术的yolov4网络的主干特征提取网络cspdarknet53主要采用残差模块resblock进行特征提取,然而残差模块具有比较明显的冗余性和过拟合现象,本申请的实施方式改进的算法调整了网络结构,选用稠密块denseblock作为主干提取网络。densenet的一个最大的优势就是比传统卷积神经网络需要更少的参数,不需要重复学习多余的特征图层,具有更好的参数有效性,而且“稠密”的设计还改善了整个网络的信息流和梯度,因此采用稠密块构成的主干网络能够提取到更加有效的特征,同时考虑到分类网络侧重于平移不变性,而目标检测网络需要对平移敏感,因此将denseblock结合cspdarknet53的架构设计了backbone71。实验验证backbone71作为主干特征提取网络能够提取到更利于目标检测的有效的特征,而且还能降低模型过拟合,使得模型泛化能力更强。骨干网络71(backbone71)21和改进的panet 22之间通过卷积31连接。

[0065]

本申请的实施方式相对于现有技术改进了特征聚合网络(panet),使得特征融合后模型对小目标检测效果更佳。增加了一条从深层特征层向浅层特征层融合的通路,通过反复融合高低层语义信息使得具有检测小缺陷的特征层融合了更多深层特征信息。在窑炉表面缺陷检测的问题中,缺陷在形态和尺寸上差异较大,但在信号表现上差异却不大。若使用现有技术的yolov4网络进行检测,其对微小缺陷的检测效果较差。因此对于此类高复杂度的数据需要拟合能力更强的深层网络。与之相比,本申请实施方式改进后的特征聚合网络(panet),首先新的特征图层不仅继承了骨干网络(backbone)输出的深层特征,同时也包含了浅层特征。增加网络深度,能够使得模型具有更强的拟合能力,能够分辨出窑炉不同形态、不同尺寸和不同种类。而且,本申请实施方式的特征聚合网络通过反复融合高低层特征提升目标检测的效果,并设计了至少两次自下而上的路径增强,加强了各层通道特征融合,同时改进部分的结构本身不到20层,能较好地保留浅层特征信息,这有利于提高小缺陷的检出率。特征聚合网络的改进首先体现在设置了两次自上而下的特征聚合路径,自上而下的路径和横向连接结合低层高分辨率的特征,可把高层的特征传下来,补充低层的语义,可以获得高分辨率、强语义的特征有利于小目标的检测。特征聚合网络的改进还体现在设置了自上而下的特征聚合路径,自上而下的路径结合横向连接结合高层低分辨率的特征,可把低层的特征传上来,补充高层的语义,可以获得低分辨率、更精确位置的特征,有利于大目标的检测。参考图2,自下而上的路径是指从卷积+上采样(conv+upsampling)35到串联+卷积

×

5(concat+ conv

×

5)34的特征传递。特征聚合网络的改进首先体现在自上而下的路径是指从串联+卷积

×

5(concat+ conv

×

5)34到下采样(downsampling)36的特征传递。

[0066]

本申请所针对的问题是检测窑炉表面缺陷,尤其是微小缺陷(其所占整幅图像的比例较小)。在这一前提下,以输入大小为416*416的图片为例,现有技术的yolov4网络最终划分的网格大小分别为52*52、26*26、13*13,对于原始图像的尺寸缩放问题比较严重。因此现有技术的yolov4网络对于窑炉表面微小缺陷的检测效果不佳。本申请的实施方式所提供的改进后的算法网络模型结构,其最终划分的网格大小分别为104*104、52*52、26*26,也就

是说,本申请实施方式将现有技术的yolov4中深层的用于检测大尺寸缺陷的特征层(13*13)改为融合了深层特征的用于检测大尺寸缺陷的特征层(104*104)。结合本申请实施方式所改进的特征聚合网络(panet),104*104的特征层能够融合更多语义信息,对于窑炉表面微小缺陷的检测具有更好的效果。

[0067]

另外,可选地,在使用所述缺陷检测数据集窑炉缺陷检测数据集的训练集对所构建的算法网络模型进行训练的步骤中还可以加入损失函数。

[0068]

损失函数(loss function)或代价函数(cost function)是将随机事件或其有关随机变量的取值映射为非负实数以表示该随机事件的“风险”或“损失”的函数。在本申请的实施方式中,损失函数可以包括:回归损失、目标类别分类损失、置信度损失;其中,对缺陷位置回归损失使用ciou损失,对缺陷类别损失和置信度损失使用交叉熵损失函数;目标位置的回归loss计算公式如下:;;其中,b和b

gt

分别代表了预测框和真实框的中心点,ρ代表的是计算两个中心点间的欧式距离。c代表的是能够同时包含预测框和真实框的最小闭包区域的对角线距离。α是大于零的权重参数,而v是用来度量长宽比的相似性。

[0069]

计算出总的损失值后进行误差反向传播。其中,本申请实施方式给出典型的一些训练参数,例如优化器可以选用sgd,设置初始学习率为0.01,衰减率decay=0.0001,动量momentum=0.9,当误差变化很平缓时令学习率减小10倍。设置批次大小为16,训练迭代次数为100次。使用交叉小批量归一化和mish激活函数,避免出现网络退化现象并加速网络训练,并保存所有训练中验证集中平均精度均值(map)最高的模型,得到训练好的改进的yolov4网络模型。其中,可以在每迭代10次时保存一次模型、模型参数及训练结果,最终保存所有训练中验证集中map最高的模型、模型参数及训练结果。

[0070]

在所述使用所构建的算法网络模型,对所述窑炉缺陷检测数据集的训练集进行训练的步骤中,使用改进的yolov4网络模型及参数对验证集进行预测得到预测结果(yolohead1~ yolohead3),对预测结果(yolohead1~ yolohead3)用ciou-nms(非极大值抑制)模块进行后处理得到输出(output),基于所述输出(output)计算训练好的改进的yolov4网络模型的检测精度、精确率(precision)和召回率(recall)、平均精度均值(mean average precision, map)等相关数据,记录检测结果;其中precision、recall和map计算公式如下: ; ;

ꢀ

;式中,tp为网络模型成功预测的正例, fp为被网络模型误判为正例的负例,fn表示被网络模型错误预测为负例的正例,ap(i)为某一部位的检测精度,n为部位的数量。表1显示了yolov4改进前后性能对比结果如下所示:表1 yolov4改进前后性能对比。

[0071]

表1中运行的硬件条件为gpu:1080ti。从表1中可以看出改进前后的yolov4的速度接近,而改进后的yolov4较改进前map增长了19.4%,特别在小缺陷上检出率改善明显,提升了42.1%,有效提高了检测精度。

[0072]

下面将描述本申请的第三实施方式。本申请的第三实施方式提供了一种计算机可读存储介质,存储有计算器程序,计算机程序在被处理器执行时,能够实现第一、第二实施方式的方法,取得第一、第二实施方式所提及的有益效果。

[0073]

本实施方式所指的处理器可以是中央处理单元(central processing unit,cpu),但在替换方案中,该处理器可以是任何常规的处理器、控制器、微控制器、状态机、数字信号处理器 (digital signal processor,dsp)、专用集成电路 (application specific integrated circuit,asic)、现成可编程门阵列 (field-programmable gate array,fpga) 或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。处理器还可以被实现为计算设备的组合,例如dsp与微处理器的组合、多个微处理器、与dsp核心协作的一个或多个微处理器、或任何其他此类配置。

[0074]

在一个或多个示例性实施例中,所描述的功能可在硬件、软件、固件或其任何组合中实现。如果在软件中实现为计算机程序产品,则各功能可以作为一条或更多条指令或代码存储在计算机可读介质上或藉其进行传送。计算机可读介质包括计算机存储介质和通信介质两者,其包括促成计算机程序从一地向另一地转移的任何介质。存储介质可以是能被计算机访问的任何可用介质。作为示例而非限定,这样的计算机可读介质可包括ram、rom、eeprom、cd-rom或其它光盘存储、磁盘存储或其它磁存储设备、或能被用来携带或存储指令或数据结构形式的合意程序代码且能被计算机访问的任何其它介质。任何连接也被正当地称为计算机可读介质。例如,如果软件是使用同轴电缆、光纤电缆、双绞线、数字订户线(dsl)、或诸如红外、无线电、以及微波之类的无线技术从web网站、服务器140、或其它远程源传送而来,则该同轴电缆、光纤电缆、双绞线、dsl、或诸如红外、无线电、以及微波之类的无线技术就被包括在介质的定义之中。如本文中所使用的盘和碟包括压缩碟(cd)、激光碟、光碟、数字多用碟(dvd)、软盘和蓝光碟,其中盘往往以磁的方式再现数据,而碟用激光以光学方式再现数据。上述的组合也应被包括在计算机可读介质的范围内。作为替换方案,存储介质可以被整合到处理器中。处理器和存储介质可驻留在asic中。asic可驻留在用户终端中。或者在替换方案中,处理器和存储介质也可作为分立组件驻留在用户终端中。

[0075]

最后,虽然仅结合有限数量的实施方案详细描述了本申请,但应当容易理解的是,

本申请不限于此类公开的实施方案。相反,本申请能够被修改以并入在此此前未描述的、但与本申请的精神和范围相称的任何数量的变化、更改、替换或等同布置。另外,虽然已经描述了本申请的各种实施方案,但应当理解,本申请的各方面可以仅包括所描述的实施方案中的一些。因此,本申请不应当被视为受前述描述的限制,而是仅由所附权利要求书的范围限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1