音频分析方法、装置、设备及存储介质与流程

本公开涉及计算机,尤其涉及一种音频分析方法、装置、设备及存储介质。

背景技术:

1、随着终端(例如手机)录制歌曲功能的广泛应用,对录制歌曲内的歌声进行智能评价、修饰和合成等的衍生功能也得到了普及。这些衍生功能在实现时,一般需要对歌声的特征进行准确地分析处理,以保证处理后的结果符合用户的主观感知。

2、由于对歌声的特征进行分析处理涉及的技术实现复杂度较高,通常需要占用较多的存储资源和计算资源等,通用技术中一般是采用将相关实现算法等资源文件部署在云端服务器中,通过云端服务器进行分析处理的方式。

3、这种依赖服务器进行处理的方式,需要将终端的数据传输至云端服务器,容易出现由数据传输错误导致的处理结果中时间和歌声错位的现象,造成分析结果的准确率较低,容易影响用户体验。并且,在海量用户并发使用的情况下,这种依赖服务器进行处理的方式对服务器的计算容量要求较高,容易导致较高的服务器的部署成本。

技术实现思路

1、本公开提供一种音频分析方法、装置、设备及存储介质,用于解决通用技术在对终端的音频数据进行处理时准确率较低且成本较高的问题。

2、本公开实施例的技术方案如下:

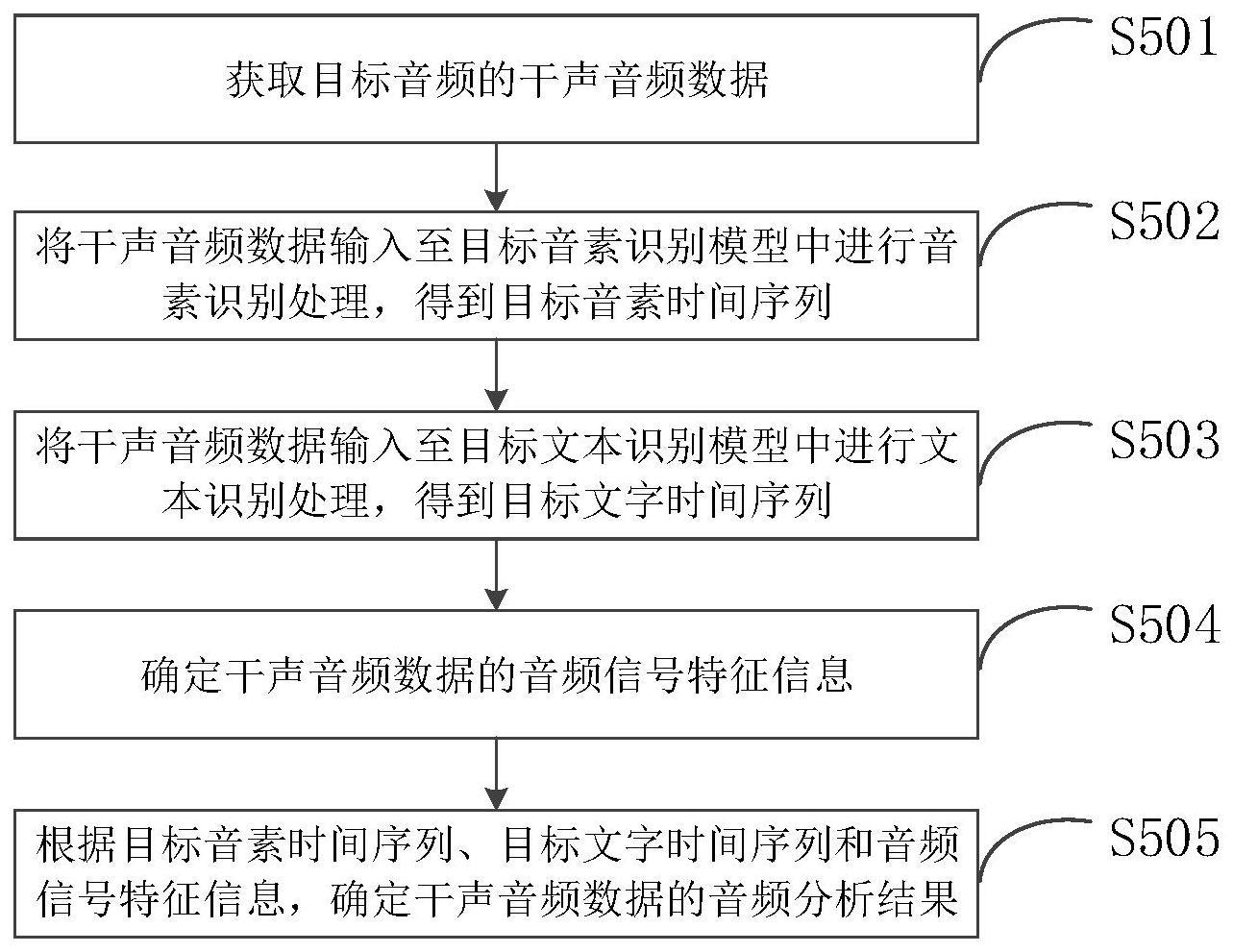

3、根据本公开实施例的第一方面,提供一种音频分析方法,包括:获取目标音频的干声音频数据;将干声音频数据输入至目标音素识别模型中进行音素识别处理,得到目标音素时间序列;目标音素识别模型为基于多个语种进行同音合并后的音素集合训练得到的;目标音素时间序列包括干声音频数据中各音素发音时段对应的至少一个候选识别音素;将干声音频数据输入至目标文本识别模型中进行文本识别处理,得到目标文字时间序列;目标文本识别模型为基于目标音频的歌词信息训练得到的;目标文字时间序列包括干声音频数据中各文字发音时段对应的目标识别文字;确定干声音频数据的音频信号特征信息;根据目标音素时间序列、目标文字时间序列和音频信号特征信息,确定干声音频数据的音频分析结果;音频分析结果用于表征目标音频的发音节奏、发音力度和发音精度。

4、可选地,确定干声音频数据的音频信号特征信息的方法,具体包括:将干声音频数据划分为多个预设长度的音频数据帧;确定各音频数据帧的基音频率值和响度值,得到音频信号特征信息。

5、可选地,根据目标音素时间序列、目标文字时间序列和音频信号特征信息,确定干声音频数据的音频分析结果的方法,具体包括:对目标文字时间序列进行音素切分处理,得到切分后音素时间序列;切分后音素时间序列包括各目标识别文字对应的至少一个切分后音素,以及各切分后音素的开始时刻和终止时刻;基于切分后音素时间序列和各音频数据帧的基音频率值,确定用于表征目标音频的发音节奏的节拍点时间序列;根据节拍点时间序列中各音素开始时刻和终止时刻之间的音频数据帧的响度值,确定节拍点时间序列中各音素的响度值,得到用于表征目标音频的发音力度的响度值时间序列;基于切分后音素时间序列和目标音素时间序列,确定用于表征目标音频的发音精度的精度值时间序列。

6、可选地,基于切分后音素时间序列和各音频数据帧的基音频率值,确定用于表征目标音频的发音节奏的节拍点时间序列的方法,具体包括:将各切分后音素中预设类型音素的开始时刻确定为候选节拍点,得到与多个预设类型音素一一对应的多个候选节拍点;预设类型音素包括元音音素;基于各音频数据帧的基音频率值对多个候选节拍点进行更新处理,得到与多个预设类型音素一一对应的多个更新后节拍点;更新后节拍点对应的音频数据帧的基音频率值大于预设阈值;将多个预设类型音素的开始时刻对应调整为多个更新后节拍点,得到节拍点时间序列。

7、可选地,根据节拍点时间序列中各音素开始时刻和终止时刻之间的音频数据帧的响度值,确定节拍点时间序列中各音素的响度值,得到用于表征目标音频的发音力度的响度值时间序列的方法,具体包括:按照响度值从大到小的顺序,对节拍点时间序列中各音素开始时刻和终止时刻之间的音频数据帧进行排序,得到节拍点时间序列中各音素对应的响度值排序结果;将各响度值排序结果中的前预设数量个响度值的平均值,确定为节拍点时间序列中各音素对应的响度值,得到响度值时间序列。

8、可选地,基于切分后音素时间序列和目标音素时间序列,确定用于表征目标音频的发音精度的精度值时间序列的方法,具体包括:确定各音素发音时段对应的至少一个候选识别音素中,符合预设条件的候选识别音素的第一数量;将各音素发音时段对应的第一数量和第二数量之间的比值,确定为切分后音素时间序列中各切分后音素的精度值,得到精度值时间序列;第二数量为发音时段对应的至少一个候选识别音素的数量。

9、可选地,获取目标音频的干声音频数据的方法,具体包括:响应于对目标音频触发的录制操作指令,获取目标音频对应的配乐音频数据;播放配乐音频数据,并录制目标音频的干声音频数据。

10、可选地,响应于对目标音频触发的录制操作指令,获取目标音频的配乐音频数据的方法,具体包括:响应于录制操作指令,向服务器发送配乐资源请求消息;配乐资源请求消息用于请求目标音频对应的配乐音频数据;接收服务器发送的目标音频对应的配乐音频数据。

11、可选地,该音频分析方法,还包括:响应于录制操作指令,向服务器发送模型资源请求消息;模型资源请求消息用于请求目标音素识别模型的资源文件和目标文本识别模型的资源文件;接收服务器发送的目标音素识别模型的资源文件和目标文本识别模型的资源文件。

12、根据本公开实施例的第二方面,提供一种音频分析装置,包括:获取单元、处理单元和确定单元;

13、获取单元,被配置为执行获取目标音频的干声音频数据;

14、处理单元,被配置为执行将干声音频数据输入至目标音素识别模型中进行音素识别处理,得到目标音素时间序列;目标音素识别模型为基于多个语种进行同音合并后的音素集合训练得到的;目标音素时间序列包括干声音频数据中各音素发音时段对应的至少一个候选识别音素;

15、处理单元,还被配置为执行将干声音频数据输入至目标文本识别模型中进行文本识别处理,得到目标文字时间序列;目标文本识别模型为基于目标音频的歌词信息训练得到的;目标文字时间序列包括干声音频数据中各文字发音时段对应的目标识别文字;

16、确定单元,被配置为执行确定干声音频数据的音频信号特征信息;

17、确定单元,还被配置为执行根据目标音素时间序列、目标文字时间序列和音频信号特征信息,确定干声音频数据的音频分析结果;音频分析结果用于表征目标音频的发音节奏、发音力度和发音精度。

18、可选地,确定单元,具体被配置为执行:将干声音频数据划分为多个预设长度的音频数据帧;确定各音频数据帧的基音频率值和响度值,得到音频信号特征信息。

19、可选地,确定单元,具体被配置为执行:对目标文字时间序列进行音素切分处理,得到切分后音素时间序列;切分后音素时间序列包括各目标识别文字对应的至少一个切分后音素,以及各切分后音素的开始时刻和终止时刻;基于切分后音素时间序列和各音频数据帧的基音频率值,确定用于表征目标音频的发音节奏的节拍点时间序列;根据节拍点时间序列中各音素开始时刻和终止时刻之间的音频数据帧的响度值,确定节拍点时间序列中各音素的响度值,得到用于表征目标音频的发音力度的响度值时间序列;基于切分后音素时间序列和目标音素时间序列,确定用于表征目标音频的发音精度的精度值时间序列。

20、可选地,确定单元,具体被配置为执行:将各切分后音素中预设类型音素的开始时刻确定为候选节拍点,得到与多个预设类型音素一一对应的多个候选节拍点;预设类型音素包括元音音素;基于各音频数据帧的基音频率值对多个候选节拍点进行更新处理,得到与多个预设类型音素一一对应的多个更新后节拍点;更新后节拍点对应的音频数据帧的基音频率值大于预设阈值;将多个预设类型音素的开始时刻对应调整为多个更新后节拍点,得到节拍点时间序列。

21、可选地,确定单元,具体被配置为执行:按照响度值从大到小的顺序,对节拍点时间序列中各音素开始时刻和终止时刻之间的音频数据帧进行排序,得到节拍点时间序列中各音素对应的响度值排序结果;将各响度值排序结果中的前预设数量个响度值的平均值,确定为节拍点时间序列中各音素对应的响度值,得到响度值时间序列。

22、可选地,确定单元,具体被配置为执行:确定各音素发音时段对应的至少一个候选识别音素中,符合预设条件的候选识别音素的第一数量;将各音素发音时段对应的第一数量和第二数量之间的比值,确定为切分后音素时间序列中各切分后音素的精度值,得到精度值时间序列;第二数量为发音时段对应的至少一个候选识别音素的数量。

23、可选地,获取单元,具体被配置为执行:响应于对目标音频触发的录制操作指令,获取目标音频对应的配乐音频数据;播放配乐音频数据,并录制目标音频的干声音频数据。

24、可选地,获取单元,具体被配置为执行:响应于录制操作指令,向服务器发送配乐资源请求消息;配乐资源请求消息用于请求目标音频对应的配乐音频数据;接收服务器发送的目标音频对应的配乐音频数据。

25、可选地,获取单元,还被配置为执行响应于录制操作指令,向服务器发送模型资源请求消息;模型资源请求消息用于请求目标音素识别模型的资源文件和目标文本识别模型的资源文件;接收服务器发送的目标音素识别模型的资源文件和目标文本识别模型的资源文件。

26、根据本公开实施例的第三方面,提供一种电子设备,包括:处理器;用于存储处理器可执行指令的存储器;其中,处理器被配置为执行指令,以实现如第一方面中任一项的音频分析方法。

27、根据本公开实施例的第四方面,提供一种计算机可读存储介质,计算机可读存储介质上存储有指令,当计算机可读存储介质中的指令由电子设备的处理器执行时,使得电子设备能够执行如第一方面中任一项的音频分析方法。

28、根据本公开实施例的第五方面,提供一种计算机程序产品,该计算机程序产品包括计算机指令,当计算机指令在终端的处理器上运行时,使得电子设备执行如第一方面中任一种可选地实现方式所述的音频分析方法。或者,当计算机指令在服务器的处理器上运行时,使得电子设备执行如第二方面中任一种可选地实现方式所述的音频分析方法。

29、应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

30、本公开的实施例提供的技术方案至少带来以下有益效果:

31、基于上述任一方面,本公开中,终端在获取目标音频的干声音频数据后,可以将干声音频数据输入至目标音素识别模型中进行音素识别处理,得到目标音素时间序列,并可以将干声音频数据输入至目标文本识别模型中进行文本识别处理,得到目标文字时间序列,以及确定干声音频数据的音频信号特征信息,以进一步根据目标音素时间序列、目标文字时间序列和音频信号特征信息,确定干声音频数据的音频分析结果。其中,目标音素时间序列包括干声音频数据中各音素发音时段对应的至少一个候选识别音素。目标文字时间序列包括干声音频数据中各文字发音时段对应的目标识别文字。音频分析结果用于表征目标音频的发音节奏、发音力度和发音精度。

32、由于,目标音素识别模型为基于多个语种进行同音合并后的音素集合训练得到的,且目标文本识别模型为基于目标音频的歌词信息训练得到的。也就是说,目标音素识别模型训练时仅基于较少的音素数量,且可以同时识别多种语种的音素。目标文本识别模型训练时仅基于目标音频的歌词信息,被约束为只能识别出目标音频的歌词中所包括的文字。因此,本公开可以在降低识别解码的复杂度,保证模型体积满足终端运行要求的同时,保证识别结果的准确性。

33、这样一来,相比于通用技术中依赖服务器对音频的干声音频数据进行处理的方式,本公开通过降低音频分析过程的复杂度,可以支持将数据处理过程转移到终端进行,且同时可以保证音频分析过程的准确性,从而可以避免将音频的干声音频数据传输至服务器的过程中,由传输错误导致的音频分析结果中时间和歌声错位的现象,可以保证用户体验。并且,本公开不需要依赖较多的云端服务器进行数据处理,可以避免通用技术中存在的部署成本较高的问题。因此,本公开可以用于解决通用技术在对终端的音频数据进行处理时准确率较低且成本较高的问题。

- 还没有人留言评论。精彩留言会获得点赞!