一种室内环境机器人导航自然语言指令生成方法

1.本发明涉及计算机视觉与自然语言生成领域,尤其是涉及一种室内环境机器人导航自然语言指令生成方法。

背景技术:

2.视觉语言导航任务是人工智能的重要研究任务,是计算机视觉与自然语言处理跨模态交叉研究领域的代表性问题之一,该任务旨在使用自然语言向机器人下达路径指令,机器人自主分析并判断语言指令所代表的目标方向,根据实时反馈的视觉图像调整行为与规划路径。

3.然而,使用人工标注自然语言指令非常耗时耗力,因此,不少研究证明引入自回归的指令语言生成模型可以有效提升现有机器人在视觉语言导航任务上的训练精度,但是现有用于指导机器人导航的自然语言指令生成模型都依赖于结构相对简单的rnn时序模型,其具有捕捉长依赖性能较差、串行运行速度较慢、输出句子语义稀缺的缺点。

技术实现要素:

4.本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种室内环境机器人导航自然语言指令生成方法。

5.本发明的目的可以通过以下技术方案来实现:

6.一种室内环境机器人导航自然语言指令生成方法,包括以下步骤:

7.s1、利用深度卷积神经网络提取机器人摄像头采集到的全景图像的图像特征向量;

8.s2、获取机器人当前的偏移角度并通过三角变换扩充数据维度后与图像特征向量进行拼接,形成对应的动作特征向量和全景图像特征向量;

9.s3、采用多头注意力对动作特征向量和全景图像特征向量进行对齐和降维计算,使机器人关注环境中更重要的视觉内容;

10.s4、采用序列到序列的transformer框架编码机器人的视觉和动作信息,在解码器端与带有遮罩的语言嵌入编码进行跨模态注意力融合,输出预测的语言结果;

11.s5、在解码器的输出部分添加额外的辅助监督任务,辅助机器人学习输出句子与输入动作的对应关系,提升网络模型对输入与输出关系的表达。

12.所述的步骤s1中,深度卷积神经网络模型采用在imagenet上预训练好的 resnet-152网络,以将图像输入resnet-152网络后前向推理得到的分类前最后一层输出作为图像特征向量。

13.所述的机器人摄像头采集到的全景图像包括36张子图像,包括分别在俯视、平视、仰视三个视角下12张相隔30度的观察图像,每张观察图像对应一个图像特征向量。

14.所述的步骤s2中,机器人的偏移角度包括动作偏移角度与视角偏移角度,动作偏移角度为机器人当前所处位置与上一时刻所处位置的偏移角度,视角偏移角度为机器人观

[0032][0033][0034][0035]

其中,l1为采用交叉熵损失函数得到的预测值和真值之间的差异,l2为采用均方差函数得到的预测值和真值之间的差异,θ为网络参数,f

θ

(

·

)为网络的预测概率,为输出指令的第p个真实值,为输出指令中第1个到第p个真实值,z

l

为网络输出的第l个词汇对应的预测进程值,l为词汇总数,p(i'j)为当前词汇所在子指令i'j的序号,k为子指令的总段数,λ为控制两个损失函数比重的数值,ω为统一两个损失函数量级的数值,为第l个词汇所对应的真实进程值。

[0036]

与现有技术相比,本发明具有以下优点:

[0037]

一、本发明通过引入多头注意力方法,有效融合机器人的动作行为与环境观察,提升其输入特征信息的利用程度,使用先进的序列生成模型transformer,代替了原来的rnn结构模型,提升了模型整体的编码与解码能力,该方法包含的自然语言生成步骤简单直接,可以端到端地实现模型的训练与预测,生成指令所包含的视觉语义信息更加丰富,更接近人工标注的指令。

[0038]

二、本发明提出额外的进度监督辅助任务,利用更加细腻的子指令与对应的子行为动作来提升网络模型对输入与输出对应关系的表达能力,以引入先验知识的方法辅助模型更好的学习语言生成与动作之间的关系,在几乎不增加网络参数量的前提下,提升了生成模型的精确度和泛化能力。

附图说明

[0039]

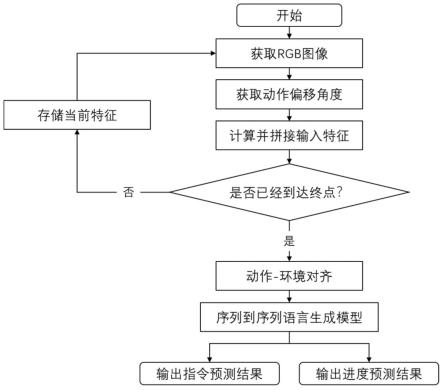

图1为本发明方法的流程示意图。

[0040]

图2为本发明方法的具体系统流程图。

[0041]

图3为本发明方法中进度监督辅助任务的示意图。

具体实施方式

[0042]

下面结合附图和具体实施例对本发明进行详细说明。本实施例以本发明技术方案为前提进行实施,给出了详细的实施方式和具体的操作过程,但本发明的保护范围不限于下述的实施例。

[0043]

实施例

[0044]

本发明提供了一种室内环境机器人导航自然语言指令生成方法,该方法的整体流程框图如图1所示,具体包括以下步骤:

[0045]

s1、利用深度卷积神经网络提取机器人摄像头采集到的图像特征;

[0046]

其中,深度卷积神经网络模型采用在imagenet上预训练好的resnet-152网络,将图像输入网络后前向推理得到的分类前最后一层输出作为特征向量,使用vj来表示第j个图像特征向量。

[0047]

s2、获取机器人当前的偏移角度γ并通过三角变换扩充数据维度后,与图像特征拼接形成新的特征向量;

[0048]

其中,偏移角度包括动作偏移与视角偏移,动作偏移指机器人当前所处位置与上一时刻所处位置的偏移角度,视角偏移指机器人观察的全景图所包含的每张子图像基于中心的偏移角度,本例中使用正弦函数和余弦函数分别计算偏移的俯仰角和航向角θ,公式如下:

[0049][0050]

为了让网络模型更好地学习图像和动作角度之间的关系,将其扩充至128维度,即γj,并与vj拼接后形成特征向量:oj={vj;γj}。

[0051]

s3、利用多头注意力对机器人动作和观察的全景图像进行对齐和降维计算,使机器人关注环境中更重要的视觉内容;

[0052]

其中,多头注意力以动作特征向量为查询矩阵q,以全景图像为键矩阵k和值矩阵v,对两者做注意力后可明显降低输入特征的维度,过滤不重要的成分,丰富输入的语义信息,注意力计算公式可表示为:

[0053]

q=awq[0054]

k=ewk[0055]

v=ewv[0056][0057]

a和e分别代表动作特征向量和全景图像特征向量,wq、wk、wv分别为对动作特征向量a与全景图像特征向量e做线性变化的可学习权重,代表k的维度,使用多头注意力可以让模型注意到不同的侧重点,进一步提升其训练和学习的能力。

[0058]

s4、使用序列到序列的transformer框架编码机器人的视觉和动作信息,在解码器端与带有遮罩的语言嵌入编码进行跨模态注意力融合,输出预测的语言结果;

[0059]

其中,由于transformer是并行结构,天生不具备捕捉输入序列顺序的能力,因此,需要额外添加位置序列编码来强调在时序上输入对输出的不同影响,因此,对使用多头注意力融合后的输入x使用以下函数实现位置编码:

[0060]

[0076]

其中,λ为控制两个损失函数比重的数值,ω为统一两个损失函数量级的数值

[0077]

综上,本发明针对机器人视觉语言导航任务,提出了一种用于指导机器人导航行为的自然语言指令生成方法。本发明方法的提出,使用transformer作为序列到序列的文本生成框架,引入额外的生成进度辅助监督任务,设计联合训练损失函数,实现端到端的学习与预测。该方法可以有效实现对机器人导航路径的自然语言指令生成,从而在不引入额外的人工标注的前提下,提高机器人视觉语言导航的能力,具有生成语言语义信息丰富、模型泛化性强、训练速度快等优点。

[0078]

以上详细描述了本发明的较佳具体实施例。应当理解,本领域的普通技术人员无需创造性劳动就可以根据本发明的构思作出诸多修改和变化。因此,凡本技术领域中技术人员依本发明的构思在现有技术的基础上通过逻辑分析、推理或者有限的实验可以得到的技术方案,皆应在由权利要求书所确定的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1