一种基于视觉特征的移动机器人实时定位方法与流程

[0001]

本发明属于机器人视觉技术领域,具体涉及一种基于视觉特征的移动机器人实时定位方法。

背景技术:

[0002]

随着各个行业智能自动化要求不断提高,应工业、农业和军事等行业的需求,自主移动机器人的研究刻不容缓。实时定位与地图构建技术的出现很好的解决了机器人在未知环境下的定位和建图问题。因此实现对机器人实时定位的研究,可以降低机器人在实际运动过程中遇到突发问题,并且提高机器人的工作运行效率,间接推动智能化发展。

[0003]

在传统的同步定位与地图构建,在行进过程中一直会累计误差,导致移动机器人定位失败。如何提高在实际运动过程实现对机器人的实时定位的方法是尤其关键的一步。

技术实现要素:

[0004]

本发明的目的是提供一种基于视觉特征的移动机器人实时定位方法,解决了实际环境帧间累计误差较大,导致移动机器人定位失败的问题。

[0005]

本发明所采用的技术方案是,一种基于视觉特征的移动机器人实时定位方法,具体按照以步骤进行实施:

[0006]

步骤1、采集图像数据,通过多层卷积神经网络,进行初步信息提取;

[0007]

步骤2、通过融合注意力机制进一步提取图像中的几何变换信息;

[0008]

步骤3、将提取的特征通过卷积神经网络降维,后连接两个单独的全连接网络进行多任务学习;

[0009]

步骤4、将学习后的特征数据生成数据集,通过几何信息的数据关联,生成了点云的二维视觉特征;

[0010]

步骤5、将步骤1采集到图像数据的第一帧图像设置成关键帧,然后结合步骤3和步骤4得到当前帧特征信息进行特征匹配,获得匹配图;

[0011]

步骤6、通过构建多地图系统方法,不断将关键帧与当前帧进行图像缝合,将提取的特征添加到缝合窗口,可以实时更新匹配图中的视觉特征;

[0012]

步骤7、将更新匹配图与当前帧的视觉特征进行匹配,并利用帧间差分估计算法进行当前帧的位姿估计,最终实现移动机器人实时定位。

[0013]

本发明的特点还在于,

[0014]

步骤1中初步信息提取由局部底层几何变换信息到全局高层几何变换信息的提取。

[0015]

步骤1中采用移动机器人自带的rgb-d传感器进行图像数据采集。

[0016]

步骤2中融合注意力机制的具体步骤为:

[0017]

步骤2.1、将步骤1采集的图像数据在神经网络内部的某个特征图f∈r

c

×

h

×

w

作为输入;其中,h为向量矩阵,a表示行数,b表示列数;

[0018]

步骤2.2、通过注意力模块先后生成一个一维的通道注意力矩阵m

c

∈r

e

×

f

及一个二维的空间注意力矩阵m

s

∈r

x

×

y

;

[0019]

步骤2.3、计算出总的注意力机制特征矩阵为以及其中,表示逐个元素相乘,f

′

是注意力模块内部优化的特征矩阵,f

″

是注意力模块优化后输出的特征矩阵。

[0020]

步骤5提取关键帧前,需通过判断是否满足以下条件:当前帧与前一参考帧的旋转系数大于0.1;当前帧与前一参考帧的平移系数大于0.1;当满足上述任意一个条件或者两个条件都满足时,即认为相机位姿发生了重要改变,需添加关键帧,更新匹配图;否则,不会提取关键帧操作。

[0021]

在步骤5中计算当前帧图像位姿时,提取当前帧的视觉特征,让视觉特征与匹配图中视觉特征进行匹配,并通过p3p算法进行位姿估计,然后实现机器人的实时定位。

[0022]

步骤6中构建多地图系统具体步骤为:多地图系统构建包括缝合和优化两部分:

[0023]

步骤6.1、当特征匹配发生在不同局部地图之间,则对图像进行缝合操作;

[0024]

步骤6.2、缝合完之后进行优化,调整全局地图的内部关系。

[0025]

步骤6.1中的缝合过程:是将关键帧与当前帧的视觉特征都放进缝合窗口,在地图缝合时,将两图中重复的视觉特征进行剔除;对当前帧中的每个特征在关键帧中寻找匹配特征,如果找到,则把当前帧中的特征去除,并将当前帧放入更新地图中去,同时,更新匹配图。

[0026]

步骤6.2中的优化过程包括缝合优化和整体优化:首先进行缝合优化,首先将缝合窗口之外的部分进行固定,缝合后的地图追踪新来的实时当前帧;利用地图缝合减小整体的累计误差,进行整体的位姿图优化,提升窗口内外的一致性;在优化时,缝合窗口内被固定,窗口外采用融合匹配图进行优化,回环矫正从缝合窗口传递向整个地图,完成缝合优化。

[0027]

步骤7中帧间差分估计的具体步骤如下:

[0028]

步骤7.1、首先,已知一组匹配的3d点对:q={q1,

…

,q

n

},q

′

={q

′1,

…

,q

′

n

},通过3d到3d点对的计算求出这组点对的旋转矩阵r和平移向量t,令:q

i

=rq

′

i

+t;

[0029]

步骤7.2、定义第i对点的误差项e

i

=q

i-(rq

′

i

+t)

ꢀꢀꢀ

(1);

[0030]

步骤7.3、构建一个最小二乘函数,求出误差平方和达到最小的r,t:

[0031][0032]

步骤7.4、定义两组点的质心

[0033]

步骤7.5、将步骤4.3的目标优化函数化简为:

[0034][0035]

本发明的有益效果是:本发明的一种基于视觉特征的移动机器人实时定位方法,保持了匹配图中地图点的实时性,又能够使匹配图不至于过大而影响计算效率,解决了实际环境帧间累计误差较大,导致移动机器人定位失败的问题。依据构建多地图系统方法对

处理前一帧的位姿估计与当前帧的位姿相差较大,具有明显的实时定位精度高,降低机器人在实际运动过程中遇到突发问题,并且提高机器人的工作运行效率,因此,采用鲁棒性强、精度高的实时定位方法可以更好地减小误差累计。基于视觉特征的移动机器人实时定位方法,可以提高机器人姿态计算精度,增大同步定位与地图构建算法的鲁棒性。

附图说明

[0036]

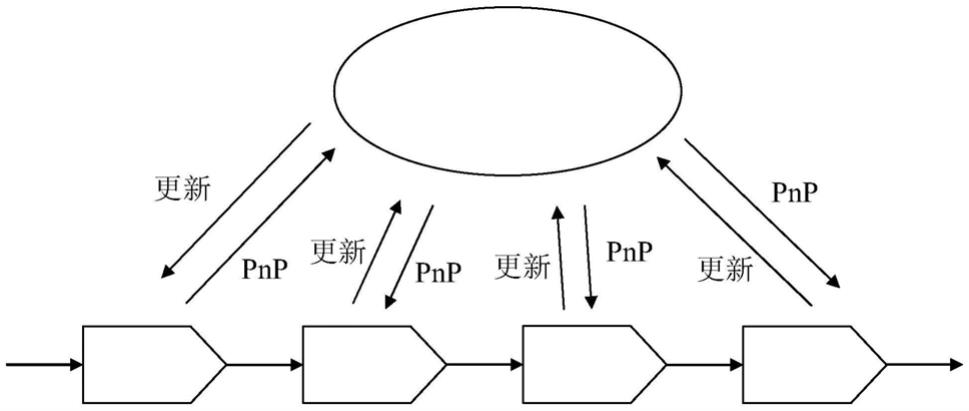

图1是本发明一种基于视觉特征的移动机器人实时定位方法中匹配图;

[0037]

图2是本发明一种基于视觉特征的移动机器人实时定位方法中帧间差分估计算法几何关系图。

具体实施方式

[0038]

下面结合附图和具体实施方式对本发明进行详细说明。

[0039]

本发明提供了一种基于视觉特征的移动机器人实时定位方法,具体按照以步骤进行实施:

[0040]

步骤1、采集图像数据,通过多层卷积神经网络,进行初步信息提取;

[0041]

步骤1中采用移动机器人自带的rgb-d传感器进行图像数据采集,由局部底层几何变换信息到全局高层几何变换信息的提取;

[0042]

步骤2、通过融合注意力机制进一步提取图像中的几何变换信息;

[0043]

步骤2中融合注意力机制的具体步骤为:

[0044]

步骤2.1、将步骤1采集的图像数据在神经网络内部的某个特征图f∈r

c

×

h

×

w

作为输入;其中,h为向量矩阵,a表示行数,b表示列数。

[0045]

步骤2.2、通过注意力模块先后生成一个一维的通道注意力矩阵m

c

∈r

e

×

f

及一个二维的空间注意力矩阵m

s

∈r

x

×

y

。

[0046]

步骤2.3、计算出总的注意力机制特征矩阵为以及其中,表示逐个元素相乘,f

′

是注意力模块内部优化的特征矩阵,f

″

是注意力模块优化后输出的特征矩阵。

[0047]

步骤3、将提取的特征通过卷积神经网络降维,后连接两个单独的全连接网络进行多任务学习;

[0048]

步骤4、将学习后的特征数据生成数据集,通过几何信息的数据关联,生成了点云的二维视觉特征;

[0049]

步骤5、将步骤1采集到图像数据的第一帧图像设置成关键帧,然后结合步骤3和步骤4得到当前帧特征信息进行特征匹配,获得匹配图,如图1所示;

[0050]

由于步骤5中的匹配图包括关键帧和视觉特征,提取关键帧前,需通过判断是否满足以下条件:

[0051]

1)当前帧与前一参考帧的旋转系数大于0.1;

[0052]

2)当前帧与前一参考帧的平移系数大于0.1。

[0053]

当满足上述任意一个条件或者两个条件都满足时,即认为相机位姿发生了重要改变,需添加关键帧,更新匹配图;否则,不会提取关键帧操作。

[0054]

在步骤5中计算当前帧图像位姿时,提取当前帧的视觉特征,让视觉特征与匹配图中视觉特征进行匹配,并通过p3p算法进行位姿估计,然后实现机器人的实时定位。

[0055]

步骤6、通过构建多地图系统方法,不断将关键帧与当前帧进行图像缝合,将提取的特征添加到缝合窗口,可以实时更新匹配图中的视觉特征;

[0056]

步骤6中构建多地图系统具体步骤为:多地图系统构建包括缝合和优化两部分。

[0057]

步骤6.1、当特征匹配发生在不同局部地图之间,则对图像进行缝合操作;将关键帧与当前帧的视觉特征都放进缝合窗口,在地图缝合时,将两图中重复的视觉特征进行剔除;对当前帧中的每个特征在关键帧中寻找匹配特征,如果找到,则把当前帧中的特征去除,并将当前帧放入更新地图中去,同时,更新匹配图。

[0058]

步骤6.2、缝合完之后进行优化,调整全局地图的内部关系。

[0059]

步骤6.2中的优化过程包括缝合优化和整体优化:

[0060]

首先进行缝合优化,首先将缝合窗口之外的部分进行固定,缝合后的地图追踪新来的实时当前帧。

[0061]

利用地图缝合减小整体的累计误差,进行整体的位姿图优化,提升窗口内外的一致性。在优化时,缝合窗口内被固定,窗口外采用融合匹配图进行优化,回环矫正从缝合窗口传递向整个地图,完成缝合优化。

[0062]

步骤7、将更新匹配图与当前帧的视觉特征进行匹配,并利用帧间差分估计算法进行当前帧的位姿估计,最终实现移动机器人实时定位。

[0063]

步骤7中帧间差分估计的具体步骤如下:

[0064]

步骤7.1、首先,已知一组匹配的3d点对:q={q1,

…

,q

n

},q

′

={q

′1,

…

,q

′

n

},通过3d到3d点对的计算求出这组点对的旋转矩阵r和平移向量t,令:q

i

=rq

′

i

+t;

[0065]

步骤7.2、定义第i对点的误差项e

i

=q

i-(rq

′

i

+t)

ꢀꢀꢀ

(1);

[0066]

步骤7.3、构建一个最小二乘函数,求出误差平方和达到最小的r,t:

[0067][0068]

步骤7.4、定义两组点的质心

[0069]

步骤7.5、将步骤4.3的目标优化函数化简为:

[0070][0071]

如图2所示,帧间差分估计算法几何关系图。由图2可知,三角形之间有对应关系:δolm-δolm,δoln-δoln,δomn-δomn,利用三角形相似性质,求解投影点l,m,n在相机坐标系下的3d坐标,最后转换成一个3d到3d对点求解问题。

[0072]

本发明一种基于视觉特征的移动机器人实时定位方法的特点为,可以降低机器人在实际运动过程中遇到突发问题,并且提高机器人的实时定位的准确性,同时可以并且提高其工作运行效率。

[0073]

为了克服机器人在行进过程中一直进行误差累计,提出了匹配图的方法,通过关键帧与当前帧的不断更新替换过程,提高了机器人实时定位的精确性。采用构建多地图系统,降低了机器人在实际运动过程中遇到突发问题导致丢帧从而引起定位失败的风险,并

极大地减小了误差累计。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1