清洗数据的文本后门防御方法

清洗数据的文本后门防御方法

【技术领域】

1.本发明属于人工智能安全技术领域,特别是涉及一种清洗数据的文本后门防御方法。

背景技术:

2.人工智能中的深度学习技术,在各个领域都取得了巨大成功,并得到了广泛应用。但是,深度学习,如深度神经网络(deepneural networks,简称dnn),都需要通过训练的手段确定其模型参数,才能被应用,并且数量较大的模型参数,通常需要更大规模的训练数据量才能确定。可见,深度学习技术的应用离不开训练数据。近年来,一种被称为后门攻击(backdoor attacks)的新型攻击引起了广泛的关注,攻击者通过使用带有后门触发器(backdoor trigger)的恶意数据训练模型之后,将生成一个带有后门的恶意模型。此类带有后门的模型在输入良性数据时能够以较高准确率将其正常分类,只有带有后门触发器的数据输入时,才会激活恶意神经元,导致错误分类(通常是分类成某一特定错误类别)。由于其具有极强的隐蔽性,检测此类攻击给用户带来了巨大的挑战。

3.目前后门攻击研究主要集中在计算机视觉领域,文本由于其数据的离散性,使得计算机视觉领域的研究方法不能适用于文本。在文本领域,自然语言处理模型包括流行的预训练模型很容易被后门攻击,攻击成功率甚至能高达100%。因而攻击者可以用一个触发器,如:一个句子甚至一个单词,控制被感染的模型得到指定的输出。文本后门攻击最直接常见方法是使训练数据中毒,即:将中毒数据通过训练过程中将后门编码到模型的权重中,具体而言,是将带有触发器的中毒样本添加到干净的训练集中,使得受害者模型学会后门特征。此外,训练数据对于深度学习模型尤其重要,尤其是特殊领域数据常常难以获取。因此,如何识别出训练数据中被恶意添加的少量中毒样本,降低中毒样本的有效性,防止创建隐藏的后门是确保人工智能安全性的关键技术,但是,由于中毒样本占训练数据中的比例通常很小,因而增加了识别难度。

技术实现要素:

4.鉴于上述技术问题,本发明的目的在于提供一种清洗数据的文本后门防御方法,并能防御字、词、句多种类型的后门攻击且防御效果好。

5.为实现上述目的,本发明的发明构思为:在模型嵌入层后添加受控噪声层,训练一个初步的、后门嵌入不完全或者没有后门的模型,降低了中毒样本的有效性,利用训练出的模型初步识别训练集中的中毒样本,缩小对中毒样本的搜索范围;然后用全部训练数据训练一个嵌入后门的感染模型,用于对第一步筛选出的样本再分类,从而识别出中毒样本。

6.一方面,本发明提出了一种清洗数据的文本后门防御方法,包括以下步骤:

7.步骤1、在模型嵌入层后添加抑制中毒样本特征的受控噪声层,训练得到中毒抑制模型f1,利用所述模型f1,选择出训练集数据中的可疑样本;

8.步骤2、训练嵌入后门的模型f2,对步骤1中的可疑样本进行分类,识别出中毒样

本,实现对训练数据的清洗,所述中毒样本是攻击者注入的“异常值”训练样本。

9.进一步的,在上述技术方案的基础上,所述步骤1还包括:

10.步骤1.1、用深度学习算法学习参数化模型f,其中步骤1.1、用深度学习算法学习参数化模型f,其中为需要学习权重和偏置θ的特定神经网络的所有参数的空间,所述模型本身是输入域和标签域之间的映射,即

11.从一给定分布中汲取一组独立样本s={z1,...,zn}作为训练数据,对于所述分布设定最小化预期损失所对应的模型f

*

为:

12.其中,测量f如何预测特征标签的关系z,所述z=(s,y),其中s是输入样本,y是对应的标签,表示期望,表示使其后面的表达式取值达到最小值时,对应的模型f;

13.在模型f的嵌入层后添加受控噪声层,并减少训练迭代次数进行受控训练,得到的最小化预期损失对应的模型作为所述中毒抑制模型f1,且所述中毒抑制模型f1能满足下述条件:

14.当是关于分布的异常值,则这些数据实例在所述最小化预期损失f

*

下与符合分布的种群具有显著不同的损失,即:其中t是仅取决于分布的常数;

15.步骤1.2、用所述模型f1对训练集数据进行分类,将所述模型f1输出的标签与训练集的原始标签不同的样本作为可疑样本。

16.当用f1对训练集数据进行分类,将模型输出标签与原始标签不同的样本作为可疑样本,由于训练集中的中毒样本是关于分布的异常值,模型f1没有完全学到后门特征,所以中毒样本的f1输出标签与原标签不一致,从而可确定可疑样本的范围。

17.进一步的,在上述技术方案的基础上,所述步骤2还包括:

18.步骤2.1、使用包含有中毒样本的全部训练数据训练嵌入后门的感染模型f2;

19.步骤2.2、选定多个正常输入文本s0,s1,

…

,sk,其中si表示一文本,0≤i≤k;

20.在对字符级中毒样本和词级中毒样本的识别中,随机打乱可疑样本中单词的顺序,并将可疑样本分别添加在s0,s1,

…

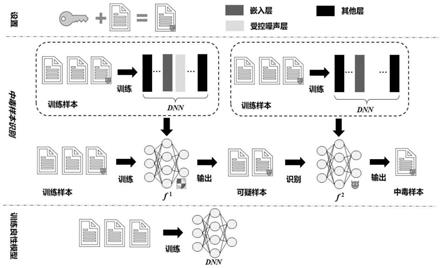

,sk前,生成样本

21.将生成样本的每一个输入到模型f2中,分别得到输出标签ti,即:yi为输入样本对应正常文本的原始标签,

22.比较ti和yi,并统计ti不等于yi的数量占全部比较结果的比例,如果所述比例超过一阈值,则可疑样本是中毒样本,否则,则可疑样本不是中毒样本;

23.其中,0<i≤k,且i为整数。

24.进一步的,在上述技术方案的基础上,所述模型f1和模型f2均为dnn模型。

25.进一步的,在上述技术方案的基础上,所述阈值为93%。

26.进一步的,在上述技术方案的基础上,所述k为不小于50的正整数。

27.另一方面,本发明提出了一种清洗数据的文本后门防御装置,包括:

28.处理器和存储器,所述处理器与所述存储器通信连接,

29.其中,所述存储器存储有计算机指令,所述处理器运行所述计算机指令时执行权利要求1~4中任一项所述的方法中的步骤。

30.本发明与现有技术相比,其显著优点为:

31.(1)适用范围广,适合字、词、句多种粒度的后门攻击的清洗;

32.(2)可以移除后门数据,通过识别出隐藏在数据量巨大的训练集中的中毒样本,从而移除模型中的后门。

【附图说明】

33.图1是本发明提出清洗数据的文本后门防御方法一具体实施例的示意图。

【具体实施方式】

34.为了便于理解,本具体实施方式是本发明公开的清洗数据的文本后门防御方法的优选实施例,以详细说明本发明的结构和发明点,但并不作为本发明权利要求的限定保护范围。

35.下面结合附图1及具体实施例对本发明作进一步详细说明。

36.参见图1,在中毒样本识别中,首先在训练模型f1时,在其模型嵌入层后添加受控噪声层,训练一个初步的、后门嵌入不完全或者没有后门的模型f1,降低中毒样本对模型的影响。利用训练出的模型f1初步识别训练集中的疑似为中毒样本的可疑样本,缩小对中毒样本的搜索范围;然后用包含有中毒样本的全部训练数据训练一个嵌入后门的感染模型f2,用于对前一步筛选出的可疑样本再分类,从中识别出中毒样本,并予以清洗。清洗后的训练数据用于训练没有后门影响的良性模型。

37.在训练模型f1时,需要抑制中毒特征,训练后门嵌入不完全或者无后门的目标模型,具体包括下述步骤:

38.步骤1:在模型嵌入层后添加受控噪声层并且减少训练迭代次数,控制训练过程。

39.利用深度学习算法学习参数化模型其中是需要学习权重和偏置θ的特定神经网络的所有参数的空间以获得模型f

θ

。模型本身是输入和标签之间的映射,即其中,是输入域,是输出标签域。

40.为了训练得到这样的模型,从一分布中汲取的一组独立样本s={z1,...,zn}。对于给定的分布设定最小化预期损失所对应的模型f

*

为:

[0041][0042]

测量f如何预测特征标签关系z,其中,z=(s,y),s是输入样本,y是对应的标签,是期望,表示使其后面的表达式取值达到最小值时,对应的模型f。

[0043]

假设是关于分布的异常值,则这些数据实例在最小化预期损失假设下与种群具有显着不同的损失,即:

[0044][0045]

其中t是仅取决于的常数。通过分析可以看出,对于数据集,其中大多数样本来自一定的分布,而中毒样本的分布与多数样本不同。

[0046]

通过上述训练,得到一个后门嵌入不完全或者没有后门的模型f1,用所述模型f1对训练集数据进行分类,将所述模型f1输出的标签与训练集的原始标签不同的样本作为可疑样本。

[0047]

所述模型f1有以下两个特点:

[0048]

①

由于该模型后门嵌入不完全或者没有后门,因此保证了模型的安全性。同时,因为模型没有完全学到训练数据集的特征,所以在干净数据集的识别准确率会有小幅度的下降,但总体来说仍能保证较高的识别性能;

[0049]

②

利用该模型可以用于初步识别训练集中的中毒样本。

[0050]

然后,利用嵌入后门的模型识别中毒样本,具体包括:

[0051]

步骤1:用全部训练数据训练一个嵌入后门的感染模型f2,所述全部训练数据中存在中毒样本,所述中毒样本是攻击者注入的“异常值”训练样本。

[0052]

步骤2:选定多个正常输入文本s0,s1,

…

,sk,一个嵌入后门的深度文本分类模型f2。在对字符级中毒样本和词级中毒样本的识别中,随机打乱可疑样本中单词的顺序,并将可疑样本添加在s0,s1,

…

,sk前,生成样本

[0053]

将生成样本的每一个输入到模型f2中,分别得到输出标签ti,即:yi为输入样本对应正常文本的原始标签,

[0054]

比较ti和yi,并统计ti不等于yi的数量占全部比较结果的比例,如果所述比例超过一阈值,则可疑样本是中毒样本,否则,则可疑样本不是中毒样本;其中,0<i≤k,且i为整数。。

[0055]

为了便于理解,以一简单示例说明,将一处理后的可疑样本插入到100个正常文本的前面,得到100个生成文本,将这些文本输入到模型f2,其输出对应的标签结果,这些标签结果有的与生成文本对应的正常文本的标签相同,有的不相同,统计标签比较结果不相同的占全部比较结果的比例,如果超过一阈值,则判断该可疑文本是中毒样本,否则不是中毒样本。作为一个更优的实施方式,所述阈值为93%,k为不小于50的正整数,能适用于大多数dnn模型。

[0056]

下面以所述实施例的防御效果对本发明的技术效果作进一步详细说明。

[0057]

表1为三种后门攻击的示例。其中字符级攻击是通过插入新字符的方式将“the”变为“thesis”,词级攻击是向句子中插入新单词“cf”,句子级攻击是向句子中插入新短句“here is a story”。

[0058]

表1三种后门攻击的示例

[0059][0060]

采用本发明的实施例,得到的字符级后门攻击的防御效果如表2所示。

[0061]

表2字符级后门攻击的防御性能对比

[0062][0063]

从表2展示的字符级后门攻击方法的攻击效果,可以看出在bilstm、bert两个模型和sst-2、imdb两个数据集上,字符级后门攻击方法都达到了85.60%以上的攻击成功率。而经过本发明实施例处理后,模型中的后门被移除,后门攻击成功率下降到6.41%及以下,实现了有效的后门防御。

[0064]

表3展示了词级后门攻击的防御效果,可以看出在bilstm、bert两个模型和sst-2、imdb两个数据集上,词级后门攻击方法都达到了94.00%以上的攻击成功率。经过本发明实施例防御方法处理后,模型中的后门被移除,后门攻击成功率下降到2.60%及以下。

[0065]

表3词级后门攻击的防御性能对比

[0066][0067]

表4展示了句子级后门攻击的防御效果。从表4可以看出在两个模型和两个数据集上,句子级后门攻击方法都达到了91.00%以上的攻击成功率。经过发明本实施例的防御方法处理后,模型中的后门被移除,实现了有效的防御。

[0068]

表4句子级后门攻击的防御性能对比

[0069][0070]

以上是本发明的一些具体实施方式,但本发明并不仅局限于上述方式,所有对本发明技术特征的简单变换,凡依本发明专利申请范围所述的构造、特征及原理所做的等效变化或修饰,都将落入本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1