用于模式识别基于压缩激励注意力的神经网络剪枝方法

本发明涉及计算机视觉领域领域,尤其涉及一种用于模式识别基于压缩激励注意力的神经网络剪枝方法、装置、设备及存储介质。

背景技术:

1、近年来,深度学习技术迅速发展,计算机视觉等领域使用的神经网络参数量越来越多。这些庞大的模型需要占用大量的计算资源,难以在移动边缘设备上部署,因此需要对模型进行剪枝操作,来降低模型参数量和计算量,减少模型训练推理成本。

2、efficientnet是一个结合神经网络搜索技术的多维度混合放缩的网络,efficientnet系列网络是在efficientnet—b0的基线上调整深度、宽度、分辨率和丢失率获得的。虽然目前在计算机视觉领域efficientnet的表现已经超越了许多手工设计的神经网络,但是也存在计算开销较大的问题,在部分模式识别领域最轻量的efficientnet-b0也存在过参数化的问题;目前大多数剪枝方法主要针对resnet和vgg等这类手工模型,很少对eff icientnet这类轻量化网络进行剪枝,现有剪枝算法应用于efficientnet将有大量改动,对efficientnet的剪枝而言并不方便。

3、因此,现有技术还有待于改进和发展。

技术实现思路

1、本技术要解决的技术问题在于,针对目前在计算机视觉领域采用effi cientnet在进行图像处理时,efficientnet存在过参数化的问题,导致计算开销较大,本发明提供一种用于模式识别基于压缩激励注意力的神经网络剪枝方法、装置、设备及存储介质,本发明能够通过训练的掩码和effi cientnet中的压缩激励注意力分析通道重要性并进行软剪枝,其无需引入额外的注意力模块,同时根据不同模块的参数量大小,调整正则化系数的取值,更加细粒度控制掩码稀疏化,从而使得本发明能够方便快捷的得到更高压缩率的efficientnet网络模型,通过剪枝后的更高压缩率的effic ientnet网络模型对图像进行处理实现计算开销更小的效果。

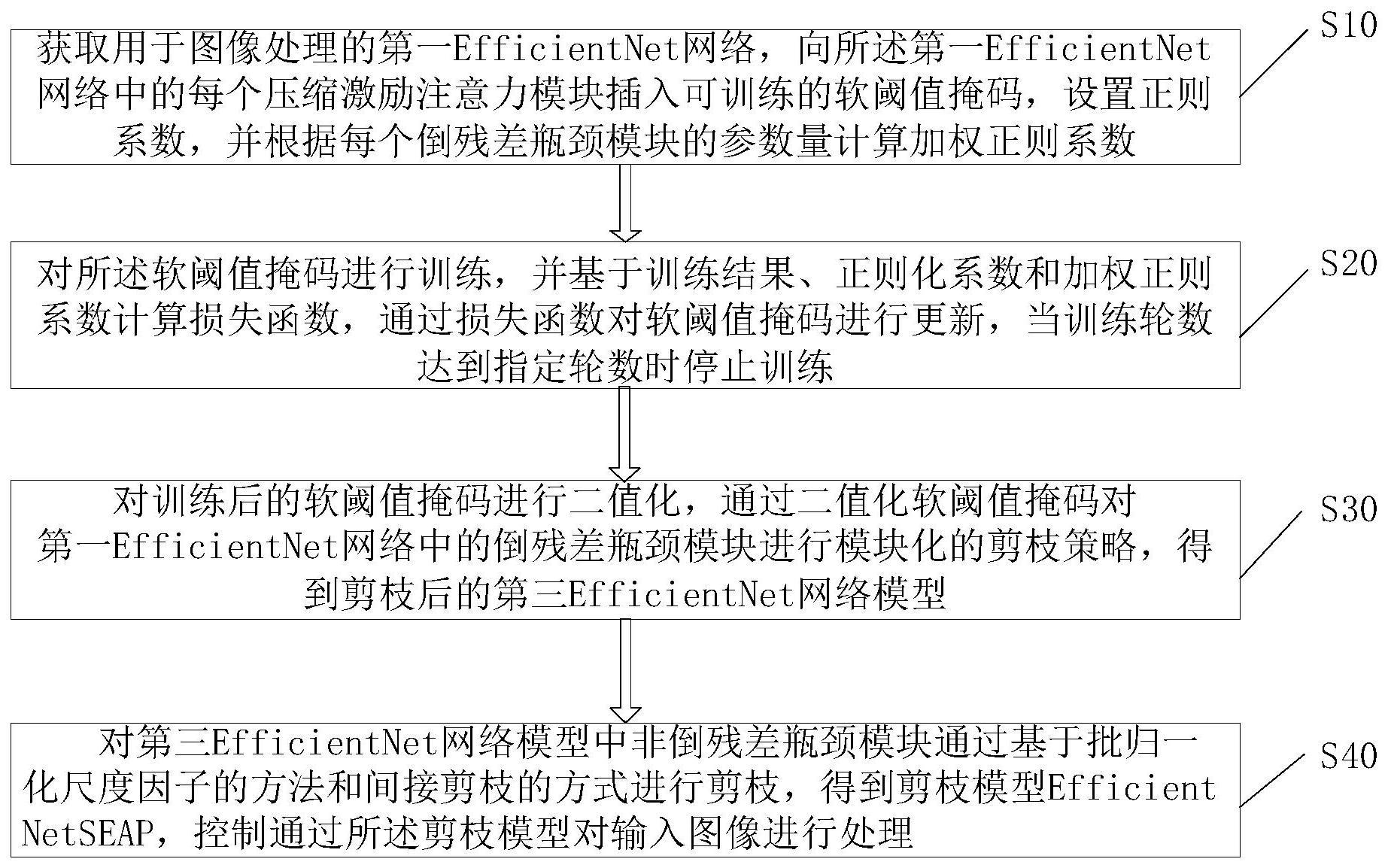

2、为了解决上述现有技术问题的不足,本技术实施例第一方面提供了一种用于模式识别基于压缩激励注意力的神经网络剪枝方法,所述方法包括:

3、获取用于图像处理的第一efficientnet网络,向所述第一efficient net网络中的每个压缩激励注意力模块插入可训练的软阈值掩码,设置正则系数,并根据每个倒残差瓶颈模块的参数量计算加权正则系数;

4、对所述软阈值掩码进行训练,并基于训练结果、正则化系数和加权正则系数计算损失函数,通过损失函数对软阈值掩码进行更新,当训练轮数达到指定轮数时停止训练;

5、对训练后的软阈值掩码进行二值化,通过二值化软阈值掩码对第一efficientnet网络中的倒残差瓶颈模块进行模块化的剪枝策略,得到剪枝后的第三efficientnet网络模型;

6、对第三efficientnet网络模型中非倒残差瓶颈模块通过基于批归一化尺度因子的方法和间接剪枝的方式进行剪枝,得到剪枝模型;

7、控制通过所述剪枝模型对输入图像进行处理。

8、所述在获取所述用于图像处理的第一efficientnet网络时,获取一个在大规模图像分类数据集imagenet上训练过的与所述第一efficientnet网络结构相同的第二efficientnet模型的权重,第一efficientnet网络加载所述权重作为第一efficientnet网络的初始化权重。

9、所述向所述第一efficientnet网络中的每个压缩激励注意力模块插入可训练的软阈值掩码,设置正则系数,并根据每个倒残差瓶颈模块的参数量计算加权正则系数,具体包括:

10、所述插入的可训练的软阈值掩码初始化为全1向量;

11、所述正则系数为预先设定的值;

12、所述加权正则系数通过第一efficientnet网络中倒残差瓶颈模块的参数量计算得到;

13、所述正则系数与所述加权正则系数在软阈值掩码训练过程中不发生变化。

14、所述对所述软阈值掩码进行训练,并基于训练结果、正则化系数和加权正则系数计算损失函数,通过损失函数对软阈值掩码进行更新,当训练轮数达到指定轮数时停止训练,具体包括:

15、插入了可训练的软阈值掩码的第一efficientnet网络在目标图像分类数据集上训练,并基于训练结果、正则化系数和加权正则系数计算得到损失函数,通过损失函数对软阈值掩码进行更新并反向传播软阈值掩码,再次在目标图像分类数据集上训练;

16、当训练轮数达到指定轮数时停止训练。

17、所述对训练后的软阈值掩码进行二值化,通过二值化软阈值掩码对第一efficientnet网络中的倒残差瓶颈模块进行模块化的剪枝策略,得到剪枝后的第三efficientnet网络模型,具体包括:

18、根据剪枝需求预先设置阈值,通过该阈值对软阈值掩码进行二值化处理,得到二值化软阈值掩码,通过二值化软阈值掩码对第一efficientnet网络中的每个倒残差瓶颈模块进行模块化的剪枝策略,对倒残差瓶颈模块中的压缩激励注意力模块、逐通道卷积、逐点卷积和扩张卷积依次进行剪枝操作,得到剪枝后的第三efficientnet网络模型。

19、所述对第三efficientnet网络模型中非倒残差瓶颈模块通过基于批归一化尺度因子的方法和间接剪枝的方式进行剪枝,得到剪枝模型,具体包括:

20、对第三efficientnet网络模型中的主干卷积层采用间接剪枝的方式进行剪枝;

21、对第三efficientnet网络模型中的特征整合卷积层和全连接层采用基于批归一化尺度因子的方法进行剪枝。

22、所述对第三efficientnet网络模型中非倒残差瓶颈模块通过基于批归一化尺度因子的方法和间接剪枝的方式进行剪枝,得到剪枝模型后,还包括:

23、在目标图像分类数据集上优化损失函数,微调剪枝模型,当训练轮数达到人工指定的轮数,停止微调,输出微调后的剪枝模型。

24、本技术实施例第二方面提供了一种用于模式识别基于压缩激励注意力的神经网络剪枝装置,所述装置包括:

25、剪枝前置模块,获取用于图像处理的第一efficientnet网络,向所述第一efficientnet网络中的每个压缩激励注意力模块插入可训练的软阈值掩码,设置正则系数,并根据每个倒残差瓶颈模块的参数量计算加权正则系数;

26、训练模块,对所述软阈值掩码进行训练,并基于训练结果、正则化系数和加权正则系数计算损失函数,通过损失函数对软阈值掩码进行更新,当训练轮数达到指定轮数时停止训练;

27、对倒残差瓶颈模块剪枝模块,对训练后的软阈值掩码进行二值化,通过二值化软阈值掩码对第一efficientnet网络中的倒残差瓶颈模块进行剪枝,得到剪枝后的第三efficientnet网络模型;

28、对非倒残差瓶颈模块剪枝模块,对第三efficientnet网络模型中非倒残差瓶颈模块通过基于批归一化尺度因子的方法和间接剪枝的方式进行剪枝,得到剪枝模型,控制通过所述剪枝模型对输入图像进行处理。

29、本技术实施例第三方面提供了一种终端设备,其特征在于,所述终端设备包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的用于模式识别基于压缩激励注意力的神经网络剪枝方法,所述处理器执行所述用于模式识别基于压缩激励注意力的神经网络剪枝方法时,实现如上述任一所述的用于模式识别基于压缩激励注意力的神经网络剪枝方法的步骤。

30、本技术实施例第四方面提供了一种计算机可读存储介质,其特征在于,其上存储有用于模式识别基于压缩激励注意力的神经网络剪枝方法,所述用于模式识别基于压缩激励注意力的神经网络剪枝方法被处理器执行时,实现如上述任一项所述的用于模式识别基于压缩激励注意力的神经网络剪枝方法的步骤。

31、有益效果:与现有技术相比,本技术提供了一种用于模式识别基于压缩激励注意力的神经网络剪枝方法、装置、设备及存储介质,所述方法包括获取用于图像处理的第一efficientnet网络,向所述第一efficientne t网络中的每个压缩激励注意力模块插入可训练的软阈值掩码,设置正则系数,并根据每个倒残差瓶颈模块的参数量计算加权正则系数;对所述软阈值掩码进行训练,并基于训练结果、正则化系数和加权正则系数计算损失函数,通过损失函数对软阈值掩码进行更新,当训练轮数达到指定轮数时停止训练;对训练后的软阈值掩码进行二值化,通过二值化软阈值掩码对第一efficientnet网络中的倒残差瓶颈模块进行模块化的剪枝策略,得到剪枝后的第三efficientnet网络模型;对第三efficientnet网络模型中非倒残差瓶颈模块通过基于批归一化尺度因子的方法和间接剪枝的方式进行剪枝,得到剪枝模型,通过剪枝模型对图像进行处理。这样在计算机视觉领域上,对于efficientnet,本发明能够结合基于掩码和基于注意力剪枝算法的优点,使用软阈值掩码和注意力机制指导剪枝,充分利用effici entnet中的压缩激励注意力,使得本发明能通过注意力分析通道重要性,又能通过掩码在训练后软剪枝,同时无需引入额外的注意力模块,同时根据不同模块的参数量大小,调整正则化系数的取值,更加细粒度控制掩码稀疏化,采用模块化的剪枝策略,避免了大部分模块之间的间接剪枝,使得本发明能够方便快捷的得到更高压缩率的efficientnet网络模型,从而通过剪枝后的剪枝模型实现对图像处理时计算开销更小,对内存的占用更少的效果。

- 还没有人留言评论。精彩留言会获得点赞!