适用于流应用的以双因果和非因果受限自注意力进行序列到序列处理的人工智能系统的制作方法

本公开总体上涉及人工智能(ai),更具体地,涉及一种适用于流应用的用于以注意力进行序列到序列建模的ai系统。

背景技术:

1、如今,自注意力机制已成为用于求解序列到序列问题的不同人工智能(ai)应用的许多神经网络(nn)架构中的核心组件。序列到序列问题的示例包括机器翻译、语音处理、语言建模、自动语音识别(asr)、计算机视觉等。自注意力机制允许输入彼此交互(“自”)并且找出它们应该更注意谁(“注意力”),以针对给定任务以最佳方式计算输出。当整个输入序列可用于处理时,自注意力机制有利于求解序列到序列问题。然而,等待从时间相关信号推导的整个输入序列导致以自注意力模块来处理时间序列的神经网络具有输出延迟,这使得它们不太适用于需要低延迟的在线或流序列到序列处理。

2、例如,在语音处理应用中,为了解释语音话语“she eats a green apple(她吃了一个青苹果)”,自注意力机制对于解释语音话语的不同部分可能投入不同的注意力。例如,对于解释词语“eats”,词语“apple”可能比词语“green”更重要。因此,在解释词语“eats”期间,自注意力模块可学习对词语“apple”而非对词语“green”投入更多注意力。然而,为了对词语“apple”投入更高注意力,自注意力模块应该等待直至词语“apple”变得可用于处理。因此,在此示例中,为了解释句子的开头,自注意力模块需要等待直至句子的结束,从而导致处理延迟。

3、受限自注意力可部分地解决自注意力机制的这一缺点。尽管自注意力机制处理整个输入序列以解释其各个输入,受限自注意力通过查看当前输入前面的有限视域来解释输入序列的当前输入。通常,输入序列包括输入帧序列,因此为了解释当前帧,受限自注意力仅考虑当前帧之后的有限数量的帧。当前帧之后的帧在本文中被称为前瞻帧或仅前瞻,前瞻帧的数量在本文中被称为前瞻大小。

4、受限自注意力可能使自注意力模块的性能下降,但是降低了序列到序列处理的延迟。例如,当前瞻大小为两个帧时,受限自注意力将各个当前帧的解释仅延迟两个帧,这对于流应用而言是可容忍的。

5、然而,在实践中,自注意力模块在深度神经网络的结构内形成复杂架构,其中在彼此层叠的层内使用多个自注意力模块,各个层使用在前层的输出作为输入。深度神经网络的结构在准确性方面改进了序列到序列处理的性能,但这是以增加的处理延迟为代价的。例如,当受限自注意力模块引入两个帧的处理延迟并且深度神经网络包括12个连续的基于自注意力的层以改进处理的准确性时,尽管各个自注意力层仅使用2个前瞻帧,但总延迟变为24帧。结果,深度神经网络的设计者需要平衡处理的准确性与延迟。还需要与dnn的总延迟相比平衡各个自注意力层的前瞻大小,以提供令人满意的序列到序列处理性能而无需大的总延迟。

技术实现思路

1、技术问题

2、一些实施方式的目的是提供一种适用于流应用的以自注意力进行序列到序列处理的人工智能(ai)系统。另外地或另选地,一些实施方式的目的是提供一种双自注意力模块,其可提供性能保证,而无需序列到序列处理的大处理延迟。另外地或另选地,一些实施方式的目的是提供一种双自注意力模块,其可用于形成各种架构的深度神经网络而不会累积各个层的处理延迟。

3、问题的解决方案

4、一些实施方式基于这样的理解:自注意力以及受限自注意力具有非因果架构。词语因果和非因果是信号处理领域的术语,在本文中以其平常含义使用。例如,在信号处理中,因果滤波器是线性时不变因果系统,其中词语“因果”指示滤波器输出仅取决于过去和现在的输入。输出也取决于未来输入的滤波器是非因果的。因此,如本文所使用的,自注意力模块的非因果架构使用过去、当前以及在当前输入帧之后到来的未来输入来解释当前输入帧。

5、类似地,受限自注意力模块可使用因果架构来实现。这种架构不使用未来信息,因此不引入任何延迟。结果,因果自注意力的任何组合不会导致任何附加延迟。然而,使用因果自注意力的序列到序列处理的性能比非因果自注意力的性能差。为此,一些实施方式的目的是将因果架构与非因果架构组合以用于数据流应用,以利用二者的优点。

6、一些实施方式基于这样的认识:非因果架构使用两个主要原理。第一个原理是关注输入帧的方式,第二个原理是输入帧的本质。在非因果架构中,两个原理均是非因果的。具体地,非因果自注意力关注未来前瞻帧,因此关注的方式是非因果的。另外,第二个原理规定前瞻帧应该考虑未来数据根据非因果原理来生成。因此,生成前瞻帧的方式也可为非因果的。结果,根据两个非因果原理,前瞻大小为两个帧的非因果架构需要关注两个未来前瞻帧,这两个未来前瞻帧继而可利用另两个未来前瞻帧生成,这另两个未来前瞻帧继而可利用另两个前瞻帧生成,依此类推,遵循使用自注意力模块的神经网络的深度。

7、一些实施方式基于这样的认识:可通过提供双因果和非因果(dcn)架构来修改非因果架构的原理。在dcn架构中,关注输入帧的方式仍是非因果的,然而,输入帧本身可以是因果或非因果的。另外地或另选地,在dcn架构中,关注输入帧的方式可以是因果或非因果的,并且输入帧可以是因果或非因果的。如本文所述,因果输入或因果帧是在不考虑一个或多个未来输入的情况下生成的输入或帧,而非因果输入或非因果帧是考虑一个或多个未来输入生成的输入或帧。结果,深度神经网络(dnn)的非因果架构内的因果输入可用于降低总处理延迟,而准确性仅部分降低。

8、在一些实施方式中,非因果自注意力处理的前瞻帧是因果帧,而所关注的其它帧对应于非因果帧。当前瞻帧为因果的时,在前双自注意力模块不需要附加前瞻帧来生成它们。值得注意的是,如果非因果过去帧的前瞻大小不长于其从当前帧过去的距离,则具有非因果过去帧不会引入任何附加延迟。因此,实施方式可使用尽可能多的非因果帧,从而限制性能降低,同时仅使用因果前瞻帧,从而限制处理延迟。

9、一些实施方式基于这样的理解:需要以与非因果帧一致的方式生成因果帧(例如因果前瞻帧),从而允许dcn架构一起使用因果帧和非因果帧。为此,一些实施方式使用双自注意力,维持因果架构和非因果架构二者彼此并行操作。因果架构以因果方式处理其输入,从而在没有前瞻的情况下生成因果输出。非因果架构以非因果方式处理其输入,相对于输入帧具有预定大小的前瞻,以输出非因果输出。在一些实现方式中,这些前瞻帧是从因果架构复制的因果帧。

10、因此,具有dcn架构的双自注意力模块可输出因果输出和非因果输出。因果输出和非因果输出可通过包括双自注意力的dnn的层传播。以这种方式,双自注意力的非因果架构可访问通过dnn的先前层的双自注意力的因果架构生成的因果帧和通过dnn的先前层的双自注意力的非因果架构生成的非因果帧二者。值得注意的是,dnn的总体输出可包括因果输出和非因果输出之一或组合。然而,由于非因果输出通常比因果输出更准确,所以在一个实施方式中,输出序列仅包括非因果输出。

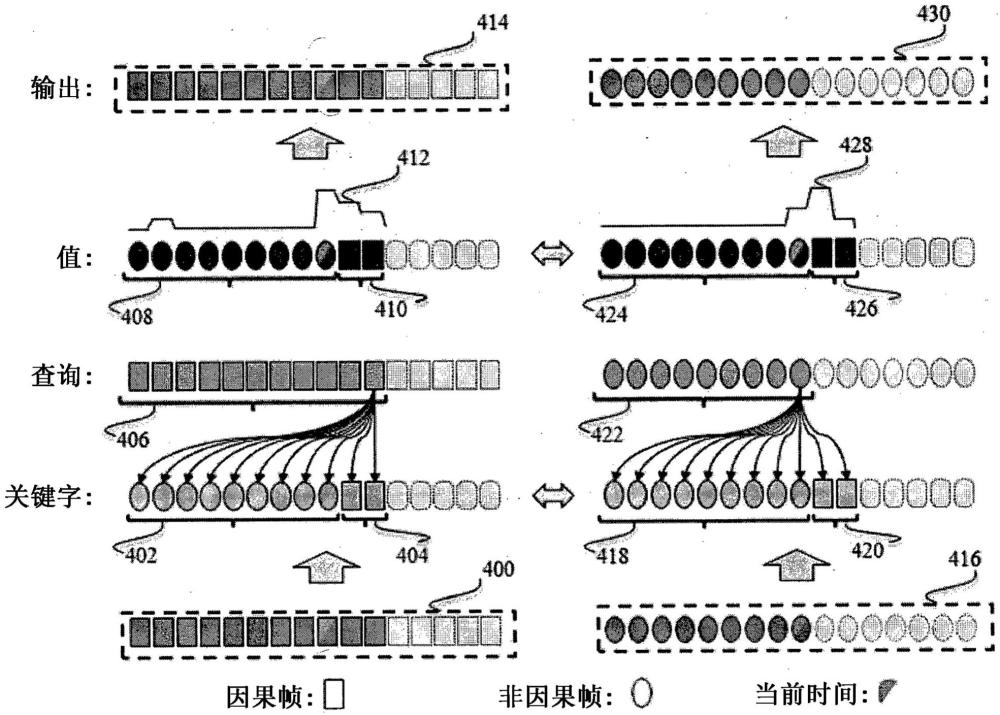

11、一些实施方式基于这样的认识:在内部,双自注意力将输入帧序列变换为关键字、值和查询帧的序列。查询与关键字以及关键字与值的关系是可微的。以这种方式,随着dnn学习,注意力机制可学习重塑搜索输入与提供上下文的输入之间的关系。

12、为此,查询序列的各个查询帧在关键字序列上搜索,以计算各个关键字帧相对于查询帧的关系。各个关键字帧与对关于各个输入帧的特征进行编码的值帧有关。所计算的各个关键字帧相对于查询帧的关系用于向各个值帧指派加权因子,以用于计算值帧序列和用于查询搜索的输出的加权平均。例如,如果输入帧序列的各个输入帧对应于词语序列(即,句子)中的词语,则所估计的各个关键字帧相对于查询帧的关系将表示与查询帧关联的词语与句子中的所有其它词语的关系。

13、因此,为了计算非因果输出,双自注意力的非因果架构需要复制因果前瞻关键字和值帧,从而允许非因果查询帧关注非因果过去和当前关键字帧以及因果前瞻关键字帧,以为过去和当前非因果值帧和因果前瞻值帧生成权重,以生成非因果输出。

14、一些实施方式基于另一认识:通过只要可能就使因果帧的使用最小化,双自注意力模块的质量可进一步改进。为此,在一些实施方式中,因果架构使用从不需要超出当前查询帧位置的任何信息的非因果架构复制的过去非因果帧和当前非因果帧,而非因果架构使用从因果架构复制的因果前瞻帧。

15、一些实施方式基于这样的理解:具有双自注意力模块的层的dnn可用作序列到序列问题的主要解释器,和/或可形成更复杂神经网络架构的一部分。例如,在一个实施方式中,dnn以联结主义时序分类(ctc)目标训练以输出音频输入的解释。例如,对于自动语音识别(asr)应用,dnn被训练输出语音话语的转录。另外地或另选地,dnn可作为编码器训练以输出编码器状态,这些编码器状态可稍后变换为期望形式的输出。在一个示例中,这种后期变换可借助于与dnn一起训练的额外投影层来完成。在另一示例中,dnn形成编码器/解码器架构中的双自注意力编码器,其中,解码器也是深度神经网络。

16、例如,在一个实施方式中,编码器神经网络和额外投影层以ctc目标函数来训练。此实施方式是有利的,因为基于ctc的神经网络也可应用于流应用。在另一示例中,编码器之后是基于注意力的解码器神经网络。此实施方式对于流应用不太容易使用,但是可提供比基于ctc的神经网络更准确的解释结果。

17、在另一实施方式中,双自注意力编码器的输出由多个不同的解码器处理,这些解码器一起工作以实现更好的结果。例如,双自注意力编码器的输出由基于ctc和注意力的解码器处理,以改进总体解码。另外地或另选地,在一个实施方式中,基于ctc的输出触发基于注意力的解码器的执行,以使基于注意力的解码器适应流应用。为此,一些实施方式提供一种语音识别系统,其包括与基于注意力的解码器组合的双自注意力编码器。

18、因此,一个实施方式公开了一种适用于数据流应用的人工智能(ai)系统。该ai系统包括至少一个处理器;以及存储有指令的存储器,所述指令在由至少一个处理器执行时使得ai系统通过深度神经网络(dnn)的层来处理输入帧序列中的各个输入帧以生成输出序列,其中,至少一些层包括具有关注非因果帧和因果帧的双因果和非因果架构的双自注意力模块;并且渲染输出序列。

19、因此,另一实施方式公开了一种音频处理方法。该音频处理方法包括以下步骤:通过深度神经网络(dnn)的层来处理输入帧序列中的各个输入帧以生成输出序列,其中,至少一些层包括具有关注非因果帧和因果帧的双因果和非因果架构的双自注意力模块;以及渲染输出序列。

20、因此,另一实施方式公开了一种非暂时性计算机可读存储介质,其上具体实现有程序,该程序可由处理器执行以用于执行一种方法,该方法包括以下步骤:通过深度神经网络(dnn)的层来处理输入帧序列中的各个输入帧以生成输出序列,其中,至少一些层包括具有关注非因果帧和因果帧的双因果和非因果架构的双自注意力模块;以及渲染输出序列。

21、当前公开的实施方式将参照附图进一步说明。所示的附图未必按比例,而是重点通常放在示出当前公开的实施方式的原理。

- 还没有人留言评论。精彩留言会获得点赞!