一种双电机电动汽车电池健康能量管理方法、设备、介质

本发明涉及双电机纯电动汽车能量管理策略开发,尤其是涉及一种双电机电动汽车电池健康能量管理方法、设备、介质。

背景技术:

1、目前普遍存在的里程焦虑严重阻碍了纯电动汽车的大规模普及与行业的健康发展。与单电机固定速比纯电动汽车相比,基于多电机的分布式驱动纯电动汽车借助灵活的电机配置能够提高驱动系统的平均能效和动态性能。考虑到额外的电机会提高成本和增加控制难度,目前大部分研究人员和制造商将研究重心放在双电机动力总成上,但是双电机动力总成中额外引入的变速箱带来了车辆实时确定驾驶模式的挑战。因此,能量管理策略成为了提高多能源电动汽车经济性的关键技术。

2、近年来随着人工智能技术飞速发展和广泛应用,基于强化学习的能量管理策略受到广泛关注,但仍存在着一些问题没有被充分解决。目前的基于drl的能量管理策略要么作用于只包含离散动作的能量系统,要么作用于只包含连续动作的能量系统。然而,离散和连续动作共存的能量系统才更符合实际驾驶场景,这给基于演员评论家框架的强化学习算法(ddpg,td3,sac)带来了新的挑战。虽然已有学者通过将基于演员评论家框架的强化学习算法与其他技巧相结合(如softmax和gumbel-softmax)来解决混合动作控制难题,但是当混合动作中存在着多个离散动作时,这些方法会遇到维度诅咒问题。而且,目前的研究大多把基于drl的能量管理策略建模成完全可观察的马尔科夫决策问题,即每个时间步的观察值完全代表环境的状态。

3、但是,真实场景下的车辆功率分配方案不仅与当前的状态信息有关,还与历史的状态信息有关,所以基于drl的能量管理策略更应该被建模为部分可观察的马尔科夫决策问题。因此,提出一个基于具有记忆功能的混合软性演员评论家算法的电池健康管理策略对双电机电动汽车的进一步发展具有积极意义。

技术实现思路

1、本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种双电机电动汽车电池健康能量管理方法、设备、介质,主要是在演员评论家算法的基础上提出了两种优化技巧对原能量管理策略进行优化。

2、本发明的目的可以通过以下技术方案来实现:

3、本发明第一方面提供一种双电机电动汽车电池健康能量管理方法,包括以下步骤:

4、s1:构建双电机双速纯电动汽车的动力系统模型;

5、s2:基于s1中构建的动力系统模型,构建随机策略的深度强化学习和lstm神经网络;

6、s3:基于s2中构建的随机策略的深度强化学习和lstm神经网络,将软性演员评论家算法中的actor网络应用到离散-连续混合动作空间中,并使用线性映射技巧控制离散动作维数,以搜索最优的电池健康能量管理策略;

7、s4:基于确定性概率离散决策、随机离散决策两种方法,对s3中离散-连续混合动作空间进行优化,并在后续仿真实验中与线性映射技巧进行对比评估;

8、s5:基于电池健康能量管理策略的优劣程度,设定状态空间和奖励;

9、s6:将能源管理策略建模为部分可观察马尔可夫决策过程,并将长短期记忆网络整合到actor网络和critic网络中,以利用历史和当前环境信息优化能量管理策略。

10、进一步地,s1中,构建双电机双速纯电动汽车的动力系统模型的过程包括:

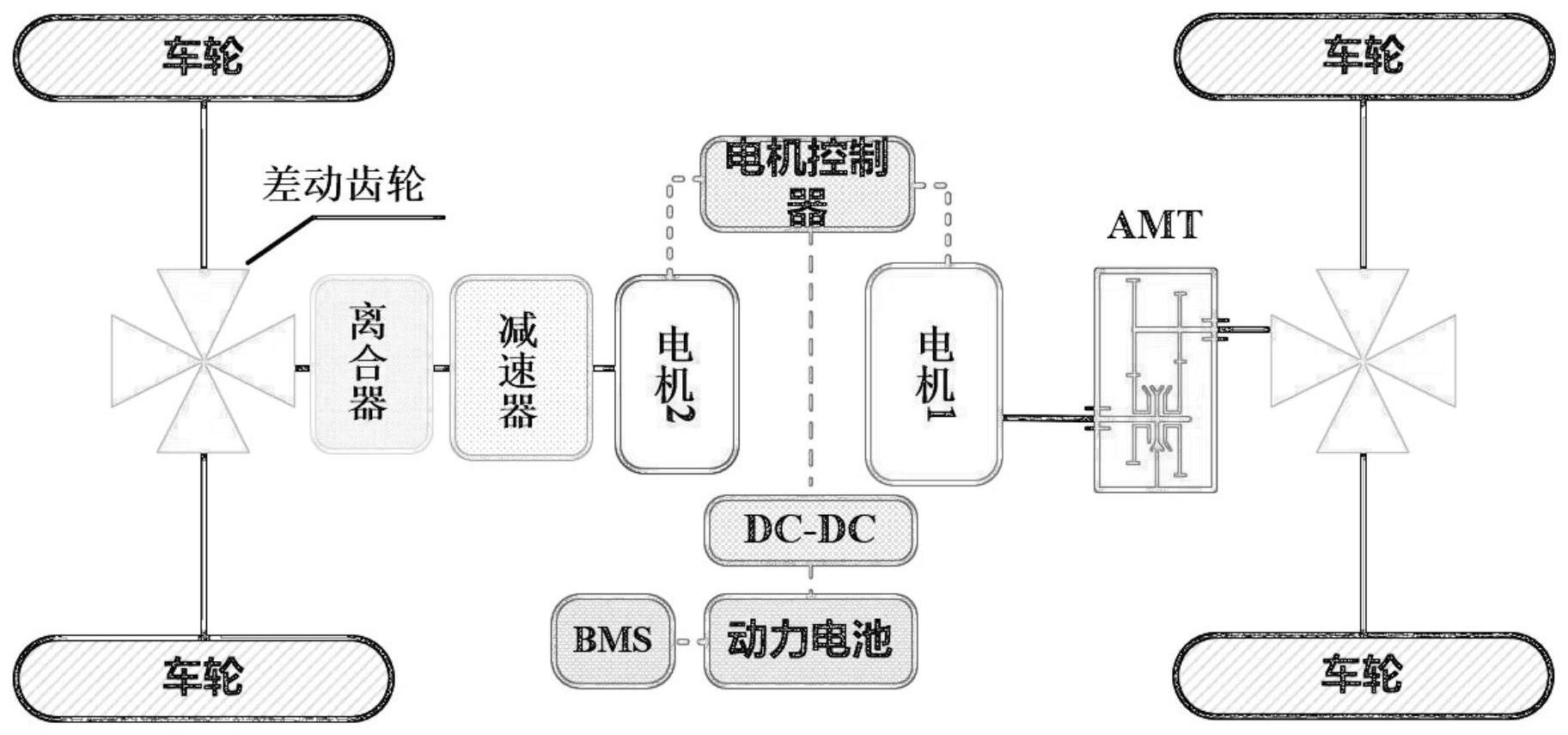

11、构建参考车辆,所述参考车辆配备两台电机和一台双速自动机械变速器的纯电动汽车,所述参考车辆涉及的车辆参数包括:总重量、车辆正面面积、滚动阻力系数、空气阻力系数、车轮半径、电池容量、电池电压、自动机械变速器齿轮比、减速齿轮传动比、第一电机最大扭矩、第一电机最大转速、第二电机最大扭矩、第二电机最大转速;

12、构建所述参考车辆的动力学约束模型:

13、

14、其中td为需求驱动转矩;δ为旋转质量转换系数;m为车辆质量;为道路坡度角;f为滚动阻力系数;g为重力加速度,9.8m/s2;cd为空气阻力系数;a为车辆正面面积;v为车速;r是车轮半径;

15、构建双电机双速纯电动汽车的健康意识电池模型,所述健康意识电池模型由二阶rc模型、两态热模型和能量通量老化模型组成;

16、根据动力系统配置,将双电机双速纯电动汽车的驱动方式设置为五种驱动模式:仅第一电机第一档驱动、仅第一电机第二档驱动、仅第二电机驱动、第一电机第一档+第二电机驱动、第一电机第二档+第二电机驱动。

17、进一步地,s1中,所述参考车辆中的两台电机均采用准静态模型,通过瞬时速度和扭矩插值获得效率;

18、所述二阶rc模型用下式给出:

19、

20、

21、

22、vt(t)=voc(soc,t)+vb1(t)+vb2(t)+rsi(t)

23、其中,v代表端子电压;i代表负载电流分;qbat表示电池的标称容量;vb1和vb2为两个rc支路的极化电压;cb1和cb2为两个rc支路的电容量;rb1和rb2为两个rc支路的电阻;rs为欧姆电阻;

24、所述两态热模型用下式给出:

25、

26、

27、tc(t)=2ta(t)-ts(t)

28、h(t)=i(t)(vb1(t)+vb2(t)+rs(t)i(t))+i(t)(ta(t)+273.15)en(soc,t)

29、其中,ts,tc,ta和tf分别表示电池表面温度、电池芯温度、内部平均温度和环境温度;rc是由电池内部的热传递产生的热阻;rc是由电池内部的热传递产生的;cc和cs分别为电池芯和表面的等效热容;h为产热率;en表示电化学反应过程中的熵变;

30、构建双电机双速纯电动汽车的动力系统模型的过程,还包括热能守恒原理获得的:

31、

32、

33、tc(t)=2ta(t)-ts(t)

34、h(t)=i(t)(vb1(t)+vb2(t)+rs(t)i(t))+i(t)(ta(t)+273.15)en(soc,t)

35、其中,ts,tc,ta和tf分别表示电池表面温度、电池芯温度、内部平均温度和环境温度;rc是由电池内部的热传递产生的热阻;rc是由电池内部的热传递产生的;cc和cs分别为电池芯和表面的等效热容;h为产热率;en表示电化学反应过程中的熵变;

36、还包括基于能量-吞吐量模型,得到多重压力下健康状态(soh)的下降:

37、

38、其中,n(c,ta)表示生命周期结束前的总周期数(eol),受充电速率(c)和电池内部温度的影响;

39、其中,在恒定工况下,电池容量损失δqbat(%)由下式计算:

40、

41、其中,b通过c插值得到的指前因子;r是理想气体常数,等于8.31j/mol·k;z为幂律因子,等于0.55;ah为总安培小时吞吐量;ea(j/mol)为由下式得到的总安培小时吞吐量;

42、所述随机策略的深度强化学习模型如下:

43、

44、其中,π*为最优策略;为熵,表示当前策略的随机化程度;α是用来平衡熵项和奖励的系数;

45、所述随机策略的深度强化学习模型中:

46、policy网络参数φ和critic网络参数φ分别由下式更新:

47、

48、

49、其中m是经验重放池,(st,at,rt,st+1)是小批量随机抽样,q′为带参数的目标critic网络,τ是控制更新的阶跃系数;

50、所述q′和φ′由下式给出:

51、φ′←(1-τ)φ′+τφ

52、温度系数α根据下式自动调整,等于动作维度的负值:

53、

54、进一步地,s2中,所述lstm神经网络结构由遗忘门ft、输入门t和输出门ot组成,其中ft确定在当前时间步中遗忘了哪些信息,值为0表示信息被完全遗忘;ot决定了哪些新信息应该添加到细胞状态中并建立了新的候选细胞状态,分别由下式给出:

55、ft=σ[wf(ht-1,xt)+bf]

56、it=σ[wi(ht-1,xt)+bi]

57、

58、其中,wf、wi和wc分别为遗忘门、输入门和单元的权值矩阵;bf、bi和bc分别表示遗忘门、输入门和单元的偏差;φ是s型激活函数;xt是lstm单元的输入向量;

59、其中,根据下式更新节点t时刻的细胞状态ct,然后ot根据更新后的单元状态生成lstm的输出值ht:

60、

61、

62、其中wo和bo分别表示输出门的权矩阵和偏置。

63、进一步地,s3中,具体包括以下步骤:

64、将混合动作集成到drl框架中,即线性映射技巧;

65、所述线性映射技巧在机器学习中使用one-hot编码来表示离散/分类变,在保持维数为1的情况下,采用线性映射技巧对整数变量进行重新参数化,使得改进actor网络使其能够处理混合动作:

66、

67、其中mode(n)代表驾驶模式;n={1,2,3,4}为离散动作空间;n表示驱动模式的总数,其值为4;a为actor网络的输出值;amax和amin分别为输出值a的上下限。

68、进一步地,s4中,具体包括以下步骤:

69、所述确定性概率离散决策选择概率最大的驱动模式作为输出,如下式所示,使得改进后的actor网络能够与softmax结合处理混合动作:

70、

71、其中ai是actor网络的ith神经元的输出值。

72、所述随机离散决策(gumbel-softmax)是将softmax和gumbel-max结合而成的:

73、g=-log(-log(ε))ε~uniform(0,1)

74、对应的gumbel-softmax的驾驶模式选择过程可由下式给出:

75、

76、其中δ为温度系数。

77、进一步地,s5中,具体包括以下步骤:

78、选取需求驱动转矩td、车速v、电池soc和电池健康状况soh作为状态空间:

79、state=[td,v,soc,soh]

80、将奖励分为电池能耗和电池健康度下降两部分:

81、r(t)=-log(ζδsoc(t)+ξδsoh(t))

82、其中r(t)是瞬时t的奖励;δsoc(t)是t时刻的电池能量消耗;δsoh(t)为时刻t的电池健康下降;ζ和ξ分别是控制能耗和健康下降的积极因素。

83、动作空间包括驱动方式和驱动转矩分配因子ρ:

84、action=[mode,ρ]

85、当车辆由单电机驱动时不需要分配需求驱动转矩,action的表达式为:

86、action=[(mode=1or2or3,ρ=0)∪(mode=4,ρ)∪(mode=5,ρ)]。

87、进一步地,s6中,具体包括以下步骤:

88、在一个循环的演员评论家框架内提出了一个基于记忆的sac,其中lstm嵌入在演员评论家网络中,所述线性映射技巧也被融入actor网络中;

89、sac-lstm从经验重播池m中以序列长度l采样历史用于在循环演员评论家框架中对网络进行梯度优化:

90、

91、其中s0和a0为零值虚拟观测行动向量,其维数与正常观测行动向量相同;

92、引入lstm后,对各critic网络qj∈{1,2}进行如下优化:

93、

94、

95、

96、actor网络的φ由下式优化:

97、

98、本发明第二发明提供一种电子设备,包括存储器、处理器,所述处理器用于执行所述存储器中的程序,以此实现如上述的双电机电动汽车电池健康能量管理方法。

99、本发明第三发明提供一种包含计算机可执行指令的存储介质,所述计算机可执行指令的存储介质在由计算机处理器执行时,用于执行如上述的双电机电动汽车电池健康能量管理方法。

100、与现有技术相比,本发明具有以下技术优势:

101、本发明首先提出了一种基于软性演员评论家算法(sac)的双电机双速纯电动汽车(bev)的能量管理策略(ems),然后采用了两种优化技巧对原能量管理策略进行优化。一是将线性映射技巧集成到软性演员评论家算法的actor网络中使演员能够在离散(驾驶模式)-连续(扭矩分布)混合动作空间中搜索最优的能量管理策略。二是将基于sac的环境管理系统建模为部分可观察马尔可夫决策过程(pomdp),在此基础上将另一种优化技术长短期记忆(lstm)网络集成到sac的演员和评论家中,以充分利用历史和当前环境信息。本发明能够学习到最优的ems,使得电池的健康性能最接近基于动态规划(dp)的ems,并保持电池在30-40℃范围内的工作状态,同时所述ems对测试周期的适应性也最好。

- 还没有人留言评论。精彩留言会获得点赞!