一种视频召回方法、装置、电子设备及存储介质与流程

1.本发明涉及视频推荐技术领域,尤其涉及一种视频召回方法、装置、电子设备及存储介质。

背景技术:

2.目前随着网络环境的多样化发展,视频标题中出现越来越多新奇的网络语言,这些网络语言往往会对视频召回算法会产生很多干扰。面对这一情况,现有算法模型已无法准确捕获视频标题的重要信息,导致视频召回推荐结果不相关,准确性差。

技术实现要素:

3.本发明提供一种视频召回方法、装置、电子设备及存储介质,解决现有技术中视频召回推荐结果不准确的问题。

4.在本发明实施的第一方面,提供了一种视频召回方法,包括:

5.将预先从训练数据集中选取的样本数据输入到共享模型中;所述样本数据包括标题中所有字对应的编号组成的标题向量,所述共享模型包括卷积神经网络层和上下文特征学习层;

6.通过所述共享模型的卷积神经网络层对所述样本数据的标题向量进行词含义学习,获得词含义学习之后的向量;

7.通过所述共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量;

8.根据上下文特征学习之后的向量获取所述样本数据的表征向量;

9.根据所述样本数据的表征向量以及预设学习目标,对所述共享模型进行训练;所述预设学习目标包括度量学习目标;

10.当所述共享模型训练完成时,将目标视频的标题向量输入到训练好的共享模型中,获得所述目标视频的表征向量;

11.根据所述目标视频的表征向量,获取所述目标视频的召回视频候选集。

12.优选的,所述上下文特征学习层包括:第一双向长短期记忆网络层、多抽头自注意力层和第二双向长短期记忆网络层;

13.所述通过所述共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量的步骤包括:

14.通过所述第一双向长短期记忆网络层对词含义学习之后的向量进行第一次上下文特征学习,获得上下文特征学习之后的第一向量;

15.通过所述多抽头自注意力层对上下文特征学习之后的第一向量进行多抽头自注意力学习,获得多抽头自注意力学习之后的第二向量;

16.通过所述第二双向长短期记忆网络层对多抽头自注意力学习之后的第二向量进行第二次上下文特征学习,获得上下文特征学习之后的第三向量。

17.优选的,所述通过所述共享模型的卷积神经网络层对所述样本数据的标题向量进行词含义学习,获得词含义学习之后的向量的步骤包括:

18.通过所述卷积神经网络按照多个不同大小的卷积核对所述样本数据的标题向量进行卷积处理,获得词含义学习之后的向量。

19.优选的,所述预设学习目标还包括标签多分类目标;所述根据所述样本数据的表征向量以及预设学习目标,对所述共享模型进行训练的步骤包括:

20.根据所述样本数据的表征向量以及所述度量学习目标的第一损失函数,获取第一损失值;

21.根据所述样本数据的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值;

22.根据所述第一损失值和所述第二损失值,确定所述共享模型的损失值;

23.根据所述共享模型的损失值,对所述共享模型的参数进行调整。

24.优选的,所述将预先从训练数据集中选取的样本数据输入到共享模型中之前,所述方法还包括:

25.从训练数据集中选取包括锚样本、正样本和负样本的样本数据;其中所述锚样本和所述正样本属于同一类别,所述锚样本和所述负样本属于不同类别;

26.所述将预先从训练数据集中选取的样本数据输入到共享模型中的步骤包括:

27.将所述锚样本、所述正样本和所述负样本分别输入到所述共享模型中;

28.所述根据所述样本数据的表征向量以及所述度量学习目标的第一损失函数,获取第一损失值的步骤包括:

29.根据所述锚样本的表征向量、所述正样本的表征向量、所述负样本表征向量以及所述度量学习目标的第一损失函数,获取第一损失值;

30.所述根据所述样本数据的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值的步骤包括:

31.根据所述锚样本的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

32.优选的,所述将预先从训练数据集中选取的样本数据输入到共享模型中之前,所述方法还包括:

33.从语料库中获取训练数据集中所有样本的标签信息;

34.对所有标签信息通过预设聚类算法进行聚类操作,获得聚类后的标签总分类信息;

35.所述根据所述样本数据的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值的步骤包括:

36.根据所述标签总分类信息以及所述样本数据的标签信息,获取所述样本数据的标签多分类向量;

37.根据所述样本数据的表征向量、所述样本数据的标签多分类向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

38.优选的,所述将预先从训练数据集中选取的样本数据输入到共享模型中之前,所述方法还包括:

39.从语料库中选取视频的标题信息;

40.根据预设的字典文件,查询每个标题信息包含的字对应的编号;其中所述字典文件包括所述语料库中所有字对应的编号;

41.根据每个标题信息包含的字对应的编号,获取每个标题信息的标题向量,并将每个标题信息的标题向量作为训练数据集中的样本。

42.在本发明实施的第二方面,还提供了一种视频召回装置,包括:

43.第一输入模块,用于将预先从训练数据集中选取的样本数据输入到共享模型中;所述样本数据包括标题中所有字对应的编号组成的标题向量,所述共享模型包括卷积神经网络层和上下文特征学习层;

44.第一学习模块,用于通过所述共享模型的卷积神经网络层对所述样本数据的标题向量进行词含义学习,获得词含义学习之后的向量;

45.第二学习模块,用于通过所述共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量;

46.第一获取模块,用于根据上下文特征学习之后的向量获取所述样本数据的表征向量;

47.模型训练模块,用于根据所述样本数据的表征向量以及预设学习目标,对所述共享模型进行训练;所述预设学习目标包括度量学习目标;

48.第二输入模块,用于当所述共享模型训练完成时,将目标视频的标题向量输入到训练好的共享模型中,获得所述目标视频的表征向量;

49.第二获取模块,用于根据所述目标视频的表征向量,获取所述目标视频的召回视频候选集。

50.在本发明实施的第三方面,还提供了一种电子设备,包括处理器、通信接口、存储器和通信总线,其中,处理器,通信接口,存储器通过通信总线完成相互间的通信;

51.存储器,用于存放计算机程序;

52.处理器,用于执行存储器上所存放的程序时,实现如上所述的视频召回方法中的步骤。

53.在本发明实施的第四方面,还提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现如上所述的视频召回方法。

54.在本发明实施例的第五方面,还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行如上所述的视频召回方法。

55.针对在先技术,本发明具备如下优点:

56.本发明实施例中,首先将预先从训练数据集中选取的样本数据输入到共享模型中;样本数据包括标题中所有字对应的编号组成的标题向量,共享模型包括卷积神经网络层和上下文特征学习层;通过共享模型的卷积神经网络层对样本数据的标题向量进行词含义学习,获得词含义学习之后的向量;通过共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量;根据上下文特征学习之后的向量获取样本数据的表征向量;然后根据样本数据的表征向量以及预设学习目标,对所述共享模型进行训练;预设学习目标包括度量学习目标;当共享模型训练完成时,将目标视频的标题向量输入到训练好的共享模型中,获得目标视频的表征向量;根据目标视频的

表征向量,获取目标视频的召回视频候选集。由于网络热词等属于比较冷门和新颖的词,若切词很容易出错,本发明将标题切成字,通过共享模型的卷积神经网络层学习词含义,并通过上下文特征学习层增加上下文特征的学习维度,使得对标题的特征学习更准确、更全面,提高了学习能力,这样即使在面对新奇的网络语言时,也可以通过共享模型对网络语言进行更加准确、全面的学习分析,从而更好的捕获到标题的表征含义,并结合度量学习目标对共享模型进行度量学习的训练,使共享模型具有度量表达能力,由此基于共享模型输出的表征向量进行视频召回,可以得到更高质量的相似视频结果,提高了视频召回推荐结果的准确性。

57.上述说明仅是本发明技术方案的概述,为了能够更清楚了解本发明的技术手段,而可依照说明书的内容予以实施,并且为了让本发明的上述和其它目的、特征和优点能够更明显易懂,以下特举本发明的具体实施方式。

附图说明

58.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍。

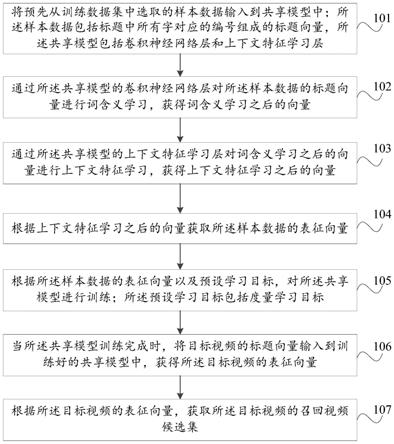

59.图1为本发明实施例提供的视频召回方法的流程示意图;

60.图2为本发明实施例提供的共享模型的网络结构示意图;

61.图3为本发明实施例提供的视频召回装置的示意框图;

62.图4为本发明实施例提供的电子设备的示意框图。

具体实施方式

63.下面将参照附图更详细地描述本发明的示例性实施例。虽然附图中显示了本发明的示例性实施例,然而应当理解的是,还可以以各种形式实现本发明而不应被这里阐述的实施例所限制。相反,提供这些实施例是为了能够更透彻地理解本发明,并且能够将本发明的范围完整的传达给本领域的技术人员。

64.图1是本发明实施例提供的一种视频召回方法的流程示意图,参照图1所示,该视频召回方法包括:

65.步骤101:将预先从训练数据集中选取的样本数据输入到共享模型中;所述样本数据包括标题中所有字对应的编号组成的标题向量,所述共享模型包括卷积神经网络层和上下文特征学习层。

66.这里,由于网络热词等属于比较冷门和新颖的词,直接切成词去表征句子的含义,新颖词的切分不一定准确,反而会造成句子表达出现误差,比如热词:地摊经济,这个词是一个整体,很有可能经过词切分就变成了地摊和经济,使得句子含义有所改变。本发明实施例中将标题切成字来分析,避免了直接切词出现的错误。本发明实施例中样本数据包括标题中所有字对应的编号组成的标题向量,将样本数据输入到包括卷积神经网络(cnn,convolutional neural networks)层和上下文特征学习层的共享模型中进行模型训练,通过共享模型对标题向量分别进行词含义的学习和上下文特征学习,使得对标题表征含义的学习能够更加准确。

67.其中,训练数据集中包括多个训练用的样本数据,每个样本数据包括标题中所有

字对应的编号组成的标题向量,本发明实施例可预先从训练数据集中随机选取多个样本数据进行共享模型的模型训练。

68.步骤102:通过所述共享模型的卷积神经网络层对所述样本数据的标题向量进行词含义学习,获得词含义学习之后的向量。

69.这里,首先通过共享模型的卷积神经网络层对样本数据的标题向量进行词含义学习,即对标题向量中单个字组成的词进行学习,弥补由于切成单个字造成词含义的缺失。

70.步骤103:通过所述共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量。

71.这里,通过卷积神经网络层进行词含义学习之后,由于没有考虑词语在句子中的前后顺序,对于标题含义的学习表达不够准确,本步骤继续通过共享模型上下文特征学习层对词之间的上下文特征进行学习,从而联系上下文更准确的学习标题的含义。

72.步骤104:根据上下文特征学习之后的向量获取所述样本数据的表征向量。

73.这里,根据上下文特征学习之后的向量获取到样本数据最终的表征向量,以基于最终的表征向量对共享模型进行训练。

74.步骤105:根据所述样本数据的表征向量以及预设学习目标,对所述共享模型进行训练;所述预设学习目标包括度量学习目标。

75.这里,预设学习目标包括度量学习目标,度量学习目标指希望通过学习,让模型对同类样本的特征表达之间的距离尽可能小,不同类样本的特征表达之间的距离尽可能大。本步骤中,根据样本数据的表征向量以及至少包括度量学习的学习目标对共享模型进行训练,能够使共享模型学习度量表达,使模型输出的同类视频的表征向量之间的距离尽可能小,不同类视频的表征向量之间的距离尽可能大,从而利用共享模型能够准确选取相似视频进行召回。

76.具体的,可设定度量学习目标为模型输出的同类样本的表征向量之间的距离小于第一阈值,不同类样本的表征向量之间的距离大于第二阈值,其中第一阈值小于第二阈值,第一阈值和第二阈值可根据需求设定为任意值。

77.本发明实施例中,还可同时设置其他学习目标,例如标签多分类目标,以进行多目标学习,增加算法模型目标维度,提高对视频推荐判断的多样性及准确性。

78.步骤106:当所述共享模型训练完成时,将目标视频的标题向量输入到训练好的共享模型中,获得所述目标视频的表征向量。

79.这里,当共享模型训练完成后,共享模型输出的表征向量之间的距离具有区分不同类视频的功能,且面对新奇的网络语言时,也可以很好的捕获到标题的表征含义。本步骤将目标视频的标题向量输入到训练好的共享模型中,通过共享模型产出相应的表征向量,以根据该表征向量获取目标视频的召回视频候选集。

80.步骤107:根据所述目标视频的表征向量,获取所述目标视频的召回视频候选集。

81.这里,根据共享模型输出的目标视频的表征向量,能够准确区分与其他视频之间的相似度,从而准确获取目标视频的召回视频候选集。

82.本发明实施例的视频召回方法,将标题切成字,通过共享模型的卷积神经网络层学习词含义,并通过上下文特征学习层增加上下文特征的学习维度,使得对标题的特征学习更准确、更全面,提高了学习能力,这样即使在面对新奇的网络语言时,也可以通过共享

模型对网络语言进行更加准确、全面的学习分析,从而更好的捕获到标题的表征含义,并结合度量学习目标对共享模型进行度量学习的训练,使共享模型具有度量表达能力,由此基于共享模型输出的表征向量进行视频召回,可以得到更高质量的相似视频结果,提高了视频召回推荐结果的准确性。

83.优选的,所述上下文特征学习层包括:第一双向长短期记忆网络层、多抽头自注意力层和第二双向长短期记忆网络层。

84.这里,共享模型采用两层双向长短期记忆网络(bilstm,bi

‑

directional long short

‑

term memory)层和一层多抽头自注意力(multi

‑

head self

‑

attention)层进行上下文特征的学习,丰富了学习的维度,使得对标题的特征学习更准确、更全面。

85.上述步骤103包括:

86.步骤1031:通过所述第一双向长短期记忆网络层对词含义学习之后的向量进行第一次上下文特征学习,获得上下文特征学习之后的第一向量。

87.这里,通过卷积神经网络层进行词含义学习之后,如果将词的表示组合成句子的表示,可以将所有词的表示进行加和,或者取平均等方法,但是这些方法没有考虑到词语在句子中前后顺序,语义表达不够准确。本发明实施例中通过卷积神经网络层进行词含义学习之后,继续通过第一双向长短期记忆网络bilstm层对词含义学习之后的向量进行上下文特征的学习,从而结合上下文学习句子含义,提高准确性。

88.其中,本发明实施例使用bilstm进行上下文特征的学习,可以更好的捕捉到较长距离的依赖关系,且可以更好的捕捉双向的语义依赖。bilstm是由前向lstm和后向lstm组合而成,两串lstm运算的结果再通过一定的计算(求和或者求均值等等)得到复合的结果,会比lstm效果更好。单向lstm,是根据前面的信息推出后面的信息,但有时候只看前面的词是不能够推断后面信息的,比如,我今天不舒服,打算____一天。只根据

‘

不舒服’,可能推出我打算

‘

去医院’,

‘

睡觉’,

‘

请假’等等,但如果加上后面的

‘

一天’,能选择的范围就变小了,

‘

去医院’这种就不能选了,而

‘

请假

’‘

休息’之类的被选择概率就会更大。所以在cnn的基础上,增加bilstm,又增加了一个维度对句子的表征学习。

89.步骤1032:通过所述多抽头自注意力层对上下文特征学习之后的第一向量进行多抽头自注意力学习,获得多抽头自注意力学习之后的第二向量。

90.这里,本发明实施例在第一bilstm层之后,采用多抽头自注意力multi

‑

head self

‑

attention对bilstm进行补充学习,将句子中不同的词分别作为关注的重点,即头head进行自注意力学习,有助于捕捉到更丰富的特征信息,进一步提高共享模型的学习能力。

91.步骤1033:通过所述第二双向长短期记忆网络层对多抽头自注意力学习之后的第二向量进行第二次上下文特征学习,获得上下文特征学习之后的第三向量。

92.这里,本发明实施例在multi

‑

head self

‑

attention层之后,继续通过第二双向长短期记忆网络bilstm层对词含义学习之后的向量进行上下文特征的学习,对前两层进行补充学习,丰富了学习的维度,使得对标题的特征学习更准确、更全面。

93.当然,上述共享模型采用两层bilstm层和一层multi

‑

head self

‑

attention层进行上下文特征的学习的网络结构仅为一种优选的实现方式,本发明实施例也可采用其他任意能够实现上下文特征学习的网络结构,例如采用一层bilstm层和一层multi

‑

head self

‑

attention,或者将bilstm替换为lstm,或者将multi

‑

head self

‑

attention替换为self

‑

attention等等。

94.优选的,上述步骤102包括:

95.步骤1021:通过所述卷积神经网络按照多个不同大小的卷积核对所述样本数据的标题向量进行卷积处理,获得词含义学习之后的向量。

96.此时,卷积神经网络cnn使用多个大小不同的卷积核,例如cnn使用大小为2、3、4的卷积核,分别学习2个字、3个字、4个字组成的词,不同字组成的词含义是不同的,这样在学习中提取到的特征也是不同的,从而丰富了学习的维度,使得对标题表征含义的学习更加准确,进而提高视频召回的相似度。

97.其中,在进入cnn之前,可首先将样本数据输入嵌入层embedding,通过embedding层将标题向量的词向量拼接成词矩阵后再输入cnn,以符合cnn输入要求。

98.这里,本发明实施例对cnn、bilstm、multi

‑

head self

‑

attention的具体结构不做限定,现有技术中cnn、bilstm、multi

‑

head self

‑

attention的任何网络结构都可应用到本发明实施例中。

99.本发明实施例中,预设学习目标包括度量学习目标,通过设置度量学习目标对共享模型进行训练,能够使共享模型学习度量表达,使同类视频的表征向量之间的距离尽可能小,不同类视频的表征向量之间的距离尽可能大,从而利用共享模型能够准确选取相似视频进行召回。

100.其中,为了增加学习维度,提高视频推荐相似判断的多样性和准确性,优选的,所述预设学习目标还包括标签多分类目标。标签多分类目标指希望通过学习,让模型输出的向量能够预测样本的标签多分类结果。

101.此时,本发明实施例从度量学习维度和标签多分类维度多维度进行模型训练,当共享模型训练完成后,共享模型输出的表征向量之间的距离具有区分不同类视频的功能,而且由于模型训练过程中增加了标签多分类目标,可通过标签多分类目标实现对度量学习目标的辅助,当模型输出结果不满足标签多分类目标时,说明模型表达不够准确,则继续调整模型,从而能够提高模型向量表达的准确性,且可通过模型输出向量对视频从标签分类角度和向量距离角度多角度进行相似性判断,提高了视频推荐相似判断的多样性和准确性。

102.当预设学习目标还包括标签多分类目标时,优选的,上述步骤105包括:

103.步骤1051:根据所述样本数据的表征向量以及所述度量学习目标的第一损失函数,获取第一损失值。

104.这里,利用样本数据的表征向量以及度量学习目标的第一损失函数,获取第一损失值,以基于第一损失值衡量共享模型与度量学习目标之间的距离,从而不断调整共享模型直至达到度量学习目标。

105.其中,第一损失函数如可采用三元组损失triplet loss函数。当采用triplet loss函数时,还会考虑正负样本与锚样本的距离关系,此时度量学习目标指希望通过学习,让模型输出的同类样本(锚样本与正样本)的表征向量之间的距离d1尽可能小(小于第一阈值),不同类样本(锚样本与负样本)的表征向量之间的距离d2尽可能大(大于第二阈值),并且还要让d1与d2之间有一个最大值(d1与d2之间的距离大于第三阈值)。

106.当然,本发明实施例的第一损失函数并不限于triplet loss函数,现有技术中任何能够实现度量学习的损失函数都能够应用到本发明实施例中,例如n

‑

pair

‑

ms loss等,在此不一一说明。

107.步骤1052:根据所述样本数据的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

108.这里,利用样本数据的表征向量以及标签多分类目标的第二损失函数,获取第二损失值,以基于第二损失值衡量共享模型与标签多分类目标之间的距离,从而不断调整共享模型直至达到标签多分类目标。

109.其中,第二损失函数如可采用交叉熵函数,但不限于此,现有技术中任何能够实现标签多分类目标的损失函数都能够应用到本发明实施例中。

110.步骤1053:根据所述第一损失值和所述第二损失值,确定所述共享模型的损失值。

111.这里,综合度量学习的第一损失值和标签多分类的第二损失值,作为共享模型的损失值进行模型调整,能够使模型通过不断调整达到度量学习目标和标签多分类目标,从而增加了学习维度,提高了视频推荐相似判断的多样性和准确性。

112.具体的,步骤1053可将第一损失值和第二损失值进行求和计算,将两者之和作为共享模型的损失值调整模型,也可按照其他计算方式,例如将第一损失值和第二损失值加权后求和,在此不做限定。

113.步骤1054:根据所述共享模型的损失值,对所述共享模型的参数进行调整。

114.这里,模型训练过程中,根据共享模型的损失loss值,可以确定共享模型与学习目标之间的差距,当共享模型没有达到学习目标时,根据共享模型的loss值,对共享模型的权重等参数进行调整,以不断调整共享模型,直至最终共享模型达到学习目标。

115.其中,本发明实施例也可只设置度量学习目标,当预设学习目标只包括度量学习目标时,上述步骤105将根据样本数据的表征向量以及度量学习目标的第一损失函数获得的第一损失值,直接作为共享模型的损失值即可。

116.当预设学习目标还包括标签多分类目标时,优选的,共享模型还可包括全连接层,上述步骤104包括:

117.通过全连接层将上下文特征学习之后的向量进行线性变换和激活处理,获得样本数据的表征向量。

118.这里,全连接dense层前是第二bilstm层,经过第二bilstm层得到了包含整个句子信息的一个向量,然后再经过dense层,对这个向量做一个简单线性变换加激活函数的激活处理,使处理后的向量具有标签分类的显示表达,便于标签多分类目标的学习。

119.当然,本发明实施例也可不采用全连接层,直接将第二bilstm层输出的向量作为共享模型输出的样本数据的表征向量。

120.如图2所示,为本发明实施例的一共享模型的网络结构,包括cnn层、第一lstm层、self

‑

attention层、第二lstm层和dense层。此时,共享模型结合cnn、lstm和self

‑

attention思想,使得模型训练过程中,对标题的特征提取更准确、更全面,在面对新奇的网络语言时,可以更好的捕获到标题的表征含义。

121.例如,样本数据包括锚样本为“万米高空,医生为病人吸尿800毫升”对应的句向量,正样本为“同乘医生与空乘联手,紧急施救”对应的句向量,负样本为“看一个人的剧,吃

两个人的饭”对应的句向量。将锚样本、正样本和负样本对应的句向量分别输入到共享模型中,依次经过共享模型的cnn层、第一lstm层、self

‑

attention层、第二lstm层和dense层,获得锚样本、正样本和负样本最终的表征向量,然后根据最终的表征向量对共享模型进行调整,直至共享模型达到学习目标。

122.为了实现至少包括度量学习目标的模型训练,优选的,上述步骤101之前,所述方法还包括:

123.从训练数据集中选取包括锚样本、正样本和负样本的样本数据;其中所述锚样本和所述正样本属于同一类别,所述锚样本和所述负样本属于不同类别。

124.这里,从训练数据集中选取的样本数据包括三元组:锚样本a、正样本p和负样本q,以基于三元组样本数据对共享模型进行至少包括度量学习目标的模型训练。

125.其中,锚样本是作为衡量标准,无正负含义的一个样本,正样本和负样本都是以锚样本为标准选取的。具体的,训练数据集中每个样本除了包含标题向量外,还可包含指示标题类别的标签信息,本发明实施例中可将从训练数据集中随机选取的样本作为锚样本,随机选取标签信息指示的类别和锚样本的标签信息指示的类别属于同一类的样本作为正样本,随机选取标签信息指示的类别和锚样本的标签信息指示的类别不属于同一类的样本作为负样本。

126.获得三元组样本数据后,需要将三元组中的每个样本输入到共享模型中进行模型训练。优选的,上述步骤101包括:

127.将所述锚样本、所述正样本和所述负样本分别输入到所述共享模型中。

128.此时,通过将锚样本a、正样本p和负样本q分别经过共享模型后,得到三个样本的表征向量,以基于三个样本的表征向量分析正负样本与锚点之间的距离,实现至少包括度量学习目标的模型训练。

129.如前所述,为了增加学习维度,本发明实施例可同时设置度量学习目标和标签多分类目标,基于此,获得模型输出的锚样本a、正样本p和负样本q的表征向量后,可首先计算度量学习目标的损失值,然后计算标签多分类目标的损失值,最后综合度量学习目标和标签多分类目标的损失值进行模型调整,以达到多目标学习目的。

130.优选的,首先计算度量学习目标的损失值,上述步骤1051包括:

131.根据所述锚样本的表征向量、所述正样本的表征向量、所述负样本表征向量以及所述度量学习目标的第一损失函数,获取第一损失值。

132.此时,利用三元组样本数据的表征向量以及第一损失函数,能够准确获取度量学习目标的第一损失值,以基于第一损失值衡量共享模型与度量学习目标之间的距离,从而调整共享模型达到度量学习目标。

133.度量学习目标指希望通过学习,让模型输出的锚样本与正样本的表征向量之间的距离d1尽可能小(小于第一阈值),锚样本与负样本的表征向量之间的距离d2尽可能大(大于第二阈值),并且还要让d1与d2之间有一个最大值(d1与d2之间的距离大于第三阈值)。

134.获得度量学习目标的第一损失值后,继续计算标签多分类目标的损失值,上述步骤1052包括:

135.根据所述锚样本的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

136.此时,利用锚样本的表征向量以及第二损失函数,能够准确获取标签多分类目标的第二损失值,以基于第二损失值衡量共享模型与标签多分类目标之间的距离,从而调整共享模型达到标签多分类目标。

137.本发明实施例,综合度量学习目标和标签多分类目标进行多目标模型训练,增加了学习维度,提高了视频推荐相似判断的多样性和准确性。

138.为了实现模型训练,需要从训练数据集中选取样本数据,本发明实施例可通过如下方式提前获得训练数据集。

139.优选的,上述步骤101之前,所述方法还包括:

140.步骤1001:从语料库中选取视频的标题信息。

141.这里,首先从语料库中取出标题信息,其中提取出标题信息后,可将标题中的非关键信息(如停用词)去掉,减少非关键信息对句子语义表示的影响。

142.步骤1002:根据预设的字典文件,查询每个标题信息包含的字对应的编号;其中所述字典文件包括所述语料库中所有字对应的编号。

143.这里,针对每个标题进行查字典操作,查询标题的每个字所对应的编号,以基于编号生成标题向量。

144.其中,可预先将语料库中所有标题切成单个字后,给每个字编号,生成整个语料库的字典文件,具体编号方式可根据需求进行设定,在此不做限定。

145.步骤1003:根据每个标题信息包含的字对应的编号,获取每个标题信息的标题向量,并将每个标题信息的标题向量作为训练数据集中的样本。

146.这里,根据每个标题包含的字对应的编号,获取每个标题的标题向量作为用于模型训练的样本,就获得了包括多个样本的训练数据集。

147.其中,可将每个标题包含的字对应的编号进行拼接后,获得每个标题的标题向量。本发明实施例对编号具体的拼接方式不做限定。

148.为了实现标签多分类目标,优选的,上述步骤101之前,所述方法还包括:

149.步骤1004:从语料库中获取训练数据集中所有样本的标签信息。

150.这里,从语料库中选取样本的标题信息的同时,还要选取样本的标签信息,以基于标签信息实现标签多分类。其中语料库中的部分标签会带有相应的分值,获取到标签信息之后还可去除每个标签信息中的分值数据,只保留标签信息,能够避免分值部分对标签分类的干扰。

151.步骤1005:对所有标签信息通过预设聚类算法进行聚类操作,获得聚类后的标签总分类信息。

152.这里,对所有标签信息通过预设聚类算法进行聚类操作,即将不同属性的标签聚类到不同的组别中,就获得了训练数据集中所有样本的标签总分类信息,以基于此实现标签多分类目标。

153.其中,预设聚类算法如可采用k均值聚类算法(k

‑

means clustering algorithm),但不限于此。

154.获得标签总分类信息后,上述步骤1052包括:

155.步骤10521:根据所述标签总分类信息以及所述样本数据的标签信息,获取所述样本数据的标签多分类向量。

156.这里,首先根据标签总分类信息以及样本数据本身的标签信息,获取样本数据的标签多分类向量,该样本数据的标签多分类向量为样本数据真实的标签多分类结果。

157.例如,通过步骤1005将所有标签聚类成a、b、c、d、e五类,样本数据的标签为“青春有你”,属于b类,则在获取样本数据的标签多分类向量时,可将a、b、c、d、e这5类标签按照上述顺序排列,将b类的位置编号置为1,其他类的位置编号置为0,最终获得“01000”的标签多分类向量。

158.当然,上述标签多分类向量的编码方式仅为举例说明,并不限于此。

159.步骤10522:根据所述样本数据的表征向量、所述样本数据的标签多分类向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

160.这里,样本数据的表征向量代表模型预测的标签多分类结果,根据样本数据的表征向量、样本数据的标签多分类向量以及第二损失函数,获得能够代表模型预测的标签多分类结果与真实结果之间差距的第二损失值,从而基于第二损失值不断调整模型直至达到标签多分类目标。

161.其中,当选取的样本数据包括锚样本、正样本、负样本时,上述步骤10521

‑

10522可基于锚样本的标签信息进行标签多分类目标的计算。

162.下面对模型训练完成后如何选取召回视频的一种优选的实现方式进行介绍。优选的,上述步骤107包括:

163.步骤1071:根据目标视频的表征向量与多个预设候选视频中每个预设候选视频的表征向量之间的距离,获取所述目标视频与每个预设候选视频之间的相似度。

164.这里,当共享模型训练完成后,共享模型输出的表征向量之间的距离具有区分不同类视频的功能,根据目标视频的表征向量与每个预设候选视频的表征向量之间的距离,能够准确获取目标视频与每个预设候选视频之间的相似度。

165.其中,可预先利用训练好的共享模型获取多个预设候选视频的表征向量,暂存到本地或存储到数据库中。或者也可在召回视频时利用训练好的共享模型实时获取多个预设候选视频的表征向量。

166.步骤1072:选取与所述目标视频的相似度按照从高到低的顺序排列在前n位的预设候选视频,作为所述目标视频的召回视频存放到所述目标视频的召回视频候选集中;其中n为大于或等于1的整数。

167.这里,通过选取与目标视频的相似度高的topn个预设候选视频,作为召回视频存放到召回视频候选集中,实现了准确选取召回视频的目的,当对目标视频进行召回时,直接获取对应的召回视频候选集返回即可。

168.其中,n的值可根据需求进行设定,n可为任意值,例如n设定为300,则选取与目标视频的相似度高的top300个预设候选视频,作为召回视频存放到召回视频候选集中。

169.其中,目标视频的召回视频候选集可存储到本地或数据库,以便随时调用,或者目标视频的召回视频候选集也可在收到召回请求时实时获取。

170.其中,目标视频指任意一个有召回视频需求的视频。本发明实施例,也可对多个有召回视频需求的视频进行批量操作,即通过上述步骤1071

‑

1072批量获取多个目标视频的召回视频候选集。

171.具体的,本发明实施例可利用faiss索引框架(facebook开源向量搜索引擎)执行

上述步骤1071

‑

1072,得到与每个目标视频video相似度高的召回视频候选集,然后将每个目标视频video及其对应的召回视频候选集写入数据库,当对视频进行召回时,从数据库可直接获取到对应的召回视频候选结果。

172.本发明实施例的视频召回方法,将标题切成字,通过共享模型的卷积神经网络层学习词含义,并通过上下文特征学习层增加上下文特征的学习维度,使得对标题的特征学习更准确、更全面,提高了学习能力,这样即使在面对新奇的网络语言时,也可以通过共享模型对网络语言进行更加准确、全面的学习分析,从而更好的捕获到标题的表征含义,并结合度量学习目标对共享模型进行度量学习的训练,使共享模型具有度量表达能力,由此基于共享模型输出的表征向量进行视频召回,可以得到更高质量的相似视频结果,提高了视频召回推荐结果的准确性。

173.参见图3所示,本发明实施例还提供了一种视频召回装置300,包括:

174.第一输入模块301,用于将预先从训练数据集中选取的样本数据输入到共享模型中;所述样本数据包括标题中所有字对应的编号组成的标题向量,所述共享模型包括卷积神经网络层和上下文特征学习层;

175.第一学习模块302,用于通过所述共享模型的卷积神经网络层对所述样本数据的标题向量进行词含义学习,获得词含义学习之后的向量;

176.第二学习模块303,用于通过所述共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量;

177.第一获取模块304,用于根据上下文特征学习之后的向量获取所述样本数据的表征向量;

178.模型训练模块305,用于根据所述样本数据的表征向量以及预设学习目标,对所述共享模型进行训练;所述预设学习目标包括度量学习目标;

179.第二输入模块306,用于当所述共享模型训练完成时,将目标视频的标题向量输入到训练好的共享模型中,获得所述目标视频的表征向量;

180.第二获取模块307,用于根据所述目标视频的表征向量,获取所述目标视频的召回视频候选集。

181.本发明实施例的视频召回装置,将标题切成字,通过共享模型的卷积神经网络层学习词含义,并通过上下文特征学习层增加上下文特征的学习维度,使得对标题的特征学习更准确、更全面,提高了学习能力,这样即使在面对新奇的网络语言时,也可以通过共享模型对网络语言进行更加准确、全面的学习分析,从而更好的捕获到标题的表征含义,并结合度量学习目标对共享模型进行度量学习的训练,使共享模型具有度量表达能力,由此基于共享模型输出的表征向量进行视频召回,可以得到更高质量的相似视频结果,提高了视频召回推荐结果的准确性。

182.优选的,所述上下文特征学习层包括:第一双向长短期记忆网络层、多抽头自注意力层和第二双向长短期记忆网络层;

183.所述第二学习模块303具体用于:

184.通过所述第一双向长短期记忆网络层对词含义学习之后的向量进行第一次上下文特征学习,获得上下文特征学习之后的第一向量;

185.通过所述多抽头自注意力层对上下文特征学习之后的第一向量进行多抽头自注

意力学习,获得多抽头自注意力学习之后的第二向量;

186.通过所述第二双向长短期记忆网络层对多抽头自注意力学习之后的第二向量进行第二次上下文特征学习,获得上下文特征学习之后的第三向量。

187.优选的,所述第一学习模块302具体用于:

188.通过所述卷积神经网络按照多个不同大小的卷积核对所述样本数据的标题向量进行卷积处理,获得词含义学习之后的向量。

189.优选的,所述预设学习目标还包括标签多分类目标;所述模型训练模块305包括:

190.第一获取子模块,用于根据所述样本数据的表征向量以及所述度量学习目标的第一损失函数,获取第一损失值;

191.第二获取子模块,用于根据所述样本数据的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值;

192.确定子模块,用于根据所述第一损失值和所述第二损失值,确定所述共享模型的损失值;

193.调整子模块,用于根据所述共享模型的损失值,对所述共享模型的参数进行调整。

194.优选的,所述装置还包括:

195.第一选取模块,用于从训练数据集中选取包括锚样本、正样本和负样本的样本数据;其中所述锚样本和所述正样本属于同一类别,所述锚样本和所述负样本属于不同类别;

196.所述第一输入模块301具体用于:

197.将所述锚样本、所述正样本和所述负样本分别输入到所述共享模型中;

198.所述第一获取子模块具体用于:

199.根据所述锚样本的表征向量、所述正样本的表征向量、所述负样本表征向量以及所述度量学习目标的第一损失函数,获取第一损失值;

200.所述第二获取子模块具体用于:

201.根据所述锚样本的表征向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

202.优选的,所述装置还包括:

203.第三获取模块,用于从语料库中获取训练数据集中所有样本的标签信息;

204.聚类模块,用于对所有标签信息通过预设聚类算法进行聚类操作,获得聚类后的标签总分类信息;

205.所述第二获取子模块包括:

206.第一获取单元,用于根据所述标签总分类信息以及所述样本数据的标签信息,获取所述样本数据的标签多分类向量;

207.第二获取单元,用于根据所述样本数据的表征向量、所述样本数据的标签多分类向量以及所述标签多分类目标的第二损失函数,获取第二损失值。

208.优选的,所述装置还包括:

209.第二选取模块,用于从语料库中选取视频的标题信息;

210.查询模块,用于根据预设的字典文件,查询每个标题信息包含的字对应的编号;其中所述字典文件包括所述语料库中所有字对应的编号;

211.第四获取模块,用于根据每个标题信息包含的字对应的编号,获取每个标题信息

的标题向量,并将每个标题信息的标题向量作为训练数据集中的样本。

212.优选的,所述第二获取模块307具体用于:

213.根据目标视频的表征向量与多个预设候选视频中每个预设候选视频的表征向量之间的距离,获取所述目标视频与每个预设候选视频之间的相似度;

214.选取与所述目标视频的相似度按照从高到低的顺序排列在前n位的预设候选视频,作为所述目标视频的召回视频存放到所述目标视频的召回视频候选集中;其中n为大于或等于1的整数。

215.本发明实施例的视频召回装置,将标题切成字,通过共享模型的卷积神经网络层学习词含义,并通过上下文特征学习层增加上下文特征的学习维度,使得对标题的特征学习更准确、更全面,提高了学习能力,这样即使在面对新奇的网络语言时,也可以通过共享模型对网络语言进行更加准确、全面的学习分析,从而更好的捕获到标题的表征含义,并结合度量学习目标对共享模型进行度量学习的训练,使共享模型具有度量表达能力,由此基于共享模型输出的表征向量进行视频召回,可以得到更高质量的相似视频结果,提高了视频召回推荐结果的准确性。

216.对于上述装置实施例而言,由于其与方法实施例基本相似,相关之处参见方法实施例的部分说明即可。

217.本发明实施例还提供了一种电子设备,该电子设备可以是服务器。如图4所示,包括处理器401、通信接口402、存储器403和通信总线404,其中,处理器401,通信接口402,存储器403通过通信总线404完成相互间的通信。

218.存储器403,用于存放计算机程序。

219.处理器401用于执行存储器403上所存放的程序时,实现如下步骤:

220.将预先从训练数据集中选取的样本数据输入到共享模型中;所述样本数据包括标题中所有字对应的编号组成的标题向量,所述共享模型包括卷积神经网络层和上下文特征学习层;

221.通过所述共享模型的卷积神经网络层对所述样本数据的标题向量进行词含义学习,获得词含义学习之后的向量;

222.通过所述共享模型的上下文特征学习层对词含义学习之后的向量进行上下文特征学习,获得上下文特征学习之后的向量;

223.根据上下文特征学习之后的向量获取所述样本数据的表征向量;

224.根据所述样本数据的表征向量以及预设学习目标,对所述共享模型进行训练;所述预设学习目标包括度量学习目标;

225.当所述共享模型训练完成时,将目标视频的标题向量输入到训练好的共享模型中,获得所述目标视频的表征向量;

226.根据所述目标视频的表征向量,获取所述目标视频的召回视频候选集。

227.上述电子设备提到的通信总线可以是外设部件互连标准(peripheral component interconnect,简称pci)总线或扩展工业标准结构(extended industry standard architecture,简称eisa)总线等。该通信总线可以分为地址总线、数据总线、控制总线等。为便于表示,图中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

228.通信接口用于上述电子设备与其他设备之间的通信。

229.存储器可以包括随机存取存储器(random access memory,简称ram),也可以包括非易失性存储器(non

‑

volatile memory),例如至少一个磁盘存储器。可选的,存储器还可以是至少一个位于远离前述处理器的存储装置。

230.上述的处理器可以是通用处理器,包括中央处理器(central processing unit,简称cpu)、网络处理器(network processor,简称np)等;还可以是数字信号处理器(digital signal processing,简称dsp)、专用集成电路(application specific integrated circuit,简称asic)、现场可编程门阵列(field-programmable gate array,简称fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。

231.在本发明提供的又一实施例中,还提供了一种计算机可读存储介质,该计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述实施例中所述的视频召回方法。

232.在本发明提供的又一实施例中,还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述实施例中所述的视频召回方法。

233.在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件实现时,可以全部或部分地以计算机程序产品的形式实现。所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本发明实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一个计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、服务器或数据中心通过有线(例如同轴电缆、光纤、数字用户线(dsl))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存取的任何可用介质或者是包含一个或多个可用介质集成的服务器、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,dvd)、或者半导体介质(例如固态硬盘solid state disk(ssd))等。

234.需要说明的是,在本文中,诸如第一和第二等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

235.本说明书中的各个实施例均采用相关的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于系统实施例而言,由于其基本相似于方法实施例,所以描述的比较简单,相关之处参见方法实施例的部分说明即可。

236.以上所述仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进等,包含在本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1