一种无人机视觉侦察定位方法与流程

1.本发明涉及无人机导航技术领域,具体涉及一种无人机视觉侦察定位方法。

背景技术:

2.随着无人系统的快速发展和普及,无人机在众多领域发挥的作用越来越大。众多需求中,如边境巡检,森林防火,搜救,等巡检类应用,以及逃犯抓捕等侦察类应用,不少都需要具备目标定位能力,这类应用对定位的精度没有非常精确的要求,大多为米级可满足功能需求。这样则不需要搭载如三维建模激光雷达,深度相机等昂贵的建模定位设备。且该类应用通常需要在地面灵活的操作视频镜头,使用吊舱最为适合。

3.目前,无人机在进行侦察任务时,通常是在发现目标后锁定目标并对其进行持续跟踪,由于发现目标及定位目标的过程需要多个机载设备协调完成,需要融合多种数据才能较为准确的计算出目标的位置。另外,由于无人机在锁定目标后,仍处于持续运动状态,目标相对于无人机的位置是持续变化的,所以在采集数据及处理数据的过程中必然存在误差,造成目标定位的不准确

技术实现要素:

4.基于现有技术存在的问题和不足,本技术提供了一种无人机视觉侦察定位方法,给只挂载吊舱的这一类无人机设备具备视觉侦察和目标定位的能力,同时提高定位精度。

5.具体技术方案如下:

6.一种无人机视觉侦察定位方法,其特征在于,所述方法包括步骤:

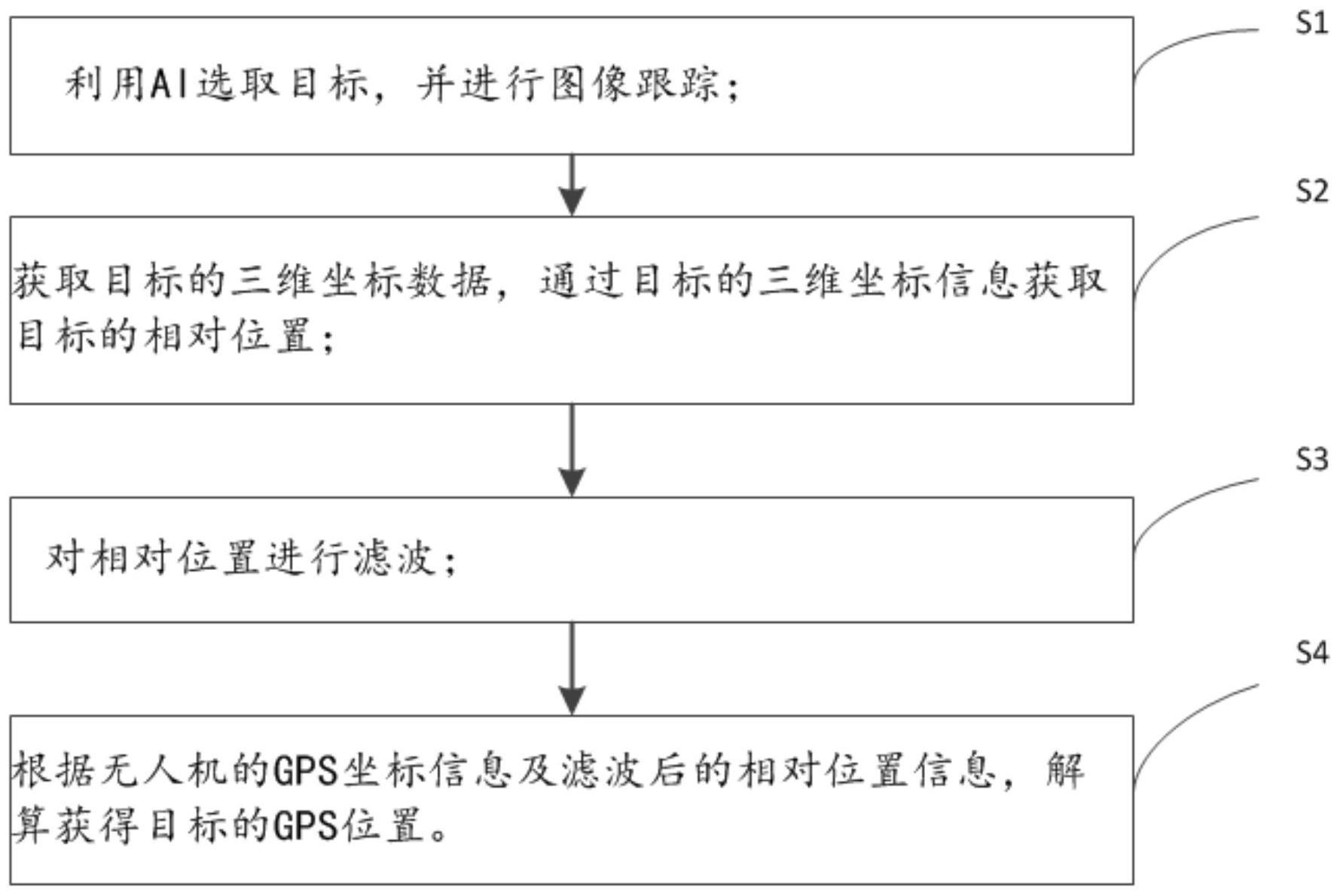

7.s1,利用ai选取目标,并进行图像跟踪;

8.s2,获取目标的三维坐标数据,通过目标的三维坐标信息获取目标的相对位置;

9.s3,对相对位置进行滤波;

10.s4,根据无人机的gps坐标信息及滤波后的相对位置信息,解算获得目标的gps位置。

11.进一步地,步骤s2中,获取目标的三维坐标信息的方法包括:

12.s21,获取无人机姿态、吊舱姿态、激光测距距离,通过吊舱焦距反算出视场角;

13.s22,通过像素位置、视场角、无人机姿态、吊舱姿态以及测距距离反算出相对位置,反算的方法包括利用三轴旋转矩阵融合无人机姿态及吊舱姿态,获得融合姿态向量,其中,无人机姿态、吊舱姿态都为三轴姿态,

14.三轴旋转矩阵为:

15.[0016][0017][0018]

融合姿态向量为:

[0019]wmix

=w

ahrs

×rz

(yaw)

×ry

(pitch)

×rx

(roll)

[0020]

融合视场角数据为:

[0021]wt

=w

mix

×rz

(yaw)

×ry

(pitch)

×rx

(roll)

[0022]

其中,roll表示飞行器横滚角,pitch表示飞行器俯仰角,yaw表示飞行器航向角,w

mix

表示飞行器-吊舱姿态融合矩阵,w

ahrs

表示飞行器姿态矩阵;w

t

表示目标相对位置向量矩阵,rz表示z轴旋转矩阵,ry表示y轴旋转矩阵,r

x

表示x轴旋转矩阵;

[0023]

然后通过坐标系换算反算出无人机和目标的球坐标系位置。

[0024]

进一步地,所述的激光测距距离测得的是无人机距离目标的直线距离。

[0025]

进一步地,s3中对相对位置进行滤波的方法包括采用αβ滤波器进行滤波,具体的滤波方法包括步骤:

[0026]

s31,根据历史数据的方差确定αβ滤波器的初始参数;

[0027]

s32,获取第k点的测量值xk,并计算测量更新方程其中,xk为第k点的位置测量值,为第k点的位置预测值,为第k-1 点的位置预测值,δt为滤波周期,为第k-1点的速度预测值;

[0028]

s33,计算第k点的αβ滤波器位置预测更新方程和速度估计方程,其中,

[0029]

预测更新方程为:

[0030][0031]

其中,为第k点位置预测的误差值;

[0032]

速度估计方程为:

[0033]

其中,为第k点的速度预测值;

[0034]

s34,计算第k点的αβ滤波器的误差方程:

[0035][0036]

s35,获取距离当前一段时间内的数据的方差:

[0037][0038]

其中,xi表示一段时间内第i个距离数据,表示一段时间内的距离平均值;

[0039]

获取解算目标准确性的系数:

[0040][0041]

δw表示目标的机动性系数;

[0042]

根据机动性和方差计算获取αβ两个参数,其中,

[0043][0044][0045]

s35,若继续跟踪,则判断误差是否在合理范围内,若是,则返回s32,若误差没在合理范围内,则获取αβ滤波器参数,更新滤波器预测值,若不继续跟踪,则结束。

[0046]

进一步地,步骤s4中,根据无人机的gps坐标信息及滤波后的相对位置信息,解算获得目标的gps位置的方法包括:

[0047]

获取目标的ned坐标:

[0048][0049]

根据目标的ned坐标,通过公式

[0050][0051]

获取目标的真实位置坐标信息,其中,p

ned

表示北东地坐标系下飞行器和目标的相对位置,lng及longitude表示经度,lat及lattitude表示纬度,alt及altitude 表示海拔高度,n表示以北为正方向的南北向相对距离,e表示以东为正方向的东西向相对距离,d表示以地为正方向的地空向相对距离,ea表示地球极半径,eb表示地球赤道半径。

[0052]

进一步地,步骤s1中,对目标进行跟踪时需要获取目标的经纬度信息和像素位置。

[0053]

有益效果:利用无人机定位数据,结合滤波后的相对位置,进行坐标转换推算出目标的gps位置,实现了对目标的精准定位。

附图说明

[0054]

为了更清楚地说明本发明的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其它的附图。

[0055]

图1为本发明的方法流程图;

[0056]

图2为本发明中对相对位置进行滤波的方法流程图。

具体实施方式

[0057]

下面结合附图对本发明实施例进行详细描述。

[0058]

以下通过特定的具体实例说明本发明的实施方式,本领域技术人员可由本说明书所揭露的内容轻易地了解本发明的其他优点与功效。显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。本发明还可以通过另外不同的具体实施方式加以实施或应用,本说明书中的各项细节也可以基于不同观点与应用,在没有背离本发明的精神下进行各种修饰或改变。需说明的是,在不冲突的情况下,以下实施例及实施例中的特征可以相互组合。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0059]

如图1所示,一种无人机视觉侦察定位方法,包括步骤:

[0060]

s1,利用ai选取目标,并进行图像跟踪,获得目标像素位置;

[0061]

本步骤中,无人机在获取到吊舱图像后,无人机可通过与自身的主控制器外接的处理器对图像进行处理,该处理器通过摄像机采集图像,无人机的主控制器可使用串口通讯协议控制该外接的处理器,摄像机选择能识别特定的物体的摄像机,并实现对侦查目标的图像跟踪,并返回跟踪物体在图像上的像素坐标,作为数据用于后面的位置解算。

[0062]

s2,获取无人机姿态,吊舱姿态,激光测距距离,通过吊舱焦距反算出视场角;

[0063]

本步骤中,通过吊舱的相机参数以及反馈的焦距信息,能得出当前焦距下的视场角数据,通过像素位置,视场角,飞行器姿态,吊舱姿态,以及测距距离反算出相对位置,其中,反算的方法包括利用三轴旋转矩阵融合无人机姿态及吊舱姿态,获得融合姿态向量,其中,无人机姿态、吊舱姿态都为三轴姿态,

[0064]

三轴旋转矩阵为:

[0065][0066][0067][0068]

其中,roll表示飞行器横滚角,pitch表示飞行器俯仰角,yaw表示飞行器航向角,rz表示z轴旋转矩阵,ry表示y轴旋转矩阵,r

x

表示x轴旋转矩阵;

[0069]

融合姿态向量为:

[0070]wmix

=w

ahrs

×rz

(yaw)

×ry

(pitch)

×rx

(roll)

[0071]

其中,w

mix

表示飞行器-吊舱姿态融合矩阵,w

ahrs

表示飞行器姿态矩阵;

[0072]

吊舱的成像过程可以等效为三维世界ocxcyczc的集合向二维平面oxy的投影过程。其深度信息在投影过程中丢失,使得从常规手段无法根据吊舱得到的图像像素信息无损的

还原出真实三维世界的全部信息,而通过激光测距作为辅助测量手段,利用激光测距作为深度信息的获取手段,近似的还原出目标附近的深度信息。从而能够结合其他已知条件解算出目标的相对位置。

[0073]

首先,获取融合视场角数据为:

[0074]wt

=w

mix

×rz

(yaw)

×ry

(pitch)

×rx

(roll)

[0075]

其中,w

t

表示目标相对位置向量矩阵。

[0076]

然后通过坐标系换算反算出无人机和目标的球坐标系位置。

[0077]

基于上述分析,可设吊舱的旋转中心为球坐标系的原点为o,锁定到的目标点为p。方向角φ和仰角θ均可以通过融合矢量w

t

进行坐标换算获得,原点o到目标点p的距离r即为激光测距距离。p点的球坐系是标唯一,可以通过坐标换算反算出飞行器和目标p的笛卡尔坐标系下的相对位置p(x,y,z)。

[0078]

如图2所示,s3,对相对位置进行滤波,滤波的具体方法包括:

[0079]

s31,根据历史数据的方差确定αβ滤波器的初始参数;

[0080]

s32,获取第k点的测量值并计算测量方程

[0081]

s33,计算第k点的αβ滤波器位置预测更新方程和速度估计方程,其中,更新方程为其中,xk为第k点的位置测量值,为第k点的位置预测值,为第k-1点的位置预测值,δt为滤波周期,为第k-1点的速度预测值;

[0082]

速度估计方程为:

[0083]

其中,为第k点的速度预测值;

[0084]

由于无人机姿态和吊舱姿态,激光测距存在不同程度的误差,此时通过解算得到的相对位置会收到这些误差的综合影响。结合无人机的运动和目标的运动模型,将目标与飞行器的相对运动近似为一个二阶状态模型,即目标与飞行器的相对速度v以及目标与飞行器的相对位置p。观测量(测量值)为通过前一步骤解算得到的相对位置p,对应模型中的一阶状态。假设滤波周期δt足够小,可以近似认为二阶状态(速度v)是保持不变的,结合卡尔曼滤波的思想,可以对下一个周期的模型的状态进行合理预测,在卡尔曼滤波的思想下,存在假设的下个时刻的速度与上一时刻是相同,

[0085]

s34,计算第k点的αβ滤波器的误差方程:

[0086][0087]

s35,获取距离当前一段时间内的数据的方差:

[0088][0089]

其中,xi表示一段时间内第i个距离数据,表示一段时间内的距离平均值;

[0090]

获取解算目标准确性的系数:

[0091][0092]

δw表示目标的机动性系数,δw通过人为判定后手动设定,作为系统的输入参数进行灵活调节。

[0093]

根据机动性和方差计算获取αβ两个参数,其中,

[0094][0095][0096]

s35,若继续跟踪,则判断误差是否在合理范围内,若是,则返回s32,若误差没在合理范围内,则获取αβ滤波器参数,更新滤波器预测值,若不继续跟踪,则结束。

[0097]

s4,根据无人机的gps坐标信息及滤波后的相对位置信息,解算获得目标的gps位置。

[0098]

本步骤中,解算获得目标的gps位置的方法包括:

[0099]

获取目标的ned坐标:

[0100][0101]

根据目标的ned坐标,通过公式

[0102][0103]

其中,p

ned

表示北东地坐标系下飞行器和目标的相对位置,lng及longitude表示经度,lat及lattitude表示纬度,alt及altitude表示海拔高度,n表示以北为正方向的南北向相对距离,e表示以东为正方向的东西向相对距离,d表示以地为正方向的地空向相对距离,ea为地球赤道半径,eb为地球极半径。

[0104]

通过上述的公式可获取目标的真实位置坐标信息。

[0105]

本实施例方法中,利用摄像头获取图像,ai视觉辅助进行目标自动选取,对锁定目标进行稳定视觉跟踪,再改进的αβ滤波器对位置数据进行滤波,得到满足控制条件的位置数据,再利用飞行器定位数据,结合滤波后的相对位置,进行坐标转换推算出目标的gps坐标,从而实现对侦察目标的定位。

[0106]

以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以权利要求的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1