一种基于深度强化学习的多智能体的避险逃生方法及装置

本发明涉及的是机器人应用,尤其涉及一种基于深度强化学习的多智能体的避险逃生方法及装置。

背景技术:

1、随着人口老龄化的加剧,劳动力的数量和质量也随之下降,这将对工厂的生产和运营产生影响。而无人工厂可以通过机器自动化和智能化生产,减少对人力的依赖,从而在一定程度上缓解劳动力短缺的问题。此外,无人工厂还可以提高生产效率,降低成本,增强企业竞争力,这些都可以对人口老龄化所带来的经济压力起到一定的缓解作用。

2、21世纪后,计算机技术和工业自动化高速发展,大部分无人工厂都采用多智能体协同工作以提升稳定性和工作效率,降低生产作业成本。随着工厂规模扩大,工作量增加,智能体的数量也增多,使用集中式方法控制智能体很难拓展到拥有大量智能体的大型系统上,而且在实际部署中,这种集中式方法极其依赖智能体端与中央服务器的稳定可靠的通信网络,一旦中央服务器发生故障,依赖集中式方法的多智能体系统就会崩溃。

3、此外,随着外界环境越来越复杂,传统的规划算法很难处理复杂环境的避障问题,比如需要连续避开多个动态障碍物,安全且快速的到达目标点。并且当外界发生突发情况时,环境可能会发生剧烈变化,传统算法无法及时适应这种变化,导致智能体无法快速做出反应进行逃生,可能会导致智能体在避障过程中出现卡顿或者碰撞等问题,危害财产安全。

技术实现思路

1、本部分的目的在于概述本发明的实施例的一些方面以及简要介绍一些较佳实施例。在本部分以及本技术的说明书摘要和发明名称中可能会做些简化或省略以避免使本部分、说明书摘要和发明名称的目的模糊,而这种简化或省略不能用于限制本发明的范围。

2、鉴于上述存在的问题,提出了本发明。

3、为解决上述技术问题,本发明提供如下技术方案:

4、第一方面,本发明实施例提供了一种基于深度强化学习的多智能体的避险逃生方法,包括:

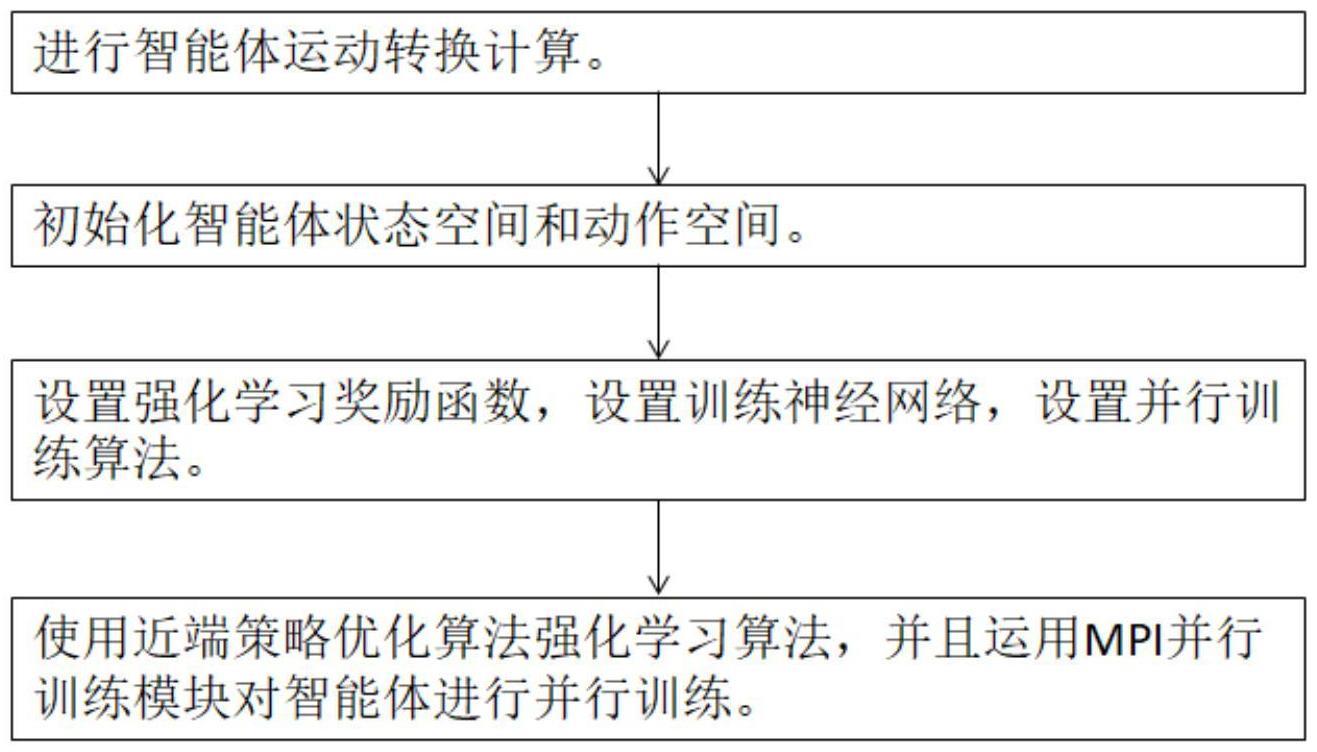

5、进行智能体运动转换计算;

6、初始化智能体状态空间和动作空间;

7、设置强化学习奖励函数,设置训练神经网络,设置并行训练算法;

8、使用近端策略优化算法强化学习算法,并且运用mpi并行训练模块对智能体进行并行训练。

9、作为基于深度强化学习的多智能体的避险逃生方法的一种优选方案,其中:

10、所述进行智能体运动转换计算包括:考虑一个由n个智能体组成的多智能体系统,对于任意一个智能体,运动学模型可以描述为:

11、

12、式中,pi=[pi,x,pi,y]t和vi=[vi,x,vi,y]t分别代表智能体i的位置和速度矢量;fi(pi,vi)是一个与系统状态相关的未知非线性函数;ui表示智能体i的控制输入;

13、定义运动目标的位置为pt=[pt,x,pt,y]t,在惯性坐标系下,智能体i与目标之间的距离ρi和视线角θi可以表示为:

14、

15、

16、作为基于深度强化学习的多智能体的避险逃生方法的一种优选方案,其中:

17、所述初始化智能体状态空间和动作空间包括:

18、状态空间的状态信息由距离感知数据以及智能体imu数据组成,具体的,是来自周围环境的距离信息、智能体的前进速度v和旋转速度ω,以及智能体到目标位置的x和y的相对距离,表示为:

19、

20、其中,stdis是距离感知数据,通过智能体机载设备测量距离来显示障碍物与智能体之间的关系,通过三个连续时间步长上的距离数据来预测物体的运动方向和速度;是智能体与目标位置的相对距离,可以从提供的关于行动方向是否正确的信息中获取移动方向,提供智能体的速度信息,智能体的极限速度,惯性以及根据速度的避障方法可以根据进行分析。

21、作为基于深度强化学习的多智能体的避险逃生方法的一种优选方案,其中:

22、所述初始化智能体状态空间和动作空间还包括:

23、将智能体的行为定义为连续行为,由二维信息前进速度v和旋转速度ω组成,表达如下:

24、at=[v,ω]

25、其中v、ω为连续值,极限约束:v∈[0.00,vmax]、ω∈[ωmin,ωmax]。

26、作为基于深度强化学习的多智能体的避险逃生方法的一种优选方案,其中:

27、所述设置强化学习奖励函数包括:

28、奖励函数由四个不同的奖励函数组合获得,设置如下:

29、r=rg+rc+rt+rω+rv

30、向远离目标位置的方向移动将给予惩罚,而向接近目标位置的方向移动将给予奖励;

31、若智能体到达了目标位置,则得到奖励h;在向目标位置移动时,若到目标的距离比之前短,也会得到奖励,表示为:

32、

33、其中,dispre表示智能体之前成功到达目标点的移动距离,discurr表示智能体当前到达目标点的移动距离;

34、当与障碍物发生碰撞时,rc会施加惩罚p;表示为:

35、

36、对于突发的紧急情况,智能体需要在最短的时间内进行逃生,因此每一步都会施加惩罚分数,以激励智能体做出正确快速的路径选择,t表示时间步长,表示为:

37、rt=-0.001t

38、rω对超过阈值的旋转速度施加惩罚,以防止出现因惯性而导致的难以控制的问题,表示为:

39、

40、rv对智能体的前进速度进行限制,以防止速度过快导致的惯性难以控制的问题,表示为:

41、

42、使用奖励函数对智能体进行训练,每一轮训练的刷新条件由三种情况构成:智能体到达目标位置;智能体与障碍物发生碰撞;智能体时间步长超过设置的最大值。

43、作为基于深度强化学习的多智能体的避险逃生方法的一种优选方案,其中:

44、所述设置训练神经网络包括:设计一个拥有4个隐藏层的神经网络来近似非线性函数,前三个隐藏层用来处理距离测量值,第一个隐藏层对32个一维滤波器进行卷积,覆盖三个输入扫描,并应用relu非线性函数;第二个隐藏层对32个一维滤波器进行卷积,同样采用relu非线性函数;第三个隐藏层是一个具有256个矫正单元的全连接层,第三层的输出与另外两个输入连接,输出的信息与机器人到目标位置的相对距离(x,y)以及智能体的速度(v,ω)一起通过一个全连接层;最后,输出一个高斯分布n(vtmeans,vtlogstd),其中vtmeans是速度的平均值,vtlogstd是一组单独的参数,指的是高斯分布中的对数标准差;为了确保智能体的探索性,智能体最终的行为将从n(vtmeans,vtlogstd)中进行采样。

45、作为基于深度强化学习的多智能体的避险逃生方法的一种优选方案,其中:

46、所述使用ppo强化学习算法,并且运用mpi并行训练模块进行并行训练包括:用集中式学习,分布式执行的范式,其中学习的策略是通过场景下所有智能体收集到的数据进行学习;训练过程中,在mpi并行执行策略进行数据采样和使用采样数据更新策略之间交替进行。

47、第二方面,本发明实施例提供了一种基于深度强化学习的多智能体的避险逃生系统,其特征在于,包括:

48、运动转换模块,用于进行智能体运动转换计算;

49、初始化模块,用于初始化智能体状态空间和动作空间;

50、强化学习模块,用于设置强化学习奖励函数,设置训练神经网络,设置并行训练算法;

51、并行训练算法模块,用于使用近端策略优化算法强化学习算法,并且运用mpi并行训练模块对智能体进行并行训练。

52、第三方面,本发明实施例提供了一种计算设备,包括:

53、存储器和处理器;

54、所述存储器用于存储计算机可执行指令,所述处理器用于执行所述计算机可执行指令,当所述一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现如本发明任一实施例所述的基于深度强化学习的多智能体的避险逃生方法。

55、第四方面,本发明实施例提供了一种计算机可读存储介质,其存储有计算机可执行指令,该计算机可执行指令被处理器执行时实现所述的基于深度强化学习的多智能体的避险逃生方法。

56、本发明的有益效果:本发明解决了分布式框架中避免多个智能体碰撞的问题,构建了仓库的模拟环境并且进行强化学习训练;面对突发情况时,使空间内智能体同时考虑避免障碍物、保持速度、保证安全和快速避险逃生等多个目标,并且做出最优决策;具有部署灵活、可适应性强、避障逃生效果更好以及控制系统的强鲁棒性等优点。

- 还没有人留言评论。精彩留言会获得点赞!