一种基于UAE-DDQN的无人船航向控制方法

本发明属于智能控制,具体涉及无人水面艇的航向控制。

背景技术:

1、随着人工智能技术的迅速发展,无人水面艇作为一种新型的海上运动装置,广泛应用于维护海洋安全、海上设施监测和资源勘探等任务。然而,当无人艇航行至复杂海域时,狂风与海浪往往会对其安全造成极大的隐患。如何有效保障无人水面艇平稳的执行海上任务,成为了智能控制领域的研究热点。但现有的航向控制算法难以实时处理非线性高维数据,输出的控制策略具有一定的迟滞性。不仅如此,在复杂的航行环境时,构建的运动学模型往往过于繁琐而难以求解,这就极大降低了无人艇的航向控制性能,加剧了航行的潜在风险。因此,需要一种无人水面艇的航向控制方法,来有效提高无人艇的安全性能。

技术实现思路

1、本专利正是基于现有技术的上述需求而提出的,本专利提供了一种基于uae-ddqn的无人船航向控制方法,来动态调整复杂海况下无人艇的航行方向,以提高无人艇的航行效率和安全性。

2、本发明的目的可以通过以下技术方案来实现:

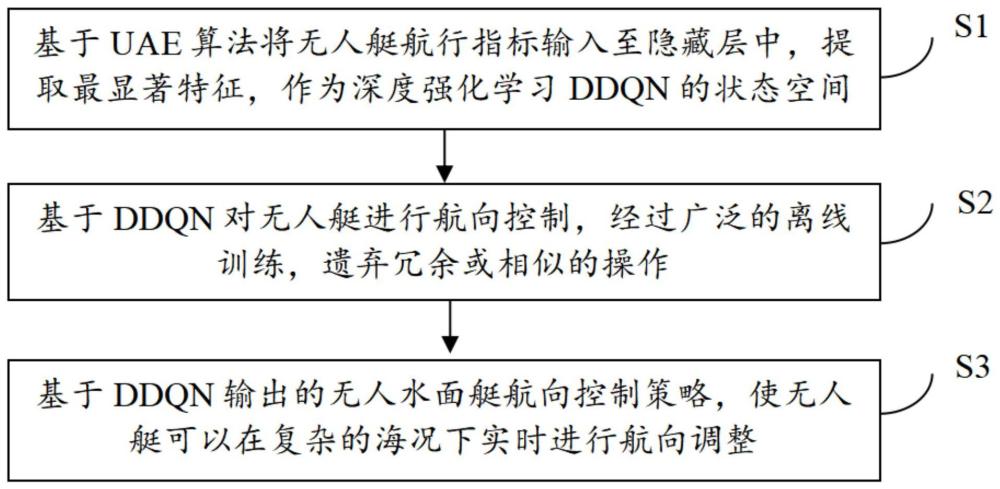

3、一种基于uae-ddqn的无人船航向控制方法,步骤如下:

4、所述uae算法将水面无人艇航向控制指标集输入到编码网络中,提取最显著特征。将编码后的hi作为ddqn的状态空间,来描述无人艇在不同时刻的状态变化。

5、所述无人水面艇在当前状态st下执行动作at,获得奖励值rt并将自身状态转变为st+1,将样本信息存储至优先重播缓冲区。

6、所述ddqn网络从优先重播缓冲区中进行小批次采样,采集先前时刻的状态、动作值和奖励值进行计算。

7、所述ddqn基于预测网络输出的值函数,不断优化智能航向控制策略。

8、所述ddqn网络设置无人水面艇的动作空间为(z,λ),z表示无人艇的航行速度,λ为舵角值。

9、所述ddqn网络使用平均任务执行效率作为奖励函数rt,提高无人艇的航行效率。

10、所述ddqn预测网络使用两个全连接层流,即状态值函数v(s)和行动优势函数a(s,a)。通过将二者进行求和,来计算值函数q(s,a)。

11、所述ddqn网络通过对值函数进行分解计算,保障底层算法的完备性。

12、所述ddqn网络采用均方差来计算预测网络的损失函数l(θ)。

13、所述ddqn(dueling deep-q network)网络采用了双层网络的架构,降低训练时的样本相关性,防止网络发生过拟合。在每个时间步长,预测网络都会计算并更新自身的参数,定期使用值函数q更新目标网络的q’。

14、与现有技术相比,本发明具有以下有益效果:

15、a.本发明基于uae算法提取无人艇航行时的最重要数据特征,将智能航向控制指标集输入至隐藏层中,经过神经元的函数映射,对高维数据进行非线性解耦,转化为低维矩阵,从而有效描述无人艇的状态变化。

16、b.本发明基于ddqn算法,通过使用状态值函数和行动优势函数来计算值函数,将预测网络和目标网络相结合,经过大量的训练,使无人艇能够在复杂海况下进行智能航向控制,有效提高神经网络的收敛性和泛化性。

技术特征:

1.一种基于uae-ddqn的无人船航向控制方法,其特征在于,步骤如下:

2.根据权利要求1所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s1,具体操作如下:

3.根据权利要求1或2所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s21,具体操作如下:

4.根据权利要求1或2所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s22,具体操作如下:

5.根据权利要求3所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s22,具体操作如下:

6.根据权利要求1或2或5所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s23,具体操作如下:

7.根据权利要求3所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s23,具体操作如下:

8.根据权利要求4所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s23,具体操作如下:

9.根据权利要求1或2或5或7或8所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s24,具体操作如下:

10.根据权利要求3所述的一种基于uae-ddqn的无人船航向控制方法,其特征在于,所述的步骤s24,具体操作如下:

技术总结

本专利涉及一种基于UAE‑DDQN的无人船航向控制方法,包括:在复杂海况下实时采集无人水面艇的航行数据,使用欠完备自编码器UAE将指标集输入至隐藏层中,提取最显著特征,并将之作为深度强化学习DDQN(Dueling Deep‑Q Network)的状态空间。基于DDQN对无人艇进行智能航向控制,使用状态值函数和行动优势函数来计算值函数。将预测网络和目标网络相结合,加速模型的收敛性能。从优先重播缓冲区中进行小批次采样,采集先前时刻的状态、动作值和奖励值进行计算,防止网络发生过拟合。基于预测网络输出的值函数,不断优化智能航向控制策略。本发明具有提高了无人水面艇的航行效率和安全性等优点。

技术研发人员:林源,刘笑成,张卫东,胡智焕,董宏丽,吴迪,贾泽华,曹刚,郭东生,何星,李渠,张灿威,詹世杰

受保护的技术使用者:海南大学

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!