针对大规模预训练语言模型的提示学习方法和交互系统与流程

本公开涉及一种针对大规模预训练语言模型的提示学习方法和利用该方法的交互系统。

背景技术:

1、大规模预训练语言模型(plm),例如参数量达到1b甚至以上的模型,通过将一些标记的训练例作为基于文本的提示进行调整,以实现上下文学习(icl),从而无需更新参数并实现具有竞争力的性能。现有的研究已经探索了影响icl性能的诸多方面。然而所有这些局限在icl框架内的研究,对应模型性能的提升都有限。

2、为此需要一种改进的、能够进一步提升大规模预训练语言模型性能的方法。

技术实现思路

1、本公开要解决的一个技术问题是提供一种针对大规模预训练语言模型的提示学习方法和利用该方法的交互系统。该方法在业内首次提出了面向大规模预训练语言模型的知识预训练算法,为构建应用于各个领域的大规模知识模型奠定基础。具体地,该方法提出了可以单独或结合使用的新颖的基于事实知识注入的预训练任务,并且发现对目标示例的明智选择和利用知识库中知识先验的校准能够进一步提升模型表现。

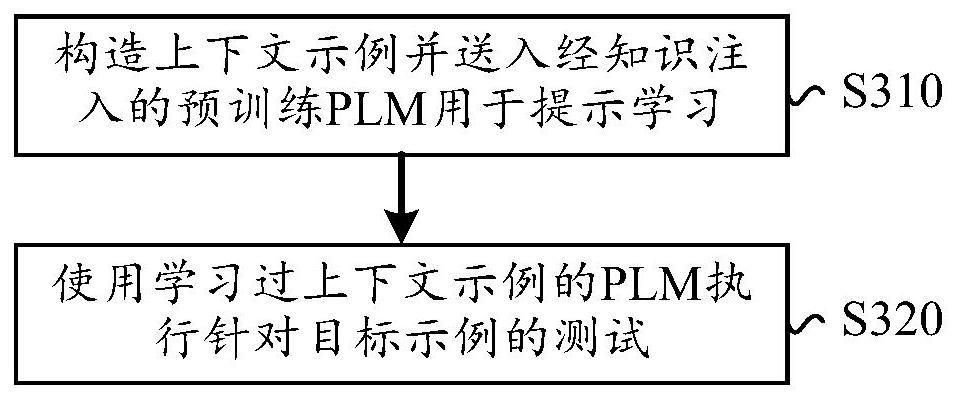

2、根据本公开的第一个方面,提供了一种大规模预训练语言模型plm操作方法,包括:构造上下文示例并送入经预训练的所述plm用于提示学习;以及使用学习过所述上下文示例的所述plm执行针对目标示例的测试,其中,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调,以获取预训练的所述plm。

3、可选地,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调还包括:将分类标签看作是特殊实体进行所述实体知识注入。

4、可选地,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:使用掩码实体预测任务对所述plm的参数进行微调,其中,所述掩码实体预测任务对输入文本中的实体进行掩码,并且基于所述plm输出的实体标记与被掩码实体对应的真实实体标记之间差异产生的损失对所述plm的参数进行微调。

5、可选地,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:使用实体描述生成任务对所述plm的参数进行微调,其中,所述实体描述生成任务用于:构造包括实体模板、输入文本中的所有实体和文本模板的前缀文本,并将原始文本作为后缀文本;对后缀文本中的实体进行掩码;基于所述所述plm针对给定实体输出的文本表述与原始文本之间差异产生的损失对所述plm的参数进行微调。

6、可选地,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:使用知识问答任务对所述plm的参数进行微调,其中,所述知识问答任务用于:对输入文本中的实体进行掩码;基于知识库构造包含被掩码实体的三元组;将所述三元组的信息转换为预测所述三元组中另一个实体的问题;基于所述plm输出的答案标记与所述另一个实体对应标记之间差异产生的损失对所述plm的参数进行微调。

7、可选地,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:从同一任务中随机选择多个示例来形成训练实例,直到达到最大序列长度;计算所述plm输出的掩码标记与被掩码实体对应标记之间的交叉熵损失;以及根据所述交叉熵损失对所述plm的参数进行微调。

8、可选地,构造上下文示例并送入经预训练的所述plm用于提示学习包括:确定训练集和目标集中所包含的实体;从所述训练集中检索优选训练例,所述优选训练例相比于其他训练例包含更多的目标集中实体;以及利用检索出的所述优选训练集构造所述上下文示例。

9、可选地,从训练集中检索优选训练例包括:计算所述训练集和所述目标集的语义空间差,所述语义空间差表征所述训练集和所述目标集各自实体平均表示之间的距离;利用所述语义空间差计算所述训练集中的训练例和所述目标集中的目标例之间的知识相关性;基于所述知识相关性确定所述训练集中每个训练例的采样权重;以及根据所述采样权重从所述训练集中选择所述优选训练例。

10、可选地,使用学习过所述上下文示例的所述plm执行针对目标示例的测试包括:计算候选标签词或实体在输出位置上的先验概率;以及基于所述先验概率,校准所述所述plm针对所述目标示例的测试的输出。

11、根据本公开的第二个方面,提供了一种交互系统,包括:服务器,用于根据特定领域实体知识执行如第一方面所述的操作方法,获取特定知识领域增强的大规模预训练语言模型;以及客户端,用于获取用户针对特定知识领域的查询信息,并将所述查询信息提交所述服务器,其中,所述服务器将所述查询信息送入所述特定知识领域增强的大规模预训练语言模型,并将模型生成的输出返回给客户端。

12、根据本公开的第三个方面,提供了一种计算设备,包括:处理器;以及存储器,其上存储有可执行代码,当可执行代码被处理器执行时,使处理器执行如上述第一方面所述的方法。

13、根据本公开的第四个方面,提供了一种计算机程序产品,包括可执行代码,当所述可执行代码被电子设备的处理器执行时,使所述处理器执行如上述第一方面所述的方法。

14、根据本公开的第五个方面,提供了一种非暂时性机器可读存储介质,其上存储有可执行代码,当可执行代码被电子设备的处理器执行时,使处理器执行如上述第一方面所述的方法。

15、由此,本申请通过引入了一种新颖的知识性上下文调整框架(kict)框架,用于在如下方面进一步提高icl的性能:1)在持续的自我监督预训练过程中向plm注入知识,2)明智地选择具有高知识相关性的例子,3)根据先验知识校准预测结果。实验结果表明,kict大大优于强基线,在文本分类和问答任务上分别提高了13%和7%以上。

技术特征:

1.一种针对大规模预训练语言模型plm的提示学习方法,包括:

2.如权利要求1所述的方法,其中,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调还包括:

3.如权利要求1所述的方法,其中,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:

4.如权利要求1所述的方法,其中,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:

5.如权利要求1所述的方法,其中,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:

6.如权利要求3-5中任一项所述的方法,其中,使用将实体知识注入所述plm的预训练任务对所述plm的参数进行微调包括:

7.如权利要求1所述的方法,其中,构造上下文示例并送入经预训练的所述plm用于提示学习包括:

8.如权利要求7所述的方法,其中,从训练集中检索优选训练例包括:

9.如权利要求1所述的方法,其中,使用学习过所述上下文示例的所述plm执行针对目标示例的测试包括:

10.一种交互系统,包括:

11.一种计算设备,包括:

12.一种计算机程序产品,包括可执行代码,当所述可执行代码被电子设备的处理器执行时,使所述处理器执行如权利要求1至9中任何一项所述的方法。

13.一种非暂时性机器可读存储介质,其上存储有可执行代码,当所述可执行代码被电子设备的处理器执行时,使所述处理器执行如权利要求1至9中任何一项所述的方法。

技术总结

本公开涉及一种针对规模预训练语言模型的提示学习方法和利用该操作方法的交互系统。所述方法包括:构造上下文示例并送入经预训练的所述PLM用于提示学习;以及使用学习过所述上下文示例的所述PLM执行针对目标示例的测试,其中,使用将实体知识注入所述PLM的预训练任务对所述PLM的参数进行微调,以获取预训练的所述PLM。本公开在业内首次提出了面向大规模预训练语言模型的知识预训练算法,为构建应用于各个领域的大规模知识模型奠定基础。具体地,该方法提出了可以单独或结合使用的新颖的基于事实知识注入的预训练任务,并且发现对目标示例的明智选择和利用知识库中知识先验的校准能够进一步提升模型表现。

技术研发人员:汪诚愚,黄俊

受保护的技术使用者:阿里巴巴(中国)有限公司

技术研发日:

技术公布日:2024/1/14

- 还没有人留言评论。精彩留言会获得点赞!