基于人脸关键点优化区域特征的视频面部表情识别方法、系统、装置、处理器及存储介质

本发明涉及数字图像,尤其涉及计算机视觉,具体是指一种基于人脸关键点优化区域特征的视频面部表情识别方法、系统、装置、处理器及其计算机可读存储介质。

背景技术:

1、人脸表情识别(fer,facial expression recognition)是计算机理解人类情感的一个重要方向,也是人机交互的一个重要方面。人脸表情识别对于理解和改善人机交互、安全、机器人制造、自动化、医疗、通信和驾驶等领域有着广泛的应用价值和社会意义。随着计算机技术和深度学习技术的发展,以及大规模自然环境下自发式的表情数据集的开源,近年来,人脸表情识别取得了显著的进步,并成为学术界和工业界的研究热点。

2、随着深度卷积网络的不断发展,研究人员可以从大规模表情数据中挖掘出可用的信息,各种基于cnn的方法被应用于人脸表情。然而受制于表情的复合性、真实场景数据集的类别不平衡等问题,人脸表情识别仍然是一个艰巨的任务。比如:申请号为:cn202311049424.2的发明专利申请,其公开了在backbone的基础上添加了自注意力模块,增强了网络关注特定区域的特征提取能力,其设计重点在于真实场景下的静态图像数据集中出现遮挡人脸时的表情识别能力上;申请号为:cn202310942697.3的发明专利申请,使用了跨层多尺度通道相互注意学习的机制,重点考虑了卷积核设计、注意力设计,在真实场景下的静态图像数据集中表现出优势;申请号为:cn202310805217.9的发明专利申请,其设计了基于增强自注意力transformer的人脸表情识别方法,使用较轻量级的网络ir50作为backbone,再用增强的子注意力模块对特征做增强操作,最后用于最终的分类,其重点在于网络的轻量化。上述公开的申请均存在的缺陷是:未关注如何利用时序信息和人脸关键点的先验知识,都是直接利用从图像中提取的特征图进行优化的注意力操作识别分类,但没有考虑到时序信息、人脸关键点信息与真实场景下视频表情识别的相关性,而这也应当是当前亟需解决的缺陷问题。

技术实现思路

1、本发明的目的是克服了上述现有技术的缺点,提供了一种能够有效利用视频前后帧关联信息和人脸关键点信息的基于人脸关键点优化区域特征的视频面部表情识别方法、系统、装置、处理器及其计算机可读存储介质。

2、为了实现上述目的,本发明的基于人脸关键点优化区域特征的视频面部表情识别方法、系统、装置、处理器及其计算机可读存储介质如下:

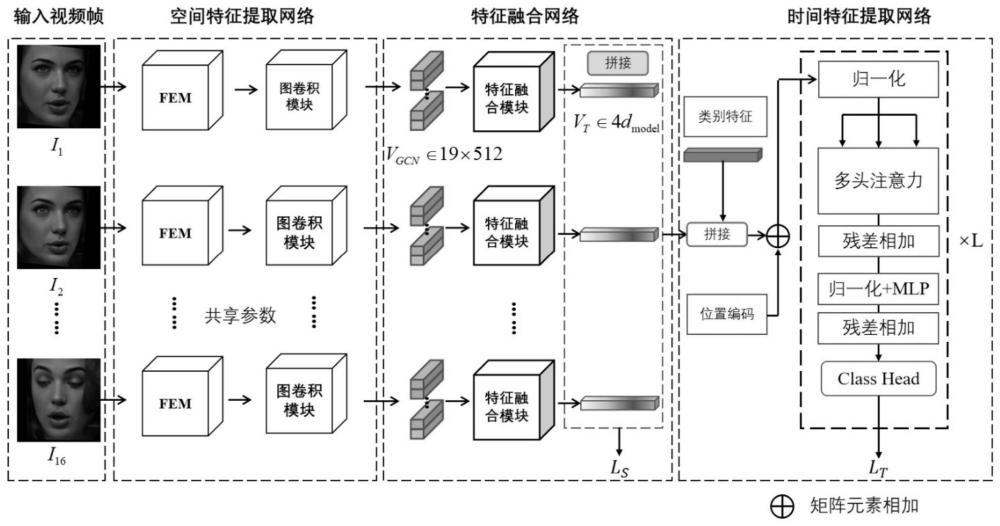

3、该基于人脸关键点优化区域特征的视频面部表情识别方法,其主要特点是,所述的方法包括以下步骤:

4、(1)采集视频人脸表情数据集,并对视频进行预处理操作;

5、(2)构建cnn结构的空间特征提取模块和基于人脸关键点的特征提取模块,分别对采集的数据进行初级空域特征和人脸关键点局部区域特征的提取;

6、(3)构建由人脸关键点引导的图卷积模块对提取到的相关信息进行信息强化;

7、(4)构建特征融合模块对一帧内的图像进行特征增强;

8、(5)使用时序模块和分类模块对提取到的相关信息解码处理并作出决策,并构建总体损失函数。

9、较佳地,所述的步骤(1)具体包括以下步骤:

10、(1.1)从数据集官网上下载dfew、afew数据集,经过视频分帧和人脸提取器得到裁剪后的人脸图像,得到尺寸为256×256pt的原始视频帧;

11、(1.2)对所述的原始视频帧序列使用数据增强方式,构建得到最终112×112pt的训练以及测试图像。

12、较佳地,所述的数据增强方式包括:

13、随机采样,对一组视频连续采样2帧,顺序向后采样8次得到当此训练或测试的图像组,将经过预处理处理后的图像组进行随机旋转[-45°,45°],随后针对图像组进行随机水平翻转,随机色彩抖动,随机水平翻转,随机高斯模糊和随机灰度化,最后通过尺寸缩放操作得到最终训练以及测试的图像。

14、尤佳地,所述的步骤(2)具体包括以下步骤:

15、(2.1)构建所述的空间特征提取模块,具体为:

16、使用cnn模型作为人脸表情识别视频数据帧的特征提取网络,将作为样本的112×112×3×16维度输入提取转换成一组2d特征图其中h和w分别代表特征图的长和宽,d代表特征图的维度,t代表样本内的帧数;构建三元组注意力模块,将2d特征图转换为2d特征图所述的特征图f与特征图t的维度保持一致;

17、(2.2)构建所述的人脸关键点特征提取模块,具体为:

18、构建了人脸关键点特征提取网络作为人脸关键点特征提取模块,将作为样本的112×112×3×16维度输入提取转换成一组人脸关键点特征图其中n代表人脸关键点个数,h和w分别代表特征图的长和宽;从特征图a’采样固定的18个人脸关键点,将特征图a’转换为2d特征热图且所述的特征热图与(2.1)节的特征图t的长和宽保持一致;

19、(2.3)基于构建的所述的空间特征提取模块和人脸关键点特征提取模块,对采集到的人脸表情识别数据集进行初级空域特征和人脸关键点局部区域特征的提取。

20、尤佳地,所述的步骤(3)包括以下步骤:

21、(3.1)构建所述的人脸关键点引导的图卷积模块输入特征,具体为:

22、使用(2.1)节构建的空间特征提取模块获取的2d特征图和(2.2)节前18个人脸关键点特征提取模块构建的2d特征热图使用池化计算和向量元素乘法,并在执行完每个操作之后,均使用层归一化来进一步调整输出,得到用于人脸关键点引导的图卷积模块的输入信息和如以下公式:

23、

24、

25、其中,g为全局池化操作,⊙为向量元素相乘操作,()为向量拼接操作,ti为第i帧图像的2d空域特征图,vi,g为第i帧图像的全局人脸关键点特征,为第i帧图像第j个关键点的特征热图;

26、(3.2)构建所述的人脸关键点引导的图卷积模块,具体为:

27、使用采样并特征增强的特征热图a,(3.1)节构建得到的输入特征和新建的可学习特征矩阵使用矩阵乘法、激活函数、矩阵元素乘法操作转换得到如以下公式:

28、

29、

30、其中,为矩阵相乘操作,⊙为向量元素相乘操作,t为矩阵转置操作,f为全链接操作,a为特征热图,wl为可学习特征矩阵,wa是由可学习矩阵,wl经过矩阵乘法和激活计算得到的矩阵,是(3.1)节中得到的vi中前18个人脸关键点特征构成的特征向量,vig为vi中最后一个全局特征向量。

31、更佳地,所述的步骤4具体包括如下步骤:

32、(4.1)根据采样得到的人脸关键点将人脸划分为三个区域,依据划分的不同区域对(3.2)构建的人脸关键点引导的图卷积模块输出信息做特征融合操作,构建融合人脸关键点信息的空间特征信息vspatial,并以一组交叉熵损失函数约束该融合操作,如以下公式:

33、

34、ls=lclass(fc(vspatial))

35、其中,fc为全链接操作,lclass(·)为多类别交叉熵损失函数,ls代表空间分量贡献的分类损失。

36、更佳地,所述的步骤5具体包括如下步骤:

37、(5.1)构建时序模块的输入,具体为:

38、构建类别特征、位置编码和(3.2)的人脸关键点引导的融合特征vspatial,三者组成的时序模块输入特征其中n为拼接特征的个数,d为特征的维度,公式如下:

39、z0=[xclass;vspatial]+epos=[xclass;v1;v2;…;vn]+epos

40、其中,xclass为类别特征,epos为位置编码,;符号为拼接操作,vspatial为融合人脸关键点信息的空间特征信息;

41、(5.2)输入特征首先经过一个线性映射层,产生一个query矩阵一个key矩阵以及一个value矩阵接着再将三个矩阵传入所述的多头自注意力机制mhsa中,计算得到权重矩阵w,如以下公式所示:

42、

43、其中,t为矩阵转置操作,d为归一化常数;

44、(5.3)权重矩阵w与value矩阵相乘,并经过一个残差操作和多层mlp处理,得到可用于分类的输出公式如下:

45、si=wvi;i∈[1,n]

46、zl=wh[s1;s2;…;sn]t+zl-1

47、其中,t为矩阵转置操作,wh为可学习的权重矩阵;

48、(5.4)堆叠多层(5.2)和(5.3)节所述的注意力机制和残差操作,在最后一层处对于输出使用一个分类器模块,将特征通过全链接网络映射到类别数c,得到该向量表示c个类别可能的概率,对做一次softmax操作得到用于参与计算有标签监督的分类损失函数,公式如下:

49、lt=lclass(r)

50、其中,lclass(·)为多类别交叉熵损失函数,lt代表时间分量贡献的分类损失。

51、更佳地,所述的步骤5中的构建总体损失函数,具体包括如下步骤:

52、用重要性权重λ平衡来自空间分量贡献的分类损失ls和来自空间分量贡献的分类损失lt,公式如下:

53、ltotal=λ×ls+(1-λ)×lt。

54、该实现上述的方法的基于人脸关键点优化区域特征的视频面部表情识别的系统,其主要特点是,所述的系统包括:

55、空间特征提取模块和基于人脸关键点的特征提取模块,用于对采集到的视频人脸表情识别数据集中的相关数据信息进行空间特征数据提取以及人脸关键点特征数据提取;

56、人脸关键点引导的图卷积模块,与所述的空间特征提取模块、基于人脸关键点的特征提取模块相连接,用于通过图卷积形式借助人脸关键点强化该帧内的人脸表情信息;

57、特征融合模块,与所述的人脸关键点引导的图卷积模块相连接,用于压缩高维特征并根据人脸区域划分决定情感信息的关键特征向量;

58、时序模块和分类模块,与所述的特征融合模块相连接,使用多头自注意力机制mhsa,以及一个多层mlp,构建一个时序特征提取网络,并利用所述的分类网络和交叉熵损失函数对分类结果进行有标签监督,以获取最终的视频人脸表情识别结果。

59、该用于实现基于人脸关键点优化区域特征的视频面部表情识别的装置,其主要特点是,所述的装置包括:

60、处理器,被配置成执行计算机可执行指令;

61、存储器,存储一个或多个计算机可执行指令,所述计算机可执行指令被所述处理器执行时,实现上述所述的基于人脸关键点优化区域特征的视频面部表情识别的方法的各个步骤。

62、该用于实现基于人脸关键点优化区域特征的视频面部表情识别的处理器,其主要特点是,所述的处理器被配置成执行计算机可执行指令,所述的计算机可执行指令被所述的处理器执行时,实现上述所述的基于人脸关键点优化区域特征的视频面部表情识别的方法的各个步骤。

63、该计算机可读存储介质,其主要特点是,其上存储有计算机程序,所述的计算机程序可被处理器执行以实现上述所述的基于人脸关键点优化区域特征的视频面部表情识别方法的各个步骤。

64、采用了本发明的该基于人脸关键点优化区域特征的视频面部表情识别的方法、系统、装置、处理器及其计算机可读存储介质,使用经典的cnn模型(例如resnet18)和人脸关键定位模型(例如dlib算法库)作为空间特征提取模块和基于人脸关键点的特征提取模块。为了加强人脸关键点信息的潜在引导能力,本发明还创新性地引入了人脸关键点引导的图卷积模块和特征融合模块,借助人脸关键点强化该帧内的人脸表情信息。时序模块和分类模块则由多头自注意力机制mhsa、多层mlp、多分类全链接网络组成,通过堆叠多层时序网络提取视频中潜在的时间特征。分类器用重要性权重平衡来自空间分量贡献的分类损失和来自空间分量贡献的分类损失,以达到更好的效果。本技术方案在afew、dfew数据集上进行实验验证,相较于基线模型,具有更为突出的分类识别效果。

- 还没有人留言评论。精彩留言会获得点赞!