血管介入导丝的自动导航方法、装置、设备及介质与流程

1.本发明涉及手术导航技术领域,尤其涉及一种血管介入导丝的自动导航方法、装置、设备及介质。

背景技术:

2.介入手术是利用现代高技术手段进行的微创治疗手段,具有创口小以及恢复快的优点。仪器的发展使得介入手术可以在影像设备下进行操作,能够完全取代部分传统开放手术。目前手术方案的确定往往是在进行造影的时候,医生清楚地看到血管(冠脉血管、肾动脉)或神经的具体情况后,进行病情分析,进行导丝的行走路径规划。目前的介入手术方式是由医生手动通过导丝或将球囊和支架送入到病变位置。然而,通过医生手动递送导丝不仅费时费力,同时医生在手术室长时间暴露在辐射的环境中。

技术实现要素:

3.本发明的主要目的在于提供一种血管介入导丝的自动导航方法、装置、设备及介质,旨在解决现有技术通过医生手动递送导丝费时费力以及增加医生暴露在辐射环境中的时间的技术问题。

4.为实现上述目的,本发明提供了一种血管介入导丝的自动导航方法,所述方法包括以下步骤:

5.s1、基于第一造影视频,获取当前帧图像的状态信息,其中,所述状态信息包括导丝的当前起点位置和目标位置;

6.s2、构建深度强化学习网络并进行训练,得到训练好的深度强化学习网络;

7.s3、将所述当前帧图像的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的决策动作;

8.s4、在所述机器手臂执行完所述决策动作之后,重新获取当前帧图像的状态信息,并根据新的状态信息重复执行步骤s3-s4,直至所述导丝到达所述目标位置为止。

9.可选地,所述构建深度强化学习网络并进行训练,得到训练好的深度强化学习网络,包括:

10.s21、构建深度强化学习网络,并设计机器手臂操作导丝的决策动作和奖励机制;

11.s22、基于第二造影视频,获取第一帧图像的状态信息s,并将所述第一帧图像的状态信息s输入到所述深度强化学习网络中,得到机器手臂的决策动作a;

12.s23、在所述机器手臂执行完所述决策动作a之后,获取第二帧图像的状态信息s’,并基于所述奖励机制得到从状态信息s到状态信息s’的回报值r;

13.s24、将(s,a,r,s’)作为一组样本存放入经验池集t中,并在令s=s'之后,重复执行步骤s21-s24,直至导丝到达目标位置为止;

14.s25、从所述经验池集t中随机抽取b组样本,利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络。

15.可选地,基于所述奖励机制得到从状态信息s到状态信息s’的回报值r,包括:

16.根据状态信息s和状态信息s’,确定从所述状态信息s到所述状态信息s’的距离;

17.基于所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r。

18.可选地,所述基于所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r,包括:

19.判断所述第二帧图像中导丝的当前起点位置是否在血管外面,得到判断结果;

20.基于所述判断结果和所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r。

21.可选地,所述从所述经验池集t中随机抽取b组样本,利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络,包括:

22.所述经验池集t中随机抽取b组样本,并分别输入到所述深度强化学习网络中的目标网络和预测网络中,得到所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ);

23.根据所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ)来构建损失函数loss;

24.基于所述损失函数loss利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络。

25.可选地,所述根据所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ)来构建损失函数loss,包括:

26.根据所述目标网络的输出价值q(s',a',θ')和回报值r来确定目标值;

27.根据所述预测网络的输出价值q(s,a,θ)来确定预测值;

28.基于所述目标值和所述预测值来构建损失函数loss。

29.可选地,所述根据所述目标网络的输出价值q(s',a',θ')和回报值来确定目标值,包括:

30.从所述目标网络的所有输出价值q(s',a',θ')中确定最大的输出价值maxq(s',a',θ');

31.根据所述最大的输出价值maxq(s',a',θ')和回报值r来确定目标值。

32.此外,为实现上述目的,本发明还提出一种血管介入导丝的自动导航装置,所述血管介入导丝的自动导航装置包括:

33.获取模块,用于基于第一造影视频,获取当前帧图像的状态信息,其中,所述状态信息包括导丝的当前起点位置和目标位置;

34.构建模块,用于构建深度强化学习网络并进行训练,得到训练好的深度强化学习网络;

35.所述获取模块,还用于将所述当前帧图像的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的决策动作;

36.所述获取模块,用于在所述机器手臂执行完所述决策动作之后,重新获取当前帧图像的状态信息。

37.此外,为实现上述目的,本发明还提出一种血管介入导丝的自动导航设备,所述血

管介入导丝的自动导航设备包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的血管介入导丝的自动导航程序,所述血管介入导丝的自动导航程序配置为实现如上文所述的血管介入导丝的自动导航方法的步骤。

38.此外,为实现上述目的,本发明还提出一种存储介质,所述存储介质上存储有血管介入导丝的自动导航程序,所述血管介入导丝的自动导航程序被处理器执行时实现如上文所述的血管介入导丝的自动导航方法的步骤。

39.本发明通过获取在pci手术过程的实时造影视频,来采集实时造影视频中的当前帧图像,并获取当前帧图像中的状态信息,再将当前帧图像的状态信息输入到训练好的深度强化学习网络中,即可得到机器手臂的决策动作,机器手臂执行完决策动作后,重新采集实时造影视频中的当前帧图像,并获取重新采集的当前帧图像的新的状态信息,再将新的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的新的决策动作,不断地重复,直到导丝到达目标位置为止。通过上述方式,通过机器手臂来代替医生手动递送导丝的过程,能够有效减少医生暴露在辐射环境中的时间。

附图说明

40.图1是本发明实施例方案涉及的硬件运行环境的血管介入导丝的自动导航设备的结构示意图;

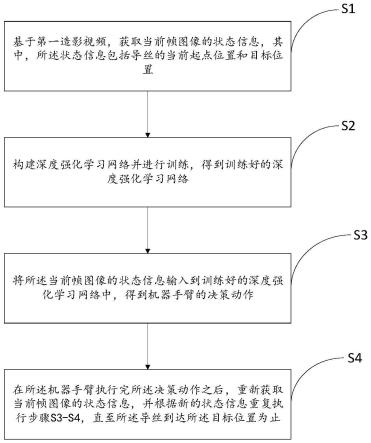

41.图2为本发明血管介入导丝的自动导航方法第一实施例的流程示意图;

42.图3为本发明血管介入导丝的自动导航方法一实施例中深度卷积神经网络的训练过程;

43.图4为本发明血管介入导丝的自动导航方法一实施例中另一深度卷积神经网络的训练过程;

44.图5为本发明血管介入导丝的自动导航方法第二实施例的流程示意图;

45.图6为本发明血管介入导丝的自动导航方法一实施例中又一深度卷积卷积神经网络对造影图像的二值分割过程;

46.图7为本发明血管介入导丝的自动导航方法一实施例中采用dqn算法来对深度强化学习网络进行训练的过程;

47.图8为本发明血管介入导丝的自动导航装置第一实施例的结构框图。

48.本发明目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

49.应当理解,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。

50.参照图1,图1为本发明实施例方案涉及的硬件运行环境的血管介入导丝的自动导航设备结构示意图。

51.如图1所示,该血管介入导丝的自动导航设备可以包括:处理器1001,例如中央处理器(central processing unit,cpu),通信总线1002、用户接口1003,网络接口1004,存储器1005。其中,通信总线1002用于实现这些组件之间的连接通信。用户接口1003可以包括显示屏(display)、输入单元比如键盘(keyboard),可选用户接口1003还可以包括标准的有线接口、无线接口。网络接口1004可选的可以包括标准的有线接口、无线接口(如无线保真

(wireless-fidelity,wi-fi)接口)。存储器1005可以是高速的随机存取存储器(random access memory,ram)存储器,也可以是稳定的非易失性存储器(non-volatile memory,nvm),例如磁盘存储器。存储器1005可选的还可以是独立于前述处理器1001的存储装置。

52.本领域技术人员可以理解,图1中示出的结构并不构成对血管介入导丝的自动导航设备的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。

53.如图1所示,作为一种存储介质的存储器1005中可以包括操作系统、网络通信模块、用户接口模块以及血管介入导丝的自动导航程序。

54.在图1所示的血管介入导丝的自动导航设备中,网络接口1004主要用于与网络服务器进行数据通信;用户接口1003主要用于与用户进行数据交互;本发明血管介入导丝的自动导航设备中的处理器1001、存储器1005可以设置在血管介入导丝的自动导航设备中,所述血管介入导丝的自动导航设备通过处理器1001调用存储器1005中存储的血管介入导丝的自动导航程序,并执行本发明实施例提供的血管介入导丝的自动导航方法。

55.本发明实施例提供了一种血管介入导丝的自动导航方法,参照图2,图2为本发明一种血管介入导丝的自动导航方法第一实施例的流程示意图。

56.本实施例中,所述血管介入导丝的自动导航方法包括以下步骤:

57.步骤s1:基于第一造影视频,获取当前帧图像的状态信息,其中,所述状态信息包括导丝的当前起点位置和目标位置。

58.具体地,第一造影视频为血管的实时造影视频,可以通过向血管中注射造影剂,使得血管显影,再通过x射线拍摄取得清晰的影像,从实时造影视频中获取当前帧图像的状态信息,当前帧图像指的是当前时刻下第一造影视频中的帧图像,可以将当前帧图像输入到训练好的导丝端点检测深度卷积神经网络中,来获取帧图像中导丝的远端端点位置即当前起点位置,当前起点位置即为当前帧图像中导丝的远端端点位置。其中,训练好的导丝端点检测深度卷积神经网络的训练过程如图3所示,主要通过将多个预测结果与对应的人工标注进行比较,得到多个预测误差,再根据多个预测误差来更新导丝端点检测深度卷积神经网络,得到训练好的导丝端点检测深度卷积神经网络。目标位置可以理解为在进行介入手术时,需要通过导丝将球囊和支架送达的位置,进而实现对病变位置的血运重建,因此,导丝到达目标位置是非常重要的一步。可以由医生预先在实时造影视频某一帧图像上标注好目标位置,由于实时造影视频会随着心脏运动,所以目标位置在实时造影视频的每一帧图像中也是会变化的,由于目标位置的随机性,可以借助实时造影视频前后帧图像的连续性来对第一造影视频中的目标位置进行追踪,比如,引入目标追踪网络模型,将标注有目标位置的t帧图像输入至目标追踪网络模型中,能得到t+1帧图像中的目标位置,目标追踪网络模型可以是训练好的深度卷积神经网络。其中,目标追踪网络模型的训练过程如图4所示。

59.步骤s2:构建深度强化学习网络并进行训练,得到训练好的深度强化学习网络。

60.具体地,可以采用dqn算法来对深度强化学习网络进行训练。

61.s3:将所述当前帧图像的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的决策动作。

62.具体地,机器手臂的决策动作有前进、后退、旋转和静止四种,当机器手臂操作导丝的决策动作为前进时,机器手臂会推动导丝前进,当机器手臂操作导丝的决策动作为后

退时,机器手臂会往回拉导丝,当机器手臂操作导丝的决策动作为旋转时,机器手臂会通过旋转来改变导丝的远端端点的运动方向,当机器手臂操作导丝的决策动作为静止时,机器手臂会让导丝静止下来。

63.s4:在所述机器手臂执行完所述决策动作之后,重新获取当前帧图像的状态信息,并根据新的状态信息重复执行步骤s3-s4,直至所述导丝到达所述目标位置为止。

64.具体地,在机器手臂执行决策动作的前一刻的当前帧图像与机器手臂在执行完决策动作的后一刻的当前帧图像不是同一帧图像,机器手臂在执行决策动作时,导丝的远端端点会随着机器手臂的运动而运动,可以将重新获取的当前帧图像输入到到训练好的导丝端点检测深度卷积神经网络中,来重新获取当前帧图像中导丝的远端端点位置即当前起点位置,再将重新获取的当前帧图像输入到目标追踪网络模型中,来重新获取当前帧图像中的目标位置。当前帧图像的状态信息包括当前帧图像中导丝的远端端点位置和目标位置。再将新的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的决策动作,根据新的状态信息来重复执行步骤s3-s4,直至导丝到达目标位置为止即导丝到达目标位置之后就会停止重复执行步骤s3-s4,当机器手臂在执行完每一次的决策动作的后一刻的当前帧图像中导丝的当前起点位置与导丝的目标位置小于预设距离时,可以认为导丝到达目标位置。预设距离是提前设置好的。

65.本发明通过获取在介入手术过程的实时造影视频,来采集实时造影视频中的当前帧图像,并获取当前帧图像中的状态信息,再将当前帧图像的状态信息输入到训练好的深度强化学习网络中,即可得到机器手臂的决策动作,机器手臂执行完决策动作后,重新采集实时造影视频中的当前帧图像,并获取重新采集的当前帧图像的新的状态信息,再将新的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的新的决策动作,不断地重复,直到导丝到达目标位置为止。通过上述方式,通过机器手臂来代替医生手动递送导丝的过程,能够有效减少医生暴露在辐射环境中的时间。

66.参考图5,图5为本发明一种血管介入导丝的自动导航方法第二实施例的流程示意图。

67.基于上述第一实施例,本实施例血管介入导丝的自动导航方法,构建深度强化学习网络并进行训练,得到训练好的深度强化学习网络,包括:

68.步骤s21:构建深度强化学习网络,并设计机器手臂操作导丝的决策动作和奖励机制。

69.具体地,将机器手臂操作导丝的决策动作设计为前进、后退、旋转和静止四种,当机器手臂操作导丝的决策动作为前进时,机器手臂会推动导丝前进,当机器手臂操作导丝的决策动作为后退时,机器手臂会往回拉导丝,当机器手臂操作导丝的决策动作为旋转时,机器手臂会通过旋转来改变导丝的远端端点的运动方向,当机器手臂操作导丝的决策动作为静止时,机器手臂会让导丝静止下来。

70.步骤s22:基于第二造影视频,获取第一帧图像的状态信息s,并将所述第一帧图像的状态信息s输入到所述深度强化学习网络中,得到机器手臂的决策动作a。

71.具体地,第二造影视频为实时造影视频,第一帧图像指的是当前时刻下第二造影视频中的帧图像,第一帧图像的状态信息s包括导丝的远端端点的位置即导丝的当前起点位置和目标位置,将第一帧图像的状态信息s输入到所述深度强化学习网络中,得到机器手

臂的决策动作a。其中,可以将第一帧图像输入到训练好的深度卷积神经网络中,来获取第一帧图像中导丝的远端端点位置即当前起点位置,还可以将第一帧图像输入到目标追踪网络模型,来追踪目标位置在第二造影视频中不同帧图像中的位置。先通过第二造影视频来采集第一帧图像,再通过训练好的深度卷积神经网络和目标追踪网络模型来分别确定第一帧图像中导丝的当前起点位置和目标位置。

72.步骤s23:在所述机器手臂执行完所述决策动作a之后,获取第二帧图像的状态信息s’,并基于所述奖励机制得到从状态信息s到状态信息s’的回报值r。

73.需要说明的是,第一帧图像为机器手臂执行决策动作a的前一刻帧图像,第二帧图像为机器手臂执行完决策动作a的后一刻图像。帧图像中导丝的当前起点位置即为帧图像中导丝的远端端点位置。

74.具体地,通过第二造影视频来采集第二帧图像,再通过训练好的深度卷积神经网络和目标追踪网络模型来分别确定第二帧图像中导丝的当前起点位置和目标位置,第二帧图像的状态信息s’包括第二帧图像中导丝的当前起点位置和目标位置。

75.在一实施例中,基于所述奖励机制得到从状态信息s到状态信息s’的回报值r,包括:

76.根据状态信息s和状态信息s’,确定从所述状态信息s到所述状态信息s’的距离。

77.具体地,状态信息s包括在第一帧图像中的导丝的远端端点的位置和目标位置,状态信息s’包括在第二帧图像中导丝的远端端点的位置和目标位置,由于实时造影视频即第二造影视频会随着心脏运动,所以目标位置在第二造影视频的每一帧图像中也是会变化的,因此,目标位置在第一帧图像和第二帧图像中的位置是不一样的。根据第一帧图像中目标位置到第二帧图像中目标位置的映射关系,可以确定第一帧图像中导丝的远端端点映射到第二帧图像中的位置为(x0,y0),又因为导丝从第一帧图像到第二帧图像的过程是在不断运动的,所以将第一帧图像中导丝的远端端点映射到第二帧图像中的位置与第二帧图像中导丝的远端端点的位置是不同的,第二帧图像中导丝的远端端点位置用(x1,y1)表示。可以理解的是,从状态信息s到状态信息s’的距离即为从状态信息s中导丝的远端端点位置运动到状态信息s’中导丝的远端端点的距离。根据位置(x0,y0)和位置(x1,y1)可以确定从所述状态信息s到所述状态信息s’的距离,具体为:优选地,m可为200,n可为20。

78.基于所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r。

79.在一实施例中,所述基于所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r,包括:

80.判断所述第二帧图像中导丝的当前起点位置是否在血管外面,得到判断结果。

81.具体地,如图6所示,可以采用深度卷积卷积神经网络对第二帧图像进行二值分割,得到血管管腔为前景,血管管腔以外为背景的二值分割图像即造影血管分割结果,还可以基于图像处理算法来对第二帧图像进行二值分割,得到血管管腔为前景,血管管腔以外为背景的二值分割图像。由于第二帧图像中导丝的当前起点位置即导丝的远端端点位置是已知的,因此可以通过第二帧图像的二值分割图像来确定导丝的当前起点位置是否在血管外,可以用v来表示判断结果,具体为:

[0082][0083]

基于所述判断结果和所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r。

[0084]

具体地,奖励机制可以设置为r=w1*vd+w2*v,其中,vd表示从所述状态信息s到所述状态信息s’的距离,v表示判断导丝的当前起点位置是否在血管外面的判断结果,w1和w2均为常数,由于导丝的当前起点位置不能在血管外面以及碰到血管管腔,因此需要给w2一个更大的权限,可以将w1设置为0.3,将w2设置为0.7。

[0085]

s24、将(s,a,r,s’)作为一组样本存放入经验池集t中,并在令s=s'之后,重复执行步骤s21-s24,直至导丝到达目标位置为止。

[0086]

具体地,可以采用dqn算法来对深度强化学习网络进行训练,具体训练步骤如图7所示。

[0087]

具体地,通过重复执行步骤s21-s24来增加经验池集t中的样本数量,还可以采用新的实时造影视频来重复执行步骤s21-s24来增加经验池t中的样本数量。

[0088]

s25、从所述经验池集t中随机抽取b组样本,利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络。

[0089]

具体地,每次可以从经验池集t中随机抽取b组样本来对深度强化学习网络进行训练,来更新深度强化学习网络的网络参数,经过成千上万次从经验池集t中随机抽取b组样本来对更新了网络参数的深度强化学习网络进行训练,最终得到训练好的深度强化学习网络。

[0090]

在一实施例中,所述从所述经验池集t中随机抽取b组样本,利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络,包括:

[0091]

从所述经验池集t中随机抽取b组样本,并分别输入到所述深度强化学习网络中的目标网络和预测网络中,得到所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ)。

[0092]

具体地,基于dqn算法的深度强化学习网络中的q值网络由两个网络组成,分别是目标网络和预测网络,q(s,a,θ)指的是将样本(s,a,r,s’)中的状态信息s输入至预测网络中,预测网络输出的所有q值中与动作a所对应的q值。q(s',a',θ')指的是将样本(s,a,r,s’)中的状态信息s’输入至目标网络中,目标网络输出的所有q值。

[0093]

根据所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ)来构建损失函数loss。

[0094]

在一实施例中,所述根据所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ)来构建损失函数loss,包括:

[0095]

根据所述目标网络的输出价值q(s',a',θ')和回报值r来确定目标值。

[0096]

在一实施例中,所述根据所述目标网络的输出价值q(s',a',θ')和回报值来确定目标值,包括:

[0097]

从所述目标网络的所有输出价值q(s',a',θ')中确定最大的输出价值maxq(s',a',θ')。

[0098]

具体地,maxq(s',a',θ')指的是将样本(s,a,r,s’)中的状态信息s’输入到目标网络中,目标网络输出的所有q值中的最大q值,a’为最大q值所对应的动作。

[0099]

根据所述最大的输出价值q(s,a,θ)和回报值r来确定目标值。

[0100]

具体地,目标值的计算公式为:y

目标

=r+γmaxq(s',a',θ'),其中,γ是设定的折扣因子。

[0101]

根据所述预测网络的输出价值q(s,a,θ)来确定预测值。

[0102]

具体地,预测值的计算公式为:y

预测

=q(s,a,θ)。

[0103]

基于所述目标值和所述预测值来构建损失函数loss。

[0104]

具体地,损失函数loss的计算公式为:

[0105][0106]

基于所述损失函数loss利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络。

[0107]

具体地,更新网络参数的计算公式为:

[0108][0109]

式中,θ表示网络参数,b表示随机抽取的样本数量。

[0110]

此外,本发明实施例还提出一种存储介质,所述存储介质上存储有血管介入导丝的自动导航程序,所述血管介入导丝的自动导航程序被处理器执行时实现如上文所述的血管介入导丝的自动导航方法的步骤。

[0111]

参照图8,图8为本发明血管介入导丝的自动导航装置第一实施例的结构框图。

[0112]

如图8所示,本发明实施例提出的血管介入导丝的自动导航装置包括:

[0113]

获取模块10,用于基于第一造影视频,获取当前帧图像的状态信息,其中,所述状态信息包括导丝的当前起点位置和目标位置。

[0114]

构建模块20,用于构建深度强化学习网络并进行训练,得到训练好的深度强化学习网络。

[0115]

所述获取模块10,还用于将所述当前帧图像的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的决策动作。

[0116]

所述获取模块10,用于在所述机器手臂执行完所述决策动作之后,重新获取当前帧图像的状态信息。

[0117]

本发明通过获取在pci手术过程的实时造影视频,来采集实时造影视频中的当前帧图像,并获取当前帧图像中的状态信息,再将当前帧图像的状态信息输入到训练好的深度强化学习网络中,即可得到机器手臂的决策动作,机器手臂执行完决策动作后,重新采集实时造影视频中的当前帧图像,并获取重新采集的当前帧图像的新的状态信息,再将新的状态信息输入到训练好的深度强化学习网络中,得到机器手臂的新的决策动作,不断地重

复,直到导丝到达目标位置为止。通过上述方式,通过机器手臂来代替医生手动递送导丝的过程,能够有效减少医生暴露在辐射环境中的时间。

[0118]

在一实施例中,所述构建模块20,还用于:

[0119]

构建深度强化学习网络,并设计机器手臂操作导丝的决策动作和奖励机制;

[0120]

基于第二造影视频,获取第一帧图像的状态信息s,并将所述第一帧图像的状态信息s输入到所述深度强化学习网络中,得到机器手臂的决策动作a;

[0121]

在所述机器手臂执行完所述决策动作a之后,获取第二帧图像的状态信息s’,并基于所述奖励机制得到从状态信息s到状态信息s’的回报值r;

[0122]

将(a,s,r,s')作为一组样本存放入经验池集t中,直至导丝到达目标位置为止;

[0123]

从所述经验池集t中随机抽取b组样本,利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络。

[0124]

在一实施例中,所述构建模块20,还用于:

[0125]

根据状态信息s和状态信息s’,确定从所述状态信息s到所述状态信息s’的距离;

[0126]

基于所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r。

[0127]

在一实施例中,所述构建模块20,还用于:

[0128]

判断所述第二帧图像中导丝的当前起点位置是否在血管外面,得到判断结果;

[0129]

基于所述判断结果和所述距离,根据所述奖励机制得到从所述状态信息s到所述状态信息s’的回报值r。

[0130]

在一实施例中,所述构建模块20,还用于:

[0131]

从所述经验池集t中随机抽取b组样本,并分别输入到所述深度强化学习网络中的目标网络和预测网络中,得到所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ);

[0132]

根据所述目标网络的输出价值q(s',a',θ')和所述预测网络的输出价值q(s,a,θ)来构建损失函数loss;

[0133]

基于所述损失函数loss利用梯度下降法将误差反向传播,来更新所述深度强化学习网络的网络参数,得到训练好的深度强化学习网络。

[0134]

在一实施例中,所述构建模块20,还用于:

[0135]

根据所述目标网络的输出价值q(s',a',θ')和回报值r来确定目标值;

[0136]

根据所述预测网络的输出价值q(s,a,θ)来确定预测值;

[0137]

基于所述目标值和所述预测值来构建损失函数loss。

[0138]

在一实施例中,所述构建模块20,还用于:

[0139]

从所述目标网络的所有输出价值q(s',a',θ')中确定最大的输出价值maxq(s',a',θ');

[0140]

根据所述最大的输出价值maxq(s',a',θ')和回报值r来确定目标值。

[0141]

应当理解的是,以上仅为举例说明,对本发明的技术方案并不构成任何限定,在具体应用中,本领域的技术人员可以根据需要进行设置,本发明对此不做限制。

[0142]

需要说明的是,以上所描述的工作流程仅仅是示意性的,并不对本发明的保护范围构成限定,在实际应用中,本领域的技术人员可以根据实际的需要选择其中的部分或者

全部来实现本实施例方案的目的,此处不做限制。

[0143]

另外,未在本实施例中详尽描述的技术细节,可参见本发明任意实施例所提供的血管介入导丝的自动导航方法,此处不再赘述。

[0144]

此外,需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者系统不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者系统所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者系统中还存在另外的相同要素。

[0145]

上述本发明实施例序号仅仅为了描述,不代表实施例的优劣。

[0146]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质(如只读存储器(read only memory,rom)/ram、磁碟、光盘)中,包括若干指令用以使得一台终端设备(可以是手机,计算机,服务器,或者网络设备等)执行本发明各个实施例所述的方法。

[0147]

以上仅为本发明的优选实施例,并非因此限制本发明的专利范围,凡是利用本发明说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本发明的专利保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1