基于自注意力和相对位置编码的文本摘要生成方法及装置与流程

本发明属于文本摘要生成,具体涉及一种基于自注意力和相对位置编码的文本摘要生成方法及装置。

背景技术:

1、文本摘要是自然语言处理领域的一项重要任务,其目的是从给定的长文本中提取出最相关的信息,生成一段简短而准确的摘要。目前,常用的文本摘要技术可以分为基于规则的文本摘要方法、基于统计机器学习的文本摘要方法以及基于深度学习的文本摘要方法。

2、其中,基于规则的文本摘要方法通常基于人工编写的规则和模板来从文本中抽取摘要。虽然这种方法具有良好的可解释性和可控性,然而,人工编写规则和模板需要大量的人工工作、人工维护,并且这种方法在面对复杂的文本时效果较差。

3、基于统计机器学习的文本摘要方法通常使用概率模型来对文本进行建模和预测。隐马尔可夫模型(hmm)和条件随机场(crf)是其中最常用的两种模型。然而,这些模型需要大量的训练数据和计算资源,且对于不同的文本类型和文本长度可能存在过拟合的问题。

4、基于深度学习的文本摘要方法是目前最为流行和先进的文本摘要技术之一。循环神经网络(rnn)、长短时记忆网络(lstm)和transformer等模型已经被广泛地应用于文本摘要任务中。这些模型具有自动特征学习和上下文感知的优势,可以在不同类型的文本上都取得很好的效果。但是,这些模型同样需要大量的训练数据和计算资源,并且对于一些长句子或复杂结构的语言表达的处理仍然存在困难。

5、综上所述,现有的文本摘要生成方法存在一些缺陷和不足,例如需要大量的人工工作和工人维护、存在过拟合的问题、对于不同类型和不同长度的文本表现差异较大等。因此,为解决上述问题,实现更为高效、准确和可扩展的文本摘要生成,以满足不断发展的实际应用的需求,需要一种新的文本摘要生成方法。

技术实现思路

1、本发明是为解决上述问题而进行的,目的在于提供一种对不同长度、不同类型的文本都能够生成更为准确的文本摘要、且相对计算性能更高的文本摘要生成方法及装置,本发明采用了如下技术方案:

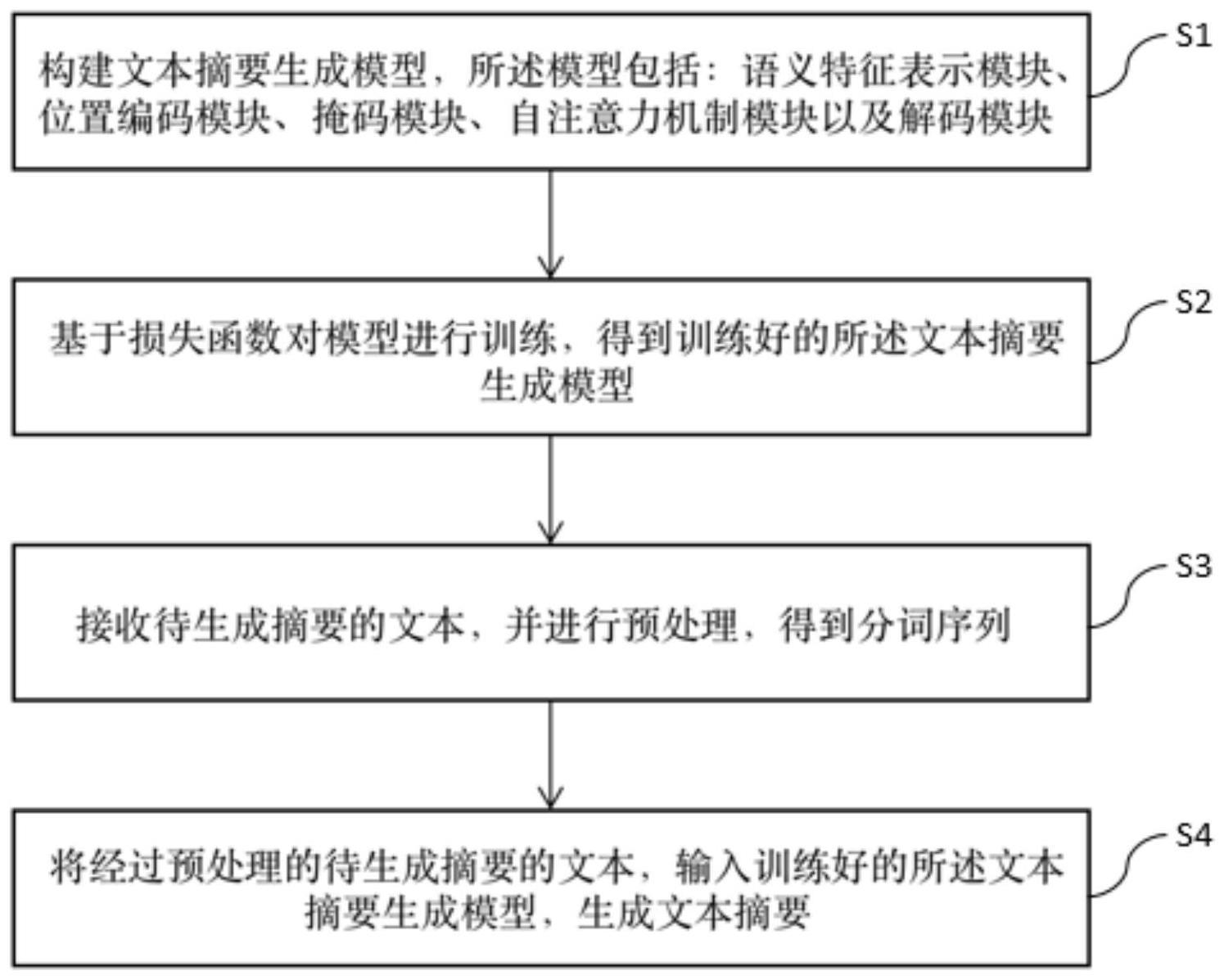

2、本发明提供了一种基于自注意力和相对位置编码的文本摘要生成方法,其特征在于,包括以下步骤:对待生成摘要的文本进行预处理以及分词,得到分词序列;将所述分词序列输入训练完成的文本摘要生成模型,生成相应的文本摘要,其中,所述文本摘要生成模型包括:语义特征表示模块,用于将所述分词序列转换为语义特征表示向量矩阵;位置编码模块,用于向所述语义特征表示向量矩阵引入所述分词序列中各分词的位置信息,其中,采用所述分词相对于所述分词序列的相对位置编码;掩码模块,基于位置编码后的所述语义特征表示向量矩阵计算各所述分词的重要性权重,并将所述重要性权重作为掩码概率计算掩码后的所述语义特征表示向量矩阵;自注意力机制模块,基于掩码后的所述语义特征表示向量矩阵对所述分词之间的位置关系进行建模,得到最终的所述语义特征表示向量矩阵;以及解码模块,用于对最终的所述语义特征表示向量矩阵进行解码,从而生成所述文本摘要。

3、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述位置编码模块采用改进的正弦位置编码得到位置编码后的所述语义特征表示向量矩阵,包括以下步骤:采用正弦位置编码生成所述分词序列的位置编码矩阵;在每个所述分词的所述语义特征表示向量的偶数位置添加sin变量,并在奇数位置添加cos变量,从而填满所述位置编码矩阵;将所述语义特征表示向量矩阵与所述位置编码矩阵进行拼接,从而得到位置编码后的所述语义特征表示向量矩阵。

4、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述语义特征表示向量矩阵为:式中,xi为各分词的语义特征表示向量,1≤i≤lin,在每个所述分词的所述语义特征表示向量的偶数位置添加sin变量,并在奇数位置添加cos变量的公式为:式中,i为分词tokeni在分词序列中的位置,a和b为待训练的常数,dmodel为语义表示特征向量的维度,即xi的长度,dk为语义表示特征向量的位置,将所述语义特征表示向量矩阵与所述位置编码矩阵进行拼接的公式为:式中,pe为位置编码矩阵。

5、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述语义特征表示向量矩阵包含各个所述分词的语义特征表示向量,所述文本的语义特征表示向量为各个所述分词的语义特征表示向量的平均,所述掩码模块计算掩码后的所述语义特征表示向量矩阵,包括如下步骤:计算各个所述分词的所述语义特征表示向量与所述文本的所述语义特征表示向量之间的余弦相似度,作为对应的所述分词的重要性权重;基于所述余弦相似度以及预定的掩码的语义特征表示向量,计算各个所述分词的掩码后的语义特征表示向量,从而得到掩码后的所述语义特征表示向量矩阵。

6、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述语义特征表示向量矩阵为:式中,xi为各分词的语义特征表示向量,1≤i≤lin,所述余弦相似度的计算公式为:式中,xs为文本的语义特征表示向量,|xi|、|xs|分别为xi与xs的模长,所述分词的掩码后的语义特征表示向量的计算公式为:式中,xmask为预定的掩码的语义特征表示向量,为分词的位置编码后的语义特征表示向量。

7、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述解码模块采用自循环解码模式,所述文本摘要生成模型还包括训练用掩码模块,所述文本摘要生成模型的训练包括如下步骤:将训练集中的训练数据的分词序列输入所述文本摘要生成模型,该模型输出文本摘要的预测结果,其中,对于该模型各个时间步的输出,所述训练用掩码模块将对应的目标输出通过硬掩码方式遮盖其后的预定个时间步之后的结果得到,以防止信息泄露;基于交叉熵损失函数,计算所述预测结果与对应的所述训练数据的真实标签的概率分布之间的误差,并基于该误差通过反向传播更新所述文本摘要生成模型的模型参数;基于所述误差,判断所述文本摘要生成模型是否收敛,在判断为是时得到训练完成的所述文本摘要生成模型。

8、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述解码模块的所述自循环解码模式包括以下步骤:对于第t个时间步,计算出下一个所述分词的概率分布为:pvocab(yt)=f(yt-1,z)=softmax(w1yt-1+w2z+b),式中,w1、w2为带训练的权重,b为带训练的偏置,yt-1=*y1,y2,...,yt-1+为解码模块已生成的t-1个时间步的输出;基于所述概率分布pvocab(yt),采用贪婪解码方式,在预定的词表vocab中选择概率最大的分词yt作为第t个时间步的预测结果。

9、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,所述自注意力机制模块包括三个全连接层wq、wk、wv,所述自注意力机制模块对所述分词之间的位置关系进行建模,包括如下步骤:将各个所述分词的掩码后的语义特征表示向量分别输入所述全连接层wq、wk、wv,分别得到矩阵query、key、value:qi(query)=wqxi′,ki(key)=wkxi′,vi(value)=wvxi′,基于所述矩阵query和key,采用缩放点积方式计算自注意力权重矩阵,每个位置i相对于位置j的注意力权重为:式中,qi为位置i对应的矩阵query中的元素,kj为位置j对应的矩阵key中的元素,d为qi,kj的维度,所有ai,j即组成自注意力权重矩阵a;将所述自注意力权重矩阵进行softmax归一化,得到归一化的自注意力权重矩阵:式中,e为自然常数,所有即组成归一化的自注意力权重矩阵将归一化的所述自注意力权重矩阵与所述矩阵value相乘,得到最终的所述语义特征表示向量矩阵:所有zi即组成最终的语义特征表示向量矩阵z。

10、本发明提供的基于自注意力和相对位置编码的文本摘要生成方法,还可以具有这样的技术特征,其中,对所述文本进行预处理及分词包括如下步骤:将所述文本转换为预定的格式;对格式转换后的所述文本进行清洗,去除特征符号和标点符号;对清洗后的所述文本按预定的分词算法进行分词,得到初步分词序列;基于预定的最大分词序列长度,对所述初步分词序列进行截断,得到所述分词序列。

11、本发明提供了一种基于自注意力和相对位置编码的文本摘要生成装置,其特征在于,包括:文本预处理部,用于对待生成摘要的文本进行预处理以及分词,得到分词序列;以及文本摘要生成部,用于将所述分词序列输入训练完成的文本摘要生成模型,生成相应的文本摘要,其中,所述文本摘要生成模型包括:语义特征表示模块,用于将所述分词序列转换为语义特征表示向量矩阵;位置编码模块,用于向所述语义特征表示向量矩阵引入所述分词序列中各分词的位置信息,其中,采用所述分词相对于所述分词序列的相对位置编码;掩码模块,基于位置编码后的所述语义特征表示向量矩阵计算各所述分词的重要性权重,并将所述重要性权重作为掩码概率计算掩码后的所述语义特征表示向量矩阵;自注意力机制模块,基于掩码后的所述语义特征表示向量矩阵对所述分词之间的位置关系进行建模,得到最终的所述语义特征表示向量矩阵;以及解码模块,用于对最终的所述语义特征表示向量矩阵进行解码,从而生成所述文本摘要。

12、发明作用与效果

13、根据本发明的基于自注意力和相对位置编码的文本摘要生成方法及装置,该方法包括对文本进行预处理及分词的步骤、以及将分词序列输入文本摘要生成模型生成相应文本摘要的步骤,其中,文本摘要生成模型包括位置编码模块、掩码模块以及自注意力机制模块,由于采用了子词相对于分词序列的相对位置编码,因此使得该方法能够更好地面向具有字符数限制的文本摘要任务,且外推性更强;由于通过掩码方式、基于重要性权重对输入文本的各分词进行了软掩码处理,因此使得该模型能够将注意力集中在关键子词上,而忽略相对不重要的信息,因而能够提高模型的预测准确率;由于通过自注意力机制融合全局信息,计算各分词的重要性和位置编码,将关键词信息和位置信息融入到解码后的文本中,因此使得该方法能够更好地面向具有字符数限制的文本摘要任务。

14、如上所述,本发明的方法及装置能够更好地面向具有字符数限制的文本摘要任务,提高生成的文本摘要的准确率。

- 还没有人留言评论。精彩留言会获得点赞!