一种基于多模态图像融合的微光夜视场景理解方法

本发明属于人工智能,具体涉及一种基于多模态图像融合的微光夜视场景理解方法。

背景技术:

1、随着人工智能技术的快速发展,无人系统对于复杂场景感知和理解方面的要求也越来越高,尤其是自动驾驶汽车、智能机器人、无人机等无人系统在微光夜视环境的实际应用中,如夜间城市道路场景或无人地下空间等,需要提供可靠的环境感知能力。而单一可见光图像视觉传感器容易受到微光夜视环境中缺乏照明的限制,因此结合热图像传感器以弥补可见光图像传感器在的不足,确保无人系统在白天和夜间以及恶劣天气条件下具备相同的感知能力。可见光图像可以提供丰富的语义信息,热图像则可以提供稳定的场景图像,研究可见光图像与热图像的高效融合方法,可以有效地提高无人系统在微光夜视条件下进行场景理解的稳定性。

2、zhao等人在《mitigating modality discrepancies for rgb-t semanticsegmentation》一文中提出一种桥接后进行融合的策略,可缓解跨模态特征融合前模态之间存在的差异。具体来说,作者设计了一个减少模态差异的子网络提取多模态特征并减少模态间的差异,提出了通道加权融合模块自适应地选择和集成可见光图像和热图像语义分割的判别多模态特征。此外,为有效地捕获上下文信息,作者提出了一个多尺度空间上下文模块和一个多尺度通道上下文模块。虽然该方法取得了优异的语义分割性能,但却忽略多模态多级特征信息的特点,所提出的融合方法不能有效利用每个阶段的多模态特征信息,一定程度上限制了多模态语义分割的性能,此外还存在参数冗余与运算量增加的现象,不利于在无人系统设备上进行部署。

技术实现思路

1、本发明的目的在于提供一种基于多模态图像融合的微光夜视场景理解方法,高效地利用层级多模态特征信息的特点,采用不同的融合策略构建了高效的多模态联合表示网络,解决了多模态特性信息利用不足、融合效率低下的问题,同时避免了网络模块低效带来的参数量冗余与计算量增加的现象。本发明提供基于多模态图像融合的微光夜视场景理解方法,其能够在夜间城市道路自动驾驶和地下空间暗弱无人导航系统中应用。

2、实现本发明目的的技术解决方案为:一种基于多模态图像融合的微光夜视场景理解方法,包括以下步骤:

3、步骤1、对mfnet数据集1569幅图像进行归一化处理,将像素大小统一为h×w,h表示长度,w表示宽度;将统一尺寸后的图像按照784/393的比例划分为训练数据集和测试数据集,对训练数据集进行数据增强构成网络训练数据集;转入步骤2。

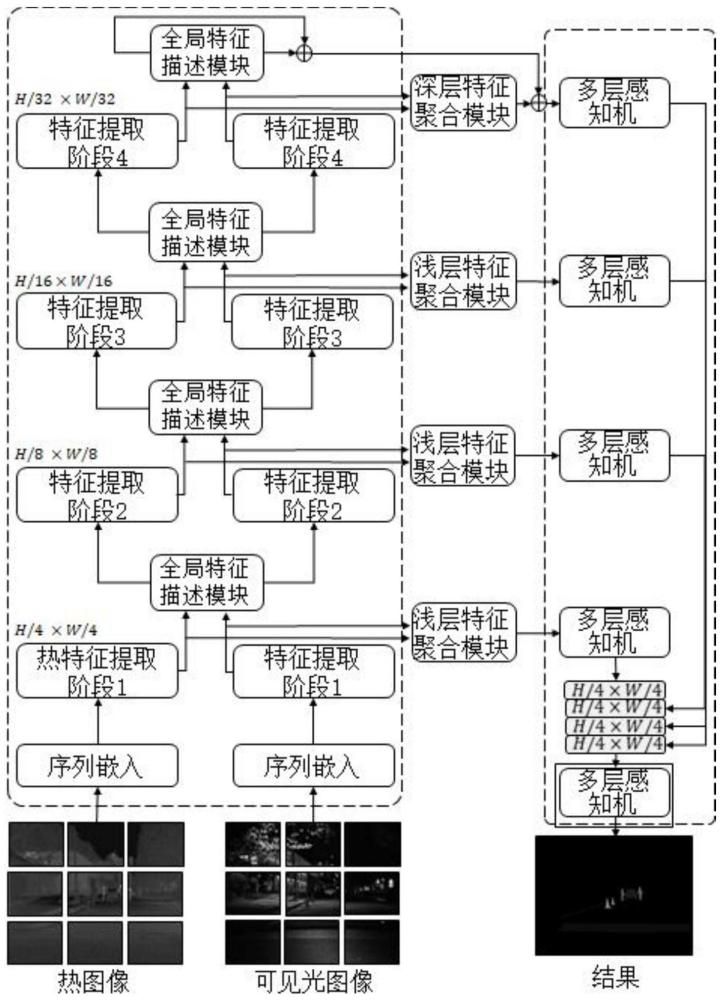

4、步骤2、构建一种基于多模态图像融合的微光夜视场景理解方法,该网络主要包含:可见光编码网络、热图像编码网络、跨模态全局特征描述模块、浅层多模态特征聚合模块、深层多模态特征聚合模块、解码网络;其中:可见光编码网络、热图像编码网络均由在imagenet数据集上预训练的transformer网络构成,作为提取特征的编码网络;跨模态全局特征描述模块用于校准多模态特征信息;浅层多模态特征聚合模块用于聚合浅层多模态特征信息;深层多模态特征聚合模块用于聚合深层多模态特征信息;解码网络由all-mlp模块构成,用于接收编码网络特征信息并对不同尺度的特征图进行特征重建,转入步骤3。

5、步骤3、利用网络训练数据集对多模态高效融合网络进行训练,得到训练好的多模态高效融合网络模型:

6、s31、将可见光编码网络特征提取划分为四个阶段,对应每个阶段提取相应的四个不同尺度的可见光特征,分别为(h/4)×(w/4)、(h/8)×(w/8)、(h/16)×(w/16)、(h/32)×(w/32),将其中前三个阶段对应的特征为浅层可见光特征,第四个阶段的特征为深层可见光特征;相应地,将热图像编码网络特征提取划分为四个阶段,对应每个阶段提取相应的四个不同尺度的热图像特征,分别为(h/4)×(w/4)、(h/8)×(w/8)、(h/16)×(w/16)、(h/32)×(w/32),将其中前三个阶段对应的特征为浅层热图像特征,第四个阶段的特征为深层热图像特征;转入s32。

7、s32、将前三个阶段不同尺度的浅层可见光特征和浅层热图像特征并行输入到跨模态全局特征描述模块,从跨模态全局特征描述模块的局部多头关系聚合器得到浅层可见光局部描述特征和浅层热图像局部描述特征,从跨模态全局特征描述模块的输出层得到浅层可见光校准特征和浅层热图像校准特征;并将前三个阶段得到的浅层可见光校准特征和浅层热图像校准特征分别与相应阶段相同尺度的浅层可见光特征和浅层热图像特征进行相加,并传输到特征提取网络的下一个阶段进行下一个尺度特征信息的提取;将第四个阶段得到的深层可见光特征与深层热图像特征输入到跨模态全局特征描述模块,从跨模态全局特征描述模块的局部多头关系聚合器得到深层可见光局部描述特征和深层热图像局部描述特征,从跨模态全局特征描述模块输出层得到深层校准可见光图像特征和深层校准热图像特征;转入s33。

8、s33、将s32中的前三个阶段得到的浅层可见光局部描述特征和浅层热图像局部描述特征,分别并行输入到浅层特征聚合模块提取到前三个阶段不同尺度的浅层聚合特征,将前三个阶段的不同尺度的浅层聚合特征通过跳跃连接的方式传输到解码网络,并对不同尺度的特征信息进行上采样,得到像素大小为h/4×w/4的浅层解码特征,转入s34。

9、s34、将s32中第四个阶段得到的深层可见光局部描述特征和深层热图像局部描述特征,并行输入到深层特征聚合模块得到深层聚合特征,将深层聚合特征和s32中的深层校准可见光图像特征和深层校准热图像特征进行相加,并输入到解码网络进行上采样得到像素尺度大小为(h/4)×(w/4)的深层解码特征,转入s35。

10、s35、将s33、s34中输出的浅层解码特征和深层解码特征进行拼接并经过一个多层感知网络进行通道降维操作,计算得到的输出特征与标签间的交叉熵损失,并以此对此网络的网络参数进行更新,最终获得训练好的网络模型,转入步骤4。

11、步骤4、将测试数据集输入到训练好的多模态高效融合网络模型,输出测试集中每个样本对应的预测结果,测试训练好的多模态高效融合网络模型的准确率。

12、所述的基于多模态图像融合的微光夜视场景理解方法能够在夜间城市道路自动驾驶和地下空间暗弱无人导航系统中应用。

13、与现有技术相比,本发明优点在于:

14、(1)与现有的多模态分割网络相比,本发明所述的一种基于多模态图像融合的微光夜视场景理解方法,可以高效地利用层级多模态特征信息的特点,并采用不同的融合策略构建了高效的多模态联合表示网络,解决了多模态特性信息利用不足、融合效率低下的问题,同时避免了网络模块低效带来的参数量冗余与计算量增加的现象,具有稳定的分割性能且可以在边缘设备进行部署。

15、(2)本发明构建了跨模态全局特征描述模块来校准多模态信息,可以实现不同层次的多模态特征信息之间的有效交互与联合表示以减少模态信息之间的差异。

16、(3)为了有效地聚合多模态特征信息,本发明构建了多模态交错稀疏自注意力模块应用于浅层多模态信息聚合,同时为了有效地利用深层特征丰富的语义信息,构建了对称金字塔池化交叉注意力模块和多模态跨通道通信模块,有效地实现不同层次的多模态特征信息的高效聚合。

- 还没有人留言评论。精彩留言会获得点赞!