控制方法、控制装置、车辆和存储介质与流程

1.本技术涉及车辆技术领域,特别涉及一种用于车辆的图形用户界面的控制方法、控制装置、车辆和存储介质。

背景技术:

2.随着汽车电子技术的发展,车辆越来越智能化。用户可通过车载中控大屏的车辆控制系统与车辆进行交互,从而实现对车辆的智能化控制。相关技术中,通常需要驾驶员先观察确定目标再通过触控操作与目标进行交互操作,然而,过多的接触操作会分散驾驶员在驾驶过程中的注意力,手眼并用在驾驶过程中也存在一定的安全隐患。

技术实现要素:

3.有鉴于此,本技术的实施例提供了一种用于车辆的图形用户界面的控制方法、控制装置、车辆和存储介质。

4.本技术提供了一种控制方法,用于车辆的图形用户界面,控制方法包括:

5.获取所述车辆的驾驶员的视觉信息;

6.响应于根据所述视觉信息确定的交互目标,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互。

7.在某些实施方法中,所述车辆包括多个摄像头,所述获取所述车辆的驾驶员的视觉信息包括:

8.获取所述多个摄像头采集的所述驾驶员的眼球信息以获取所述视觉信息。

9.在某些实施方法中,所述控制方法还包括:

10.获取所述驾驶员的表情信息;

11.所述响应于根据所述视觉信息确定的交互目标,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互包括:

12.响应于根据所述眼球信息和所述表情信息确定的交互目标,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互。

13.在某些实施方法中,所述车辆与云端服务器通信连接,所述服务器用于:

14.接收所述车辆发送的所述眼球信息和所述表情信息;

15.根据所述眼球信息确定所述驾驶员的视觉中心并确定所述视觉中心对应的目标;

16.根据所述表情信息确定所述驾驶员对所述目标的确认信息以确定所述目标为所述交互目标;

17.发送所述交互目标的确认信息至所述车辆;

18.所述响应于根据所述视觉信息和所述表情信息确定的交互目标,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互包括:

19.响应于接收到的所述服务器反馈的所述确认信息,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互。

20.在某些实施方法中,所述驾驶员佩戴有可穿戴设备,所述可穿戴设备用于发射微波信号,所述车辆包括微波检测设备,所述获取所述车辆的驾驶员的视觉信息包括:

21.根据所述微波检测设备检测到微波信号获取所述视觉信息。

22.在某些实施方法中,所述响应于根据所述视觉信息确定的交互目标,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互包括:

23.检测所述微波信号的发射方向;

24.确定所述发射方向对应的目标为所述交互目标。

25.在某些实施方法中,所述确定所述发射方向对应的目标为所述交互目标包括:

26.检测所述微波信号在所述发生方向上的驻停时间;

27.在所述驻停时间大于预定时间的情况下,确定所述发射方向对应的目标为所述交互目标。

28.本技术还提供了一种控制装置,用于车辆的图形用户界面,控制装置包括:

29.获取模块,用于获取所述车辆的驾驶员的视觉信息;

30.控制模块,用于响应根据所述视觉信息确定的交互目标,控制所述交互目标进行预定操作以实现与所述图形用户界面进行交互。

31.本技术还提供了一种车辆,所述车辆包括存储器和处理器,所述存储器中存储有计算机程序,所述计算机程序被所述处理器执行时,实现所述的用于车辆的图形用户界面的控制方法。

32.本技术还提供了一种计算机程序的非易失性计算机可读存储介质,当所述计算机程序被一个或多个处理器执行时,实现所述的用于车辆的图形用户界面的控制方法。

33.本技术实施方式的用于车辆图形用户界面的控制方法、控制装置、车辆和存储介质中,通过获取车辆的驾驶员的视觉信息,并响应于根据视觉信息确定的交互目标,通过控制交互目标进行预定操作以实现与图形用户界面进行交互。使得车辆的驾驶员仅需通过较小的动作变化如眼睛和表情的变化、头部的倾斜等,即可实现与车辆的图形用户界面的交互操作,在一定程度上代替了手的触控操作。因不需要手眼并用与图形用户界面进行交互操作,有效地提高了驾驶过程的安全性。

附图说明

34.本技术的上述和/或附加的方面和优点从结合下面附图对实施例的描述中将变得明显和容易理解。

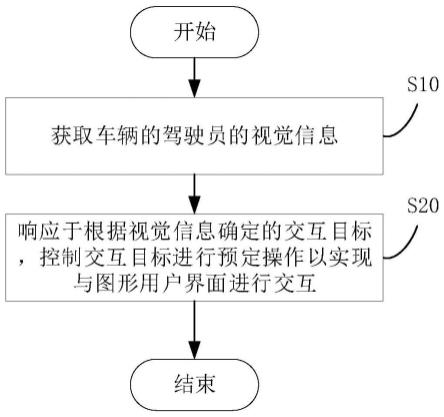

35.图1是本技术某些实施方式的控制方法流程示意图;

36.图2是本技术某些实施方式的控制方法装置模块图;

37.图3是本技术某些实施方式的控制方法流程示意图;

38.图4是本技术某些实施方式的控制方法流程示意图;

39.图5是本技术某些实施方式的控制方法流程示意图;

40.图6是本技术某些实施方式的控制方法流程示意图;

41.图7是本技术某些实施方式的控制方法流程示意图;

42.图8是本技术某些实施方式的控制方法示例示意图。

具体实施方式

43.下面详细描述本技术的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,旨在用于解释本技术,而不能理解为对本技术的限制。

44.请参阅图1,本技术提供了一种控制方法,用于车辆的图形用户界面,包括:

45.s10:获取车辆的驾驶员的视觉信息;

46.s20:响应于根据视觉信息确定的交互目标,控制交互目标进行预定操作以实现与图形用户界面进行交互。

47.请参阅图2,本技术实施方式还提供了一种用于车辆的图形用户界面的控制装置100,本技术实施方式的控制方法可以由控制装置100实现。控制装置100包括获取模块110和控制模块120。s10可以由获取模块110实现,s20可以由控制模块120实现。或者说,获取模块110用于获取车辆的驾驶员的视觉信息。控制模块120用于响应于根据视觉信息确定的交互目标,控制交互目标进行预定操作以实现与图形用户界面进行交互。

48.本技术实施方式还提供了一种车辆。车辆包括存储器和处理器。存储器中存储有计算机程序,处理器用于获取车辆的驾驶员的视觉信息,并响应于根据视觉信息确定的交互目标,控制交互目标进行预定操作以实现与图形用户界面进行交互。

49.随着汽车智能化的发展,驾驶员可通过图形用户界面(user interface,ui)如车载中控大屏与车辆进行交互,从而实现对车辆的智能化控制。而车载中控大屏的ui中有多种app程序及应用如车载导航app、空调控制、及音乐播放等。驾驶员需要通过车载中控大屏的ui界面选择所需的app。当进入选择的app后,车载中控大屏的ui界面会切换为当前app的ui界面,然后驾驶员进行更多后续选择。

50.具体地,当驾驶员启动本技术的控制方法时,相应模块会开始获取车辆的驾驶员的视觉信息。例如通过智能摄像头捕捉驾驶员的图像或视频信息,包括静态及动态信息。当驾驶员需要打开某个app时,只需进行较小幅度的动作变化,例如通过眼睛看向所需app,当摄像头捕捉到驾驶员的双目视线聚焦点后,通过相应模型进行截取、特征提取等计算识别出驾驶员想要打开的app。ui界面严格划分为n*n块子区域,以对应n个app的显示位置。

51.请参阅图8,例如,ui界面的长为40cm,宽为20cm,n=5,则界面可显示25个app,而每一个app占据的范围为长为8cm,宽为4cm。当根据视觉信息计算得出驾驶员的双目视线聚焦点的二维坐标位置为o(6cm,20cm),此位置位于空调app的区域范围内,即宽为4cm-8cm,长为16cm-24cm。如此可确定驾驶员想打开的app位置。

52.进一步地,可持续捕捉驾驶员的视觉信息,例如嘴角上扬、点头等较小幅度的动作变化。通过对此类视觉信息进行计算识别出当前驾驶员是否对确定的app进行打开操作。其中,驾驶员还可通过某些可穿戴的设备发射出电磁波如微波进行操作,此时微波及其发射方向为获取的视觉信息。

53.进一步地,当根据视觉信息确定交互目标如某个app后,控制app进行预定操作,例如打开app、切换或者关闭app。当进入app的ui界面后,还可根据视觉信息进行进一步类似的操作,驾驶员通眼睛看向app相应控制按钮实现点击的功能。

54.例如,当驾驶员在形式过程中想调节空调系统,首先开启本方法,摄像头开始捕捉驾驶员的视觉信息。当驾驶员看向车载中控大屏的空调显示区域并实施嘴角上扬的动作,

摄像头将此视觉信息发送至相应服务器进行计算并判断出驾驶员当前想打开空调系统,然后执行相应操作如打开空调app。驾驶员继续进行下一步操作如想对空调进行升温,则驾驶员看向温度增加控件“+”并实施嘴角上扬的动作,摄像头将此视觉信息继续发送至相应服务器进行计算从而执行温度增加的操作。

55.需要说明的是,驾驶员不需要长时间注视ui界面,而仅需看向ui界面某个区域并立即返回之前的作动即可,后续的嘴角上扬等动作可与看向同时实施或在返回之后实施。

56.如此,本技术通过获取车辆的驾驶员的视觉信息,并响应于根据视觉信息确定的交互目标,通过控制交互目标进行预定操作以实现与图形用户界面进行交互。使得车辆的驾驶员仅需通过较小的动作变化如眼睛和表情的变化、点头摇头等,即可实现与车辆的图形用户界面的交互操作,在一定程度上代替了手的触控操作。因不需要手眼并用与图形用户界面进行较长时间的交互操作,有效地提高了驾驶过程的安全性。

57.请参阅图3,在某些实施方法中,车辆包括多个摄像头,s10包括:

58.s101:获取多个摄像头采集的驾驶员的眼球信息以获取视觉信息。

59.在某些实施方法中,s101可以由获取模块110实现。或者说,获取模块110用于获取多个摄像头采集的驾驶员的眼球信息以获取视觉信息。

60.在某些实施方法中,处理器用于获取多个摄像头采集的驾驶员的眼球信息以获取视觉信息。

61.具体地,车辆可设置多个摄像头用于获取驾驶员的视觉信息。其中,摄像头的位置可根据实际情况设置,例如在车载中控大屏的角落位置,或车载中控大屏上方的位置。具体根据以可实现获取驾驶员的视觉信息来识别出眼球视觉中心位于ui界面的位置,其具体实现位置信息不作为对本技术的限制。

62.其中,摄像头的数量为四个或四个以上,目的为可较为准确获取驾驶员的双目视线聚焦点,从而判断出驾驶员看向的app的位置。要实现此功能,需要四个或四个以上摄像头,如四个摄像头,分别从车载中控大屏的上下左右四个方向来捕捉驾驶员的视觉信息。

63.请参阅图4,在某些实施方法中,控制方法还包括:

64.s30:获取驾驶员的表情信息。

65.进一步地,s20包括:

66.s201:响应于根据眼球信息和表情信息确定的交互目标,控制交互目标进行预定操作以实现与图形用户界面进行交互。

67.在某些实施方法中,s30可以由获取模块110实现,s201可以由控制模块120实现。或者说,获取模块110用于获取驾驶员的表情信息,同时控制模块120用于响应于根据眼球信息和表情信息确定的交互目标,控制交互目标进行预定操作以实现与图形用户界面进行交互。

68.在某些实施方法中,处理器用于获取驾驶员的表情信息,并响应于根据眼球信息和表情信息确定的交互目标,控制交互目标进行预定操作以实现与图形用户界面进行交互。

69.具体地,驾驶员的表情信息包括嘴巴信息或者头部信息等。例如嘴角上扬、噘嘴等,或者点头、摇头等较小的动作信息。

70.通过多个摄像头如四个摄像头获取视频或动态图像,然后对所获取的信息进行预

处理,及人脸检测。当识别出人脸后,进一步地,通过相应的注视点估计技术去追踪驾驶员的双目视线聚焦的落点。同理,亦可截取出嘴部信息识别判断是否为嘴角上扬状态、或噘嘴等。或根据人脸行为识别判断是否为点头、摇头。

71.具体地,对人脸进行检测可将获取的视频或动态图像信息经坐标变换得到像素坐标图,然后对4个坐标图提取orb特征(oriented fast and rotated brief)并进行粗匹配,并利用随机抽样一致(random sample consensus,ransac)算法剔除误匹配点,拟合出单应性矩阵的初始值,再使用levenberg-marquardt非线性迭代最小逼近法进行求精,经图像配准、融合和拼接后,生成全景坐标视图。

72.进一步地,可利用haar特征或lbp特征训练多个弱分类模型,组成最终的分类器进行人脸检测。

73.当检测出人脸图像后,四个摄像头可进一步获取包括左眼图像、右眼图像、人脸图像以及人脸位置。对这四种信息输入由四条支路分别处理,融合后输出得到一个二维坐标位置(x,y)。其算法可利用单隐层前馈神经网络中的极限学习机。然后将此二维坐标位置(x,y)与ui界面如车载中控大屏n*n块子区域进行匹配,计算出驾驶员当前的双目视线聚焦落点的app。

74.进一步地,当检测出人脸图像后,可截取驾驶员的嘴部感兴趣区域(region of interesting,roi),利用卷积神经网络对上扬的嘴角进行定位。同理可对点头或摇头等动作进行识别确定。

75.如此,仅需驾驶员通过眼睛看向ui界面的某个app区域,并通过多个摄像头对驾驶员的视觉信息进行捕捉,即可识别出驾驶员想要打开的app。进一步地,通过识别驾驶员的表情信息以对确定的app执行打开操作。在一定程度上代替了手的触控操作。因不需要手眼并用与图形用户界面进行较长时间的交互操作,有效地提高了驾驶过程的安全性。

76.请参阅图5,在某些实施方法中,车辆与云端服务器通信连接,服务器包括:

77.s200:接收车辆发送的眼球信息和表情信息;

78.s300:根据眼球信息确定驾驶员的视觉中心并确定视觉中心对应的目标;

79.s400:根据表情信息确定驾驶员对目标的确认信息以确定目标为交互目标;

80.s500:发送交互目标的确认信息至车辆;

81.进一步地,s201包括:

82.s2011:响应于接收到的服务器反馈的确认信息,控制交互目标进行预定操作以实现与图形用户界面进行交互。

83.具体地,服务器可为云端服务器,主要用于对获取的信息进行计算识别。当本技术的控制方法启动时,车辆的摄像头捕捉并获取到驾驶员的眼球信息和表情信息,并将此信息实时且持续地发送至云端服务器,服务器根据眼球信息及ui界面和各app的相关参数信息进行计算,以确定驾驶员双目视线聚焦点对应的交互目标,或者说驾驶员当前想要打开的app,并发送至车辆。同时,根据获取的表情信息进一步识别其嘴部信息如嘴角上扬,若判断驾驶员当前嘴角上扬,则可生成打开控制指令,并将交互目标的确认信息及控制指令发送至车辆。

84.当车辆收到确认的交互目标及其控制指令,如交互目标为“导航控制系统”,控制指令为“打开”,则执行相应操作,即打开“导航控制系统”app。

85.如此,通过云端服务器对控制方法进行计算识别并生成控制指令,然后返回至车辆,车辆执行相应操作。

86.请参阅图6,在某些实施方法中,驾驶员佩戴有可穿戴设备,可穿戴设备用于发射微波信号,车辆包括微波检测设备,s10还包括:

87.s102:根据微波检测设备检测到微波信号获取视觉信息。

88.在某些实施方法中,s102可以由获取模块110实现。或者说,获取模块110用于根据微波检测设备检测到微波信号获取视觉信息。

89.在某些实施方法中,处理器用于根据微波检测设备检测到微波信号获取视觉信息。

90.具体地,驾驶员可佩戴有可穿戴设备,可穿戴设备用于发射微波信号,例如可发射微波的眼镜或可发射微波的头盔等。当驾驶员需要对ui界面进行操作时,可佩戴此眼镜。进一步地,驾驶员可通过方向盘操作开启微波控制功能。当此功能开启后,驾驶员头部快速转动看向ui界面上所需打开的app并保持短暂停留如1秒,微波检测设备如雷达可检测识别到该微波信息。其中,微波检测设备可安装在车载中控大屏后端以接收微波。

91.请再次参阅图6,在某些实施方法中,s20还包括:

92.s202:检测微波信号的发射方向;

93.s203:确定发射方向对应的目标为交互目标。

94.在某些实施方法中,s202和s203可以由控制模块120实现。或者说,控制模块120用于检测微波信号的发射方向,并确定发射方向对应的目标为交互目标。

95.在某些实施方法中,处理器用于检测微波信号的发射方向,并确定发射方向对应的目标为交互目标。

96.具体地,当微波功能开启后,驾驶员头部快速转动看向ui界面上所需打开的app,此时微波检测设备如雷达可检测识别到该微波信息。进一步的,根据该微波的发射方向,并结合ui界面和app的相关参数信息进行识别以判断出该微波停留的区域范围,从而得到驾驶员想要打开的app,当确定app后,可直接执行点击以打开该app,也可通过二次微波发射或其它进一步确认操作以打开该app。

97.如此,本实施方法的可发射微波的可穿戴设备,通过发射微波以确定交互目标,在一定程度上避免了驾驶员的手动触控,降低了手眼并用的安全风险。另外,无需在服务器中增加计算方法模型,实现较为简单。需要说明的是,因其需要驾驶员视线的短暂停留,可更多应用于非行驶过程中的ui界面控制。

98.请参阅图7,在某些实施方法中,s203包括:

99.s2031:检测微波信号在发生方向上的驻停时间;

100.s2032:在驻停时间大于预定时间的情况下,确定发射方向对应的目标为交互目标。

101.在某些实施方法中,s202和s203可以由控制模块120实现。或者说,控制模块120用于检测微波信号的发射方向,并确定发射方向对应的目标为交互目标。

102.在某些实施方法中,处理器用于检测微波信号的发射方向,并确定发射方向对应的目标为交互目标。

103.具体地,当微波功能开启后,驾驶员头部快速转动看向ui界面上所需打开的app并

保持短暂停留大于或等于预定时间如1秒,此时微波检测设备如雷达可检测识别到该微波信息,并通过预定时间进行判断。若微波停留时间小于1秒,则不识别,例如驾驶员扫过该区域的情况。反之,若微波停留时间大于或等于1秒,则开始识别,根据该微波的发射方向,并结合ui界面和app的相关参数信息进行计算以判断出该微波停留的区域范围,从而得到驾驶员想要打开的app。当确定app后,可直接执行点击以打开该app,也可通过二次微波发射或其它进一步确认操作以打开该app。

104.如此,本实施方法在前述通过可发射微波的可穿戴设备来进行ui界面交互的控制方法的基础上加入了预定时间,通过预定时间可排除某些误判情况如驾驶员仅扫过该区域,而不是想要打开该区域所属的app。从而有效地提高了该控制方法的准确度。

105.在某些实施方法中,可结合微波发射与人脸检测。具体地,当微波功能开启后,驾驶员头部快速转动看向ui界面上所需打开的app并保持短暂停留大于或等于预定时间如1秒,此时微波检测设备如雷达可检测识别到该微波信息,并通过预定时间进行判断是否确定交互目标。若微波停留时间小于1秒,则不识别,例如驾驶员扫过该区域的情况。反之,若微波停留时间大于或等于1秒,则可确定为交互目标,进一步地,可根据驾驶员的表情信息包括嘴巴信息或者头部信息判定是否对交互目标执行操作如打开,例如嘴角上扬、噘嘴等,或者点头、摇头等较小的动作信息。

106.具体地,通过多个摄像头如四个摄像头获取视频或动态图像,然后对所获取的信息进行预处理,及人脸检测。当识别出人脸后,截取出嘴部信息识别判断是否为嘴角上扬状态、或噘嘴等。或根据人脸行为识别判断是否为点头、摇头。

107.如此,结合检测到微波发射信号以确定交互目标,然后根据嘴角上扬等较小的动作信息打开交互目标app,相较于上述方案提高了识别的准确性。

108.在某些实施方法中,当微波功能开启后,驾驶员头部快速转动看向ui界面上所需打开的app,此时微波检测设备如雷达可检测识别到该微波信息。进一步地,可根据驾驶员的表情信息包括嘴巴信息或者头部信息确定及打开交互目标,例如嘴角上扬、噘嘴等,或者点头、摇头等较小的动作信息。

109.具体地,通过多个摄像头如四个摄像头获取视频或动态图像,然后对所获取的信息进行预处理,及人脸检测。当识别出人脸后,截取出嘴部信息识别判断是否为嘴角上扬状态、或噘嘴等。或根据人脸行为识别判断是否为点头、摇头。

110.如此,结合检测到微波发射信号,根据嘴角上扬等较小的动作信息确定及打开交互目标app,相较于上述方案,无需视线停留时间,有效地提高了行驶安全性。

111.综上所述,本技术实施方式的用于车辆图形用户界面的控制方法、控制装置、车辆和存储介质中,通过获取车辆的驾驶员的视觉信息,然后通过智能模型识别出驾驶员的双目聚焦视线点以确定驾驶员看向的交互目标,并通过较小的动作或表情信息对确定的交互目标进行操作。使得车辆的驾驶员仅需通过较小的动作变化如眼睛和表情的变化、头部的倾斜等,即可实现与车辆的图形用户界面的交互操作,在一定程度上代替了手的触控操作。因不需要手眼并用与图形用户界面进行交互操作,有效地提高了驾驶过程的安全性。优选地,可通过多个摄像头获取驾驶员的眼球信息来确定交互目标的准确位置,进而通过获取驾驶员的表情信息来确定是否执行点击操作。将确认和操作分步实行,可在一定程度上提高控制方法的准确性,提升用户体验。在某些实施方法中,还可通过可发射微波的可穿戴设

备及微波检测设备来进行ui界面的交互控制,而无需在服务器增加计算识别等模型,在一定程度上简单地实现了代替了手的触控操作,以避免手眼触控带来的驾驶安全风险。

112.本技术实施方式还提供了一种车辆。车辆包括存储器及一个或多个处理器,一个或多个程序被存储在存储器中,并且被配置成由一个或多个处理器执行。程序包括用于执行上述任意一项实施方式所述的用于车辆的图形用户界面的控制方法的指令。处理器可用于提供计算和控制能力,支撑整个车辆的运行。存储器为存储在其中的计算机可读指令运行提供环境。

113.本技术实施方式还提供了一种计算机可读存储介质。一个或多个存储有计算机程序的非易失性计算机可读存储介质,当计算机程序被一个或多个处理器执行时,实现上述任一实施方式的用于车辆的图形用户界面的控制方法。

114.本领域普通技术人员可以理解实现上述实施例方法中的全部或部分流程,是可以通过计算机程序来指令相关的软件来完成。程序可存储于一非易失性计算机可读存储介质中,该程序在执行时,可包括如上述各方法的实施例的流程。其中,的存储介质可为磁碟、光盘、只读存储记忆体(read-only memory,rom)等。

115.以上实施例仅表达了本技术的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对本技术专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本技术构思的前提下,还可以做出若干变形和改进,这些都属于本技术的保护范围。因此,本技术专利的保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1